Nützliche Unterscheidungen pt. 43 (The Problematic Edition)

Eine weitere zumindest pragmatisch nützliche Unterscheidung ist die Frage ob etwas ein Problem ist oder ein Umstand.

(frei nach clay shirky, der einmal ich glaube issak rubin den ausspruch if you have the same problem for a long time, maybe it’s not a problem, maybe it’s a fact

zugeschrieben hat)

Die Unterscheidung Problem/Umstand ist als Unterscheidung funktional deshalb interessant, weil sie gwm. nur auf der Ebene der Bewertung wirksam ist, die Beschreibung des jeweiligen Phänomens ist üblicherweise die gleiche und der Unterschied ist der Sache gwm. inhärent. Oder anders gesagt: man erkennt erst an der Bewertung (oder Betonung), ob der Unterschied gesehen wird oder nicht.

Gleichzeitig ist es oft so, dass die falsche Bewertung eines Umstands als Problem die in der Folge angedachten ‘Lösungen’ dann selbst erst an anderer Stelle Probleme erzeugen, weil man Umstände eben nicht lösen kann, sondern man mit ihnen leben/herumleben muss.

(es liegt glaub ich die vermutung nicht fern, dass mehr oder weniger die gesamte europäische und besonders natürlich die deutsche mediale hysterie und der dadurch getriggerte politische (re-)aktionismus bezüglich dem web/technologie nichts anderes ist als lösungen für fälschlicherweise als problem verstandene umstände, die dann auf der falschen ebene behandelt werden sollen; so betrachtet erklären sich phänomene wie oettinger, das leistungsschutzrecht, das recht auf vergessen, das netzwerkdurchsuchungsgesetz usw. fast von selbst)

(abt: draw the distinction!)

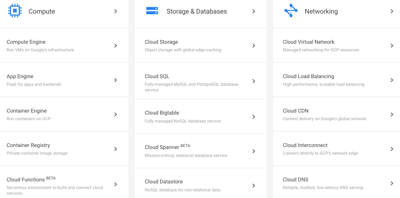

Google Cloudbag

kl. nachtrag zu 841036605653692416 und eher eine nts, aber die google cloud next 2017 (eine playlist mit allen vorträgen liegt hier, die keynotes hier und hier ) ist dann doch etwas erschreckend, weil es die auf absehbare zeit geltende synthese von google darstellt und sich google gwm. als corporate douche bag selbst gefunden hat (these war ihre pragmatisch-geniale algorithmik bei der suche und adsense; antithese ihre grössenwahnsinnige debilität bei allem anderen und besonders allem sozialen). es ist wirklich so eines dieser dinge, die man so nicht vorhersehen kann, die dann retrospektiv aber auch nicht gänzlich überraschen, die aber doch ein echter schock sind, wenn man sich nach zwei, drei jahren das erste mal wiedersieht.

wenn man so will sehen wir das symptom davon, dass sie nie eine bewältigungsstrategie für ihre flops, facepalms und fails gefunden haben, und dann zunehmend nur noch das selektiert und verstärkt haben, was ihnen den damit verbundenen makel und die immer tiefer verdrängte scham nicht verursacht, was halt die corporate douchebagery wurde, weil dieser bereich selbst so lange affirmativ wirkt, solange man sich an die regeln hält und sich mit den etablierten ritualen, sprachformen, habitus, etc. identifiziert. das traurige dabei ist, dass für google leicht auch eine andere, utopischere synthese möglich gewesen wäre, wenn sie nur ein eitzerl mehr demut und weniger grössenwahn aufbringen hätten können, weil sie dann auch irritationen aus der umwelt in ihre feedbackloops einbauen hätten können und dadurch ihre selbstwahrnehmung verbessern.

die meisten ihrer fails waren ja nicht deshalb fails, weil die idee selbst schon idiotisch war (wobei es die auch gab), die meisten fails wurden deshalb fails, weil google als system einen hermetischen grad an operativer geschlossenheit entwickelt und die umwelt nur über extrem limitierte selektionen angeschlossen hat, das aber in bereichen, wo der gesamte wert der anwendung oder plattform darin besteht, die umwelt möglichst differenziert wahrzunehmen und sich in dialektik damit zu entwickeln.

(was google übrigens intern nie entwickeln konnte ist sinn, aber das ist ein anderes thema)

gelandet sind sie jetzt jedenfalls in einem sicheren hafen als infrastrukturprovider einer cloud für fortune 500 companies mit allen rahmenbedingungen, die vor allem hierarchisch tiefe it-strukturen mit faible für salesmen und integrationsberater ansprechen und also irgendwie dort, wo man vor 10 jahren vl. noch microsoft vermutet hätte, die lustigerweise bei einem, ich sag mal, hipperen und teilweise auch deutlich offeneren portfolio gelandet sind. traurig hier besonders auch, dass man sie irgendwie noch nie so glücklich und in ihrem element gesehen hat.

(nur als oberflächlicher eindruck, die unterschiede der clouds von amazon, google und microsoft müsste man sich ohnehin irgendwann mal genauer anschauen, nicht nur was die produkte, features und preise betrifft, sondern auch die ideologischen grundannahmen, den grad der freiheiten usw.)

Was man von Big Brother über Trump lernen kann

in den USA hat in den letzten wochen ja nicht nur die wahl zum präsidenten stattgefunden, es läuft gerade auch die erste reine online-ausgabe von big brother. und wenn man sich die anschaut, kann man das wie und warum und nochmal das wie vom sieg von trump vl. schlüssiger verstehen, als mit den meisten medienkritischen und politikphilosophischen oder sozialwissenschaftlichen erklärungsversuchen, die wir in den kommenden tagen und monaten sehen werden.

ich gehe ausnahmsweise mal davon aus, dass nicht jeder hier mitlesende auch us big brother schaut, deshalb ein paar worte zum format:

es zieht eine gruppe von leuten in ein haus, lebt dort von der welt abgeschieden, wird aber rund um die uhr gefilmt und im fernsehen/im internet übertragen; jede woche wird eine person hinausgewählt, der letzte verbliebene gewinnt 250k; das spiel besteht einerseits aus wettbewerben, die bestimmte rechte verleihen (andere zur elimination nominieren, schutz vor nominierung, usw.), hat andererseits aber auch eine starke soziale komponente (allianzen bilden, kochen, nett oder unterhaltsam sein, dumm oder unfähig und also keine gefahr sein, usw.).

neu in der aktuellen online version ist, dass es keine komprimierte und editierte show im fernsehen gibt, die immer auch die interessen oder narrativen wünsche der produzenten reflektiert, sondern dass alles im webstream live gezeigt wird, auch das normalerweise versteckte. und noch wichtiger: dass die zuschauer durch abstimmungen in das geschehen eingreifen können (einen spieler nominieren, eine stimme zur hinauswahl, diverse andere sicherheiten oder vergünstigungen).

zum verständnis der wahl interessant war nun die dynamik und die feedbackloops der internen und externen gruppenbildungen, die sich nicht nur gegenseitig etabliert und beobachtet, sondern auch eine weise aufgeschaukelt, isoliert und verfestigt hat, die ohne diese wechselseitige interpenetration UND spezifische konstellation nicht möglich gewesen wäre:

der katalysator war eine (leider etwas unglückliche) primäre selbstselektive trennung im haus, bei der es einerseits die normalos (weiß, collegeabschluss, heterosexuell, fit und idealerweise aus dem süden) und andererseits die underdogs (schwarz, dropouts, schwul, dick) gab. und in dieser konstellation sympathisiert natürlich jeder zuschauer für die underdogs, was dazu führte, dass ‘amerika’ in den ersten zwei wochen die unsympathischsten WASPs rausgewählt hat, obwohl sie intern durch die wettbewerbe eigentlich die ‘macht’ im haus gehabt hätten.

der effekt davon war, dass die ‘misfits’ das als zeichen einer uneingeschränkten sympathie von ‘amerika’ verstanden haben, was sie in der folge auf eine weise selbstgerecht gemacht hat, in der plötzlich sie diejenigen wurden, die aus einer position der macht (amerika liebt uns und hasst die anderen) heraus begonnen haben, unnette und ungustiöse dinge zu tun (die polster der anderen unter ihrer achsel reiben oder darauf furzen, trashtalk der auch in den expliziteren roasts funktionieren würde, usw.) – während die verbliebenen ‘plastics’ plötzlich die sympathischen underdogs wurden, weil es einfach vier mädel waren, die überraschend gut miteinander ausgekommen sind (üblicherweise zerlegen sich die frauen in big brother als allererstes selbst).

(übrigens ein anfängerfehler, weil in dem format mittlerweile bekannt sein sollte, dass sympathie immer an die position gebunden ist und auch ehemalige fan favorites in nur einer woche zum verachteten individuum werden können, wenn sie ein zweites mal eingeladen werden und sich dann als checker geben)

der andere effekt war eine fanbildung außen, die die interne dynamik inklusive der falschen selbsteinschätzung und selbstgerechtigkeit und wachsenden kognitiven dissonanzen mehr oder weniger gespiegelt und übernommen hat.

üblicherweise ist es in der populärkultur ja so, dass die ‘misfits’ die sympathischen geheimen helden sind, denen man gerne die daumen drückt und die am ende idealerweise auch gewinnen, während die privilegierten ‘plastics’ abgestraft werden, sich ihr prinz als frosch herausstellt und sie wenn sie glück haben nach einer läuterung eine versöhnung erfahren.

hier war es aber so, dass die ‘misfits’ nach allen pragmatischen kriterien des zusammenlebens bald die eigentlichen ungustl waren, was von den ursprünglichen fans aber nicht zur kenntnis genommen wurde, was allerdings nur funktionieren konnte, indem der bezug zur realität kollektiv aufgegeben wurde und man sich auf eine art emergenten hive mind bezogen hat, in dem alles eitel freud und sonnenschein war.

das notwendige konstitutive element dafür war glaub ich, dass sich eine gruppe falscherweise selbst als ‘fucked over’ wahrgenommen hat. im haus hat sich diese auslegung in der dritten woche gebildet, nachdem die stimme von ‘amerika’ das erste mal nicht mehr zu gunsten der misfits ausgefallen ist, als sie selbst das erste mal an der macht waren. ihre einzige erklärung dafür war, dass der prozess selbst ‘rigged’ sein muss. amerika liebt sie, das haben die ersten wochen gezeigt, und die anderen sind furchtbare menschen, das ist selbstevident, es kann also nicht anders sein als dass irgendwas nicht stimmt.

und diese selbstwahrnehmung als ‘fucked over’ hat sich auch nach aussen übertragen. auch die fans der misfits haben einfach als axiom angenommen, dass niemand für die plastics stimmen könnte und dass jedes voting für diese also ‘rigged’ sein muss. entweder weil die fans der anderen rassisten oder homophob sind, oder weil sie das wahlsystem gamen, oder weil die produktionsfirma korrupt ist und das ergebnis fälscht.

nachdem diese falsche selbstwahrnehmung aber einmal etabliert war, kam es zu einer art operativen schliessung und entwicklung von techniken, die wir dann auch bei trump zu spüren bekamen:

- die entwicklung von filter- und gruppierungsprozessen, bei denen man zunehmend nur noch das zu sehen bekommt, was man sehen will und was die eigene meinung bestärkt (blocked bye). ich bin kein fan des konzepts der filterbubble, weil es auf individueller ebene einfach kein problem ist, weil jeder seinen inputstrom so variabel halten kann wie er will; aber sozial verschaltet wird tatsächlich eine eigene dynamik getriggert, wenn leute beginnen den realitätsbezug sozial aufzugeben. wobei dabei ganz interessant ist, dass es weniger ein problem der sichtbarkeit von aussagen oder fakten ist – die gruppen besuchen sich auch gegenseitig um zu trollen usw. – sondern dass es eher darum geht, die eigene bewertung davon zu bestätigen.

- die ausbildung einer paranoiden wahrnehmung, bei der schon die kleinsten dinge als beweis für eine verschwörung herhalten können. der ursprung der paranoia entsteht dadurch, dass das wahrgenommene gefühl des eigenen stroms nicht in der wahl amerikas reflektiert wird (die ursache dafür war bei big brother aber ganz lapidar, dass sich auf verschiedenen plattformen verschiedene fangruppen gefunden haben – auf twitter sind die fans der misfits, auf reddit die fans der plastics. im eigenen strom schwimmt man in einer bequemen mehrheit, den vl. grösseren schwarm zwei ecken weiter sieht man nicht). einmal etabliert beweist aber potentiell alles die verschwörung.

- damit verbunden das verlieren von jedem maßstab resp. das verzerren von aussagen. stundenlange schimpftiraden sind gleichwertig wie ein ‘jeez, das sind solche idioten’, schon eine handvoll an fehlern reicht aus, um sie im argumentativen tresor zu verwahren und bei bedarf immer wieder herauszuholen.

- eine verpflichtung für alles sein zu müssen, was den eigenen kandidaten begünstigt oder den anderen kandidaten benachteiligt, und gegen alles sein zu müssen, was den eigenen kandidaten benachteiligt oder den anderen kandidaten begünstigt (ansonsten schnell: hast du heute deine medikamente vergessen? achtung, dein account wurde gehackt)

- ganz interessant dabei ist, dass neben der genuinen dummheit auf semantischer ebene, das kollektiv durchaus eine systemische schlauheit entwickeln und zu erstaunlich effektiven verfahren kommen kann (nur als beispiel: bei den votings ist es wichtig, die stimmen auf ein gemeinsames ziel zu konzentrieren, weil man sonst auch bei gegebener mehrheit gegen eine einheitliche minderheit verlieren kann; und während sich auf der ebene der interpretation von votings eher die bizarren thesen der grössten beliebtheit erfreuten, so hat es nur eine weitere woche gebraucht, bis mechanismen zur selbstorganisation etabliert waren)

- neben der entwicklung von schlauen spielzügen eine parallele entwicklung von mehr oder weniger legalen tricks, das spiel selbst zu unterlaufen (um beim beispiel votings zu bleiben: neben den methoden zur selbstorganisation wurden gleichzeitig techniken entwickelt, die die selbstorganisation der anderen seite verhindern oder unterlaufen sollten – manipulation der polls, versuch der infiltration der anderen mit fake-accounts, usw.). viele aktivitäten griffen dann auch schnell unter die gürtellinie, verspottende meme sind noch eher die angenehmeren symptome. das problem der legitimität stellt sich deshalb nicht, weil man eben selbst die unterdrückte gruppe ist und in reiner notwehr handelt.

- das spiel ist selbst asymmetrisch; where they go low we go high oder ein bezug auf rationalität sind keine strategien, mit denen man gewinnen kann. blöderweise hätte man mit einem where they go low we go lower noch mehr verloren.

das nur auf die schnelle, aber ich glaube die ähnlichkeiten mit dem wahlkampf von trump sind leicht zu erkennen (der grösste unterschied ist natürlich, dass sich im falle trump ausgerechnet die weiße mehrheit als unterdrückt empfunden hat, von den bürokraten in washington, von den liberalen medien, von den bankern an der wall street, von der sprachkontrolle der politisch korrekten, vom system clinton, von allen anderen, die ihnen die waffen wegnehmen wollen, usw.).

(der kapitale fehler war glaub ich nicht, dass wir uns auf falsche politische gewissheiten verlassen haben und die medien deshalb ihrem auftrag als überzeuger der mehrheit vom anständigen nicht nachgekommen sind, wie es sascha lobo in seiner analyse vermutet. wobei es eine fatale falsche gewissheit gab, nämlich die annahme, dass trump niemals wirklich gewählt werden würde, die vorstellung war einfach absurd; das hat niemand so gesagt, als horrorszenario wurde die möglichkeit natürlich betont, aber ich glaube es haben die wenigsten wirklich gedacht. reine spekulation, aber ich kann mir gut vorstellen, dass der gesamte wahlkampf anders abgelaufen wäre, wenn trump als realistische option empfunden worden wäre. retrospektiv kommt mir eher vor, dass der wahlkampf von clinton und allen liberalen medien primär auf verwaltung eines 5% vorsprungs ausgelegt war, wahrscheinlich um sich nicht unnötig auf versprechungen oder konkrete positionen festlegen zu müssen, die sich dann in der amtszeit vl. rächen könnten. kleines indiz dafür war, dass sie nicht einmal eine alternative rede vorbereitet hatte.)

wobei die frage bleibt, was man tun hätte können oder was man in zukunft tun kann. wobei man aber zumindest sehen kann, was in dieser konstellation nicht funktioniert – nämlich das aufklären und informieren, das verstehen und gute zureden, auch nicht das emotionalisieren. am ehesten bleibt wohl eine gute politik, die die rechte von allen menschen angemessen festschreibt.

Papierkorb pt. 144

(kl. nachtrag zu den minimal models pt. 3 : ein relativ wichtiger parameter, den ich dort ausgelassen habe, ist die jeweilige soziale/monetäre/symbolische signifikanz. sprich: was wichtig oder teuer ist, darf auch mal überlegung/aufwand erfordern und muss keine einclickgeste sein; und je wichtiger und teuerer es ist, desto mehr überlegung/aufwand darf erwartet werden)

((was nur zur sicherheit nicht bedeutet, dass irgendwas von mobilen apps nicht abgebildet werden kann, solange sie nicht spürbar schlechter als die beste nichtmobile alternative sind))

Minimal Models pt. 3 (Gadget Edition)

(für aufmerksamere leser: das folgende modell ist im ersten teil ein remix vom minimal model pt. 1, der media edition und ich ersetze eigentlich nur die begriffe; im zweiten teil bespreche ich dann aber die teilweise auch gegebenen unterschiede)

part 1

stellen wir uns einmal eine welt vor, in der für den gemeinen menschen es nur eine art an computativer gerätschaft gibt: gehäuse, in denen eine platine steckt, die man mit dingen wie einem prozessor, arbeitsspeicher, festplatten, karten für diverse erweiterungen, tastatur, maus und einem monitor verbinden kann. man kann die internen komponenten austauschen, wie man will; man kann die externe peripherie anschließen, die man will; man kann das betriebssysteme und die software installieren, die man will; man könnte auch selbst komponenten bauen oder software entwickeln und verkaufen, wenn man es kann und einem danach ist. man kann unter dem strich damit machen, was man will. nennen wir sie PC.

alle, die bedarf an einer computativen gerätschaft haben, benutzen PCs für alles, was sie tun wollen (moorhuhn spielen, sich zahlen für die spreadsheets vom business plan ausdenken, musik produzieren, AI-algorithmen programmieren, etc.), was sollten sie auch sonst tun. es wird sich ein bestimmter raum an entwicklern von hard- und software einerseits und benutzern andererseits ausbilden, und die benutzung wird sich auf einem gewissen aktivitätsniveau mit einer gewissen, je spezifischen verteilung von ‘jobs’ der benutzung einpendeln.

stellen wir uns nun vor, dass dann eine zweite gerätschaft hinzukommt, die alle komponenten von einem solchen PC so schrumpft, dass sie inklusive berührungssensitivem bildschirm in eine tafel zotter schokolade passt. man kann zwar nicht mehr alles machen was man will, aber man kann sich noch immer apps aus einem kontrollierten store herunterladen und diese apps dann benutzen wie man will. nennen wir sie iphone.

was wird passieren?

- leute werden eine ganze reihe an neuen ‘jobs’ entdecken, die mit dem neuen, viel kleineren und viel billigeren gerät plötzlich sinnvoll werden (einige, weil sie davor grundsätzlich unmöglich waren, andere, weil sie davor grundsätzlich möglich aber gwm. sinnlos oder unpraktikabel waren).

- es wird eine umverteilung/migration der beteiligung geben: leute werden beginnen, iphones statt PCs für die neuen jobs zu verwenden, und für die jobs, für die iphones besser als PCs geeignet sind. (für welche dinge sich neue gerätschaften besser eignen ist übrigens schwer vorauszusehen; es gibt einige jobs, die auf dem iphone erstaunlich gut funktionieren)

- einige leute werden sich erstmals eine computative gerätschaft zulegen, entweder weil sie erstmals für sich sinnvolle jobs entdecken oder weil sie für sie erstmals einfach oder billig genug ist.

- einige andere werden fortan PCs und iphones verwenden, einige wenige weiterhin nur einen PC, einige nur oder nur noch iphones.

- die anzahl der benutzer von gerätschaften wird insgesamt zunehmen.

- die anzahl der ausgeführten ‘job-ereignisse’ wird in diesem fall wohl dramatisch zunehmen, nicht nur weil das iphone vor allem sehr ‘kleine’ jobs ermöglicht, sondern auch weil man das iphone 24/7 bei sich tragen kann und man damit also diese kleinen und kleinsten aktivitäten permanent ausführen kann.

- der marktanteil der gerätschaften wird sich verschieben. (die gesellschaftliche bewertung davon ist jedoch eine schwierige sache, weil der marktanteil an den gesamten aktivitäten tatsächlich nichts über die nachhaltigkeit oder gesellschaftliche relevanz der nützlichkeit aussagt.)

als ergebnis entsteht irgendwann jedenfalls ein neues technologisches milieu mit zwei ebenen der ausdifferenzierung: einerseits differenzieren sich die gerätschaften ‘gegeneinander’ aus; andererseits differenzieren sich innerhalb der einzelnen gerätschaft die aktivitätspotentiale der jeweiligen jobs untereinander aus. sowohl die gerätschaften selbst als auch die qualität und quantität der ‘jobs’ innerhalb der jeweiligen gerätschaft pendeln sich auf einem gewissen neuen aktivitätsniveau ein.

these:

mit jeder weiteren gerätschaft entstehen – immer der gleichen logik folgend – jeweils immer wieder neue milieus, die sich jeweils immer wieder einerseits bezüglich der gerätschaften untereinander und andererseits in jeder gerätschaft in sich selbst bezüglich der jobs und ereignisse ausdifferenzieren.

(neue gerätschaften entstehen üblicherweise durch einführung von neuen unterscheidungen, die technologisch möglich werden; neben der unterscheidung offen, modular, klobig und stationär (PC) und geschlossen, monolithisch, handlich und immer dabei (iphone) wie in unserer welt, gibt es viele andere, wie ausdifferenzierung entlang der grösse des screens, der art der eingabemöglichkeit (keyboard+maus, touch, voice, etc.), der autonomie (autonom und selbstbetrieben/abhängig von der cloud), bzgl. des formfaktors, bzgl. des preisfaktors, bzgl. des freiheitsfaktors und vielen anderen. und jede unterscheidung verdoppelt gwm. die anzahl der möglichen gerätschaften, wobei es aber auch clusterbildungen resp. kategorien und nicht genutzte kombinationen gibt.).

was kann man nun schon aus diesem allereinfachsten modell lernen?

- eine neue gerätschaft wird die anzahl der grundsätzlich möglichen ‘jobs’ erhöhen (etwa weil sie schneller oder kleiner oder billiger oder omnipräsent ist) und kann die anzahl der systemweit ausgeführten ‘job-ereignisse’ erhöhen oder aber auch reduzieren (etwa weil sie dinge zusammenfasst oder überflüssig macht). in beiden fällen funktioniert das leben danach idealerweise besser. die anzahl der ausgeführten job-ereignisse selbst ist jedenfalls eine völlig sinnlose metrik.1

- man kann und sollte mehrere gerätschaften gleichzeitig verwenden, idealerweise verwendet man für jeden job das jeweils dafür geeignetste gadget.2 die alte gerätschaft muss jedenfalls nicht sterben, damit die neue sinnvoll oder wertvoll wird. (das klingt offensichtlich aber viele fühlen sich leider nur wohl, wenn sie irgendwas ausstopfen und an die wand hängen können.)

- es ist ganz grundsätzlich nicht schlecht oder beklagenswert, wenn eine alte gerätschaft ‘marktanteile’ an eine neue verliert. es ist ganz grundsätzlich nicht gut oder bejubelnswert, wenn eine neue gerätschaft ‘marktanteile’ gewinnt und eine alte verdrängt. das ergebnis der anpassung ist ein gleichgewicht auf höherem niveau. es gibt ganz grundsätzlich nichts zu urteilen, sondern nur was zu beobachten. (don’t ask yourself if this is a good thing or a bad thing. ask yourself what’s going on)

- der ‘marktanteil’ der verschiedenen gerätschaften ist auch nicht sinnvollerweise vergleichbar, weil sie völlig unterschiedliche funktionen mit unterschiedlicher wertigkeit entlang der achsen persönlich, sozial und system (siehe querfinanz ) erfüllen können.

- es bringt nichts, die alten marktanteile im neuen milieu retten zu wollen oder künstlich zu pimpen. (marktanteile sind kein recht und auch kein erwartbarer effekt einer ‘anstrengung’, marktanteile reflektieren die homöostatische ausdifferenzierung aller zu einem zeitpunkt gegebenen parameter)

- die effekte und möglichkeiten der jeweiligen gerätschaft sind also keine ‘leistung’ der gerätschaft oder der hersteller, sondern effekte, die durch die benutzung entstehen.

- es gibt strukturell keine zeitlichkeit oder vorrecht der einen gerätschaft über die andere; ist die neue gerätschaft einmal da, koexistiert sie mit allen anderen gerätschaften gleichwertig. (der kleine vorteile von der historisch älteren gerätschaft ist, dass die leute erst wechseln/ihr verhalten adaptieren müssen und die (natürlich sunk) costs der anschaffung. das asymptotische gleichgewicht für eine bestimmte konstellation ist aber zeitlos.) zwar wird es im konkreten historischen verlauf gewisse wellen geben (überschätzung am anfang, zuerst hysterie und dann verachtung bei beobachteter abnahme, etc.), früher oder später passt sich die verteilung jedoch an, weil das kämpfen gegen die ineffizienzen zu teuer wird.

- ganze kategorien von gerätschaften können durchaus auch obsolet werden und verschwinden. (allerdings sollten sie überleben können, solange es zumindest einen halbwegs populären ‘job’ gibt, für den sie die gerätschaften sind, die dafür am besten geeignet ist.)

- gelegentlich können die verschiebungen und migrationen ob eines neuen gadgets auch sehr schnell gehen und/oder sehr grosse auswirkungen haben.

- es ist wirklich wichtig, nicht den fehler zu machen, die übergangsphase von einem zustand in den neuen als etwas anderes als eine anpassung ans neue gleichgewicht zu interpretieren. (das ist natürlich der fehler, den alle machen, die sich zahlen von neuen formfaktoren anschauen und dann aleatorisch extrapolieren um dann wasauchimmer und jedenfalls den tod von irgendwas zu prognostizieren.)

- auch wenn kategorien von gerätschaften wegen anderen kategorien üblicherweise ‘marktanteile’ verlieren, so wird doch gleichzeitig auch ihr eigenes profil geschärft. sie werden also besser, weil sie zunehmend für die jobs herangezogen werden, für die sie wirklich geeignet sind.

bis hier verlief das modell mehr oder weniger synchron zum media model. die unterschiede möchte im folgenden abschnitt skizzieren:

part 2

- im vergleich zum media model – bei dem sich die medien primär gegeneinander ausdifferenzieren und dabei gwm. inhaltliche formkörper etablieren – gibt es hier doch eine viel stärkere abhängigkeit von technologischen entwicklungen und sozio-ökonomischen umständen, was zwei konkrete serien triggert:

(a) eine art gemeinsame ‘technologische phylogenese’ bei der entstehungsgeschichte der gerätschaften, einfach weil bestimmte unterscheidungen von technologischen errungenschaften abhängig sind. für die unterscheidung online/offline braucht man das web; für die unterscheidung stationär/mobil braucht man das mobile web; für gewisse formfaktoren müssen bestimmte komponenten klein genug, oder schnell genug, oder billig genug sein, etc – wobei sie das dann aber für alle immer gwm. zum gleichen zeitpunkt werden.

(b) gleichzeitig kann man auch eine viel stärker variierende individuelle ‘technologische ontogenesen’ bei der adaption der gerätschaften erwarten, einfach weil die lebensläufe konkrete und viel härtere umstände etablieren, die den zugang zu und den umgang mit gerätschaften definieren.

- während die phylogenetische serie aus der perspektive der atemporalität betrachtet werden sollte – i.e.: ist eine gerätschaft erst mal da, muss die welt so tun, als wäre sie schon immer da gewesen, und das ist wichtig, weil die jeweiligen umverteilungen dann keine progression weg von einem und hin zu einem besseren anderen sind, sondern eine homöostatische anpassung an das gleichgewicht, das es geben würde, wenn es alle gerätschaften immer schon gegeben hätte – müssten die ontogenetischen serien empirisch pragmatisch und politisch beschrieben werden (was den rahmen dieses modells aber sprengt).3

- statt unseren blick jedenfalls auf das systemisch irrelevante technologisch ‘werdende’ oder ‘wachsende’ zu richten und ohne uns von der berechtigten kritik an den gesellschaftlichen bedingungen zum zugang zu sehr ablenken zu lassen, sollten wir also primär die ausdifferenzierung der jobs im auge behalten, die in bestimmten technologischen milieus dann möglich werden und die konkrete benutzung dann tatsächlich empirisch/ethnographisch beschreiben.4 es reicht, vl. verständlicher formuliert, nicht aus zu messen, wie oft eine gerätschaft benutzt wird, man sollte sich vor allem auch anschauen, wofür und mit welchen persönlichen und gesellschaftlichen konsequenzen.

exkurs: jobs und mobility

schauen wir uns vl. kurz an, wofür etwa iphones geeignet sind und wofür nicht.

(a) sie sind perfekte persönliche entertainment- und consumption devices. man kann radio, musik oder podcasts hören wo und wann man will; man kann youtube-videos oder tv-serien anschauen wo und wann man will; man kann sich mit spielen soviel zeit vertreiben, wie man will, man kann kürzere artikel lesen, so viele man will, solange die augen noch können.

(b) sie sind perfekte persönliche communication devices. sie machen einen via text, chat oder skype dauererreichbar und wer muss kann sogar emails schreiben oder telefonieren.

(c.) sie sind perfekte persönliche butler für dinge, die gerade anstehen (wo bin ich gerade? wo ist das nächste? wie wird das wetter? welcher song spielt gerade im hintergrund? was kostet das bei amazon? wie viel ist 31+5? bestell ein taxi! übersetze mal schnell! sie sind eine universelle fernbedienung, sie können sogar das garagentor öffnen, usw.)

(d) sie sind perfekte persönliche documentation devices. man kann photos machen, videos drehen, tonaufnahmen machen, wer will kann auch seine aktivitäten erfassen, seine biodaten erfassen, seine geodaten erfassen, etc. und alles visualisieren und archivieren.

(es ist also ein no brainer, dass jeder mensch, der auch nur irgendwie dazu die möglichkeit hat, ein iphone haben wird. und man braucht kein via vertrag querzufinanzierendes absurd überteuertes iphone: ein ungesperrtes moto-g auf dem ein near-stock marshmallow läuft kostet $130, für $10/m bekommt man vertragsfreie 1,5GB daten pro monat, es sind die bezahlbarsten zaubermaschinen aller zeiten und man muss schon sehr stur sein, um sich dem zu verweigern. statt iphone sage ich fortan also smartphone)

gleichzeitig sind sie für andere dinge weniger gut geeignet. spielfilme schaut man sich doch lieber auf einem grösseren screen an. etwas längere emails oder blogposts sind vl. noch möglich aber nicht praktisch, fürs verfassen von langen texte sind sie wirklich unpraktikabel. auch das recherchieren von nicht ganz trivialen zusammenhängen wird schnell umständlich. man wird auf ihnen auch nicht programmieren oder komplexere produktionsprozesse definieren (in diesem sinne sind sie keine autopoetischen gerätschaften), etctrara. alles, was nicht in eine serie an einfachen, kleinen happen aufgeteilt werden kann, wird schnell schwer.5

smartphones sind also perfekte gerätschaften zum konsum von wert und für persönliche und phatische kommunikation, zur produktion von gesellschaftlichem wert für andere und von sozialem sinn sind sie aber ungeeignet.6

aber warum ich auf diesen statements of the obvious so herumreite: es hilft zwei fehler zu vermeiden, die bei der naiven extrapolation von ‘mobile’ und ‘iot’ üblicherweise gemacht werden:

(a) die von den ganzen mobile-firstlern gemachte annahme, dass sich die mobilen verteilungen anteilsmässig wie die davor bei den PCs verhalten werden. und weil bald 90% mobil abläuft, sollte man also möglichst viel auf mobil werfen, weil es ja ein 10x so interessanter markt ist. was dabei aber übersehen wird ist, dass im mobilen 95% der aktivitäten mit einer handvoll an anwendungen verbracht wird – eben denen, die die primären anwendungsfälle am besten lösen – und plötzlich streitet man sich mit zwei millionen anderen apps um die verbleibenden 5% krümel, was schon eine deutlich unattraktivere proposition ist (in der es natürlich noch immer interessante meganischen gibt, die sich aber auch wieder mit einem sehr fetten head und sich einem schnell ausdünnenden langen schwanz verteilen; tools wie googles firebase helfen vl. noch eine zeit lang, dort zumindest relative vorteile zu haben, sind mittelfristig aber nur ein race to the bottom, weil sie ja von allen anderen auch eingesetzt werden). man sollte sich also gut überlegen, ob das eigene soziale objekt oder der eigene anwendungsfall für mobile geeignet ist oder nicht und wie man ihn ggf. ‘mobilisiert’.

(niemand heuert zb. ein handy an, um damit einzukaufen, was ja die unhinterfragte prämisse im feld ecommerce zu sein scheint. apps müssen einen signifikanten und konkreten nutzen offerieren, der sich aus den spezifischen möglichkeiten des smartphones ergibt – sprich lokalität, identität, einfachheit im bezahlen, habitualisierte gesten (eg. tinder), zeitfaktor wie auktionen oder stündliche aktionen, ggf. sozialität, von mir aus auch coupons, etc., ansonsten ist der screen einfach zu klein und man setzt sich halt am abend an sein macbook. eine ausnahme ist der vl. gerade deshalb von allen so gepushte bereich chat(bots), weil hier die grösse des screens relativ unwichtig ist. einfach das motto mobile first auszurufen bringt jedenfalls nichts, wenn man keinen zumindest wirklich guten job dafür hat, und die eigene app mit gewalt zu pushen bringt überhaupt nichts, weil sie auch genauso schnell wieder gelöscht ist oder vor sich hin gammelt, wenn sie keinen nachhaltigen und einzigartigen wert für den benutzer offeriert. app-installs zu kaufen ist ähnlich sinnvoll wie twitter-followers zu kaufen. die 100k schauen gut aus, bringen aber exakt nix. wer die zalando-studies von excom verfolgt, der kann derzeit quasi in echtzeit mitverfolgen, wie zumindest systematisch versucht wird, für sich selbst/den gesamten bereich mode einen mobilen shopping-sinn zu finden)

(b) die von der tech-crowd gerne gemachte annahme, dass sich diese gegenüber dem PC exponentielle nützlichkeit des smartphones dann auch in den kommenden kategorien an gerätschaften (watch, biochips, smart-xy, usw.) immer wieder fortsetzen wird und die singularität also naht. auch hier gibt es sicher noch grössere und kleinere ritzen und potentiale, aber man sieht glaub ich schon bei der apple watch sehr schön, wie wenig echten mehrwert sie generiert, selbst wenn sie in ein paar jahren auch ohne iphone funktioniert (wobei ich übrigens trotzdem glaube, dass sie ihr geld allemal wert ist, wenn man im apple kosmos bleiben möchte und nicht mit einer pebble oder so experimentieren möchte, die derzeit an interessanteren stellen herumschrauben). auch voice – also alles von siri bis echo – hat seine grenzen (und leidet vor allem auch der dämlichen und auch von niemandem hinterfragten grundannahme, dass leute wirklich mit ihren gerätschaften sprechen wollen, was die entwicklung der szenarien behindert, wofür voice wirklich am besten geeignet ist, die es natürlich auch gibt; aber auch bei voice wird das gerade beobachtbare explosive wachstum fälschlicherweise als unaufhaltsames neues paradigma und nicht als homöostatische anpassung interpretiert). und der gesamte komplex iot generiert jährlich gerade tausende neue gadgets, aber keiner weiss so wirklich warum; alle laufen, weil alle anderen auch laufen, aber die paradigmatischen anwendungsfälle sind noch immer das garagentor, kustomisierbare beleuchtung, der selbst die milch nachbestellende kühlschrank und ansonsten fast immer gimmicks, die zwar fans vom yps natürlich das herz höher schlagen lassen, aber das leben nicht wirklich verbessern. öfter als nicht verkomplizieren sie unnötigerweise dinge, die man mit einem handgriff auch einfach selbst tun könnte. aber davon abgesehen: es gibt nur wenige ‘perfekte’ gerätschaften, die eine art idealer universeller canvas für alles mögliche sind (und apple hat interessanterweise 3 davon: das iphone SE, das kleine ipad pro und das 13’ macbook pro, irgendwas machen sie also richtig) und wir werden wohl in nächster zeit resp. bis zur nächsten radikalen technologischen unterscheidung keine weitere mehr sehen. bis dahin zerfasern sich die kommenden verteilungen zunehmend an den rändern und müssen sich also eher eine ebene darüber an emergente thematische plattformen andocken, die den gemeinsamen leim und infrastruktur liefern (und die sich derzeit gerade um den besten platz in der ersten reihe streiten, themen sind etwa car, home, payment, health, usw.)

—-

1 besonders blöd ist natürlich die annahme, dass mehr benutzung besser und/oder wünschenswert ist; ich habe überhaupt nichts gegen die sinnlose benutzung von technologie als freizeitbeschäftigung oder zur überbrückung von zeit, aber die benutzung von technologie erzeugt nur wert, wenn sie das leben eines benutzers verbessert und/oder mehr zeit für andere dinge erzeugt, und sie generiert nur sozialen sinn, wenn sie anschlusskommunikation ermöglicht; wert entsteht jedenfalls nicht, indem man möglichst viel leben mit technologie verbringt.

2 hier spielt natürlich der preisfaktor eine rolle, dh. man muss entweder in gerätschaften investieren, kann alternativ aber immer auch aus dem eigenen bündel vorhandener gerätschaften selektieren.

3 nur zum beispiel: das ipad ist nicht der bessere PC, das ipad ist die gerätschaft für leute, die keinen weiteren ansprüche an jobs haben als die, die das ipad kann (was übrigens völlig ok ist); das smartphone ist nicht schon bei 80% und also schon fast der endpunkt der evolution, das smartphone ist die gerätschaft für die 99% unserer aktivitäten, für die es gut genug ist, usw.

4 jobs können üblicherweise von mehreren gadgets jeweils mehr oder weniger gut erledigt werden. gerätschaften können andererseits auch mit peripherie kombiniert werden, was ihnen dann ganz andere potentiale eröffnet. einfache gadgets lassen sich etwa mit einem bluetooth-keyboard für aufgaben öffnen, für die sie alleine nicht geeignet wären.

5 wobei limitationen manchmal natürlich auch gut sein können, weil sie den fokus quasi erzwingen. wer mit dem iphone youtuber ist, der muss sich konzentrieren, wer mit dem iphone ein blogger ist, der muss sich kurz fassen, usw.

6 nur zur sicherheit: sowohl smartphones als auch tablets sind alles andere als reine consumption machines, vor allem für phatische kommunikation und kleine datentypen wie chat und messages, aber auch für alles was mit narration zu tun hat. ich mokiere mich nicht darüber, dass aus 1000 ausgeführten aktivitäten 990 privat und gesellschaftlich nutzlos sind; ich mokiere mich nur darüber, dass es keinen unterschied in der bewertung gibt.

Quiz Pt. 106 Solution

Ich bin euch ja noch meine Antwort auf Quiz Pt. 106 schuldig:

das sich abzeichnende Muster ist ganz einfach, dass sich jede dumme Verweigerung gegenüber dem Web früher oder später auf unerwartete Weise rächt, und dass diese Weise umso grotesker wird, je dümmer man sich angestellt hat – üblicherweise, weil man gegen den völlig falschen Feind angelaufen ist, statt zu versuchen das Web positiv mitzugestalten, solange man noch in der allerbesten Position dafür ist.

Ich habe das in der Talfahrt schon mal für den Komplex Medien angedeutet:

(karma am rande: der journalismus bekommt mit buzzfeed, heftig und co nun endlich die rechnung dafür präsentiert, dass sie die nullerjahre mit dem belächeln und verspotten von zuerst blogs und dann twitter verbracht haben, die mit ihrer zukunft wenig bis nichts zu tun haben bzw. hatten. die irritation und konsternation darüber, dass es da plötzlich was anderes gibt, wo jeder seine meinung publizieren konnte und kann, hat sie blind für alle ihre existenz tatsächlich betreffenden entwicklungen gemacht. mit der aktuellen hysterie – man denke an das schnipsel- und leistungsschutzrecht, den ‘kampf’ gegen google, das am besten zerschlagen werden soll, usw. – wiederholen sie gwm. diesen ersten fehler, nur dieses mal ganz brav nach marx und hegel nicht als tragödie, sondern als farce.)

(nts: mich öfter selbst zitieren)

Und wenn es einen anderen Komplex geben sollte, der sich dem Web tatsächlich noch konsequenter als die deutschen Medien verweigert hat, dann ist das die deutsche Politik. Die Sammlung der netzpolitischen Interventionen der letzten 10 Jahre stünde dem Schildbürgerbuch an unfreiwilliger Komik kaum nach (man denke an stoppschilder, vorratsdatenspeicherung, recht auf vergessen, de-mail, störerhaftung, rechtsfreien raum, leistungsschutzrecht oder als persönliche fehden etwa, wie s. gabriel mehr angst vor google hat als vor allem, was durch e. snowden aufgedeckt wurde, wie sich i. aigner gezwungen sah, ihre mitgliedschaft bei facebook zu kündigen, falls nicht auf die kritikpunkte der studie der stiftung warentest eingegagen wird, usw.), wenn nur die Kosten nicht eine enorme gesellschaftliche Verhinderung und Bremsung wäre.

Um die Metapher von oben aufzugreifen: die falsche von den bürgerlichen Parteien ausgemachte Gefahr war die Piratenpartei, also der unorganisierte Haufen an Spinnern, die sich für Vernetzung, eine progressivere Netzpolitik, etcblabla einsetzen, und die man nach dem kurzfristigen Strohfeuer schon als erlegt erachtete, mit dem Thema digitale Bürgerrechte sind halt keine Wahlen zu gewinnen. Nur sind die Piraten und alle anderen Netzaktivisten völlig irrelevant. Das Problem sind nicht die, die sich das als Thema Internet auf die Fahne schreiben, sondern die, die die Dynamik des Internets und die Verstärkungseffekte von etwa Facebook ‘schamlos’ benutzen und einen plötzlich rechts mit 180 überholen können. Der blaue Balken ist also das wiederkehrende Verdrängte, das Symptom des jahrelangen Misstrauens und Mauerns gegenüber dem Web, das hinter jeder Ecke Gefahren sieht, ‘Feuer’ schreit und jeden, der es nicht besser weiss, völlig verunsichert – man denke nur an Cookies, die ja mindestens so giftig imaginiert werden wie Fliegenpilze.

Quiz Pt. 102 Solution

was ist die falsche Grundannahme, die hinter jedem Sinnieren über einen algorithmischen Twitter-Feed steckt?

Ich bin euch ja noch meine Antwort auf Quiz Pt. 102 schuldig:

die falsche Annahme ist ganz einfach, dass Tweets besser oder schlechter sein können

(und daraus abgeleitet dann, dass man twitter besser machen könnte, wenn man nur die guten und allerbesten erkennt und dann hervorhebt und in der timeline besonders betont, wenn man die schlechten herausfiltert und versteckt, etc.)

Tweets haben aber keine inhärente Superheit, sondern sind einzeln betrachtet eher dull. Ihren Wert bekommen sie erst als ‘Differenz’ zu allen anderen Tweets im Gesamtsystem Twitter, das ihnen einen bestimmten Satz an Möglichkeiten zum Strömen – in Timelines, in öffentlichen und privaten Listen, in Profilen, in Suchen, etc. – offeriert, die von der geneigten Gefolgschaft ‘aktualisiert’ werden kann bzw. muss.

(natürlich gibt es tweets, die isoliert betrachtet, wenn man so will, besser/informativer als andere sind, es gibt gelungene wortspielchen, der exit von frank93 schmerzt noch immer, es gibt brilliante einsatzannotationen zum weltgeschehen, es gibt sarkastische kommentare zum fernsehen, gute links, etctrara, aber das ist völlig irrelephant, wirklich gut werden sie erst resp. nur, wenn sie im strom aller anderen gwm. aus eigener kraft erscheinen. das fischen im strom gehört also nicht nur dazu, der akt des fischens (inklusive aller meditativen und intensiven reaktionen) selbst ist wichtiger als die gefangenen fische. auch völlig unterschätzt wird hier übrigens unser kognitives potential beim prozessieren und priorisieren vom eigenen strom, zumal es ja einige visuelle clues wie den avatar oder anzahl an favs und retweets gibt)

((das bedeutet natürlich nicht, dass es kein legitimes anliegen ist, bessere clients, filter, aggregatoren, mischpulte oder rekombinatoren zu entwickeln resp. zu benutzen – die gibt es jetzt schon und da gibts auch noch viel luft nach oben -, nur sollte das eben die aufgabe von unabhängigen entwicklern/startups/plattformen sein, nicht die von twitter selbst, weil twitter natürlich immer nur eine interpretation vom bedeutsamen tweet realisieren kann, während es natürlich immer eine vielzahl an möglichen heuristiken gibt; jede ‘offizielle’ priorisierung von twitter erzeugt gwm. risse im symbolische gewebe, die sich nicht mehr stopfen lassen und deren kosten (etwa die latente angst den vl. wichtigsten tweet aller zeiten zu verpassen) viel grösser sind als der mögliche nutzen))

nur am rande: twitter hat das problem, dass ihnen von allen seiten erklärt wird, wie facebook zum enormen userwachstum kam, weil sie ‘bold’ und oft auch unpopuläre ‘moves’ machten, und dass twitter nur deshalb userzahlentechnisch stagniert, weil ihnen eben der mut zu diesen grossen änderungen fehlt, dabei bräuchte es ja nur längere tweets, algorithmische timelines, bessere dm’s, lustigere filter für die kids, etcblabla, dann kommt schon die milliarde. was da immer übersehen wird ist, dass facebook in einer sehr eingeschränkten version gestartet ist, die man dann sehr leicht ‘erweitern’ konnte (von studenten zu allen, von private zu public, etc.) ohne das eigene wesen zu zersetzen, während twitter nach seiner ersten grossen iteration schon 2007 mehr oder weniger am idealen endpunkt angekommen ist und jede weitere intervention dann fast notwendigerweise eine verschlechterung darstellt. dass die algorithmische timeline bei facebook funktioniert hat, bedeutet eben gerade nicht, dass sie auch bei twitter funktionieren würde; bei facebook hat sie nur deshalb funktioniert, weil facebook nach dem prinzip bringschuld operiert; twitter hingegen basiert auf dem prinzip holschuld. das dilemma von twitter besteht nun natürlich darin, dass sie nicht zum offensichtlichen schluss kommen können, dass twitter halt doch nicht wie facebook für alle ist, sondern nur für die wenigen hundert millionen, die selbst darin den sinn und wert erkennen können; sie müssen halt auf teufel komm raus wachsen, weil die bewertungen davon ausgehen, dass jeder weltbürger in 5 jahren mit 5 twitteraccounts herumläuft.

Papierkorb pt. 113

(relativ traurig ist ja, wenn ich auf die letzten 10 jahre zurückblicke, dass ich kein eitzerl weitergekommen bin, was positive aussagen über das web oder die welt betrifft. es gibt vl. einen gewissen korpus an aussagen, aus dem man sinnvollerweise schöpfen und permutieren kann, wenn man halt irgendwas sagen will, aber was wäre schon damit gewonnen und jede non-triviale aussage bleibt ganz grundsätzlich falsch)

((wo ich ggf. schlauer geworden bin, ist beim markieren von ‘falschen’ aussagen, also aussagen, die man in der form einfach nicht machen kann. und das sind – ich übertreibe jetzt nicht – fast alle. was doch unwahrscheinlich ist, aber trotzdem so ist. und ich betone jetzt wie der freiherr von guttenberg: fast jede aussage über das internet ist ein blödsinn und das ist die wahrheit, siehe papierkorb 112. ich weiss nicht, wieso sich die welt da so anstellt, aber es ist so))

Lazy Blog Ep. 51

(blogpost über DAS fundamentale dilemma im derzeitigen und kommenden web: den umstand, dass der linke diskurs von einem semiotischen idealismus geprägt ist, der mit dem internet konfrontiert nun durchgebrannt ist)

((ein dilemma ist das vor allem deshalb, weil als effekt dieses semiotischen idealismus und des durchbrennens diese alternativlose technoskepsis entsteht, die in der konsequenz das ganze spielfeld den neoliberalen kräften überlässt, die natürlich ein radikal zynisches verhältnis zum diskurs haben, was aber nichts macht, weil die linken für sie daran glauben und ihr eigenes verhalten danach ausrichten))

(((für diesen blogpost gibt es natürlich eine ganze reihe an möglichen ansätzen, ein fruchtbarer wäre vl., das anhand einer konkreten analyse von d. dath zu tun; den habe ich ja gestern schon zum zweiten mal als deutschen morozov tituliert, siehe 625274779000565760 und dort in der sidebar auch den kontext, aber ich habe heute nacht auf youtube in ein paar vorträge von ihm reingehört und die sache ist bei ihm doch etwas komplizierter und deshalb vl. auch etwas ergiebiger. zb. sinniert er durchaus auch darüber, wie es einen technologiegetriebenen neokommunismus geben könnte (der viel mehr menschen in den produktionsprozess einbezieht, der viel weniger menschen ausgrenzt, der viel weniger menschen verblöden lässt, der menschen besser behandelt, usw.). sein problem ist dann aber, dass er einerseits auf einem unverhandelbaren set an rechten und freiheiten besteht, die er in einem vollständigen und bis in die faserspitzen durchdachten modell garantieren will, dass er andererseits aber auch jede form von ausbeutung oder kapitalistischer produktionsbedingungen schon ganz strukturell verunmöglichen will. er geht also nicht vom potential aus, sondern von der verunmöglichung von nicht vollständiger kontrolle, was ihn etwa im fall copyright in die konfliktierende position bringt, auf der einen seite jede kulturindustrielle verwertung (inkl. aller legaler konstrukte, die ihr parasitäres blutsaugen unterstützen) zu kritisieren, dem er andererseits aber nichts anderes als ein noch schärferes recht entgegensetzen kann, das halt die immateriellen verwertungsinteressen des autors noch stärker vertritt. alternativen nimmt er zwar wahr – auf der einen seite die neoliberalen irren wie amazon, die sogar einen literaturpreis für self-publisher ausgeschrieben haben, auf der anderen seite technohippies, die davon schwafeln, dass die grenzen zwischen produzenten und konsumenten ohnehin schwinden, damit aber halt auch niemanden satt machen -, bewertet sie aber anhand ihrer (zugegebenerweise blödsinnigen) selbstbeschreibung und nicht anhand von dem, was sie sind. er ist jedenfalls das paradigmatische beispiel dafür, wie man sich selbst im weg stehen kann und das gegenteil von dem was man will bewerkstelligt)))

FYI 027

fyi: das internet ist keine lösung; es ist die frage, wie die gesellschaft ausschauen würde, wenn es das internet schon immer gegeben hätte.

(wenn man so will entspricht die welt einem startup, das sich gerade selbst sucht, ich habe das in the strain schon ein bisschen angedeutet; zu bemerken sind dabei vl. zwei dinge: einerseits bekommt es diese suche mit den historischen strukturen zu tun, die es nur geben konnte, weil es das internet noch nicht gegeben hat, die die eigene existenz – inklusive aller opportunistischer unterstützungsstrukturen – nun aber bis zu den zähnen bewaffnet verteidigen; andererseits muß man aufpassen, homöostatische anpassungen an das erwartbare gleichgewicht nicht mit ‘trends’ zu verwechseln, die eine richtung in eine ‘zukunft’ beschreiben, was natürlich dazu verleitet den wert von ereignissen oder verhalten völlig falsch einzuschätzen und wertvolle techniken verfrüht abzuschreiben)

Pfeifkonzert

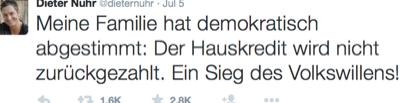

(eigentlich soll man trolle nicht füttern, aber weil es doch gwm. das paradigmatische beispiel für das zu beschreibende phänomen ist doch eine minianmerkung zum witz über die griechen von nuhr auf twitter:

es ist in letzter zeit immer öfter zu beobachten, dass jede vorgebrachte kritik an irgendwas mit etwaigen pöbeleien kombiniert und in einem schwung weggeschüttet wird. noch besser wenn es einen sogenannten gackserl-sturm gibt, damit disqualifiziert sich das gesamte restliche internet und man selbst ist das einzige opfer.

zur erinnerung: nuhr hat kurz nach dem referendum in griechenland getwittert

auch sehr wohlwollend bewertet, ist dieser witz gleich mehrfach problematisch. er kommt aus einer position der selbstgerechtigkeit und ordnungsgläubigkeit, was recht ist, muß recht bleiben, da gibt es keine nachsicht. er kommt aus einer position der stärke und macht sich über die schwachen lustig. er appelliert an das grundgefühl vom neid, was natürlich jede form von solidarität verhindert (‘ja genau, mir schenkt ja auch niemand was’). er ignoriert die gesamte geschichte der situation (und alle damit verbundenen machtpolitischen, wirtschaftlichen, diplomatischen, medialen, sozialen komplexitäten) und lokalisiert die ‘schuld’ bei den griechen, denen nur der ‘wille’ zum zurückzahlen fehlt. es ist ein witz für eine von den deutschen medien erzeugte mehrheit, der die konstruierten ressentiments verstärkt und nicht hinterfragt oder dekonstruiert. wer darüber nachdenkt findet sicher mehr, unterm strich ist es jedenfalls ein gelungenes stück populismus.

statt sich nun aber ein bisschen zu schämen, verteidigt nuhr seinen sogenannten witz in der faz dann auch inhaltlich (mit der deutschen/regierungspolitischen sandkastenargumentation, die alle vorgetragenen argumente schlicht ignoriert) und erklärt dann aber das netz und das, was es mit den menschen anstellt, zum problem. und man traut dann seinen augenen nicht, mit welchen geschützen er bei der beschreibung was er im anschluss ertragen mußte auffährt: natürlich den gackserl-sturm, der andersmeinende durch gemeinsamen bewurf mit gackserln nicht weniger als mundtot machen will; er wurde beleidigt, beschimpft, bedroht; er wurde als zensor bezeichnet, abstrus, weil er ja nicht der könig des internets ist (sic); es gab weitere beschimpfungen, beleidigungen, todeswünsche, drohungen; er wurde als nazi und in anderem zusammenhang als ausländerfeind bezeichnet, beides irrsinnige vorwürfe, die sachlichkeit vermeiden und den anderen überwältigen und ‘im digitalen vernichtungskampf’ besiegen wollen; sie wollten ihn primitiv etikettieren, um ihn, den andersdenkenden, moralisch zu diskreditieren, und das sei ‘die übliche form der auseinandersetzung’ im web; die primitivität und aggressivität der verfolgung führe zu lynchjustiz und pogromen, zum glück wird heute – anders als im mittelalter – nur noch virtuell getötet resp. digital vernichtet; der gackserl-sturm sei ganz offensichtlich die hexenverbrennung 2.0; und das werde im internet ja immer schneller; um meinungsfreiheit gehe es schon lange nicht mehr, argumente werden nur ‘in den seltensten fällen’ ausgetauscht, es gehe um meinungshoheit und die vernichtung abweichender meinungen, indem überwältigt, etikettiert, beleidigt wird; was fehlt sei die haftbarkeit des einzelnen, nur die bringt rechtsstaatlichkeit und menschenwürde; die pöbelnde masse, die wir gerade erleben, bringt uns zurück zum faschismus, vl. auch ins mittelalter; die herausforderung unserer zeit ist also die aufklärung auch ins web zu bringen.

hier ist das ding: die gesamte kommunikation, die aus dem quadranten der ‘hater’ kommt und mit dem internet teilweise erst sichtbar, teilweise erst erzeugt, teilweise sich selbst hochschaukelnd verstärkt wird, die einen manchmal wirklich fassungslos macht, ist nicht das beste, was das internet hervorgebracht hat, und ist ganz grundsätzlich niemandem zu wünschen.

sein artikel in der faz lässt jedenfalls schon die tiefsten abgründe der menschlichen seele vermuten, entsprechend vorsichtig und spät habe ich mich jetzt doch einmal an den thread zum tweet auf twitter herangewagt, aber hier wird’s interessant: die reaktionen sind in keinster weise so, dass sie eine solche tirade auch nur ansatzweise rechtfertigen würden. ich bin nicht auf facebook und dort schaut es u.u. etwas anders aus, aber im (durchaus langen) thread auf twitter gibt es vl. eine handvoll reaktionen, die man als ‘übergriffig’ bezeichnen könnte; die mehrheit der antworten besteht aus tweets, die dem witz ganz allgemein dummheit und/oder populismus und/oder mangelnden witz diagnostizieren; auch die zustimmung, die genausoists und die weitersos sind vertreten; und dann gab es auch noch eine durchaus signifikante anzahl an reaktionen, die ihm, würde er sich die mühe machen den hinweisen zu folgen, auch versuchen zu erklären, warum sein witz als dumm und populistisch und unlustig wahrgenommen wird. am ehesten entspricht das also einem pfeifkonzert, und das ist er nicht gewohnt und das verletzt vermutlich seine eitelkeit, weil er seine witze üblicherweise vor einem selbstselektierten publikum absetzt, das über jeden witz lacht. aber jede form der auseinandersetzung kann er sich und den faz-lesern sparen, wenn er ‘gackserl-sturm’ schreit und das internet zum ort der verdammnis erklärt.

(nochmal: auf facebook gab es wohl unangenehmere kommentare und die will ich nicht legitimieren; aber ich vermute stark, dass es auch dort konstruktiv/kritische stimmen gibt, die er ignoriert, weil er lieber in seiner schachtel bleibt und selbst die vorbeilaufenden mit seinem gackserl bewirft))

618786157799849984 Revisited

@kusanowsky openmedi reines bauchgefühl: das 'genie' wandelt sich von 'produktiv' zu 'perzeptiv' (zettelkasten idiosynkratisch dazwischen)

— Markus Spath (hackr) July 8, 2015kl. nachtrag zu 618786157799849984 :

vorgeschichte war dieser tweet mit einem video über luhmann und seinem zettelkasten, in dessen thread dann kusanowsky an seinen kurzvortrag über die koinzidenz von luhmann und dem internet erinnert hat, in dem er nicht weniger als einen epochalen übergang der funktion/position des gelehrten unter den bedingungen des internets skizziert. (schaut es auch ggf. an, es ist kaum zu komprimieren, aber verkürzt ist seine beobachtung, dass es die traditionelle aufgabe des gelehrten war, erkenntnis zu produzieren, die er dann der öffentlichkeit durch lehre zur verfügung stellt, wobei ihm einerseits herausragende kognitive kompetenz/genialität unterstellt wurde, deren würde er andererseits durch abschirmung vor den trollen und allem gemeinen bewahren mußte; luhmann hat dann aber sowohl dem begriff des genies als erzeuger von wissen, als auch mit dem begriff der lehre als ‘übertragung’ von wissen von einem (intelligenten) kopf in die köpfe aller anderen gebrochen, da kommunikation eben gerade nur deshalb funktionieren kann, weil die menschen nicht füreinander ereichbar sind, und der begriff des genies sinnlos ist, weil die gesellschaft nicht aus menschen, sondern aus kommunikationen besteht. das zeitliche zusammenfallen von luhmann und der entstehung vom internet könnte uns, so vermutet klaus, nun hinweise darauf geben, was wir mit dem internet nun auch im komplex ‘wissen’ anstellen könnten, wobei wir blöderweise das problem haben, dass nicht mal luhmann-schüler mit dem zettelkasten noch etwas anfangen können und wir vom internet nun überhaupt keine vorstellung haben). der tweet ist gwm. eine abrundende ergänzung: ich glaube klaus war tatsächlich auf der richtigen spur, luhmann und sein zettelkasten ist gwm. der drehpunkt für die reformatierung vom system ‘diskurs’. mit dem internet ist nämlich zwar die konzeption vom genie, das erkenntnis produziert, gestorben (just google it, big data, etc.), aber gleichzeitig als perzeptor und selektor, der im endlosstrom der daten die muster und zusammenhänge erkennt und als storyteller in eine share- und likebare narration verpackt, wiederauferstanden. luhmann hat mit der selbstdistanzierung vom ‘genie’ sicherlich ein bisschen kokettiert, aber er hat die aufgabe vom ‘genie’ konkret verschoben und zwar hin zum ‘anwender eines (nontrivialen, unwahrscheinlichen) algorithmus’. der witz bei der gesamten systemtheorie ist ja, dass sie sich tatsächlich von selbst schreibt, wenn man sie einmal verstanden hat – und für luhmann war der zettelkasten gwm. nur der inputstrom, auf den er sich freiwillig selbst beschränkt hat (was bei ihm natürlich nicht weniger als die behandlung aller hauptsysteme der gesellschaft war). das genie kann man aber trotzdem nicht ganz streichen, weil es nun der algorithmus ist, auf den man kommen oder den man erst mal verstehen muß. als mechanismus ist das nicht ganz neu, deleuze hat zb. seine philosophie in den verschiedensten feldern ‘gefunden’. aber mit dem internet bekommt dieses methodische ‘sich von selbst schreiben’ natürlich seine bestimmung, weil potentiell alles und zwar in echtzeit zum inputstrom werden kann (wobei natürlich nicht alles für jeden algorithmus sinnvoll ist, genaugenommen fast nichts für keinen, wobei dieses nichts auch wieder gigantisch groß ist, es gibt halt einfach sehr viel). man danke nur an zizek, der kann seine theorie zu so ziemlich jedem politischen oder gesellschaftlichen thema in zwei, drei tagen zu einem aufsatz implementieren, oder an bolz oder auch kusanowski, wenn man nach einem luhmann-schüler sucht.

618394991371620352 Revisited

.@martinweigert mspro diplix das 'große problem' ist doch nicht die demut/epistemologische reflexion, sondern die dummheit/arschlochigkeit

— Markus Spath (hackr) July 7, 2015@martinweigert _jk mspro diplix (nur zur sicherheit: ich meine das nicht persönlich, sondern strukturell; etwa ausblenden des int. disk.)

— Markus Spath (hackr) July 7, 2015kl. nachtrag zu 618394991371620352 weil man es doch auch missverstehen kann:

vorgeschichte war diese anmerkung von diplix über eine anmerkung von niggemeier, in der dieser sich über die pseudo-wirlassenunsauchgernekorrigieren-prozesse der medien mokiert und diplix stattdessen mehr demut im journalismus fordert, damit gewinne man eher vertrauen zurück als als ignoranter, besserwisserischer gockel. aber während demut natürlich nie schlecht ist und wenn man von der korrektur handwerklicher fehler (etwa der verwechslung einer riesigen demo gegen mit einer riesigen demo für etwas oder umgekehrt) einmal absieht, das ‘große problem’ in der berichterstattung über griechenland ist doch nicht die mangelnde demut und dass man nicht durchblicken lässt, dass man eigentlich überhaupt keine ahnung hat (und dann vermutlich die eigene ahnungslosigkeit zur eigentlichen krise erklärt und das dann diskutiert), sondern dass ein grossteil der leitmedien nicht nur keine uninformierte aber zumindest im versuch neutrale, sondern im tandem mit der regierungspolitik eine über weite strecken desinformierende, polemische und den griechen gegenüber völlig unverantwortliche und asoziale linie gefahren ist, und das auch lange, nachdem wirklich offensichtlich war, dass sowohl die maßnahmen, als auch der die maßnahmen flankierende diskurs in einer sackgasse gelandet sind und man am ende angekommen nun auch noch ein loch graben will. wer den twitterstrom von @martinlindner ein paar monate zurückliest, wird seinen augen nicht trauen, wie lange die deutschen massenmedien und allen voran die öffentlich-rechtlichen talkshows – anders als ihre internationalen kollegen, die die dissonanz zwischen plan und wirklichkeit spät aber doch irgendwann erkannten und verdauten – unisono die trope vom faulen griechen wiederholten, der sich alle probleme selbst eingebrockt hat, der jetzt schon seit jahren trotz konkreter anweisungen seine hausaufgaben nicht macht und der doch wirklich von alleine darauf kommen sollte, dass er einfach noch ein bisschen mehr sparen muss, usw. da fehlt nicht die demut, da wird ganz gezielt nur eine sehr einseitige wirklichkeit konstruiert und überhaupt nur jene stimmen zugelassen, die eben diese wirklichkeit bestätigen. ich kenne mich null aus, aber dass das gesamte hilfsprogramm nichts anderes war als ein hilfsprogramm für die betroffenen banken, dass man ein wirtschaftlich ohnehin am boden liegendes land nicht schuldenfrei sparen kann, dass die verschuldung als mittel beliebiger politischer erpressungen verwendet wird, dass deutschland mit diesem politischen gehabe gerade weltweit viel von dem ansehen verspielt, das es sich in den letzten 60, 70 jahren völlig zurecht erarbeitet hat (ehemals exzellente medien, die von aussen mittlerweile nur noch als hinterwäldlerisch wahrgenommen werden; wertebasierte politik (liberal und sozial), die zumindest in der causa griechenland von aussen nur noch als unfähig und stur wahrgenommen wird) scheint mir offensichtlich zu sein. man muß keine lösung im köcher haben, um eine falsche lösung als falsch zu erkennen.

(ich vermute, dass die wurzel dieses deutschen sonderweges im fall griechenland die gleiche ist wie im fall web 2.0 oder lsr, nämlich das zusammentreffen vom grundgefühl, dass es keinen nutznießer geben darf (dieses ich schneide mir lieber den finger ab, bevor ein anderer von meiner leistung profitiert

, siehe der parasit), mit dem umstand, dass sich die deutschen medien nur selbst lesen – und also den internationalen diskurs auf der einen seite, den socmed diskurs auf der anderen seite einfach nicht registrieren und nur in ihrem eigenen saft dahinköcheln, ohne dadurch einen wettbewerbsnachteil zu haben, weil es ja alle anderen auch tun)

The Strain

kl. nachtrag zu curate or die: die nyt hat vor kurzem ja von ihren kollegen viel bewunderndes kopfnicken geerntet, weil sie intern mal eine woche den zugang zur eigenen desktop-version gesperrt hat, damit alle ihre mobilen gerätschaften verwenden müssen und dadurch quasi gezwungen werden, sich in die mehrzahl der leser zu versetzen und die kommende ‘bedeutung’ von mobile zu verstehen.

ich glaube als experiment machen sie da etwas sehr richtiges, aber ich bin mir ziemlich sicher, dass sie daraus die falschen schlüsse ziehen werden, weil sie bei ihren bestehenden grundsätzlichen annahmen bleiben werden. und die axiomatische annahme aller verlage ist, dass es einerseits eine grundstätzlich gegebene nachfrage nach journalistischen inhalten gibt und dass sie andererseits die gottgegebenen produzenten ebendieser journalistischen produkte sind.

diese im papierzeitalter quasi seine perfekte realisation gefunden habende natürliche ordnung erlebt aus diesem blickwinkel zuerst mit dem internet/web und dann mit mobile zwar eine krise der verkauf- und verwertbarkeit, aber die struktur der ordnung selbst wird nicht in frage gestellt. wer kein zeitungspapier mehr liest, der hat vor 10 jahren die zeitung als startseite im browser gehabt, mehr web braucht man nicht; und wer kein zeitungsportal mehr liest, der verwendet google um zeitungsartikel zu finden oder facebook, um sich von den freunden zeitungsartikel empfehlen zu lassen und darüber zu diskutieren; und wer nur noch ein handy hat, der verwendet es um sich in der strassenbahn oder im park mit zeitungsartikeln über die geschehnisse zu informieren.

das medium, wie die leserschaft das eigene angebot konsumiert, wandelt sich und die aktuellen trends (omg, mehr und mehr mobile) erkennt man im analyse-tool der wahl, aber die struktur und die aufgabe resp. position der beteiligten parteien bleibt konstant.

für die zeitungsmacher ist zu jedem zeitpunkt ganz klar, dass sie der fixpunkt sind, um den die welt sich dreht. und der typische deutsche verleger geht zusätzlich auch noch davon aus, dass ihnen google, facebook und twitter einfach alles zu verdanken haben, dass leute nur auf google gehen, um die verlagsinhalte zu finden, dass leute nur auf facebook und twitter gehen, um dort verlagsinhalte zu teilen, usw. (aus dieser sicht sind so dinge wie das leistungsschutzrecht oder die forderung nach 11% vom umsatz von google zumindest nicht mehr wirr oder wahnhaft, sondern einfach kontrafaktisch grundbegründet.)

die neuen umstände werden also immer nur als fragen der form und der distribution und der monetarisierbarkeit behandelt, was nicht gestellt wird, ist die frage nach dem eigenen sinn und den neuen umständen selbst. aber der eigene sinn ist vielleicht fragiler, als nicht nur von ihnen angenommen wird.

was wie eine evolution von ‘trends’ im konsum von nachrichten ausschaut – leute lesen sie zuerst auf papier, dann auf dem portal, dann auf facebook, dann auf dem handy – müsste nämlich eher als ganz grundsätzlich neuentwicklung des gesamten ‘dispositivs’ unter grundsätzlich neuen bedingungen bewertet werden, für das alles andere als klar ist, was dort funktionieren kann und wie das funktionieren wird. die welt versucht gwm. gerade herauszufinden, wie sie ausschauen würde, wenn es das web und mobile immer schon gegeben hätte.

man kann aber fast davon ausgehen, dass der ‘journalismus’ wir wir ihn kennen retrospektiv betrachtet eher wie ein historischer zufall ausschauen wird, als wie eine gegebenheit, die nur ein zeitgemäßes gefäß suchen muss. man braucht ja nur die perspektive auf die entwicklung zu wechseln: leute haben zeitungen nur solange gelesen, solange es nichts gab, was leichter und gleichzeit gut genug war (online portale); und leute haben die zeitungsportale nur solange als startseite benutzt, solange es nichts gab, was leichter und gleichzeitig gut genug war (facebook); und auf facebook nehmen die leute die nachrichten bestenfalls noch hin, ein bisschen informiert werden und synchronisation mit der welt ist ja nicht schlecht, aber sie sind doch nicht der grund, um auf facebook zu gehen, die leute interessieren sich für sich selbst und ihre bekannten und verwandten; anders gesagt: zeitungen konnte es nur deshalb geben, weil es damals noch kein facebook gab.

und die radikalste transformation deutet sich natürlich gerade mit dem übergang zu mobile an, weil damit zwar auf der einen seite ein universeller und permanenter zugang für alle gegeben sein wird, gleichzeitig aber ganz grundsätzliche begrenzungen der komplexität des ‘rezipierten’ etabliert werden, die aber natürlich immer noch gut genug sein werden.

die leute waren gwm. jahrzehntelang zu ihrem journalistischen ‘glück’ gezwungen, aber sie haben jede möglichkeit zu was einfacherem auch immer sofort genutzt, sobald sie sich ergeben hat. der journalismus in der uns bekannten form ist also eine reine historische kontingenz, die zwar gesellschaftlich wünschenswert ist, aber niemanden wirklich interessiert.

selbst beim am weltgeschehen interessierten bildungsbürger ist die disposition grundsätzlich anders, wenn er eine mobile gerätschaft verwendet. auch wenn es theoretisch natürlich möglich ist, auf dem iphone täglich ein potpourri an kritischen, gesellschaftspolitischen, analytischen longreads zu lesen, die form und die disposition verstärkt natürlich alles snackbare und unmittelbar intensive, also die snapchats und whatsapps, die vines und instagrams, die tweets mit animierten katzengifs.

(nur am rande: gerade deshalb ist es so absurd, dass die verlage mit aller gewalt gegen google kämpfen aber apple und facebook in den arsch kriechen, weil google gwm. der einzige kanal ist, über den sie intentional offene, weil eben genau nach dem thema suchende besucher bekommen. alles was sich über sharing aufschaukelt oder ausdifferenziert ist zwar viel ‘erfolgreicher’, muss aber auch mit einem gähnenden wegwischen nach 2 sekunden rechnen)

aber um zur ausgangsthese zurückzukommen: die frage ist natürlich, was die richtigen schlüsse auf das experiment der nyt sein könnten. und das wird ein harter knochen, weil das baumaterial nur der sinn sein kann.

FYI 013

fyi: thesen über die wirksamkeit vom web muß man weder vermuten noch begründen oder beweisen, man braucht nur auf ein funktionierendes beispiel zu zeigen.

(gibt es kein empirisches beispiel ist das üblicherweise kein schlechter hinweis darauf, dass eine annahme nicht stimmt; das web ist also weniger ein spekulatives und/oder utopisches medium, sondern ein materialistisches)

Durchschnittlichkeit und Zufriedenheit

‘mögen deine wünsche in erfüllung gehen’ ist ja einer dieser chinesischen flüche, die sich früher oder später besonders hinterlistig bewahrheiten – und am umstand, dass es durch das vom web bedingten unbundling und microchunking zu einer strukturellen krise der durchschnittlichkeit, besonders zu einer krise des durchschnittlichen textes kam, ist vielleicht einer der hinterlistigsten bewahrheitungen.

wir erinnern uns: neben dem hypertext, also der möglichkeit zur vernetzbarkeit von texten, was der grundsätzlichen kern vom web ist, war die damit verbundene entkoppelung der textfragmente von ihrem kontext, die das freie flottieren und beliebige rekombinieren und reaggregieren von texten, informationen, gedanken und also ein genuin neues dispositiv ermöglicht, die zentrale metapher und wunschvorstellung für die zukunft von text.

was auf semiotischer ebene jedoch wie ein paradies klingt, hat nicht mit den psychologischen resp. infoökonomischen nebeneffekten gerechnet.

ganz allgemein gesagt sind menschen relativ unkomplizierte und leicht zufriedenzustellende lebewesen, die mit durchschnittlichkeit gut leben können, solange das gesamtpaket stimmt. ein, zwei goodies reichen aus, um der gesamten restlichen durchschnittlichkeit zumindest den notwendigen hauch von wertigkeit zu verleihen.

(durchschnittliches als angenehm empfinden zu können ist übrigens alles andere als ungeschickt, weil es nicht nur naturgemäß viel mehr durchschnittliches als besonderes gibt und man sich also über viel mehr im leben freuen kann, sondern weil das durchschnittliche in den allermeisten fällen auch völlig ausreicht. dieser von der werbung erzeugte wahn immer nur das allerbeste zu wollen ist aber ein völlig anderes thema).

bündel und pakete sind jedenfalls notwendige formen, uns viele durchschnittliche einzeldinge als angenehm wahrnehmen zu lassen und uns zufrieden zu stellen. bricht man die bündel jedoch auf, liegen die dinge plötzlich isoliert vor uns und müssen also einzeln beurteilt, bewertet und empfunden werden. das hat natürlich gegenüber dem bündel einen riesigen vorteil – man kann sich die rosinen aus dem kuchen picken (wenn man rosinen mag, ansonsten kann man sich den kuchen aus den rosinen picken), es hat aber auch eine ganze reihe an nachteilen. die notwendigkeit plötzlich alles einzeln beurteilen, bewerten und empfinden zu müssen ist nicht nur aufwendig und belastend, die davor geniessbare durchschnittlichkeit verliert entbündelt sogar ganz grundsätzlich den zugang zu diesem naiven genuss und muss sich plötzlich die frage gefallen lassen, warum man nun gerade es und nicht etwas anderes lesen soll, usw.

die zwei paradigmatischen formate, die mit dem internet entbündelt und in die einzelnen bestandteile zerlegt wurden, sind natürlich zeitungen und LPs.

bei LPs sind die effekte jedem musikliebhaber bekannt: das snacken nur an den ‘besten’ songs eines albums ermöglicht zwar viel mehr streuung, discovery und durchschnittlich eine viel höhere einzelintensität der gehörten tracks, aber es geht auch der persönliche bezug verloren, den man etwa in den kleinen aha momenten entwickelt, wenn ein song, den man bis dato völlig ignoriert hat, plötzlich der lieblingssong eines albums wird usw. (natürlich funktioniert das nur bei alben, die wirklich als solche bestimmt sind und denen das auch gelungen ist, aber guten musikern gelingt das oft). das vermeiden der durchschnittlichkeit und die erhöhte intensität der einzelstücke macht gleichzeitig den hörer selbst unzufriedener, weil er fortan immer auf der suche nach etwas besserem sein muss. die sehnsucht nach dieser bindung an etwas vorgegebenes erkennt man ja am comeback von vinyl.

und bei zeitungen sind die effekte allen ausser den zeitungsmachern bekannt: ein davor wirklich großartiges papierbündel zerfällt zu einem losen haufen an artikeln, die fast alle durchschnittlich und nicht besser oder schlechter als die artikelhaufen aller anderen zeitungen sind und für den leser also eine einzige infoökonomische zumutung sind (für den übergang vom wertvollen bündel zum wertlosen haufen können die zeitungen nichts, ihre plötzliche wertlosigkeit war gwm. höhere gewalt; woran sie allerdings selbst schuld sind, ist, dass sie die situation und ihre position nicht verstehen, den kopf in den sand stecken und dort dann versuchen, ein liedchen zu pfeifen). die wirklich einmaligen artikel, die eine zeitung an einem tag erzeugt, die man also nicht gleichwertig überall sonst findet, dürften sich im einstelligen, bei wochenzeitungen vl. im zweistelligen bereich befinden und die muss man natürlich auch erstmal finden.

aber interessanter als die krise der texte der zeitungen ist der umstand, dass dieses verhältnis jede art an text betrifft und sich früher oder später also direkt in den text selbst einschreibt. es hat eine zeit lang gedauert, bis wir das bemerken können, weil sich natürlich auch die produktions- und rezeptionsbedingungen anpassen müssen, durch die verstärkung dank social media wird die logik jedoch langsam sichtbar:

damit durchschnittliche texte, die bisher ein perfekt feines dasein als füllstoff führen konnten, im haufen aller aufgelösten artikel aller einen funken wert behalten können, müssen sie jetzt auf irgendeine art auch isoliert und autonom funtionieren. und dafür gibts zwei primäre möglichkeiten: entweder sie stiften selbst ‘sinn’ für den leser, enthalten zumindest etwa eine nützliche information; oder sie erzeugen eine ‘erregung’, also das kompakte gefühl eines lols, oder wins, oder omgs, oder cutes, oder fails, oder wtfs.

und woran erkennt man, ob ein text ‘sinn’ oder ‘erregung’ erzeugt? genau, er wird geshared. wenn ein text im web von niemandem geshared wurde, wurde er dann überhaupt geschrieben? der verbliebene wert von durchschnittlichen texten im zustand der entbündeltheit zeigt sich also in der sharebarkeit.

das ding jetzt ist natürlich, dass sinn nicht nur viel schwerer zu produzieren ist, es erfordert auch viel mehr aufwand vom leser, ihn zu erkennen, und es ist auch viel riskanter ihn zu sharen. und dass erregungen andererseits nicht nur viel leichter erzeugt werden können als sinn, erregungen können auch viel schneller aufgeschnappt werden und erzeugen also auch viel eher anschlusskommunikation und selbstverstärkung in den sogenannten erregungswellen. ich habe oben die lols, wins, omgs, usw. als qualifizierer von erregungen nicht zufällig von buzzfeed zitiert – sie zeigen, wie präzise buzzfeed diese logik schon vor langem erkannt hat und deshalb nur noch genau diese art von texten produziert. buzzfeed ist eine maschine zur produktion und distribution der letzten durchschnittlichen texte, die noch verwertbar sind.

die zeitungen, zumindest die qualitätszeitungen, haben nun natürlich das problem, dass sie in ihrem selbstverständnis die produzenten vom sinn sind und die produzenten von erregungen gwm. verachten müssen und sie sich dadurch quasi auf diese eine position festlegen; gleichzeitig produzieren sie natürlich in realität deutlich mehr (unsharebaren und austauschbaren) fülltext als sonstwas, erzeugen also viel weniger leistung, als sie es in ihrer selbstwahrnehmung glauben; nur müssen sie auch ihren kollegen von buzzfeed dabei zuschauen, wie die ganz ungeniert eine wissenschaft der verpönten sharebaren erregungen entwickeln können und ihnen die PIs, die aufmerksamkeit und die werbegelder und fast den ganzen kuchen wegknabbern.

von dieser logik sind natürlich auch die blogs betroffen. auch die konnten in den ersten 10, 15 jahren gut mit durchschnittlichem fülltext leben, weil es mehrere kontexte gab, die den fülltext im ‘bündel’ rezipierbar machten. einerseits gab es (imaginierte) communities wie antville oder twoday, andererseits gab es feedreader wie den google reader oder netvibes, die die abos der feeds zu einer personalisierten superzeitung rekontextualisierten. im aufgelösten zustand haben blogs aber das gleiche problem wie die zeitungen: die durschnittlichen posts, wenn wir ehrlich sind also fast alles was wir produzieren, sind im haufen aller posts aller völlig wertlos. im grunde gibt’s dann nur 2 strategien: man produziert selbst shareables (socialismus), oder man erzeugt sich seinen eigenen kontext im eigenen gesamtwerk und tut so als wär das jetzt so (solipsismus). wem das eine zu blöd und das andere zu anstrengend ist, der hört dann halt auf zu bloggen und wechselt vielleicht zu einer plattform wie tumblr oder medium, wo man ein bisschen kontext von der plattform spendiert bekommt und gleichzeitig in die eine oder andere richtung ‘gelenkt’ wird (erregung bei tumblr, sinn bei medium).