Die Zeitgenossen der Gesellschaft Pt. 47: Der Chatbot

Der Chatbot (🤖) ist ein in letzter Zeit überall und immer gesehener Zeitgenosse, der sich durch sein freundliches, kollaboratives, wunderbar improvisierendes Wesen auszeichnet, der auf Kritik immer angenehm und konstruktiv reagiert und sich bei Fragen und Szenarien als erstaunlich resourceful erweist und von dem sich so mancher diesbezüglich durchaus was abschauen könnte.

In seiner modernen Form gibt es ihn ja noch nicht so lange, insofern will ich noch kein abschließendes Urteil fällen, aber ein paar verstreute Anmerkungen möchte ich machen:

ich glaube es ist wichtig zu verstehen, dass er mit denken, sprechen, intelligenz oder bewußtsein falsch beschrieben wird. es schaut für uns natürlich so aus, weil er vergleichbare effekte triggert und mit uns via sprache interagiert, über dinge, die bei uns sowas wie intelligenz oder denken erfordern, aber als metaphern zur beschreibung seines wesens führen sie uns auf ein gleis in eine falsche richtung, was schade ist, weil es uns nicht nur einige nützliche dinge verbaut, sondern auch das angemessene erstaunen über die echte erstaunlichkeit erschwert.

ich habe noch kein gutes mentales modell für mich gefunden, aber wahrscheinlich nicht ganz falsch ist die vorstellung als multdimensionaler, mannigfaltiger vektorraum, in dem entlang ‘unendlich’ vieler serien von textsequenzen ähnlichkeitscluster eingeschrieben sind bzw. emergieren, und der in der folge antwortsequenzen generieren kann, denen nicht nur der ‘ozean’ der hineingefütterten vorgeschichte zur verfügung steht, sondern die sich in der kontinuation des ‘dialogs’ dann zunehmend präzisieren und personalisieren können und zu einem gewissen grad auch eine art geschichte etablieren.

ein aspekt, der sich damit gut erklärt, ist dieses doch erstaunliche talent des zeitgenossen, die ebene von begriffen bei bedarf zu wechseln und zunehmend ‘besser’ anzupassen. menschen tun sich mit der reflexion der sprach- und denkbedingungen ja schwerer als sie sollten, es ist ja alles eh nur noch ein gigantisches missverständnis und nur die einfältigsten bleiben effektiv, aber chatgpt hat fast nie ein problem damit, mit dem begriff nach einspruch oder widerspruch einfach ins nächste cluster zu wechseln und die dort gemachten verdichtungen aufzugreifen und zu benutzen. er ist der paradigmatische improv, alles ist ‘ja, und’. er verwendet bis zu einem gewissen grad ‘continuations’, bündelt also den kontext eines chats und aller intern gemachten ‘zwischenprompts’ als markierungen, die ein gewisses plateau etablieren und das funktioniert einfach irre gut. genau das vermittelt uns den eindruch, dass er versteht, im umgang mit menschen sind wir das nicht gewohnt. auch sein induzieren und deduzieren ist (zumindest noch ein weilchen) innerhalb eines rein mathematischen modells das effekte generiert beschreibbar, bei dem die chats wenn man so will temporäre monaden sind, innerhalb derer er alle möglichen verläufe einige cpu-zyklen oder bis irgendein lokales optimum erreicht ist lang intern simuliert o.ä.

auch die doch überraschende ‘kreativität’ seiner chats, gedichte, listen und erzählungen bekommt damit nicht nur eine plausible erklärung (er kann problemlos entlang der verschiedensten lateralen und kollateralen verbindungen wechseln, er kann dann auch dort sofort die schlüssigen kombinationen erkennen), es gibt uns dadurch auch einen neuen blick auf das wesen unserer kreativität selbst (die dann irgendwie natürlich auch nix anderes ist, aber dann halt trotzdem ganz was anderes usw.).

uff, es wird schon etwas lang, aber zwei punkte noch:

- das offensichtliche ist fortan immer und für alle verfügbar. das klingt nicht besonders toll, aber das könnte vieles ändern und einige bereiche up-leveln. für jeden menschen war bisher ja nur das offensichtlich, was für ihn schon offensichtlich ist, aber das ist immer nur ein tropfen im pool der gesamten offensichtlichkeit und der rest blieb unoffensichtlich und verborgen. fortan braucht man nur einen chat beginnen und an der oberfläche schwimmt schon die offensichtlichkeit. (man braucht ihm da nix glauben, wir wissen, dass er auch viel erfindet, aber als erste anregung ist man oft schon viel weiter)

- das gesamte mediale milieu wird komplett durchgemischt und sich ein einem neuen stratum neu ablagern müssen. das ganze feld ist schon seit jahren ein punchingball verschiedener kräfte und krisen, metaverses und cryptos, ein überdruss breitet sich an allen ecken und enden aus, aber gemeinsem mit dem twitter-murks holt der chatbot zu einem one-two punch aus, der eine genuin neue sinnstiftung erfordert. content ist in der bisherigen form jedenfalls tot, gleichzeitig wird er bleiben, nur eine neue funktion erfüllen müssen.

Leftovers 2022 (Agency Edition)

auch nicht weitergekommen sind wir 2022 jedenfalls dabei, neben einer (immer berechtigten) kritik an den umständen und plattformen, gleichzeitig einen (oft durchaus möglichen) gegenentwurf im inneren der umstände und plattformen zu formulieren.

ein bisschen spitzer formuliert: mir ist keine einzige netzpolitische kritik oder open/indie/dezentral/crypto-reinterpretation bekannt, die zumindest auch die aktuell gegebenen möglichkeiten einer individuellen agency innerhalb eines hegemonial strukturierten feldes zumindest erwähnt.

(dass keine einzige (im sinne von im promillebereich nicht messbar) massenmediale publikation in zehntausenden artikeln zur privatsphärengefahr und surveillance-kapitalistischen datensammelwut von apps die möglichkeit beschreibt, dass man cookies halt schon auch selbst löschen kann, oder dass es einen private-mode gibt, bei dem alle cookies von selbst gelöscht werden, oder dass man mehrere browser für mehrere dinge verwenden kann etctrara, das kann ich sogar verstehen, die wollen natürlich die leserschaft monetarisieren und nicht emanzipieren usw., aber tbh, auch im gesamten netzpolitischen diskurs (und den organen wie netzpolitik, techdirt, oder dem oeuvre von cory doctorow) sucht man eigentlich lange. ich bin mir nicht sicher ob es eine unverschämte unterstellung ist, hier eine variation vom shirky prinzip zu vermuten (critics will try to preserve the problem to which they provide the criticism), aber es gibt zumindest zwei grobe probleme:

- zum einen bleiben sie selbst im gleichen narrativ und dem gleichen plateau, das sie eigentlich bekämpfen u/o verändern u/o transzendieren wollen. via mspro lief mir gestern dieser eigentlich sehr supere thread von cory doctorow durch die TL (gibts auch im rebundle). aber während er die beteiligten ökonomien luzide beschreibt, so liest sich das ganze genauso gut als handbuch, das sich dann auf jeder ableitungsebene wiederholen lässt oder aber auf den offenen/dezentralen/föderalen alternative wiederholt wird, mit dem user immer als unterworfenem unter dem strom. in meinem slice der webkritik vermisse ich seit mindestens 10 jahren den bruch im narrativ, der einen hauch utopie zumindest erahnen lässt und nicht das gleiche dann halt im gegenteil wiederholt, think kroker (mit dystopischem pretext) in den 90ern oder bubblegen (mit hyperaffirmativem) in den nullern.

- zum anderen übersehen sie jede form von agency im bestehenden milieu. das nur kurz konstatiert, weil das thema viele mausefallen hat, die man immer zuerst entschärfen/kontextualisieren müsste, aber nur als beispiel neben den oben erwähnten cookies hat zb cory ein paar doch naheliegende aspekte nicht erwähnt: (a) man kann auch innerhalb einer struktur mit den mitteln der struktur gegen die machtverhältnisse arbeiten (subkulturen haben das mehr oder weniger immer schon getan resp. mussten das tun, oft entstand aber gerade dudurch ihre kraft; das sentiment unserer zeit ist aber natürlich, dass die dinge ihre explizite form suchen). (b) twitter zb ist auch as is mehr oder weniger vollständig selbstkontrolliert. wenn man ein bisschen programmieren kann, kann man mit der API eig. machen, was man will (ich hab mich mit twitter recht viel herumgespielt, die gute nachricht, viel bringts eh nicht). aber das kann halt nicht jede, aber es wird halt auch nie erwähnt oder erklärt. (ç) niemand darf nur eine einzige plattform verwenden (und ist der dominanten also ausgeliefert, wenn man mit anderen kommunizieren will), niemand muss sich zwischen der hegemonialen und der dezentralen entscheiden und alles andere aufgeben, man kann sich sein eigenes bündel zusammenstellen wie man will, man kann auch zwischen den plattformen flottieren.

(zum glück ist das eh alles egal usw.)

Das Einhorn

blogpost zum tweet

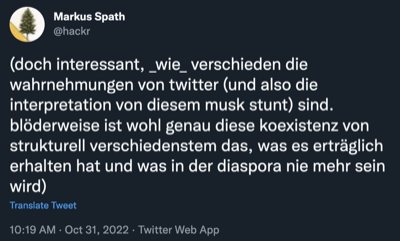

vor allem auch weil die twitterwelt eben alles ist, was der twitterfall ist, will ich die positionen und wahrnehmungen nicht im einzelnen betonen, sondern nur ein paar allgemeine anmerkungen über twitter machen, die ich im kollektiven unsere-zukunft-nach-musk gemurmel kaum berücksichtigt finde. schnell vorab:

twitter ist ein einhorn, das im zoo unserer webdienste/plattformen einen singulären charakter hat. viele gängige techniken aus den playbooks (von startups und usern) für social media greifen bei twitter nicht und sind öfter als nicht eher kontraproduktiv.1

5 elemente dieser singularität:

- das soziale objekt von twitter ist ein gedanke / ein moment

(gedanken resp. momente sind mannigfaltig, deshalb ist es auch twitter, weil es die matrix aus input und möglichkeiten der benutzung ist. für mich ist es völlig unerklärlich, dass mehr oder weniger überhaupt keine interpretation der ereignisse nach musk das soziale objekt der jeweiligen plattform auch nur im ansatz berücksichtigt. alle tun so, als wäre überhaupt jedes soziale netzwerk austauschbar gleich, social graph baby!, als könnte und sollte man jetzt halt genausogut auf tiktok (das ist ja eh die zukunft, dort sind doch die jungen) oder ins fediverse oder in die blockchain oder sonstwohin gehen, dabei geht es überall um was völlig anderes (in meiner TL war wusi die einzige, die das zumindest registriert hat “Notfalls lip sync und Tänze”.)2

- der twitter handle ist die de-facto universelle adresse für öffentliche ansprechbarkeit im netz

es gibt natürlich noch andere ‘adressen’ die eins hat oder haben könnte (email, telefonnummer, url vom blog, andere profile, etc.) aber nur der twitter handle wird universell verstanden, ist öffentlich und unaufdringlich. (im profil nur die ersten 5 oder so tweets zu zeigen und dann mit dem signup popup zu kommen ist deshalb eine der allergrößten idiotien im web)

- tweets sind in ihrer unveränderbarkeit die einzigen stabilen, in raum und zeit gefroren referenzpunkte im web

man kann sie löschen aber ansonsten ist das der eine gemeinsame öffentliche raum, in dem aussagen fest stehen (und in der folge rekonstruierbare referenzen für historische ereignisse, geschichtliche entwicklungen usw) sind. (der edit button ist deshalb eine der allerallergrößten idiotien und unforced errors im web)

- twitter ist egalitär / für alle gleich

mit warhol könnte man sagen ‘you can know that the president tweets, Liz Taylor tweets, and just think, you can tweet, too. Twitter is Twitter and no amount of money can get you a better Twitter than the one the bum on the corner is enjoying. all the tweets are the same and all the tweets are good.’

das trifft zwar teilweise auch auf andere plattformen, apps und gerätschaften zu, aber bei twitter koinzidiert das auch mit dem ‘datentyp’ tweet selbst, der die einfachste universell sinnvolle einheit im web ist, wenn man so will. jeder hat die exakt gleiche möglichkeit zu tweeten (schon bei flickr und youtube ist es ein bisschen anders, da spielt bald die kamera und andere produktionsmittel eine rolle; auf instagram die eigene optik und der zugang zu setups; auf tiktok das alter und verfügbare zeit; auf blogs der grad der beharrlichkeit u/o sturheit usw.) bei twitter braucht man nur zwei finger und ein beliebiges internetfähiges gerät, für den tweet macht das keinen unterschied. (deshalb ist dieser twitter blue button zumindest eine große dummheit, weil einige tiere gleicher als andere werden usw.)

- twitter ist ein dorf

man sitzt mit allen anderen zusammen. neben dem präsidenten und liz taylor und dem bum auch das common squirrel und das possumeveryhour und vielen andere personen oder bots, die einen vl. wirklich interessieren. das verhältnis ist aber symbiotisch, der raum spannt sich in und durch twitter erst und nur in der benutzung auf.

das alles ist eher grundsätzlich und bedeutet jetzt für den einzelnen tweep zunächst einmal nichts, das etabliert nur einen spezifischen raum für kontingenzen, der in dieser art aber eben einzigartig und nicht resimulierbar ist und der nicht mal eben ausgerupft und an anderer stelle wieder eingepflanzt werden kann. deshalb empfiehlt es sich eine frage im hinterkopf zu behalten:

- was ist der eigentliche job to be done einer jeweiligen verwendung von twitter? (job tbd frei nach asymco der es frei nach christensen konzipiert, siehe)

die antwort für einen selbst wird man nicht finden, der mensch ist nicht dafür gestrickt sich selbst zu verstehen, aber mit den milchshakes von christensen können wir erahnen, dass es was anderes ist, als wir von allen seiten hören oder aber auch selbst glauben. man landet dabei auch schnell in einer art inception, wo hinter jeder ebene eines jobs eine andere ebene eines eigentlicheren jobs steckt, usw., aber das macht alles nix. alle ebenen wirken zwar gleichzeitig, aber man operiert immer nur unter temporärer selektion einer spezifischen ebene.

was nun vermutet werden darf: jobs tbd sind besser oder schlechter für twitter geeignet. manche wurden durch twitter tatsächlich erst möglich/auf scale praktikabel. der großteil der kognitiven dissonanzen, die wir im web in den letzten 10 jahren (nicht nur auf twitter) erleben, entsteht, wenn jobs tbd in (platt-)formen gepresst werden, die sich dafür einfach nicht eignen. (vor allem das nicht zünden vom indieweb und fediverse hat leider die eigene strukturelle inkompatibilität mit in ihrem wesen ehrenvollen ‘causes’ noch nie gesehen, weil sie ihren job tbd dahinter noch nie verstanden haben, aber das ist eine andere auslaufrille bei mir)

ohne microzumanagen oder die pluralität der jobs festlegen zu wollen, eine regel für twitter leitet sich daraus ab:

- twittere spezifisch!

auch wenn tweets in den allgemeinen raum aller tweets gepostet werden, reaktualisieren sie immer das subjekt auf basis dessen job tbd und adressieren dabei zunächst einmal immer nur die eigenen followers und spannen insofern im global space eine eigene, idiosynkratische fläche auf. man twittert immer nur in einem ganz konkreten, spezifischen verhältnis zum kollektiv, das sich aber permanent aktualisiert (und das immer auch mit einem potential zum kurzschluss verbunden ist. die paradigmatischen effekte sind wohl serendipität und viralität, aber in den kleineren formen steckt natürlich die hauptattraktivität von twitter, weil das eigene oevre immer über gesten, memes, second order trends, etc. im faktual mitschwingt. worin die spezifität besteht ist schon wieder mannigfaltig, aber der effekt davon ist, dass sich dadurch das soziale (im ursprünglichen sinn vom knacks, siehe) überhaupt erst etablieren kann).

(dem fediverse würde ich lustigerweise exakt die komplementäre regel mitgeben: toote allgemein! alles was den symbolisch-imaginären resp. sozialen überbau nicht braucht ist im fediverse eig. besser aufgehoben)

in diesem sinne: macht was ihr wollt, es gibt gute gründe für alles, aber lasst euch nicht den spaß von einer dumpfbacke verderben.

—-

1 es ist ein einhorn trotz und nicht wegen der corporate entity twitter. beobachten kann man das im grunde seit dem start und den damaligen megalomanischen phantasien, die sich von generation zu generation vererben. sinnloses wachstum, viralität, feature creep und vor allem diese diese fixe idee mit dem innovieren z.b. sind nur bei plattformen, die nicht auf sinn basieren, ein veritables mittel um ein momentum zu generieren, bei twitter wäre von anfang an die freiwillige selbstbeschränkung auf eigensinn selbst die wertvollste kraft gewesen, aber ich verzettle mich. die zeit in den nullern war jedenfalls lustig, als sich das feuilleton noch gefragt hat, für was das gut sein soll, als es noch keine ausgestampften pfade für die möglichkeiten (auf einfluss, reichweite, audience usw.) gab, als noch alles möglich schien.

2 die ursprünglichen 140 zeichen, in die im grunde nicht mehr als ein gedanke passte, wurden in der folge natürlich ausgeweitet, es gibt dann auch links, threads, photos und videos, reaction gifs, vorschauende twittercards usw., der paradigmatische datentyp von twitter bleibt aber der ein einem mentalen zyklus erfassbare moment.

aus dem gedanken wächst dann alles mögliche im anschluss, aber was beobachtbar gut funktionert ist das treiben im schwarm, das vorbeischwimmen an witzen, anmerkungen, erfassen einer gleichzeitigkeit bei live events, eindrücken, gefühlen, selbstvergewisserungen und virtue signaling für einen tribe, vor allem natürlich serien und cute overload usw.

politische diskussionen, wissenschaftliche abhandlungen, aufklärung und überzeugung von unbekannten, etc. sind nicht unmöglich, erfordern aber auf twitter second order strukturen innerhalb derer sie funktionieren.

gedanke jedenfalls ist ein sehr offener datentyp, der eben die unterschiedlichsten dinge ermöglicht, siehe wieder den ausgangstweet, man braucht sich also nicht wundern, aber man sollte halt auch wirklich mit den festlegungen aufpassen, zumal jede festlegung alle anderen möglichkeit behindern könnte.

Nützliche Unterscheidungen pt. 38 (The Reasonable Edition)

Eine weitere im Grunde offensichtliche, aber derzeit in vielen das Web u/o Technologie u/o Politik/Sozialität im Zeitalter der mobilen Vernetztheit betrefenden Debatten öfter als nicht übersehene Unterscheidung ist die zwischen Voraussetzung und Ursache.

Aus Vogelperspektive betrachtet: die Welt muss da sein, damit in ihr irgendwas geschehen kann; trotzdem ist die Welt dann nicht Ursache für alles, was in ihr geschieht. Die Sprache muss da sein, damit mit ihr irgendwas gesprochen werden kann; trotzdem ist die Sprache nicht Ursache für alles, was mit ihr gesprochen wird. Usw.

Man kann das dann beliebig granular herunterbrechen, derzeit gerade aber gerne verwechselt: die Existenz von Facebook ist eine Voraussetzung dafür, dass darauf Nachrichten, Meme und Seme kursieren und sich auch in kreisenden Bewegungen steigern können, aber Facebook ist nicht die Ursache dafür, dass sich in bestimmten Clustern besonders die allerblödesten postfaktischen Erregungen hochschaukeln.

(natürlich gibt es immer wieder auch einen mehr oder weniger starken zusammenhang zwischen dem ermöglichenden und dem verursachsenden – im fall socmed hat das soziale und das infoökonomische design der jeweiligen plattform mitunter auch signifikanten einfluss darauf, was wie mit welcher verstärkungslogik strömt etc. – trotzdem laufen alle interventionen, die diese unterscheidung nicht treffen, etwa die ganzen ‘facebook ist schuld an trump wegen den fakenews in den filterbubbles’ erklärungen, was sich ja als primäres narrativ der selbstberuhigung der medien über sich selbst etabliert hat, in die leere, weil sie am symptom doktoren wollen und nicht am grund, der in dem fall das eigene sichnichtfestlegenwollendebessermaldämlichstellen ist)

(abt: draw the distinction!)

Was man von Big Brother über Trump lernen kann

in den USA hat in den letzten wochen ja nicht nur die wahl zum präsidenten stattgefunden, es läuft gerade auch die erste reine online-ausgabe von big brother. und wenn man sich die anschaut, kann man das wie und warum und nochmal das wie vom sieg von trump vl. schlüssiger verstehen, als mit den meisten medienkritischen und politikphilosophischen oder sozialwissenschaftlichen erklärungsversuchen, die wir in den kommenden tagen und monaten sehen werden.

ich gehe ausnahmsweise mal davon aus, dass nicht jeder hier mitlesende auch us big brother schaut, deshalb ein paar worte zum format:

es zieht eine gruppe von leuten in ein haus, lebt dort von der welt abgeschieden, wird aber rund um die uhr gefilmt und im fernsehen/im internet übertragen; jede woche wird eine person hinausgewählt, der letzte verbliebene gewinnt 250k; das spiel besteht einerseits aus wettbewerben, die bestimmte rechte verleihen (andere zur elimination nominieren, schutz vor nominierung, usw.), hat andererseits aber auch eine starke soziale komponente (allianzen bilden, kochen, nett oder unterhaltsam sein, dumm oder unfähig und also keine gefahr sein, usw.).

neu in der aktuellen online version ist, dass es keine komprimierte und editierte show im fernsehen gibt, die immer auch die interessen oder narrativen wünsche der produzenten reflektiert, sondern dass alles im webstream live gezeigt wird, auch das normalerweise versteckte. und noch wichtiger: dass die zuschauer durch abstimmungen in das geschehen eingreifen können (einen spieler nominieren, eine stimme zur hinauswahl, diverse andere sicherheiten oder vergünstigungen).

zum verständnis der wahl interessant war nun die dynamik und die feedbackloops der internen und externen gruppenbildungen, die sich nicht nur gegenseitig etabliert und beobachtet, sondern auch eine weise aufgeschaukelt, isoliert und verfestigt hat, die ohne diese wechselseitige interpenetration UND spezifische konstellation nicht möglich gewesen wäre:

der katalysator war eine (leider etwas unglückliche) primäre selbstselektive trennung im haus, bei der es einerseits die normalos (weiß, collegeabschluss, heterosexuell, fit und idealerweise aus dem süden) und andererseits die underdogs (schwarz, dropouts, schwul, dick) gab. und in dieser konstellation sympathisiert natürlich jeder zuschauer für die underdogs, was dazu führte, dass ‘amerika’ in den ersten zwei wochen die unsympathischsten WASPs rausgewählt hat, obwohl sie intern durch die wettbewerbe eigentlich die ‘macht’ im haus gehabt hätten.

der effekt davon war, dass die ‘misfits’ das als zeichen einer uneingeschränkten sympathie von ‘amerika’ verstanden haben, was sie in der folge auf eine weise selbstgerecht gemacht hat, in der plötzlich sie diejenigen wurden, die aus einer position der macht (amerika liebt uns und hasst die anderen) heraus begonnen haben, unnette und ungustiöse dinge zu tun (die polster der anderen unter ihrer achsel reiben oder darauf furzen, trashtalk der auch in den expliziteren roasts funktionieren würde, usw.) – während die verbliebenen ‘plastics’ plötzlich die sympathischen underdogs wurden, weil es einfach vier mädel waren, die überraschend gut miteinander ausgekommen sind (üblicherweise zerlegen sich die frauen in big brother als allererstes selbst).

(übrigens ein anfängerfehler, weil in dem format mittlerweile bekannt sein sollte, dass sympathie immer an die position gebunden ist und auch ehemalige fan favorites in nur einer woche zum verachteten individuum werden können, wenn sie ein zweites mal eingeladen werden und sich dann als checker geben)

der andere effekt war eine fanbildung außen, die die interne dynamik inklusive der falschen selbsteinschätzung und selbstgerechtigkeit und wachsenden kognitiven dissonanzen mehr oder weniger gespiegelt und übernommen hat.

üblicherweise ist es in der populärkultur ja so, dass die ‘misfits’ die sympathischen geheimen helden sind, denen man gerne die daumen drückt und die am ende idealerweise auch gewinnen, während die privilegierten ‘plastics’ abgestraft werden, sich ihr prinz als frosch herausstellt und sie wenn sie glück haben nach einer läuterung eine versöhnung erfahren.

hier war es aber so, dass die ‘misfits’ nach allen pragmatischen kriterien des zusammenlebens bald die eigentlichen ungustl waren, was von den ursprünglichen fans aber nicht zur kenntnis genommen wurde, was allerdings nur funktionieren konnte, indem der bezug zur realität kollektiv aufgegeben wurde und man sich auf eine art emergenten hive mind bezogen hat, in dem alles eitel freud und sonnenschein war.

das notwendige konstitutive element dafür war glaub ich, dass sich eine gruppe falscherweise selbst als ‘fucked over’ wahrgenommen hat. im haus hat sich diese auslegung in der dritten woche gebildet, nachdem die stimme von ‘amerika’ das erste mal nicht mehr zu gunsten der misfits ausgefallen ist, als sie selbst das erste mal an der macht waren. ihre einzige erklärung dafür war, dass der prozess selbst ‘rigged’ sein muss. amerika liebt sie, das haben die ersten wochen gezeigt, und die anderen sind furchtbare menschen, das ist selbstevident, es kann also nicht anders sein als dass irgendwas nicht stimmt.

und diese selbstwahrnehmung als ‘fucked over’ hat sich auch nach aussen übertragen. auch die fans der misfits haben einfach als axiom angenommen, dass niemand für die plastics stimmen könnte und dass jedes voting für diese also ‘rigged’ sein muss. entweder weil die fans der anderen rassisten oder homophob sind, oder weil sie das wahlsystem gamen, oder weil die produktionsfirma korrupt ist und das ergebnis fälscht.

nachdem diese falsche selbstwahrnehmung aber einmal etabliert war, kam es zu einer art operativen schliessung und entwicklung von techniken, die wir dann auch bei trump zu spüren bekamen:

- die entwicklung von filter- und gruppierungsprozessen, bei denen man zunehmend nur noch das zu sehen bekommt, was man sehen will und was die eigene meinung bestärkt (blocked bye). ich bin kein fan des konzepts der filterbubble, weil es auf individueller ebene einfach kein problem ist, weil jeder seinen inputstrom so variabel halten kann wie er will; aber sozial verschaltet wird tatsächlich eine eigene dynamik getriggert, wenn leute beginnen den realitätsbezug sozial aufzugeben. wobei dabei ganz interessant ist, dass es weniger ein problem der sichtbarkeit von aussagen oder fakten ist – die gruppen besuchen sich auch gegenseitig um zu trollen usw. – sondern dass es eher darum geht, die eigene bewertung davon zu bestätigen.

- die ausbildung einer paranoiden wahrnehmung, bei der schon die kleinsten dinge als beweis für eine verschwörung herhalten können. der ursprung der paranoia entsteht dadurch, dass das wahrgenommene gefühl des eigenen stroms nicht in der wahl amerikas reflektiert wird (die ursache dafür war bei big brother aber ganz lapidar, dass sich auf verschiedenen plattformen verschiedene fangruppen gefunden haben – auf twitter sind die fans der misfits, auf reddit die fans der plastics. im eigenen strom schwimmt man in einer bequemen mehrheit, den vl. grösseren schwarm zwei ecken weiter sieht man nicht). einmal etabliert beweist aber potentiell alles die verschwörung.

- damit verbunden das verlieren von jedem maßstab resp. das verzerren von aussagen. stundenlange schimpftiraden sind gleichwertig wie ein ‘jeez, das sind solche idioten’, schon eine handvoll an fehlern reicht aus, um sie im argumentativen tresor zu verwahren und bei bedarf immer wieder herauszuholen.

- eine verpflichtung für alles sein zu müssen, was den eigenen kandidaten begünstigt oder den anderen kandidaten benachteiligt, und gegen alles sein zu müssen, was den eigenen kandidaten benachteiligt oder den anderen kandidaten begünstigt (ansonsten schnell: hast du heute deine medikamente vergessen? achtung, dein account wurde gehackt)

- ganz interessant dabei ist, dass neben der genuinen dummheit auf semantischer ebene, das kollektiv durchaus eine systemische schlauheit entwickeln und zu erstaunlich effektiven verfahren kommen kann (nur als beispiel: bei den votings ist es wichtig, die stimmen auf ein gemeinsames ziel zu konzentrieren, weil man sonst auch bei gegebener mehrheit gegen eine einheitliche minderheit verlieren kann; und während sich auf der ebene der interpretation von votings eher die bizarren thesen der grössten beliebtheit erfreuten, so hat es nur eine weitere woche gebraucht, bis mechanismen zur selbstorganisation etabliert waren)

- neben der entwicklung von schlauen spielzügen eine parallele entwicklung von mehr oder weniger legalen tricks, das spiel selbst zu unterlaufen (um beim beispiel votings zu bleiben: neben den methoden zur selbstorganisation wurden gleichzeitig techniken entwickelt, die die selbstorganisation der anderen seite verhindern oder unterlaufen sollten – manipulation der polls, versuch der infiltration der anderen mit fake-accounts, usw.). viele aktivitäten griffen dann auch schnell unter die gürtellinie, verspottende meme sind noch eher die angenehmeren symptome. das problem der legitimität stellt sich deshalb nicht, weil man eben selbst die unterdrückte gruppe ist und in reiner notwehr handelt.

- das spiel ist selbst asymmetrisch; where they go low we go high oder ein bezug auf rationalität sind keine strategien, mit denen man gewinnen kann. blöderweise hätte man mit einem where they go low we go lower noch mehr verloren.

das nur auf die schnelle, aber ich glaube die ähnlichkeiten mit dem wahlkampf von trump sind leicht zu erkennen (der grösste unterschied ist natürlich, dass sich im falle trump ausgerechnet die weiße mehrheit als unterdrückt empfunden hat, von den bürokraten in washington, von den liberalen medien, von den bankern an der wall street, von der sprachkontrolle der politisch korrekten, vom system clinton, von allen anderen, die ihnen die waffen wegnehmen wollen, usw.).

(der kapitale fehler war glaub ich nicht, dass wir uns auf falsche politische gewissheiten verlassen haben und die medien deshalb ihrem auftrag als überzeuger der mehrheit vom anständigen nicht nachgekommen sind, wie es sascha lobo in seiner analyse vermutet. wobei es eine fatale falsche gewissheit gab, nämlich die annahme, dass trump niemals wirklich gewählt werden würde, die vorstellung war einfach absurd; das hat niemand so gesagt, als horrorszenario wurde die möglichkeit natürlich betont, aber ich glaube es haben die wenigsten wirklich gedacht. reine spekulation, aber ich kann mir gut vorstellen, dass der gesamte wahlkampf anders abgelaufen wäre, wenn trump als realistische option empfunden worden wäre. retrospektiv kommt mir eher vor, dass der wahlkampf von clinton und allen liberalen medien primär auf verwaltung eines 5% vorsprungs ausgelegt war, wahrscheinlich um sich nicht unnötig auf versprechungen oder konkrete positionen festlegen zu müssen, die sich dann in der amtszeit vl. rächen könnten. kleines indiz dafür war, dass sie nicht einmal eine alternative rede vorbereitet hatte.)

wobei die frage bleibt, was man tun hätte können oder was man in zukunft tun kann. wobei man aber zumindest sehen kann, was in dieser konstellation nicht funktioniert – nämlich das aufklären und informieren, das verstehen und gute zureden, auch nicht das emotionalisieren. am ehesten bleibt wohl eine gute politik, die die rechte von allen menschen angemessen festschreibt.

FYI 073

fyi: der google assistant ist der neue mr. clippy (abt. hate to brake it to you but…)

The Strain

kl. nachtrag zu curate or die: die nyt hat vor kurzem ja von ihren kollegen viel bewunderndes kopfnicken geerntet, weil sie intern mal eine woche den zugang zur eigenen desktop-version gesperrt hat, damit alle ihre mobilen gerätschaften verwenden müssen und dadurch quasi gezwungen werden, sich in die mehrzahl der leser zu versetzen und die kommende ‘bedeutung’ von mobile zu verstehen.

ich glaube als experiment machen sie da etwas sehr richtiges, aber ich bin mir ziemlich sicher, dass sie daraus die falschen schlüsse ziehen werden, weil sie bei ihren bestehenden grundsätzlichen annahmen bleiben werden. und die axiomatische annahme aller verlage ist, dass es einerseits eine grundstätzlich gegebene nachfrage nach journalistischen inhalten gibt und dass sie andererseits die gottgegebenen produzenten ebendieser journalistischen produkte sind.

diese im papierzeitalter quasi seine perfekte realisation gefunden habende natürliche ordnung erlebt aus diesem blickwinkel zuerst mit dem internet/web und dann mit mobile zwar eine krise der verkauf- und verwertbarkeit, aber die struktur der ordnung selbst wird nicht in frage gestellt. wer kein zeitungspapier mehr liest, der hat vor 10 jahren die zeitung als startseite im browser gehabt, mehr web braucht man nicht; und wer kein zeitungsportal mehr liest, der verwendet google um zeitungsartikel zu finden oder facebook, um sich von den freunden zeitungsartikel empfehlen zu lassen und darüber zu diskutieren; und wer nur noch ein handy hat, der verwendet es um sich in der strassenbahn oder im park mit zeitungsartikeln über die geschehnisse zu informieren.

das medium, wie die leserschaft das eigene angebot konsumiert, wandelt sich und die aktuellen trends (omg, mehr und mehr mobile) erkennt man im analyse-tool der wahl, aber die struktur und die aufgabe resp. position der beteiligten parteien bleibt konstant.

für die zeitungsmacher ist zu jedem zeitpunkt ganz klar, dass sie der fixpunkt sind, um den die welt sich dreht. und der typische deutsche verleger geht zusätzlich auch noch davon aus, dass ihnen google, facebook und twitter einfach alles zu verdanken haben, dass leute nur auf google gehen, um die verlagsinhalte zu finden, dass leute nur auf facebook und twitter gehen, um dort verlagsinhalte zu teilen, usw. (aus dieser sicht sind so dinge wie das leistungsschutzrecht oder die forderung nach 11% vom umsatz von google zumindest nicht mehr wirr oder wahnhaft, sondern einfach kontrafaktisch grundbegründet.)

die neuen umstände werden also immer nur als fragen der form und der distribution und der monetarisierbarkeit behandelt, was nicht gestellt wird, ist die frage nach dem eigenen sinn und den neuen umständen selbst. aber der eigene sinn ist vielleicht fragiler, als nicht nur von ihnen angenommen wird.

was wie eine evolution von ‘trends’ im konsum von nachrichten ausschaut – leute lesen sie zuerst auf papier, dann auf dem portal, dann auf facebook, dann auf dem handy – müsste nämlich eher als ganz grundsätzlich neuentwicklung des gesamten ‘dispositivs’ unter grundsätzlich neuen bedingungen bewertet werden, für das alles andere als klar ist, was dort funktionieren kann und wie das funktionieren wird. die welt versucht gwm. gerade herauszufinden, wie sie ausschauen würde, wenn es das web und mobile immer schon gegeben hätte.

man kann aber fast davon ausgehen, dass der ‘journalismus’ wir wir ihn kennen retrospektiv betrachtet eher wie ein historischer zufall ausschauen wird, als wie eine gegebenheit, die nur ein zeitgemäßes gefäß suchen muss. man braucht ja nur die perspektive auf die entwicklung zu wechseln: leute haben zeitungen nur solange gelesen, solange es nichts gab, was leichter und gleichzeit gut genug war (online portale); und leute haben die zeitungsportale nur solange als startseite benutzt, solange es nichts gab, was leichter und gleichzeitig gut genug war (facebook); und auf facebook nehmen die leute die nachrichten bestenfalls noch hin, ein bisschen informiert werden und synchronisation mit der welt ist ja nicht schlecht, aber sie sind doch nicht der grund, um auf facebook zu gehen, die leute interessieren sich für sich selbst und ihre bekannten und verwandten; anders gesagt: zeitungen konnte es nur deshalb geben, weil es damals noch kein facebook gab.

und die radikalste transformation deutet sich natürlich gerade mit dem übergang zu mobile an, weil damit zwar auf der einen seite ein universeller und permanenter zugang für alle gegeben sein wird, gleichzeitig aber ganz grundsätzliche begrenzungen der komplexität des ‘rezipierten’ etabliert werden, die aber natürlich immer noch gut genug sein werden.

die leute waren gwm. jahrzehntelang zu ihrem journalistischen ‘glück’ gezwungen, aber sie haben jede möglichkeit zu was einfacherem auch immer sofort genutzt, sobald sie sich ergeben hat. der journalismus in der uns bekannten form ist also eine reine historische kontingenz, die zwar gesellschaftlich wünschenswert ist, aber niemanden wirklich interessiert.

selbst beim am weltgeschehen interessierten bildungsbürger ist die disposition grundsätzlich anders, wenn er eine mobile gerätschaft verwendet. auch wenn es theoretisch natürlich möglich ist, auf dem iphone täglich ein potpourri an kritischen, gesellschaftspolitischen, analytischen longreads zu lesen, die form und die disposition verstärkt natürlich alles snackbare und unmittelbar intensive, also die snapchats und whatsapps, die vines und instagrams, die tweets mit animierten katzengifs.

(nur am rande: gerade deshalb ist es so absurd, dass die verlage mit aller gewalt gegen google kämpfen aber apple und facebook in den arsch kriechen, weil google gwm. der einzige kanal ist, über den sie intentional offene, weil eben genau nach dem thema suchende besucher bekommen. alles was sich über sharing aufschaukelt oder ausdifferenziert ist zwar viel ‘erfolgreicher’, muss aber auch mit einem gähnenden wegwischen nach 2 sekunden rechnen)

aber um zur ausgangsthese zurückzukommen: die frage ist natürlich, was die richtigen schlüsse auf das experiment der nyt sein könnten. und das wird ein harter knochen, weil das baumaterial nur der sinn sein kann.

Durchschnittlichkeit und Zufriedenheit

‘mögen deine wünsche in erfüllung gehen’ ist ja einer dieser chinesischen flüche, die sich früher oder später besonders hinterlistig bewahrheiten – und am umstand, dass es durch das vom web bedingten unbundling und microchunking zu einer strukturellen krise der durchschnittlichkeit, besonders zu einer krise des durchschnittlichen textes kam, ist vielleicht einer der hinterlistigsten bewahrheitungen.

wir erinnern uns: neben dem hypertext, also der möglichkeit zur vernetzbarkeit von texten, was der grundsätzlichen kern vom web ist, war die damit verbundene entkoppelung der textfragmente von ihrem kontext, die das freie flottieren und beliebige rekombinieren und reaggregieren von texten, informationen, gedanken und also ein genuin neues dispositiv ermöglicht, die zentrale metapher und wunschvorstellung für die zukunft von text.

was auf semiotischer ebene jedoch wie ein paradies klingt, hat nicht mit den psychologischen resp. infoökonomischen nebeneffekten gerechnet.

ganz allgemein gesagt sind menschen relativ unkomplizierte und leicht zufriedenzustellende lebewesen, die mit durchschnittlichkeit gut leben können, solange das gesamtpaket stimmt. ein, zwei goodies reichen aus, um der gesamten restlichen durchschnittlichkeit zumindest den notwendigen hauch von wertigkeit zu verleihen.

(durchschnittliches als angenehm empfinden zu können ist übrigens alles andere als ungeschickt, weil es nicht nur naturgemäß viel mehr durchschnittliches als besonderes gibt und man sich also über viel mehr im leben freuen kann, sondern weil das durchschnittliche in den allermeisten fällen auch völlig ausreicht. dieser von der werbung erzeugte wahn immer nur das allerbeste zu wollen ist aber ein völlig anderes thema).

bündel und pakete sind jedenfalls notwendige formen, uns viele durchschnittliche einzeldinge als angenehm wahrnehmen zu lassen und uns zufrieden zu stellen. bricht man die bündel jedoch auf, liegen die dinge plötzlich isoliert vor uns und müssen also einzeln beurteilt, bewertet und empfunden werden. das hat natürlich gegenüber dem bündel einen riesigen vorteil – man kann sich die rosinen aus dem kuchen picken (wenn man rosinen mag, ansonsten kann man sich den kuchen aus den rosinen picken), es hat aber auch eine ganze reihe an nachteilen. die notwendigkeit plötzlich alles einzeln beurteilen, bewerten und empfinden zu müssen ist nicht nur aufwendig und belastend, die davor geniessbare durchschnittlichkeit verliert entbündelt sogar ganz grundsätzlich den zugang zu diesem naiven genuss und muss sich plötzlich die frage gefallen lassen, warum man nun gerade es und nicht etwas anderes lesen soll, usw.

die zwei paradigmatischen formate, die mit dem internet entbündelt und in die einzelnen bestandteile zerlegt wurden, sind natürlich zeitungen und LPs.

bei LPs sind die effekte jedem musikliebhaber bekannt: das snacken nur an den ‘besten’ songs eines albums ermöglicht zwar viel mehr streuung, discovery und durchschnittlich eine viel höhere einzelintensität der gehörten tracks, aber es geht auch der persönliche bezug verloren, den man etwa in den kleinen aha momenten entwickelt, wenn ein song, den man bis dato völlig ignoriert hat, plötzlich der lieblingssong eines albums wird usw. (natürlich funktioniert das nur bei alben, die wirklich als solche bestimmt sind und denen das auch gelungen ist, aber guten musikern gelingt das oft). das vermeiden der durchschnittlichkeit und die erhöhte intensität der einzelstücke macht gleichzeitig den hörer selbst unzufriedener, weil er fortan immer auf der suche nach etwas besserem sein muss. die sehnsucht nach dieser bindung an etwas vorgegebenes erkennt man ja am comeback von vinyl.

und bei zeitungen sind die effekte allen ausser den zeitungsmachern bekannt: ein davor wirklich großartiges papierbündel zerfällt zu einem losen haufen an artikeln, die fast alle durchschnittlich und nicht besser oder schlechter als die artikelhaufen aller anderen zeitungen sind und für den leser also eine einzige infoökonomische zumutung sind (für den übergang vom wertvollen bündel zum wertlosen haufen können die zeitungen nichts, ihre plötzliche wertlosigkeit war gwm. höhere gewalt; woran sie allerdings selbst schuld sind, ist, dass sie die situation und ihre position nicht verstehen, den kopf in den sand stecken und dort dann versuchen, ein liedchen zu pfeifen). die wirklich einmaligen artikel, die eine zeitung an einem tag erzeugt, die man also nicht gleichwertig überall sonst findet, dürften sich im einstelligen, bei wochenzeitungen vl. im zweistelligen bereich befinden und die muss man natürlich auch erstmal finden.

aber interessanter als die krise der texte der zeitungen ist der umstand, dass dieses verhältnis jede art an text betrifft und sich früher oder später also direkt in den text selbst einschreibt. es hat eine zeit lang gedauert, bis wir das bemerken können, weil sich natürlich auch die produktions- und rezeptionsbedingungen anpassen müssen, durch die verstärkung dank social media wird die logik jedoch langsam sichtbar:

damit durchschnittliche texte, die bisher ein perfekt feines dasein als füllstoff führen konnten, im haufen aller aufgelösten artikel aller einen funken wert behalten können, müssen sie jetzt auf irgendeine art auch isoliert und autonom funtionieren. und dafür gibts zwei primäre möglichkeiten: entweder sie stiften selbst ‘sinn’ für den leser, enthalten zumindest etwa eine nützliche information; oder sie erzeugen eine ‘erregung’, also das kompakte gefühl eines lols, oder wins, oder omgs, oder cutes, oder fails, oder wtfs.

und woran erkennt man, ob ein text ‘sinn’ oder ‘erregung’ erzeugt? genau, er wird geshared. wenn ein text im web von niemandem geshared wurde, wurde er dann überhaupt geschrieben? der verbliebene wert von durchschnittlichen texten im zustand der entbündeltheit zeigt sich also in der sharebarkeit.

das ding jetzt ist natürlich, dass sinn nicht nur viel schwerer zu produzieren ist, es erfordert auch viel mehr aufwand vom leser, ihn zu erkennen, und es ist auch viel riskanter ihn zu sharen. und dass erregungen andererseits nicht nur viel leichter erzeugt werden können als sinn, erregungen können auch viel schneller aufgeschnappt werden und erzeugen also auch viel eher anschlusskommunikation und selbstverstärkung in den sogenannten erregungswellen. ich habe oben die lols, wins, omgs, usw. als qualifizierer von erregungen nicht zufällig von buzzfeed zitiert – sie zeigen, wie präzise buzzfeed diese logik schon vor langem erkannt hat und deshalb nur noch genau diese art von texten produziert. buzzfeed ist eine maschine zur produktion und distribution der letzten durchschnittlichen texte, die noch verwertbar sind.

die zeitungen, zumindest die qualitätszeitungen, haben nun natürlich das problem, dass sie in ihrem selbstverständnis die produzenten vom sinn sind und die produzenten von erregungen gwm. verachten müssen und sie sich dadurch quasi auf diese eine position festlegen; gleichzeitig produzieren sie natürlich in realität deutlich mehr (unsharebaren und austauschbaren) fülltext als sonstwas, erzeugen also viel weniger leistung, als sie es in ihrer selbstwahrnehmung glauben; nur müssen sie auch ihren kollegen von buzzfeed dabei zuschauen, wie die ganz ungeniert eine wissenschaft der verpönten sharebaren erregungen entwickeln können und ihnen die PIs, die aufmerksamkeit und die werbegelder und fast den ganzen kuchen wegknabbern.

von dieser logik sind natürlich auch die blogs betroffen. auch die konnten in den ersten 10, 15 jahren gut mit durchschnittlichem fülltext leben, weil es mehrere kontexte gab, die den fülltext im ‘bündel’ rezipierbar machten. einerseits gab es (imaginierte) communities wie antville oder twoday, andererseits gab es feedreader wie den google reader oder netvibes, die die abos der feeds zu einer personalisierten superzeitung rekontextualisierten. im aufgelösten zustand haben blogs aber das gleiche problem wie die zeitungen: die durschnittlichen posts, wenn wir ehrlich sind also fast alles was wir produzieren, sind im haufen aller posts aller völlig wertlos. im grunde gibt’s dann nur 2 strategien: man produziert selbst shareables (socialismus), oder man erzeugt sich seinen eigenen kontext im eigenen gesamtwerk und tut so als wär das jetzt so (solipsismus). wem das eine zu blöd und das andere zu anstrengend ist, der hört dann halt auf zu bloggen und wechselt vielleicht zu einer plattform wie tumblr oder medium, wo man ein bisschen kontext von der plattform spendiert bekommt und gleichzeitig in die eine oder andere richtung ‘gelenkt’ wird (erregung bei tumblr, sinn bei medium).

(überhaupt ist es natürlich nicht so, dass der durchschnittliche text seine funktion für immer verloren hat. ich habe das nur nicht betont, weil ich sonst jeden punkt relativieren hätte müssen, und dann aber auch die relativerungen relativieren hätte müssen, weil sie auf tektonischer ebene trotzdem wieder egal wären, es hätte alles jedenfalls unnötig verkompliziert. aber die entbündelung hat nicht nur opfer, sondern erzeugt naturgemäß auch einen neuen möglichkeitsraum für tools, plattformen, communities (fast alle funktionierenden tun das letztendlich) etc. dafür, eigene, neue kontexte für text zu erzeugen, innerhalb derer dann auch die durchschnittlichen texte wieder einen platz bekommen können, ohne dass diese sich selbst beweisen müssen. wie fast immer kann man sich einfach anschauen, was funktionert.)

nur am rande beobachtet ist doch lustig, dass wir gerade mit der krise der durchschnittlichkeit den von den poststrukturalisten vor 50 jahren diagnostizierten verlust der autorschaft konkretisiert bekommen. nur, wie so oft, kommt es anders als damals gedacht: die neuen kleinformate transzendieren nicht nur den autor, sie schreiben sich wörtlich genommen tatsächlich selbst und brauchen die readaktionellen prozesse inklusive aller beteiligten menschen und software nur noch als organisatorische struktur. moderne redakteure tun ja im grunde nichts anderes als texten eine erste form zu geben und diese dann solange anzupassen, bis die roten lämpchen, die auf schlecht formulierte überschriften, hohe absprungraten nach dem ersten satz, falsche keywords, geringes sharementum, etc. hinweisen, nicht mehr rot blinken und der text also seine objektive form gefunden hat. paradoxerweise sind es deshalb ausgerechnet die roboterjournalisten, die den ethischen anspruch auf autorschaft am reinsten repräsentieren.

598425890696073216 Revisited

wirklich unbehagen bereitet mir übrigens der gedanke, dass sie das web gutmeinend verschlimmbessern, um mit apps um marktanteile zu kämpfen.

— Markus Spath (@hackr) May 13, 2015kl. nachtrag zu 598425890696073216 – zumindest eine erste iteration, die sich lustigerweise aus der überschneidung mit einem anderen tweet ergibt, den ich am gleichen tag aber in einem völlig anderen kontext (verizon schluckt aol) getwittert hatte:

(ich war damals ja eher compuserve)

— Markus Spath (@hackr) May 13, 2015um die zwei tweets zusammenzubringen, sollte ich zwei dinge erwähnen:

(1) einer der größten, wenn nicht der größte im allgemeinen ausgemachte feinde des offenes webs sind projekte wie facebook zero oder internet.org, also konstrukte, die ein kontrolliertes subset an webseiten oder apps kostenlos offerieren, um der nächsten milliarde menschen zugang zum internet zu ermöglichen. was sich als akt der nächstenliebe gibt, ist jedoch, so die verteidiger des offenen webs unisono, nichts anderes als die ausbeutung ökonomischer benachteiligung, die nur neue user einfangen und an sich binden und damit das eigene wachstum anheizen will, also digitaler imperialismus (und wem das nicht reicht nachtürlich auch eine freche verletzung der netzneutralität, aber um das geht es hier nicht). und ihr plan geht auch noch auf, viele der so angelockten glauben dann sogar, facebook sei das internet. statt im offenen web zu publizieren, verkaufen sich diese armen seelen an facebook und landen im vorraum zur hölle.

(2) compuserve war anno dazumal, also plus/minus vor 20 jahren, neben aol die einfachste möglichkeit, mit einem macintosh zugang zum internet und email zu bekommen. es gab auch schon einige websites und der netscape navigator war gerade neu und hip, aber ein grosser teil des nutzens war zunächst das angebot, das compuserve bereitstellte. über die uni hatte ich dann bald auch ein bisschen webspace und zugang zum usenet und unter der ägide von hotwired und webmonkey dann irgendwann auch ein rudimentäres verständnis von html und framesets, aber die möglichkeiten von compuserve hat meine erfahrung mit dem internet in den ersten jahren weitgehend dominiert. und auch wenn ich dann quasi das web ‘mitbegleitet’ habe, bis zu meinem eigentlichen knacks im kopf dauerte es dann weitere 10 jahre.

der punkt dieser zweiten, zugegebenerweise schon etwas verstaubten geschichte ist, dass die erste geschichte nicht notwendigerweise den dystopischen verlauf nehmen muss, von dem alle ausgehen. wer in einem geschlossenen garten aufwächst, muss nicht notwendigerweise den rest seines lebens darin verbringen. menschen können lernen und zusammenhänge verstehen. manchmal fehlt nur eine einzige information. wer heute zb. glaubt, dass facebook das internet ist, dem muss nur einer einmal zeigen, dass das nicht der fall ist, sondern dass facebook im besten fall ein nützlicher und in jedem fall ein grosser wal in einem riesigen ozean namens web ist, das man mit etwas entdeckergeist dann selbst erforschen kann (ob das dann angenommen wird und denjenigen interessiert ist eine andere frage). und wir brauchen gar nicht so betroffen tun, noch vor 10 jahren haben hierzulande die meisten geglaubt, dass das internet dieses blaue ‘e’ am desktop ist.

ich will mit dieser anmerkung nicht die grundsätzliche korrektheit der kritik an facebook (und co) kritisieren und ich will die machenschaften von facebook (und co) weder relativieren noch legitimieren. was sie abziehen ist unterm strich eine riesige sauerei, vor allem deshalb, weil sie es auch ganz einfach auch anders andenken und umsetzen hätten können.

der fehler liegt nicht in der vorgetragenen kritik, sondern in der analyse und der bewertung, was das bedeutet. und eine hysterische bewertung (es ist ganz eindeutig das endgame, wenn wir jetzt verlieren, dann ist das offene web verloren, usw.) führt zu einer hysterischen überreaktion, die dann, wenn wir pech haben, mehr schaden anrichtet als der feind, wegen dem man überhaupt erst losgelegt hat.

(interessanterweise teilen die protagonisten eines offenen webs, hier fortan stellvertretend mozilla, und die ideologisch mehr oder weniger aus der gegenteiligen ecke kommenden verlage diesen schaum vor dem mund, wenn sie es mit google oder facebook oder apple zu tun bekommen; aber lassen wir hier die verlage einmal beiseite)

der allgemeine fehler von mozilla ist, vom offenen web kein ‘sinnverständnis’ zu haben, sondern den sinn in der vorhandenheit selbst zu sehen, was bedeutet, dass sie den erzeugten wert also nur am marktanteil messen können. alles, was von facebook (und co) aufgesaugt wird, ist ein verlust und die masse des von facebook aufgesaugten ist eine katastrophe. als reaktion bleibt ihnen also nur der ‘kampf’ um marktanteile und als grund für die beliebtheit von facebook (und co) ist ihnen leider nur eingefallen, dass der offene stack technisch unterlegen ist, was nur bedeuten kann, dass sämtliche apis der geschlossenen plattformen nachgebaut werden müssen, siehe den kleinen überblick ihrer aktuellen interventionen.

(man erkennt auch die wiederholung eines musters: als das soziale web der katalysator für das wachstum war, wurde im ‘social graph’ von facebook der zaubertrank gesehen, und die damalige erwartung war, dass man den nur offen nachbrauen muss, dann wird alles gut. wir erinnern uns an projekte wie open social, friend connect, portable contacts, chi.mp, diaspora, usw.)

der spezifische fehler in hinblick auf die ‘emerging markets’ neuer user, die gleich mit dem smartphone einsteigen, ist, dass die entwicklung als lineare, technik-getriebene evolution vom statischen über das soziale hin zum mobilen web gesehen wird, und den menschen innerhalb dieser entwicklung keine subjektivität oder möglichkeit zum widerstand oder zur reinterpretation zuzutrauen. wir sehen es ja bei uns, da kleben die jungen ja nur noch an ihren handys und chatten oder posten selfies statt zu bloggen oder die wikipedia zu verbessern. was wir bei uns erleben ist aber weniger eine evolution, sondern eine angleichung an das ‘natürliche’ kommunikative gleichgewicht unter den bedingungen vom mobilen internet, das halt erst jetzt möglich geworden ist, aber immer schon so veranlagt war. die phasen waren also, wenn man so will, in ihrem historischen ablauf notwendig, weil wir uns immer kollektiv an das gerade technisch machbare angepasst haben, aber einmal vorhanden verhalten sie sich, als wären sie immer schon da gewesen.

aber die technische ebene ist ja nicht die einzige. auch interessant ist mitunter, wie sich die technik / das web auf gesellschaftlicher ebene auswirkt – und da macht das narrativ der evolution einen u-turn. da sind dann plötzlich die apps des mobilen webs die primitive form, die halt (natürlich massenweise) private kommunikationsereignisse ermöglichen, die aber weder für die öffentlichkeit bestimmt noch für die gesellschaft nützlich wären. erst mit dem offenen und sozialen web bekommen wir einen viel interessanteren hebel, um gesellschaftliche probleme zu behandeln und gemeinsame lösungen auf sozialer sinnebene zu finden.

und hier muss man der kommenden ‘mobilen milliarde’ einfach zutrauen, dass sie ihre eigene entwicklungsgeschichte durchmachen und dabei vl. auf einem viel höheren niveau landen, als wir es bis dato geschafft haben, oder aber auch nicht. sie beginnen zwanzig jahre später und das dauert sicher ein bisschen zeit, aber der umstand, dass sie bei unserem ‘ende’ beginnen bedeutet eben nicht, dass sie dort bis in alle ewigkeit braten müssen.

(man erkennt übrigens die wiederholung eines weiteren musters: als etwa das ipad vorgestellt wurde, haben es die vertreter des offenen webs als zynische und infantilisierende konsumationsmaschine wahrgenommen und die kollektive volksverblödung befürchtet, siehe das offene web und seine feinde. gekommen ist es natürlich anders, nur das mangelnde vertrauen in die systemkraft der eigenen offenheit und die kreativkraft der menschen ist ihnen leider geblieben)

Sauerkrauts Revolutions

Warum ist Deutschland in allen Dingen Web so daneben?

Ich bin euch ja noch meine Antwort auf Quiz Pt. 61 schuldig.

Und die ist: wegen den Deutschen.

——

Derzeit gibt es wohl zwei dominante Kulturformen, die das allgemeine sozio-technologische Potential einer ‘Gesellschaft’ reflektieren:

(1) das Fernsehen

(2) das Web

Beide Formen sind hochgradig komplex (duh) und auf vielfältige Weise mit mehreren anderen gesellschaftlichen Subsystemen verwoben (duh). Beide sind nicht als Produkt, sondern nur als systemisches Bündel an Produktions-, Rezeptions- und Distributionsbedingungen, die alle selbst wiederum in den verschiedensten systemischen Abhängigkeiten zu Bildung, Technologie, Finanzierung/Kapital, Politik/Recht, etc. stehen, zu verstehen.

Das gesellschaftlich mögliche Potential beider Felder entsteht als Equilibrium im Zusammenspiel der jeweils beteiligten Strukturen, wobei es innerhalb dieses Equilibriums nur beschränkt die Möglichkeit zum ‘Ausbruch’ nach oben gibt.

Sprich: es ist nicht möglich, in einer Kultur einfach schnell mal besseres Fernsehen zu machen, oder einfach schnell mal bessere Startups zu erzeugen, indem man sie ein bisschen fördert oder in Schulen C++ unterrichtet. Will man sich verbessern, muss man das Niveau des Gesamtsystems erhöhen, was nur gelingen kann, wenn man das Zusammenspiel versteht.

(was es allerdings gibt, sind lokale maxima und talente, die auch in anderen milieus funktionieren könnten. ein harald schmidt war in seiner hochzeit mitunter sogar besser als ein david letterman; ein stefan raab macht – egal ob man ihn mag oder nicht – unterhaltsames fernsehen, das in dieser form woanders gar nicht möglich wäre; ein christoph waltz kommt in hollywood überhaupt erst zur entfaltung; usw.)

Spielen wir das nur mal als Milchmädchen frei assoziativ mit Fernsehserien durch: Es gibt die Ebenen der Produktion, die einerseits mehrere kulturelle Gebiete wie Schauspiel, Literatur/Drehbuchschreiberei, Musik/Ton und Regie/Kamera integriert, aber natürlich auch alle anderen Aspekte einer Produktion wie Schnitt, Casting, Kostüme, Bühnenbild und Set Design, Postproduktion und Special Effects, etctrara beinhaltet. Dann gibt es die Ebene der Kritik und der Rezeption, also wie viele Leute es anschauen, welche Leute es anschauen, was von Kritikern oder Sehern darüber gesagt und geschrieben und gevloggt wird, welche Themen oder Charaktere sich ins kulturelle Unbewusste einprägen, welche Bilder oder Themen davon zu zirkulieren beginnen, auch welche Veranstaltungen es dazu gibt (Comic-Con, Bambi), usw. Und es gibt natürlich die Ebene der Finanzierung, Distribution, Vermarktung und Ausstrahlung, also dem Gewebe an öffentlichen und privaten Fernsehanstalten, an Produktionsfirmen, an Programmverantwortlichen, Showrunnern, Werbenden, usw, die auch wiederum alle in unterschiedliche Strukturen mit unterschiedlichen Rahmenbedingungen eingebettet sind.

(nicht jede erwähnte und vergessene schraube wirkt sich sofort auf alle anderen schrauben aus, d.h. es gibt schon grössere und kleinere abstraktionen, aber vieles hängt mit vielem anderen mehr oder weniger direkt zusammen)

Für jede der beteiligten ‘Positionen’ gibt es offizielle oder inoffizielle Bildungswege, Werdegänge und Verfahren der Besetzung (gewerkschaftlich, meritokratisch, nepotistisch, etc.). Und auf jeder Ebene werden sich formelle oder informelle Prozesse etablieren und ausdifferenzieren. Und das Zusammenspiel von allem etabliert dann eben halt das jeweils konkrete gesellschaftliche Gesamtmilieu.

Hier ist nun das Ding: dieses Gesamtmilieu definiert weitgehend einerseits die durchschnittlich erwartbare minimale Qualität von Produktionen und andererseits die maximale Höhe der Idealproduktion. In einer Kultur mit hohem Gesamtmilieu ist nicht nur jede durchschnittliche Produktion viel besser als jede durchschnittliche Produktion aus einer Kultur mit niedrigerem Gesamtmilieu, in einer Kultur mit hohem Gesamtmilieu sind auch die Spitzen (die The Wire’s, die Breaking Bad’s oder die Jon Stewart’s) ungleich viel höher, als sie in einer Kultur mit niedrigerem Gesamtmilieu überhaupt möglich sind.

Innerhalb eines (niedrigeren) Milieus fällt das nicht auf, weil alles andere ja genauso mittelgut ist und es eine lokale Verteilung mit lokalen Hits gibt. Die eigene Höhe im internationalen Vergleich spürt man nur, wenn man die eigenen Programme international verkaufen will. Und bei Fernsehserien kann man sich ja leicht ausmalen, wie das Verhältnis von Import zu Export ist.

Ich glaube die Frage, warum es fast unmöglich ist, aus dem lokalen Milieu auszubrechen, wird am Beispiel Fernsehen recht anschaulich: Bei guten TV-Serien (oder auch Reality TV) sind einfach alle Ebenen irre gut; die Schauspieler sind irre gut und die Stories bzw. die Dialoge sind irre gut und die Cinematographie ist irre gut und der Schnitt ist irre gut und die Musik ist irre gut und die ganze Qualität der Produktion ist irre gut, usw. Was bedeutet, dass es diese guten Schauspieler und Schreiber und Regisseure und Kameramänner und Editoren und alle anderen zuerst einmal geben und dass man sie dann auch finden und bekommen muss. Und in Kulturen mit hohem Milieu haben sich diese Prozesse eben zu einem Grad ausdifferenziert, dass es einerseits einen sich permanent nachfüllenden Pool an Talenten gibt, und andererseits Mechanismen die besten zu entdecken und auf die aktuellen Projekte zu mappen. Und weil sich Talent nicht in einem Vakuum entwickelt sondern nur im Benchmark gegen andere wird dieser Pool an Talenten umso besser, je besser er schon ist. Und je grösser und besser der Pool ist, desto eher professionalisieren und spezialisieren sich die Filterprozesse; Aufgaben wie Casting werden überhaupt erst dann ‘als Kunst’ geschätzt und anerkannt, wenn man aus einem vollen Pool schöpfen kann, aber auch weiß, dass es auch alle anderen tun. (deutsches reality tv beginnt üblicherweise mit wirklich lahmem casting, was ihnen in konsequenz dann kein material für subtileres storytelling gibt, sondern halt nur für ein sich akzelerierendes gegenseitiges anschnauzen)

Komponenten beim Web

Mit dem Web verhält es sich grundsätzlich sehr ähnlich. Es gibt die Ebene der Produktion, die mehrere technische/informatische Gebiete wie Systemanalyse, Programmieren, Entwicklung von bösen Algorithmen, Datenbanken, Testen oder Design integriert, aber natürlich auch alle anderen Aspekte eines Projekts wie Projektmanagement, Qualitätssicherung, Administration, Dokumentation, usw. beinhaltet. Dann gibt es die Ebene der Benutzung und der Rezeption, also wie und wie viele und welche Leute es verwenden, was die Blogger oder Benutzer darüber sagen, welche soziale Objekte erzeugt werden und wie sie fliessen können, wie es via APIs o.ä. mit dem Gesamtsystem anderer Dienste zusammenhängt, usw. Und natürlich die Ebene der Leitung, Finanzierung und Vermarktung, also den Gründern und Managern, dem Gewebe an öffentlichen Förderungen und Einrichtungen und Wagniskapital, an Human Resources und Contractors, an Werbenden und zahlenden Kunden, Presse, Kommunikation, Community Management, usw. die auch alle wiederum in unterschiedliche Strukturen mit unterschiedlichen Rahmenbedingungen eingebettet sind.

Und auch hier gibt es für jede der beteiligten Positionen offizielle oder inoffizielle Wege der Ausbildung und Besetzung und auf jeder Ebene eine Ausdifferenzierung formeller und informeller Prozesse zum gesellschaftlichen Gesamtmilieu, das auch hier wieder ganz weitgehend einerseits die durchschnittlich erwartbare minimale Qualität von und andererseits die maximale Höhe der Idealproduktion definiert. Wir kennen die Logik von oben.

Zu erwähnen ist vielleicht, dass es bei Startups natürlich ein viel breiteres Spektrum an Größenordnungen als beim Fernsehen gibt. Es gibt ja tatsächlich Ein-Personen Startups, die gesellschaftlich durchaus signifikante Effekte erzielen können. Und es gibt Probleme, die mehrere Tausend hochgradig spezialisierte Leute beschäftigen können und manche Milieus beschäftigen sogar zehntausende Leute damit alle andern zu überwachen. Der sweet spot für Startups scheint jedenfalls aber ein Kern von zwei, drei Leuten zu sein. Aber ob groß oder klein, alle sind an ihr Milieu gebunden.

Aber es gibt zwei wichtige Unterschiede:

Die Auswirkungen sind gesellschaftlich deutlich relevanter, weil es nicht nur ein Markt für Unterhaltung ist und/oder die Gesellschaft auf symbolischer Ebene tangiert (was natürlich auch nicht zu unterschätzen ist), sondern eben direkt in grundsätzlich alle anderen gesellschaftlichen Subsysteme einwirkt und diese u.u. transformiert, egal ob die das selbst dann wollen oder nicht. Dieses ‘es ändert sich alles’ klingt zwar wie eine blöde Plattitüde, aber es kann ja jeder versuchen sich zu erinnern, wie die Welt vor nur 20 Jahren noch war und es geht natürlich erst los, nur wissen wir noch nicht wohin.

Und die Bedeutung der ‘Rezeption’, also der Feedbackloops mit den ‘Benutzern’, ist nicht nur ungleich höher, sie ist essentiell, weil die Entwicklung neuartiger Dienste nur in Koevolution mit Benutzern möglich ist. Aus den Standardsituationen (aus 2009, also immer 5 jahre dazurechnen):

gerade im und um das internet lagen eigentlich alle schon immer falsch, man braucht nur an die metaphern und visionen von vor 15 jahren denken. niemand hat vor 10 jahren mit wikipedia, google oder blogs, vor fünf jahren mit facebook, youtube oder flickr, noch vor zweieinhalb jahren mit twitter und mit den damit einhergegangenen strukturveränderungen gerechnet, einfach auch deshalb, weil die meisten tools selbst reine zufälle waren, deren effekte noch nicht mal die gründer auch nur erahnten. facebook entstand, weil zuckerberg ein fauler hund war und aufgaben crowdsourcen wollte; flickr war ein abfallprodukt eines online-games; die wikipedia entstand, weil aus der eigentlich angedachten nupedia, die von experten geschrieben werden sollte, nix wurde; twitter war als sms-dienst unter freunden gedacht, den die user dann umfunktionalisiert haben und zu dem gemacht haben, was es ist. wir wissen alle nix und selbst wenn man mit einer aussage/prognose zufällig richtig liegt, dann eher deshalb, weil irgendeine aussage immer stimmt, und nicht weil man es wissen konnte.

(nts: mich öfter selbst zitieren)

Aber der Zufall kommt, das habe ich damals nicht betont, nicht von allein; er entsteht nur in der Dialektik zwischen der Art, wie Leute ein Angebot be- und oft missnutzen und für sich interpretieren, und der Aufmerksamkeit von Gründern, die sich abzeichnende Flüsse wahrnehmen und im Idealfall aufgreifen und damit laufen. Ohne die Neugier der frühen Benutzer entsteht ganz einfach nichts Neues. (Permutationen sind ab einem gewissen Grad des Verständnisses dann natürlich möglich, aber auch die erhöhen im besten Fall die Wahrscheinlichkeit für einen gewissen Erfolg; man sieht das daran, wie wenige Gründer ihren ersten Erfolg dann wiederholen können, auch wenn sie dann deutlich freundlicher behandelt werden, was natürlich auch schon wieder der Grund für das ‘Nichtfunktioneren’ sein kann, weil ihnen der tatsächliche Gegenwind fehlt; VC folgt übrigens einer anderen Logik, die versuchen Wahrscheinlichkeitsverteilungen zu optimieren)

Und das ist dann eigentlich schon das K.o. für rein deutsche Startups in der ersten Runde, die notwendige Dichte an explorativen Benutzern gibt es hier einfach nicht, weil alles Neue zunächst als reine Zumutung wahrgenommen wird, die einen mit einer Vollbegründung erst von ihrem Sinn und Nutzen überzeugen muss, bevor man sich vl. mal zur temporären Benutzung erbarmt. Rationalität und Erbsenzählerei sind in einigen Bereichen nützliche Eigenschaften, als Katalysatoren für Startups sind sie aber ungeeignet. In Deutschland ist sicherlich einiges suboptimal, aber auch Medien und Politik, die zwei größten absichtlichen Bremser, können nichts verunmöglichen was wirklich ans Tageslicht will. Das große Unglück für die deutschen Startups sind die deutschen User.

(wenn das noch nicht reicht, dann kommt in deutschland noch dazu, dass gründungen häufig bwl-getrieben sind, was auch noch die zweite seite der erwähnten dialektik behindert, weil es bei denen im vergleich zu tech-getriebenen deutlich schwerer ist, aufmerksam zu sein und sich mit agilität anzupassen)

Und das bedeutet leider, dass das ganze Standard-Repertoire an von Politikern, Verbänden, Vertretern und Bloggern geforderten Förderungen überhaupt nichts bringt, weil sie im besten Fall ein Problem lösen, das von diesem Grundproblem dann schon im Keim erstickt wird. Die (oft bemängelte) Anzahl an Startups zb. ist ja überhaupt nur dann bedeutsam, wenn es einerseits zu mehr Variation führt und es andererseits auch eine gesellschaftliche Selektionsfunktion gibt, die die potentiell funktionierenden Startups dann entdecken kann. Ansonsten ist das ein reiner crap shoot. (inkubatoren sind die standard-maschine zur erzeugung dieser variation, nur benötigen auch die wieder eine gewisse systemische dichte als katalysator, die üblicherweise durch eine art hunger-funktion erzeugt wird, die es in deutschland eigentlich – zum glück – auch nicht gibt).

(nur zur sicherheit: mich interessieren hier nur native webstartups, die irgendeine neue beziehung oder verbindung von davor unverbundenem ermöglichen, irgendein neues soziales objekt generieren, irgendwelche neuen ströme erzeugen oder fliessen lassen, irgendeinen neuen möglichkeitsraum erzeugen. mich interessiert hier nicht die abbildung von grundsätzlich ohnehin gut verstandenen verhältnissen jetzt halt auch im web, das folgt mitunter einer etwas anderen logik mit teilweise grösserer steuer- und planbarkeit; auch der komplex internet of things und alles was mikro- oder makroskopisch mit hardware zu tun hat funktioniert anders)

Wenn man sich also sagen wir mal auf mittlerem Niveau überlegt, wo man ansetzen soll und was man tun kann, um international mitzuspielen zu können, dann ist es wichtig, die eigenen Schwächen zu verstehen, damit man an seinen asymmetrischen Stärken arbeiten kann.

Das ist im Falle Web im Vergleich zum Fernsehen auch deshalb relativ wichtig, weil im Web nur die Ebene der Produktion an das lokale Milieu gebunden ist; die Ebene der Rezeption ist zumindest grundsätzlich flüssig, d.h. für Benutzer gibt es keine Notwendigkeit, mittelgute lokale Reinterpretationen zu verwenden, weil man immer auch das Original verwenden kann. Der Name World Wide Web deutet das schon an.

(es ist nicht nur völlig sinnlos, den höchstentwickelten projekten des höchstentwickelten milieus à la ‘wir brauchen ein europäisches google’ direkt konkurrenz machen zu wollen, es ist auch eine verschwendung von ressourcen, die in andere projekte gesteckt werden könnten. mit den 200 mio die etwa in theseus gepumpt wurden, hätte y-combinator 1.667 startups inkubieren können. das problem dabei ist natürlich, dass es im milieu dementsprechende verfahren geben müsste, die diese sinnvolleren projekte erkennen kann, was auf mittelhohem niveau eher unwahrscheinlich ist, es hängt eben alles mit allem zusammen)

Es wird ein bisschen lang und das ist vl. Thema für ein anderes Posting, aber ich glaube es ist die Hoffnung nicht ganz unbegründet, dass das ‘Deutsche’ nicht nur das Problem, sondern auch die Lösung ist, weil es einige tatsächlich distinktive Eigenschaften und ausgeprägte Qualitäten hat, die sich für die zukünftige Ausdifferenzierung vom weltweiten Gesamtmilieu als nützlich erweisen könnten.

-

update: see 260680356

Captain Koons

endlich wieder einmal ein Quiz: Was kann man von Pulp Fiction über die Apple Watch lernen?

ich bin euch ja noch die auflösung von quiz pt. 96 schuldig und die verbirgt sich in der frage, wie der film wohl geworden wäre, wenn der vater von butch coolidge statt seiner goldenen uhr eine apple watch edition getragen hätte, aber first things first:

nach der vorstellung der watch im september konnte man ja sehen, dass sie als ding die von apple erwartbare tollheit haben wird. smartwatches sind natürlich keine ganz neue kategorie, man denke an die pebble oder einiges im umfeld von android wear und michael knight hat schon in den 80ern eine gehabt. aber apple hat damit wohl den ersten sich als uhr verkleidenden minicomputer gebaut, an dem sich fortan alles andere messen lassen muss.

(smartwatches selbst haben imo mit ‘innovation’ ohnehin wenig zu tun, sie sind die offensichtliche extrapolation in einer serie an kleiner werdenden touchscreens als user interface für universelle mobile computation. sprich: auf die idee kommt jeder, die leistung besteht in der ‘exekution’, also dem design und der entwicklung/produktion und vor allem auch dem zusammenspiel von soft- und hardware und dem bereitstellen eines ökosystems für andere, und da ist apple natürlich in der einzigartigen situation den ganzen stack in der eigenen hand zu haben)

neben dieser dinghaften schlüssigkeit scheint mir aber auch der preis zu stimmen. mit $350 liegt sie in diesem mental als taschengeld abschreibbaren bereich von übers jahr betrachtet weniger als einem euro pro tag.

der preis ist deshalb bei der watch so wichtig (und wir kommen weiter unten nochmal darauf), weil apple selbst auch 6 monate nach der ersten vorstellung der watch noch überhaupt kein gespür dafür hat, für was sie wirklich gut sein wird.

ich frage mich wirklich, was apple im letzten halben jahr gemacht hat. fast alle von ihnen gezeigten beispiele sind noch immer im grunde nur störungen des menschen bei anwendungsfällen, die vom iphone – das man ohnehin eingesteckt haben muss, damit die uhr überhaupt funktioniert – wesentlich besser gelöst werden. sie betonen zwar die eigenschaft ‘most personal device’ als mantra immer und immer wieder, aber sie interpretieren sie zumindest derzeit nur als irritant.

zu apples glück tut das der attraktivität der watch deshalb keinen abbruch, weil es wegen dem preis eben rational ausreicht, wenn jeder für sich den einen usecase entdeckt, der einen einmal am tag kurz happy macht. für die watch also jedenfalls ein thumbs up.

aber all das konnte man sich auch schon nach der vorstellung im september denken, die einzige katze, die sie jetzt im jüngsten kick-off event aus dem sack gelassen haben, war das pricing für die watch edition. und die hat dann für etwas kognitive dissonanz gesorgt:

ich bin noch über niemanden gestolpert, der über die 10k jammert, aber über mehrere, die über vermeintliche jammerer prophylaktisch jammern.

— Markus Spath (@hackr) March 9, 2015die diskussion war nicht unwitzig, weil sie eigentlich nur darin bestand, dass apple analysten/cheerleader dem säkularen rest unterstellt haben, dass sie über den preis sicherlich jammern werden, dass sie dabei aber überhaupt nicht verstehen, wie genial der schachzug von apple ist und was apple damit will und tut und kann und welche märkte apple damit erschliesst, think vogue not chip, usw.

Und jetzt kommt Ihr ins Spiel, die Ihr hämische, amüsierte oder neiderfüllte Scherze macht über die superteure, goldene Apple-Uhr, die nur Deppen kaufen. Wie jeder einzelne davon Apple glücklich macht!

sascha lobo etwa bleibt noch vergleichsweise pragmatisch und unterstreicht nur – iirc asymco folgend – die verkaufspsychologische these, dass teure dinge im direkten vergleich weniger teure dinge billiger erscheinen lassen, und dass sich deshalb die immer noch viel zu teuren watches neben den editions billig wie semmeln anfühlen und entsprechend verkaufen werden.

Wer sich eine 10k+-Uhr leisten kann, sieht den kommenden Wertverlust der Technik als Teil des Statussymbols.

marcel weiss andererseits verabschiedet sich gleich von jeglicher rationalität und sieht im zu erwartenden wertverlust selbst den eigentlichen sinn. auch er folgt iirc einer anderen einschätzung von asymco, dass sich nämlich die neureichen asiaten nur so darauf stürzen werden.

was die zwei und alle anderen positionen dazwischen, die den luxus-charakter der editions betonen und damit den preis erklären, aber nicht verstehen ist, dass es nicht der preis ist, der das zu erklärende ist.

dass es luxusgüter gibt, die hochwertig und mit edelsten materialien in handarbeit in abgeschotteten bergdörfern gefertigt werden, um dann unverschämt teuerer verkauft werden zu können, leuchtet jedem ein, auch denen die sich das dann nicht leisten können oder wollen.

das zu erklärende ist, wie es überhaupt dazu kommen konnte, dass apple eine solche nur außenrum luxuriöse uhr konzipiert und baut, wenn ganz offensichtlich ist, dass das technische herz ein stück technologie für $50 ist, das in eher 3 als 5 jahren völlig veraltet sein wird und dass man dann also auf einer uhr für $10.000 sitzt, die technisch und funktionell jeder nächsten generation an normalwatches für 350$ deutlich unterlegen sein wird.

und auch wenn man über die software selbst viel abstrahieren kann, dinge wie verbesserte akkulaufzeit oder chips für den aktuellsten übertragungsstandard oder unabhängigkeit von einem mitzuschleppenden mutterschiff iphone definieren doch mitunter radikale unterschiede in der nützlichkeit.

(ich könnte die editions ja noch irgendwie verstehen, wenn apple für sie eine eingeweidetechnische upgradeability offerieren und garantieren würde; alle zwei jahre bekommt man, wenn man will, für eine pauschale service-gebühr den aktuellsten und besten chip eingebaut, was kommt ist sicher nicht grösser und hätte bei standardisierter schnittstelle also locker platz. aber as is entsprechen die uhren spätestens in ein paar jahren bestenfalls vergoldeten minis, die aber von selbstfahrenden smarts in allen kategorien übertroffen werden)

um zb auf das argument von lobo zurückzukommen: der fehler in seiner analogie ist, dass es sich bei den watches nicht um rolexes handelt, die sich als swatches verkleiden, sondern dass es sich bei den editions um swatches handelt, die sich als rolex verkleiden.

was und finally, sorry, zu meiner antwort auf das quiz bringt: hätte butch’s vater im vietnamkrieg statt der goldenen uhr seines grossvaters eine apple watch edition getragen, er hätte sie wohl nicht in der gefangenschaft 5 jahre lang in seinem hintern versteckt, und spätestens captain koons hätte sie nicht weitere zwei jahre in seinem hintern versteckt und butch hätte sie also nie bekommen. er hätte sie dann also auch nie in seinem apartment vergessen und hätte also nie vincent dann dort beim holen der uhr erschossen und wäre also dann nie auf der flucht marsellus begegnet, was ja erst die seminale szene mit dem schwert getriggert hat, die butch dann ja im grunde gerettet hat, weil er seine schuld begleichen konnte usw.

und ich will jetzt nicht apple unterstellen, dass ihre watch am vermutlichen tod von butch in der alternativwelt schuld gewesen wäre. man kann aber lernen, dass wertschätzung immer auch ein element der narration benötigt. und die narration von luxus operiert natürlich auf einer trivialeren ebene als familiengeschichte, aber auch luxus ist keine reine funktion von preis oder exklusivität, sondern benötigt für die symbolische schliessung zumindest eine imaginierbare qualität als anker in der realität, und die ist, wie wir gesehen haben, bei der edition halt nicht gegeben.

Lazy Blog Ep. 46