2023.02

109909080143889021

109909080143889021 - @marcelweiss ich glaub weder noch, tbh. aber ist nicht der ganze punkt von dezentralität, dass es gegenüber so dingen wie größe eher resilient ist? meine hypothese wäre, dass sich die ausdifferenzierung eher entlang eines funktionierenden SOs (i know) formiert. (diesbezüglich hat tumblr eines schon gefunden, mastodon noch nicht wirklich, es schaut nur wie T aus und ist einfach und in sich sinnvoll genug, um eine gewisse stabililtät zu erhalten, zumindest ein weilchen)

1626929453535199237

1626929453535199237 - little did squirrel know that it was the last time he was visiting the tree (der baum ist weg, nicht das squirrel, aber ich befürchte einen major blow für meine squirrel studies)

1626135518067974144

1626135518067974144 - "when lost, you'd rather get no direction than a wrong one". knowing when to shut up oder don't have any opinion at all wäre vmtl. das key skill fortan, aber silence ist kein content, ist nicht anschlussfähig, meinung füllt das eigene hirn immer automagisch auf und aus uswusf. RT @nntaleb One lesson connected to ChatGPT is that reliable pple aren't those who have good answers in general, but those who answer ONLY things they know v. well.

1624809980380516354

1624809980380516354 - (schon 7h vor dem start alle #superbowl snacks aufgefuttert, und kaffee hab ich auch fast keinen mehr, uiui)

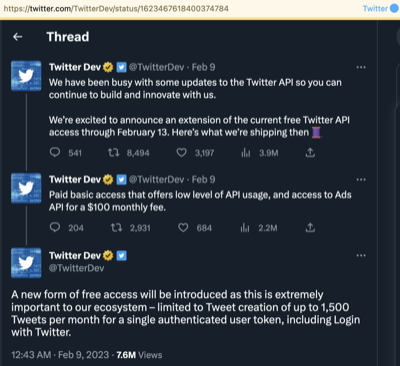

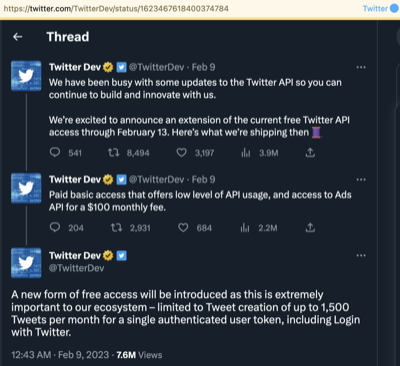

1624341305496113154

1624341305496113154 - twitterminiquiz: was ist im gefüge vom wo zu publish (e/o?) und wo zu syndicate (e/o?) der effekt der kommenden (greedy) api, die nix mehr raus- und nur noch reinlässt?

ich löse mal auf: T verwandelt sich von first in line als PESOS plattform zum first in line als POSSE (i.e davor waren 'gute' tweets immer spezifisch und für die ewigkeit, jetzt werden sie primär opportunistisch, weil alles jederzeit abgerissen werden kann (sterlings favela chic)

1624331256006688769

1624331256006688769 - (text füllt halt immer den gesamten raum und hat es schon immer. i.e. es gibt nie zu wenig, aber man hat auch nix von mehr. mit chatty ai wird nur offensichtlich, wie völlig kontingent das tatsächlich ist, wie sich im grunde immer nur die milieus der strombildungen verschieben)

1623629933380526080

1623629933380526080 - für (provinzialströmische) internet-archäologen: heute vor 13 jahren hat google google buzz vorgestellt (kommt mir viel länger her vor, damals waren sie aber jedenfalls noch lustig) (M ist übrigens gar nicht so weit von buzz, was das potential und falschen grundannahmen betrifft)

109834579042051495

109834579042051495 - @marcelweiss I was hoping Google beats them to the punch (e.g. one-click mastodon instances hosted for free on some fedispot domain etc. unfortunately the community would freak out)

1623414592339603460

1623414592339603460 - (devoha, this is hideous)

RT @TwitterBlue need more than 280 characters to express yourself? we know that lots of you do… and while we love a good thread, sometimes you just want to Tweet everything all at once. we get that.

109822694085837977

109822694085837977 - @ChristophKappes die menschliche leistung dürfte darauf hinauslaufen, dass die nichtverlässlichkeiten (falsche grundannahmen, dinge die noch nicht verstanden oder bekannt sind, non sequiturs, etc.) erkennbar und also anschlussfähig sind.

1622685558899150864

1622685558899150864 - aber wir könnens ja auch, schon lange, eh schon sehr sehr lange usw. RT @sundarpichai In 2021, we shared next-gen language + conversation capabilities powered by our Language Model for Dialogue Applications (LaMDA). Coming soon: Bard, a new experimental conversational GoogleAI service powered by LaMDA.

worldwide

worldwide