Selection 2015

Papierkorb pt. 113

(relativ traurig ist ja, wenn ich auf die letzten 10 jahre zurückblicke, dass ich kein eitzerl weitergekommen bin, was positive aussagen über das web oder die welt betrifft. es gibt vl. einen gewissen korpus an aussagen, aus dem man sinnvollerweise schöpfen und permutieren kann, wenn man halt irgendwas sagen will, aber was wäre schon damit gewonnen und jede non-triviale aussage bleibt ganz grundsätzlich falsch)

((wo ich ggf. schlauer geworden bin, ist beim markieren von ‘falschen’ aussagen, also aussagen, die man in der form einfach nicht machen kann. und das sind – ich übertreibe jetzt nicht – fast alle. was doch unwahrscheinlich ist, aber trotzdem so ist. und ich betone jetzt wie der freiherr von guttenberg: fast jede aussage über das internet ist ein blödsinn und das ist die wahrheit, siehe papierkorb 112. ich weiss nicht, wieso sich die welt da so anstellt, aber es ist so))

Lazy Blog Ep. 51

(blogpost über DAS fundamentale dilemma im derzeitigen und kommenden web: den umstand, dass der linke diskurs von einem semiotischen idealismus geprägt ist, der mit dem internet konfrontiert nun durchgebrannt ist)

((ein dilemma ist das vor allem deshalb, weil als effekt dieses semiotischen idealismus und des durchbrennens diese alternativlose technoskepsis entsteht, die in der konsequenz das ganze spielfeld den neoliberalen kräften überlässt, die natürlich ein radikal zynisches verhältnis zum diskurs haben, was aber nichts macht, weil die linken für sie daran glauben und ihr eigenes verhalten danach ausrichten))

(((für diesen blogpost gibt es natürlich eine ganze reihe an möglichen ansätzen, ein fruchtbarer wäre vl., das anhand einer konkreten analyse von d. dath zu tun; den habe ich ja gestern schon zum zweiten mal als deutschen morozov tituliert, siehe 625274779000565760 und dort in der sidebar auch den kontext, aber ich habe heute nacht auf youtube in ein paar vorträge von ihm reingehört und die sache ist bei ihm doch etwas komplizierter und deshalb vl. auch etwas ergiebiger. zb. sinniert er durchaus auch darüber, wie es einen technologiegetriebenen neokommunismus geben könnte (der viel mehr menschen in den produktionsprozess einbezieht, der viel weniger menschen ausgrenzt, der viel weniger menschen verblöden lässt, der menschen besser behandelt, usw.). sein problem ist dann aber, dass er einerseits auf einem unverhandelbaren set an rechten und freiheiten besteht, die er in einem vollständigen und bis in die faserspitzen durchdachten modell garantieren will, dass er andererseits aber auch jede form von ausbeutung oder kapitalistischer produktionsbedingungen schon ganz strukturell verunmöglichen will. er geht also nicht vom potential aus, sondern von der verunmöglichung von nicht vollständiger kontrolle, was ihn etwa im fall copyright in die konfliktierende position bringt, auf der einen seite jede kulturindustrielle verwertung (inkl. aller legaler konstrukte, die ihr parasitäres blutsaugen unterstützen) zu kritisieren, dem er andererseits aber nichts anderes als ein noch schärferes recht entgegensetzen kann, das halt die immateriellen verwertungsinteressen des autors noch stärker vertritt. alternativen nimmt er zwar wahr – auf der einen seite die neoliberalen irren wie amazon, die sogar einen literaturpreis für self-publisher ausgeschrieben haben, auf der anderen seite technohippies, die davon schwafeln, dass die grenzen zwischen produzenten und konsumenten ohnehin schwinden, damit aber halt auch niemanden satt machen -, bewertet sie aber anhand ihrer (zugegebenerweise blödsinnigen) selbstbeschreibung und nicht anhand von dem, was sie sind. er ist jedenfalls das paradigmatische beispiel dafür, wie man sich selbst im weg stehen kann und das gegenteil von dem was man will bewerkstelligt)))

FYI 027

fyi: das internet ist keine lösung; es ist die frage, wie die gesellschaft ausschauen würde, wenn es das internet schon immer gegeben hätte.

(wenn man so will entspricht die welt einem startup, das sich gerade selbst sucht, ich habe das in the strain schon ein bisschen angedeutet; zu bemerken sind dabei vl. zwei dinge: einerseits bekommt es diese suche mit den historischen strukturen zu tun, die es nur geben konnte, weil es das internet noch nicht gegeben hat, die die eigene existenz – inklusive aller opportunistischer unterstützungsstrukturen – nun aber bis zu den zähnen bewaffnet verteidigen; andererseits muß man aufpassen, homöostatische anpassungen an das erwartbare gleichgewicht nicht mit ‘trends’ zu verwechseln, die eine richtung in eine ‘zukunft’ beschreiben, was natürlich dazu verleitet den wert von ereignissen oder verhalten völlig falsch einzuschätzen und wertvolle techniken verfrüht abzuschreiben)

Pfeifkonzert

(eigentlich soll man trolle nicht füttern, aber weil es doch gwm. das paradigmatische beispiel für das zu beschreibende phänomen ist doch eine minianmerkung zum witz über die griechen von nuhr auf twitter:

es ist in letzter zeit immer öfter zu beobachten, dass jede vorgebrachte kritik an irgendwas mit etwaigen pöbeleien kombiniert und in einem schwung weggeschüttet wird. noch besser wenn es einen sogenannten gackserl-sturm gibt, damit disqualifiziert sich das gesamte restliche internet und man selbst ist das einzige opfer.

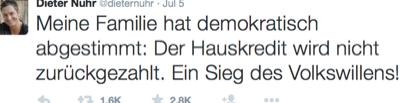

zur erinnerung: nuhr hat kurz nach dem referendum in griechenland getwittert

auch sehr wohlwollend bewertet, ist dieser witz gleich mehrfach problematisch. er kommt aus einer position der selbstgerechtigkeit und ordnungsgläubigkeit, was recht ist, muß recht bleiben, da gibt es keine nachsicht. er kommt aus einer position der stärke und macht sich über die schwachen lustig. er appelliert an das grundgefühl vom neid, was natürlich jede form von solidarität verhindert (‘ja genau, mir schenkt ja auch niemand was’). er ignoriert die gesamte geschichte der situation (und alle damit verbundenen machtpolitischen, wirtschaftlichen, diplomatischen, medialen, sozialen komplexitäten) und lokalisiert die ‘schuld’ bei den griechen, denen nur der ‘wille’ zum zurückzahlen fehlt. es ist ein witz für eine von den deutschen medien erzeugte mehrheit, der die konstruierten ressentiments verstärkt und nicht hinterfragt oder dekonstruiert. wer darüber nachdenkt findet sicher mehr, unterm strich ist es jedenfalls ein gelungenes stück populismus.

statt sich nun aber ein bisschen zu schämen, verteidigt nuhr seinen sogenannten witz in der faz dann auch inhaltlich (mit der deutschen/regierungspolitischen sandkastenargumentation, die alle vorgetragenen argumente schlicht ignoriert) und erklärt dann aber das netz und das, was es mit den menschen anstellt, zum problem. und man traut dann seinen augenen nicht, mit welchen geschützen er bei der beschreibung was er im anschluss ertragen mußte auffährt: natürlich den gackserl-sturm, der andersmeinende durch gemeinsamen bewurf mit gackserln nicht weniger als mundtot machen will; er wurde beleidigt, beschimpft, bedroht; er wurde als zensor bezeichnet, abstrus, weil er ja nicht der könig des internets ist (sic); es gab weitere beschimpfungen, beleidigungen, todeswünsche, drohungen; er wurde als nazi und in anderem zusammenhang als ausländerfeind bezeichnet, beides irrsinnige vorwürfe, die sachlichkeit vermeiden und den anderen überwältigen und ‘im digitalen vernichtungskampf’ besiegen wollen; sie wollten ihn primitiv etikettieren, um ihn, den andersdenkenden, moralisch zu diskreditieren, und das sei ‘die übliche form der auseinandersetzung’ im web; die primitivität und aggressivität der verfolgung führe zu lynchjustiz und pogromen, zum glück wird heute – anders als im mittelalter – nur noch virtuell getötet resp. digital vernichtet; der gackserl-sturm sei ganz offensichtlich die hexenverbrennung 2.0; und das werde im internet ja immer schneller; um meinungsfreiheit gehe es schon lange nicht mehr, argumente werden nur ‘in den seltensten fällen’ ausgetauscht, es gehe um meinungshoheit und die vernichtung abweichender meinungen, indem überwältigt, etikettiert, beleidigt wird; was fehlt sei die haftbarkeit des einzelnen, nur die bringt rechtsstaatlichkeit und menschenwürde; die pöbelnde masse, die wir gerade erleben, bringt uns zurück zum faschismus, vl. auch ins mittelalter; die herausforderung unserer zeit ist also die aufklärung auch ins web zu bringen.

hier ist das ding: die gesamte kommunikation, die aus dem quadranten der ‘hater’ kommt und mit dem internet teilweise erst sichtbar, teilweise erst erzeugt, teilweise sich selbst hochschaukelnd verstärkt wird, die einen manchmal wirklich fassungslos macht, ist nicht das beste, was das internet hervorgebracht hat, und ist ganz grundsätzlich niemandem zu wünschen.

sein artikel in der faz lässt jedenfalls schon die tiefsten abgründe der menschlichen seele vermuten, entsprechend vorsichtig und spät habe ich mich jetzt doch einmal an den thread zum tweet auf twitter herangewagt, aber hier wird’s interessant: die reaktionen sind in keinster weise so, dass sie eine solche tirade auch nur ansatzweise rechtfertigen würden. ich bin nicht auf facebook und dort schaut es u.u. etwas anders aus, aber im (durchaus langen) thread auf twitter gibt es vl. eine handvoll reaktionen, die man als ‘übergriffig’ bezeichnen könnte; die mehrheit der antworten besteht aus tweets, die dem witz ganz allgemein dummheit und/oder populismus und/oder mangelnden witz diagnostizieren; auch die zustimmung, die genausoists und die weitersos sind vertreten; und dann gab es auch noch eine durchaus signifikante anzahl an reaktionen, die ihm, würde er sich die mühe machen den hinweisen zu folgen, auch versuchen zu erklären, warum sein witz als dumm und populistisch und unlustig wahrgenommen wird. am ehesten entspricht das also einem pfeifkonzert, und das ist er nicht gewohnt und das verletzt vermutlich seine eitelkeit, weil er seine witze üblicherweise vor einem selbstselektierten publikum absetzt, das über jeden witz lacht. aber jede form der auseinandersetzung kann er sich und den faz-lesern sparen, wenn er ‘gackserl-sturm’ schreit und das internet zum ort der verdammnis erklärt.

(nochmal: auf facebook gab es wohl unangenehmere kommentare und die will ich nicht legitimieren; aber ich vermute stark, dass es auch dort konstruktiv/kritische stimmen gibt, die er ignoriert, weil er lieber in seiner schachtel bleibt und selbst die vorbeilaufenden mit seinem gackserl bewirft))

618786157799849984 Revisited

@kusanowsky openmedi reines bauchgefühl: das 'genie' wandelt sich von 'produktiv' zu 'perzeptiv' (zettelkasten idiosynkratisch dazwischen)

— Markus Spath (hackr) July 8, 2015kl. nachtrag zu 618786157799849984 :

vorgeschichte war dieser tweet mit einem video über luhmann und seinem zettelkasten, in dessen thread dann kusanowsky an seinen kurzvortrag über die koinzidenz von luhmann und dem internet erinnert hat, in dem er nicht weniger als einen epochalen übergang der funktion/position des gelehrten unter den bedingungen des internets skizziert. (schaut es auch ggf. an, es ist kaum zu komprimieren, aber verkürzt ist seine beobachtung, dass es die traditionelle aufgabe des gelehrten war, erkenntnis zu produzieren, die er dann der öffentlichkeit durch lehre zur verfügung stellt, wobei ihm einerseits herausragende kognitive kompetenz/genialität unterstellt wurde, deren würde er andererseits durch abschirmung vor den trollen und allem gemeinen bewahren mußte; luhmann hat dann aber sowohl dem begriff des genies als erzeuger von wissen, als auch mit dem begriff der lehre als ‘übertragung’ von wissen von einem (intelligenten) kopf in die köpfe aller anderen gebrochen, da kommunikation eben gerade nur deshalb funktionieren kann, weil die menschen nicht füreinander ereichbar sind, und der begriff des genies sinnlos ist, weil die gesellschaft nicht aus menschen, sondern aus kommunikationen besteht. das zeitliche zusammenfallen von luhmann und der entstehung vom internet könnte uns, so vermutet klaus, nun hinweise darauf geben, was wir mit dem internet nun auch im komplex ‘wissen’ anstellen könnten, wobei wir blöderweise das problem haben, dass nicht mal luhmann-schüler mit dem zettelkasten noch etwas anfangen können und wir vom internet nun überhaupt keine vorstellung haben). der tweet ist gwm. eine abrundende ergänzung: ich glaube klaus war tatsächlich auf der richtigen spur, luhmann und sein zettelkasten ist gwm. der drehpunkt für die reformatierung vom system ‘diskurs’. mit dem internet ist nämlich zwar die konzeption vom genie, das erkenntnis produziert, gestorben (just google it, big data, etc.), aber gleichzeitig als perzeptor und selektor, der im endlosstrom der daten die muster und zusammenhänge erkennt und als storyteller in eine share- und likebare narration verpackt, wiederauferstanden. luhmann hat mit der selbstdistanzierung vom ‘genie’ sicherlich ein bisschen kokettiert, aber er hat die aufgabe vom ‘genie’ konkret verschoben und zwar hin zum ‘anwender eines (nontrivialen, unwahrscheinlichen) algorithmus’. der witz bei der gesamten systemtheorie ist ja, dass sie sich tatsächlich von selbst schreibt, wenn man sie einmal verstanden hat – und für luhmann war der zettelkasten gwm. nur der inputstrom, auf den er sich freiwillig selbst beschränkt hat (was bei ihm natürlich nicht weniger als die behandlung aller hauptsysteme der gesellschaft war). das genie kann man aber trotzdem nicht ganz streichen, weil es nun der algorithmus ist, auf den man kommen oder den man erst mal verstehen muß. als mechanismus ist das nicht ganz neu, deleuze hat zb. seine philosophie in den verschiedensten feldern ‘gefunden’. aber mit dem internet bekommt dieses methodische ‘sich von selbst schreiben’ natürlich seine bestimmung, weil potentiell alles und zwar in echtzeit zum inputstrom werden kann (wobei natürlich nicht alles für jeden algorithmus sinnvoll ist, genaugenommen fast nichts für keinen, wobei dieses nichts auch wieder gigantisch groß ist, es gibt halt einfach sehr viel). man danke nur an zizek, der kann seine theorie zu so ziemlich jedem politischen oder gesellschaftlichen thema in zwei, drei tagen zu einem aufsatz implementieren, oder an bolz oder auch kusanowski, wenn man nach einem luhmann-schüler sucht.

618394991371620352 Revisited

.@martinweigert mspro diplix das 'große problem' ist doch nicht die demut/epistemologische reflexion, sondern die dummheit/arschlochigkeit

— Markus Spath (hackr) July 7, 2015@martinweigert _jk mspro diplix (nur zur sicherheit: ich meine das nicht persönlich, sondern strukturell; etwa ausblenden des int. disk.)

— Markus Spath (hackr) July 7, 2015kl. nachtrag zu 618394991371620352 weil man es doch auch missverstehen kann:

vorgeschichte war diese anmerkung von diplix über eine anmerkung von niggemeier, in der dieser sich über die pseudo-wirlassenunsauchgernekorrigieren-prozesse der medien mokiert und diplix stattdessen mehr demut im journalismus fordert, damit gewinne man eher vertrauen zurück als als ignoranter, besserwisserischer gockel. aber während demut natürlich nie schlecht ist und wenn man von der korrektur handwerklicher fehler (etwa der verwechslung einer riesigen demo gegen mit einer riesigen demo für etwas oder umgekehrt) einmal absieht, das ‘große problem’ in der berichterstattung über griechenland ist doch nicht die mangelnde demut und dass man nicht durchblicken lässt, dass man eigentlich überhaupt keine ahnung hat (und dann vermutlich die eigene ahnungslosigkeit zur eigentlichen krise erklärt und das dann diskutiert), sondern dass ein grossteil der leitmedien nicht nur keine uninformierte aber zumindest im versuch neutrale, sondern im tandem mit der regierungspolitik eine über weite strecken desinformierende, polemische und den griechen gegenüber völlig unverantwortliche und asoziale linie gefahren ist, und das auch lange, nachdem wirklich offensichtlich war, dass sowohl die maßnahmen, als auch der die maßnahmen flankierende diskurs in einer sackgasse gelandet sind und man am ende angekommen nun auch noch ein loch graben will. wer den twitterstrom von @martinlindner ein paar monate zurückliest, wird seinen augen nicht trauen, wie lange die deutschen massenmedien und allen voran die öffentlich-rechtlichen talkshows – anders als ihre internationalen kollegen, die die dissonanz zwischen plan und wirklichkeit spät aber doch irgendwann erkannten und verdauten – unisono die trope vom faulen griechen wiederholten, der sich alle probleme selbst eingebrockt hat, der jetzt schon seit jahren trotz konkreter anweisungen seine hausaufgaben nicht macht und der doch wirklich von alleine darauf kommen sollte, dass er einfach noch ein bisschen mehr sparen muss, usw. da fehlt nicht die demut, da wird ganz gezielt nur eine sehr einseitige wirklichkeit konstruiert und überhaupt nur jene stimmen zugelassen, die eben diese wirklichkeit bestätigen. ich kenne mich null aus, aber dass das gesamte hilfsprogramm nichts anderes war als ein hilfsprogramm für die betroffenen banken, dass man ein wirtschaftlich ohnehin am boden liegendes land nicht schuldenfrei sparen kann, dass die verschuldung als mittel beliebiger politischer erpressungen verwendet wird, dass deutschland mit diesem politischen gehabe gerade weltweit viel von dem ansehen verspielt, das es sich in den letzten 60, 70 jahren völlig zurecht erarbeitet hat (ehemals exzellente medien, die von aussen mittlerweile nur noch als hinterwäldlerisch wahrgenommen werden; wertebasierte politik (liberal und sozial), die zumindest in der causa griechenland von aussen nur noch als unfähig und stur wahrgenommen wird) scheint mir offensichtlich zu sein. man muß keine lösung im köcher haben, um eine falsche lösung als falsch zu erkennen.

(ich vermute, dass die wurzel dieses deutschen sonderweges im fall griechenland die gleiche ist wie im fall web 2.0 oder lsr, nämlich das zusammentreffen vom grundgefühl, dass es keinen nutznießer geben darf (dieses ich schneide mir lieber den finger ab, bevor ein anderer von meiner leistung profitiert

, siehe der parasit), mit dem umstand, dass sich die deutschen medien nur selbst lesen – und also den internationalen diskurs auf der einen seite, den socmed diskurs auf der anderen seite einfach nicht registrieren und nur in ihrem eigenen saft dahinköcheln, ohne dadurch einen wettbewerbsnachteil zu haben, weil es ja alle anderen auch tun)

The Strain

kl. nachtrag zu curate or die: die nyt hat vor kurzem ja von ihren kollegen viel bewunderndes kopfnicken geerntet, weil sie intern mal eine woche den zugang zur eigenen desktop-version gesperrt hat, damit alle ihre mobilen gerätschaften verwenden müssen und dadurch quasi gezwungen werden, sich in die mehrzahl der leser zu versetzen und die kommende ‘bedeutung’ von mobile zu verstehen.

ich glaube als experiment machen sie da etwas sehr richtiges, aber ich bin mir ziemlich sicher, dass sie daraus die falschen schlüsse ziehen werden, weil sie bei ihren bestehenden grundsätzlichen annahmen bleiben werden. und die axiomatische annahme aller verlage ist, dass es einerseits eine grundstätzlich gegebene nachfrage nach journalistischen inhalten gibt und dass sie andererseits die gottgegebenen produzenten ebendieser journalistischen produkte sind.

diese im papierzeitalter quasi seine perfekte realisation gefunden habende natürliche ordnung erlebt aus diesem blickwinkel zuerst mit dem internet/web und dann mit mobile zwar eine krise der verkauf- und verwertbarkeit, aber die struktur der ordnung selbst wird nicht in frage gestellt. wer kein zeitungspapier mehr liest, der hat vor 10 jahren die zeitung als startseite im browser gehabt, mehr web braucht man nicht; und wer kein zeitungsportal mehr liest, der verwendet google um zeitungsartikel zu finden oder facebook, um sich von den freunden zeitungsartikel empfehlen zu lassen und darüber zu diskutieren; und wer nur noch ein handy hat, der verwendet es um sich in der strassenbahn oder im park mit zeitungsartikeln über die geschehnisse zu informieren.

das medium, wie die leserschaft das eigene angebot konsumiert, wandelt sich und die aktuellen trends (omg, mehr und mehr mobile) erkennt man im analyse-tool der wahl, aber die struktur und die aufgabe resp. position der beteiligten parteien bleibt konstant.

für die zeitungsmacher ist zu jedem zeitpunkt ganz klar, dass sie der fixpunkt sind, um den die welt sich dreht. und der typische deutsche verleger geht zusätzlich auch noch davon aus, dass ihnen google, facebook und twitter einfach alles zu verdanken haben, dass leute nur auf google gehen, um die verlagsinhalte zu finden, dass leute nur auf facebook und twitter gehen, um dort verlagsinhalte zu teilen, usw. (aus dieser sicht sind so dinge wie das leistungsschutzrecht oder die forderung nach 11% vom umsatz von google zumindest nicht mehr wirr oder wahnhaft, sondern einfach kontrafaktisch grundbegründet.)

die neuen umstände werden also immer nur als fragen der form und der distribution und der monetarisierbarkeit behandelt, was nicht gestellt wird, ist die frage nach dem eigenen sinn und den neuen umständen selbst. aber der eigene sinn ist vielleicht fragiler, als nicht nur von ihnen angenommen wird.

was wie eine evolution von ‘trends’ im konsum von nachrichten ausschaut – leute lesen sie zuerst auf papier, dann auf dem portal, dann auf facebook, dann auf dem handy – müsste nämlich eher als ganz grundsätzlich neuentwicklung des gesamten ‘dispositivs’ unter grundsätzlich neuen bedingungen bewertet werden, für das alles andere als klar ist, was dort funktionieren kann und wie das funktionieren wird. die welt versucht gwm. gerade herauszufinden, wie sie ausschauen würde, wenn es das web und mobile immer schon gegeben hätte.

man kann aber fast davon ausgehen, dass der ‘journalismus’ wir wir ihn kennen retrospektiv betrachtet eher wie ein historischer zufall ausschauen wird, als wie eine gegebenheit, die nur ein zeitgemäßes gefäß suchen muss. man braucht ja nur die perspektive auf die entwicklung zu wechseln: leute haben zeitungen nur solange gelesen, solange es nichts gab, was leichter und gleichzeit gut genug war (online portale); und leute haben die zeitungsportale nur solange als startseite benutzt, solange es nichts gab, was leichter und gleichzeitig gut genug war (facebook); und auf facebook nehmen die leute die nachrichten bestenfalls noch hin, ein bisschen informiert werden und synchronisation mit der welt ist ja nicht schlecht, aber sie sind doch nicht der grund, um auf facebook zu gehen, die leute interessieren sich für sich selbst und ihre bekannten und verwandten; anders gesagt: zeitungen konnte es nur deshalb geben, weil es damals noch kein facebook gab.

und die radikalste transformation deutet sich natürlich gerade mit dem übergang zu mobile an, weil damit zwar auf der einen seite ein universeller und permanenter zugang für alle gegeben sein wird, gleichzeitig aber ganz grundsätzliche begrenzungen der komplexität des ‘rezipierten’ etabliert werden, die aber natürlich immer noch gut genug sein werden.

die leute waren gwm. jahrzehntelang zu ihrem journalistischen ‘glück’ gezwungen, aber sie haben jede möglichkeit zu was einfacherem auch immer sofort genutzt, sobald sie sich ergeben hat. der journalismus in der uns bekannten form ist also eine reine historische kontingenz, die zwar gesellschaftlich wünschenswert ist, aber niemanden wirklich interessiert.

selbst beim am weltgeschehen interessierten bildungsbürger ist die disposition grundsätzlich anders, wenn er eine mobile gerätschaft verwendet. auch wenn es theoretisch natürlich möglich ist, auf dem iphone täglich ein potpourri an kritischen, gesellschaftspolitischen, analytischen longreads zu lesen, die form und die disposition verstärkt natürlich alles snackbare und unmittelbar intensive, also die snapchats und whatsapps, die vines und instagrams, die tweets mit animierten katzengifs.

(nur am rande: gerade deshalb ist es so absurd, dass die verlage mit aller gewalt gegen google kämpfen aber apple und facebook in den arsch kriechen, weil google gwm. der einzige kanal ist, über den sie intentional offene, weil eben genau nach dem thema suchende besucher bekommen. alles was sich über sharing aufschaukelt oder ausdifferenziert ist zwar viel ‘erfolgreicher’, muss aber auch mit einem gähnenden wegwischen nach 2 sekunden rechnen)

aber um zur ausgangsthese zurückzukommen: die frage ist natürlich, was die richtigen schlüsse auf das experiment der nyt sein könnten. und das wird ein harter knochen, weil das baumaterial nur der sinn sein kann.

FYI 013

fyi: thesen über die wirksamkeit vom web muß man weder vermuten noch begründen oder beweisen, man braucht nur auf ein funktionierendes beispiel zu zeigen.

(gibt es kein empirisches beispiel ist das üblicherweise kein schlechter hinweis darauf, dass eine annahme nicht stimmt; das web ist also weniger ein spekulatives und/oder utopisches medium, sondern ein materialistisches)

Durchschnittlichkeit und Zufriedenheit

‘mögen deine wünsche in erfüllung gehen’ ist ja einer dieser chinesischen flüche, die sich früher oder später besonders hinterlistig bewahrheiten – und am umstand, dass es durch das vom web bedingten unbundling und microchunking zu einer strukturellen krise der durchschnittlichkeit, besonders zu einer krise des durchschnittlichen textes kam, ist vielleicht einer der hinterlistigsten bewahrheitungen.

wir erinnern uns: neben dem hypertext, also der möglichkeit zur vernetzbarkeit von texten, was der grundsätzlichen kern vom web ist, war die damit verbundene entkoppelung der textfragmente von ihrem kontext, die das freie flottieren und beliebige rekombinieren und reaggregieren von texten, informationen, gedanken und also ein genuin neues dispositiv ermöglicht, die zentrale metapher und wunschvorstellung für die zukunft von text.

was auf semiotischer ebene jedoch wie ein paradies klingt, hat nicht mit den psychologischen resp. infoökonomischen nebeneffekten gerechnet.

ganz allgemein gesagt sind menschen relativ unkomplizierte und leicht zufriedenzustellende lebewesen, die mit durchschnittlichkeit gut leben können, solange das gesamtpaket stimmt. ein, zwei goodies reichen aus, um der gesamten restlichen durchschnittlichkeit zumindest den notwendigen hauch von wertigkeit zu verleihen.

(durchschnittliches als angenehm empfinden zu können ist übrigens alles andere als ungeschickt, weil es nicht nur naturgemäß viel mehr durchschnittliches als besonderes gibt und man sich also über viel mehr im leben freuen kann, sondern weil das durchschnittliche in den allermeisten fällen auch völlig ausreicht. dieser von der werbung erzeugte wahn immer nur das allerbeste zu wollen ist aber ein völlig anderes thema).

bündel und pakete sind jedenfalls notwendige formen, uns viele durchschnittliche einzeldinge als angenehm wahrnehmen zu lassen und uns zufrieden zu stellen. bricht man die bündel jedoch auf, liegen die dinge plötzlich isoliert vor uns und müssen also einzeln beurteilt, bewertet und empfunden werden. das hat natürlich gegenüber dem bündel einen riesigen vorteil – man kann sich die rosinen aus dem kuchen picken (wenn man rosinen mag, ansonsten kann man sich den kuchen aus den rosinen picken), es hat aber auch eine ganze reihe an nachteilen. die notwendigkeit plötzlich alles einzeln beurteilen, bewerten und empfinden zu müssen ist nicht nur aufwendig und belastend, die davor geniessbare durchschnittlichkeit verliert entbündelt sogar ganz grundsätzlich den zugang zu diesem naiven genuss und muss sich plötzlich die frage gefallen lassen, warum man nun gerade es und nicht etwas anderes lesen soll, usw.

die zwei paradigmatischen formate, die mit dem internet entbündelt und in die einzelnen bestandteile zerlegt wurden, sind natürlich zeitungen und LPs.

bei LPs sind die effekte jedem musikliebhaber bekannt: das snacken nur an den ‘besten’ songs eines albums ermöglicht zwar viel mehr streuung, discovery und durchschnittlich eine viel höhere einzelintensität der gehörten tracks, aber es geht auch der persönliche bezug verloren, den man etwa in den kleinen aha momenten entwickelt, wenn ein song, den man bis dato völlig ignoriert hat, plötzlich der lieblingssong eines albums wird usw. (natürlich funktioniert das nur bei alben, die wirklich als solche bestimmt sind und denen das auch gelungen ist, aber guten musikern gelingt das oft). das vermeiden der durchschnittlichkeit und die erhöhte intensität der einzelstücke macht gleichzeitig den hörer selbst unzufriedener, weil er fortan immer auf der suche nach etwas besserem sein muss. die sehnsucht nach dieser bindung an etwas vorgegebenes erkennt man ja am comeback von vinyl.

und bei zeitungen sind die effekte allen ausser den zeitungsmachern bekannt: ein davor wirklich großartiges papierbündel zerfällt zu einem losen haufen an artikeln, die fast alle durchschnittlich und nicht besser oder schlechter als die artikelhaufen aller anderen zeitungen sind und für den leser also eine einzige infoökonomische zumutung sind (für den übergang vom wertvollen bündel zum wertlosen haufen können die zeitungen nichts, ihre plötzliche wertlosigkeit war gwm. höhere gewalt; woran sie allerdings selbst schuld sind, ist, dass sie die situation und ihre position nicht verstehen, den kopf in den sand stecken und dort dann versuchen, ein liedchen zu pfeifen). die wirklich einmaligen artikel, die eine zeitung an einem tag erzeugt, die man also nicht gleichwertig überall sonst findet, dürften sich im einstelligen, bei wochenzeitungen vl. im zweistelligen bereich befinden und die muss man natürlich auch erstmal finden.

aber interessanter als die krise der texte der zeitungen ist der umstand, dass dieses verhältnis jede art an text betrifft und sich früher oder später also direkt in den text selbst einschreibt. es hat eine zeit lang gedauert, bis wir das bemerken können, weil sich natürlich auch die produktions- und rezeptionsbedingungen anpassen müssen, durch die verstärkung dank social media wird die logik jedoch langsam sichtbar:

damit durchschnittliche texte, die bisher ein perfekt feines dasein als füllstoff führen konnten, im haufen aller aufgelösten artikel aller einen funken wert behalten können, müssen sie jetzt auf irgendeine art auch isoliert und autonom funtionieren. und dafür gibts zwei primäre möglichkeiten: entweder sie stiften selbst ‘sinn’ für den leser, enthalten zumindest etwa eine nützliche information; oder sie erzeugen eine ‘erregung’, also das kompakte gefühl eines lols, oder wins, oder omgs, oder cutes, oder fails, oder wtfs.

und woran erkennt man, ob ein text ‘sinn’ oder ‘erregung’ erzeugt? genau, er wird geshared. wenn ein text im web von niemandem geshared wurde, wurde er dann überhaupt geschrieben? der verbliebene wert von durchschnittlichen texten im zustand der entbündeltheit zeigt sich also in der sharebarkeit.

das ding jetzt ist natürlich, dass sinn nicht nur viel schwerer zu produzieren ist, es erfordert auch viel mehr aufwand vom leser, ihn zu erkennen, und es ist auch viel riskanter ihn zu sharen. und dass erregungen andererseits nicht nur viel leichter erzeugt werden können als sinn, erregungen können auch viel schneller aufgeschnappt werden und erzeugen also auch viel eher anschlusskommunikation und selbstverstärkung in den sogenannten erregungswellen. ich habe oben die lols, wins, omgs, usw. als qualifizierer von erregungen nicht zufällig von buzzfeed zitiert – sie zeigen, wie präzise buzzfeed diese logik schon vor langem erkannt hat und deshalb nur noch genau diese art von texten produziert. buzzfeed ist eine maschine zur produktion und distribution der letzten durchschnittlichen texte, die noch verwertbar sind.

die zeitungen, zumindest die qualitätszeitungen, haben nun natürlich das problem, dass sie in ihrem selbstverständnis die produzenten vom sinn sind und die produzenten von erregungen gwm. verachten müssen und sie sich dadurch quasi auf diese eine position festlegen; gleichzeitig produzieren sie natürlich in realität deutlich mehr (unsharebaren und austauschbaren) fülltext als sonstwas, erzeugen also viel weniger leistung, als sie es in ihrer selbstwahrnehmung glauben; nur müssen sie auch ihren kollegen von buzzfeed dabei zuschauen, wie die ganz ungeniert eine wissenschaft der verpönten sharebaren erregungen entwickeln können und ihnen die PIs, die aufmerksamkeit und die werbegelder und fast den ganzen kuchen wegknabbern.

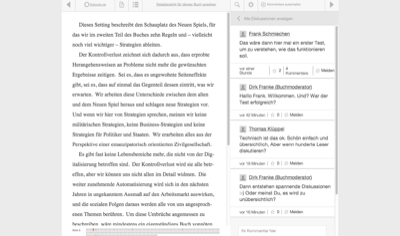

von dieser logik sind natürlich auch die blogs betroffen. auch die konnten in den ersten 10, 15 jahren gut mit durchschnittlichem fülltext leben, weil es mehrere kontexte gab, die den fülltext im ‘bündel’ rezipierbar machten. einerseits gab es (imaginierte) communities wie antville oder twoday, andererseits gab es feedreader wie den google reader oder netvibes, die die abos der feeds zu einer personalisierten superzeitung rekontextualisierten. im aufgelösten zustand haben blogs aber das gleiche problem wie die zeitungen: die durschnittlichen posts, wenn wir ehrlich sind also fast alles was wir produzieren, sind im haufen aller posts aller völlig wertlos. im grunde gibt’s dann nur 2 strategien: man produziert selbst shareables (socialismus), oder man erzeugt sich seinen eigenen kontext im eigenen gesamtwerk und tut so als wär das jetzt so (solipsismus). wem das eine zu blöd und das andere zu anstrengend ist, der hört dann halt auf zu bloggen und wechselt vielleicht zu einer plattform wie tumblr oder medium, wo man ein bisschen kontext von der plattform spendiert bekommt und gleichzeitig in die eine oder andere richtung ‘gelenkt’ wird (erregung bei tumblr, sinn bei medium).

(überhaupt ist es natürlich nicht so, dass der durchschnittliche text seine funktion für immer verloren hat. ich habe das nur nicht betont, weil ich sonst jeden punkt relativieren hätte müssen, und dann aber auch die relativerungen relativieren hätte müssen, weil sie auf tektonischer ebene trotzdem wieder egal wären, es hätte alles jedenfalls unnötig verkompliziert. aber die entbündelung hat nicht nur opfer, sondern erzeugt naturgemäß auch einen neuen möglichkeitsraum für tools, plattformen, communities (fast alle funktionierenden tun das letztendlich) etc. dafür, eigene, neue kontexte für text zu erzeugen, innerhalb derer dann auch die durchschnittlichen texte wieder einen platz bekommen können, ohne dass diese sich selbst beweisen müssen. wie fast immer kann man sich einfach anschauen, was funktionert.)

nur am rande beobachtet ist doch lustig, dass wir gerade mit der krise der durchschnittlichkeit den von den poststrukturalisten vor 50 jahren diagnostizierten verlust der autorschaft konkretisiert bekommen. nur, wie so oft, kommt es anders als damals gedacht: die neuen kleinformate transzendieren nicht nur den autor, sie schreiben sich wörtlich genommen tatsächlich selbst und brauchen die readaktionellen prozesse inklusive aller beteiligten menschen und software nur noch als organisatorische struktur. moderne redakteure tun ja im grunde nichts anderes als texten eine erste form zu geben und diese dann solange anzupassen, bis die roten lämpchen, die auf schlecht formulierte überschriften, hohe absprungraten nach dem ersten satz, falsche keywords, geringes sharementum, etc. hinweisen, nicht mehr rot blinken und der text also seine objektive form gefunden hat. paradoxerweise sind es deshalb ausgerechnet die roboterjournalisten, die den ethischen anspruch auf autorschaft am reinsten repräsentieren.

598425890696073216 Revisited

wirklich unbehagen bereitet mir übrigens der gedanke, dass sie das web gutmeinend verschlimmbessern, um mit apps um marktanteile zu kämpfen.

— Markus Spath (@hackr) May 13, 2015kl. nachtrag zu 598425890696073216 – zumindest eine erste iteration, die sich lustigerweise aus der überschneidung mit einem anderen tweet ergibt, den ich am gleichen tag aber in einem völlig anderen kontext (verizon schluckt aol) getwittert hatte:

(ich war damals ja eher compuserve)

— Markus Spath (@hackr) May 13, 2015um die zwei tweets zusammenzubringen, sollte ich zwei dinge erwähnen:

(1) einer der größten, wenn nicht der größte im allgemeinen ausgemachte feinde des offenes webs sind projekte wie facebook zero oder internet.org, also konstrukte, die ein kontrolliertes subset an webseiten oder apps kostenlos offerieren, um der nächsten milliarde menschen zugang zum internet zu ermöglichen. was sich als akt der nächstenliebe gibt, ist jedoch, so die verteidiger des offenen webs unisono, nichts anderes als die ausbeutung ökonomischer benachteiligung, die nur neue user einfangen und an sich binden und damit das eigene wachstum anheizen will, also digitaler imperialismus (und wem das nicht reicht nachtürlich auch eine freche verletzung der netzneutralität, aber um das geht es hier nicht). und ihr plan geht auch noch auf, viele der so angelockten glauben dann sogar, facebook sei das internet. statt im offenen web zu publizieren, verkaufen sich diese armen seelen an facebook und landen im vorraum zur hölle.

(2) compuserve war anno dazumal, also plus/minus vor 20 jahren, neben aol die einfachste möglichkeit, mit einem macintosh zugang zum internet und email zu bekommen. es gab auch schon einige websites und der netscape navigator war gerade neu und hip, aber ein grosser teil des nutzens war zunächst das angebot, das compuserve bereitstellte. über die uni hatte ich dann bald auch ein bisschen webspace und zugang zum usenet und unter der ägide von hotwired und webmonkey dann irgendwann auch ein rudimentäres verständnis von html und framesets, aber die möglichkeiten von compuserve hat meine erfahrung mit dem internet in den ersten jahren weitgehend dominiert. und auch wenn ich dann quasi das web ‘mitbegleitet’ habe, bis zu meinem eigentlichen knacks im kopf dauerte es dann weitere 10 jahre.

der punkt dieser zweiten, zugegebenerweise schon etwas verstaubten geschichte ist, dass die erste geschichte nicht notwendigerweise den dystopischen verlauf nehmen muss, von dem alle ausgehen. wer in einem geschlossenen garten aufwächst, muss nicht notwendigerweise den rest seines lebens darin verbringen. menschen können lernen und zusammenhänge verstehen. manchmal fehlt nur eine einzige information. wer heute zb. glaubt, dass facebook das internet ist, dem muss nur einer einmal zeigen, dass das nicht der fall ist, sondern dass facebook im besten fall ein nützlicher und in jedem fall ein grosser wal in einem riesigen ozean namens web ist, das man mit etwas entdeckergeist dann selbst erforschen kann (ob das dann angenommen wird und denjenigen interessiert ist eine andere frage). und wir brauchen gar nicht so betroffen tun, noch vor 10 jahren haben hierzulande die meisten geglaubt, dass das internet dieses blaue ‘e’ am desktop ist.

ich will mit dieser anmerkung nicht die grundsätzliche korrektheit der kritik an facebook (und co) kritisieren und ich will die machenschaften von facebook (und co) weder relativieren noch legitimieren. was sie abziehen ist unterm strich eine riesige sauerei, vor allem deshalb, weil sie es auch ganz einfach auch anders andenken und umsetzen hätten können.

der fehler liegt nicht in der vorgetragenen kritik, sondern in der analyse und der bewertung, was das bedeutet. und eine hysterische bewertung (es ist ganz eindeutig das endgame, wenn wir jetzt verlieren, dann ist das offene web verloren, usw.) führt zu einer hysterischen überreaktion, die dann, wenn wir pech haben, mehr schaden anrichtet als der feind, wegen dem man überhaupt erst losgelegt hat.

(interessanterweise teilen die protagonisten eines offenen webs, hier fortan stellvertretend mozilla, und die ideologisch mehr oder weniger aus der gegenteiligen ecke kommenden verlage diesen schaum vor dem mund, wenn sie es mit google oder facebook oder apple zu tun bekommen; aber lassen wir hier die verlage einmal beiseite)

der allgemeine fehler von mozilla ist, vom offenen web kein ‘sinnverständnis’ zu haben, sondern den sinn in der vorhandenheit selbst zu sehen, was bedeutet, dass sie den erzeugten wert also nur am marktanteil messen können. alles, was von facebook (und co) aufgesaugt wird, ist ein verlust und die masse des von facebook aufgesaugten ist eine katastrophe. als reaktion bleibt ihnen also nur der ‘kampf’ um marktanteile und als grund für die beliebtheit von facebook (und co) ist ihnen leider nur eingefallen, dass der offene stack technisch unterlegen ist, was nur bedeuten kann, dass sämtliche apis der geschlossenen plattformen nachgebaut werden müssen, siehe den kleinen überblick ihrer aktuellen interventionen.

(man erkennt auch die wiederholung eines musters: als das soziale web der katalysator für das wachstum war, wurde im ‘social graph’ von facebook der zaubertrank gesehen, und die damalige erwartung war, dass man den nur offen nachbrauen muss, dann wird alles gut. wir erinnern uns an projekte wie open social, friend connect, portable contacts, chi.mp, diaspora, usw.)

der spezifische fehler in hinblick auf die ‘emerging markets’ neuer user, die gleich mit dem smartphone einsteigen, ist, dass die entwicklung als lineare, technik-getriebene evolution vom statischen über das soziale hin zum mobilen web gesehen wird, und den menschen innerhalb dieser entwicklung keine subjektivität oder möglichkeit zum widerstand oder zur reinterpretation zuzutrauen. wir sehen es ja bei uns, da kleben die jungen ja nur noch an ihren handys und chatten oder posten selfies statt zu bloggen oder die wikipedia zu verbessern. was wir bei uns erleben ist aber weniger eine evolution, sondern eine angleichung an das ‘natürliche’ kommunikative gleichgewicht unter den bedingungen vom mobilen internet, das halt erst jetzt möglich geworden ist, aber immer schon so veranlagt war. die phasen waren also, wenn man so will, in ihrem historischen ablauf notwendig, weil wir uns immer kollektiv an das gerade technisch machbare angepasst haben, aber einmal vorhanden verhalten sie sich, als wären sie immer schon da gewesen.

aber die technische ebene ist ja nicht die einzige. auch interessant ist mitunter, wie sich die technik / das web auf gesellschaftlicher ebene auswirkt – und da macht das narrativ der evolution einen u-turn. da sind dann plötzlich die apps des mobilen webs die primitive form, die halt (natürlich massenweise) private kommunikationsereignisse ermöglichen, die aber weder für die öffentlichkeit bestimmt noch für die gesellschaft nützlich wären. erst mit dem offenen und sozialen web bekommen wir einen viel interessanteren hebel, um gesellschaftliche probleme zu behandeln und gemeinsame lösungen auf sozialer sinnebene zu finden.

und hier muss man der kommenden ‘mobilen milliarde’ einfach zutrauen, dass sie ihre eigene entwicklungsgeschichte durchmachen und dabei vl. auf einem viel höheren niveau landen, als wir es bis dato geschafft haben, oder aber auch nicht. sie beginnen zwanzig jahre später und das dauert sicher ein bisschen zeit, aber der umstand, dass sie bei unserem ‘ende’ beginnen bedeutet eben nicht, dass sie dort bis in alle ewigkeit braten müssen.

(man erkennt übrigens die wiederholung eines weiteren musters: als etwa das ipad vorgestellt wurde, haben es die vertreter des offenen webs als zynische und infantilisierende konsumationsmaschine wahrgenommen und die kollektive volksverblödung befürchtet, siehe das offene web und seine feinde. gekommen ist es natürlich anders, nur das mangelnde vertrauen in die systemkraft der eigenen offenheit und die kreativkraft der menschen ist ihnen leider geblieben)

Quiz Pt. 97 Solution

Warum fällt es der Indiecrowd so schwer zu verstehen, dass sie es sind, die das materialistische/warenfetischistische Verständnis von Daten haben, und nicht die Plattformen?

Ich bin euch ja noch meine Antwort auf Quiz Pt. 97 schuldig:

Ich glaube die Wurzel des Nichtverstehens liegt in den tendenziell linken/liberalen Werten der Indiecrowd – dem Glauben an Offenheit, Freiheit, Gerechtigkeit, Autonomie, Demokratie, Bürgerrechten, Datenrechten, usw. Damit ausgestattet werden sie wiederholt mit Plattformen konfrontiert, auf denen Menschen Dinge tun und die mit hunderten Millionen, manche sogar mit dutzenden (Twitter) oder hunderten (Facebook) Milliarden bewertet werden.

Das weckt natürlich die Neugier und wenn man sich fragt, wo der Wert denn herkommt, wer ihn erzeugt, wer davon u.u. unrechtsmäßig profitiert, usw., dann landet man schnell bei der Diagnose, dass es – und ich beziehe mich im folgenden exemplarisch auf Twitter, das Prinzip lässt sich aber leicht auf die meisten anderen Plattformen übertragen – ein Produkt gibt (den Tweet), das von ganz offensichtlich unbezahlten Arbeitern produziert wird (den Usern), was in der Summe ein aggregiertes Ganzes ergibt, dessen Mehrwert sich die Betreiber dann fürstlich bezahlen lassen.

Ist man gedanklich einmal bei diesem Ausbeutungszusammenhang gelandet, kommt man nicht nur schwer wieder davon los, es beginnt auch eine Art warenfetischistische Überbewertung des Produktes Tweet. Sprich: der Tweet selbst wird als viel wichtiger und bedeutsamer und wertvoller imaginiert, als er eigentlich ist (in 98,2% aller Fälle ist es ein in 20 Sekunden abgesetzter Blurb mit 80 Zeichen und zwei Hashtags und/oder einem Link und/oder 6 Emojis).

Es wäre sicherlich interessant, sich die Arten der Übertragungen und Projektionen etwas genauer anzuschauen – mitunter geht es um Fragen der Kontrolle, vom Besitzanspruch, von der sogenannten Hoheit über die eigenen Daten, um die Ströme und Reaggregierbarkeit, usw. – hier relevant ist aber nur, dass der Tweet fortan als Ware und also die eigene Aktivität als Arbeit und also das Verhältnis als Ausbeutungsverhältnis konzipiert wird und dass man sich in dieser Schlinge umso mehr verfängt, je mehr man sich darauf fixiert.

Mein Vorschlag zur Kur wäre, Tweets nicht länger als Produkt mit einem (ohnehin nur solipsistisch imaginierten) Wert zu konzipieren, den dann ein anderer abschöpft, sondern funktionalistisch als Abfälle kommunikativer Akte zu verstehen, mit denen man Dinge erreichen will und/oder kann.

Man twittert aus reinem Egoismus, weil man seine Bekannten und Verwandten mit dem eigenen Geistesblitz beglücken möchte, weil man die Welt unbedingt über den letzten grenzgenialen eigenen Blogeintrag informieren möchte, weil man eine schnelle Frage hat auf die wohl einer aus der geneigten Verfolgschaft eine Antwort hat, uswusf.

Und man liest die Tweets der Anderen aus reinem Egoismus, weil es einen mit dem bekannten sozialen 6ten Sinn versieht, weil man über Ereignisse fast in Echtzeit informiert wird, weil man eine Injektion an Serendipity bekommt, die sonst kaum möglich wäre, weil man ein genuines Interesse an den Mitmenschen hat, etctrara.

Das Problem der Indiecrowd ist also grundsätzlich, dass sie gelegentlich bürgerliche Eigentums- und die damit verbundenen Kontrollverhältnisse konstruieren und darauf bestehen, wo es eigentlich um Kommunikationsverhältnisse geht und wo deshalb auf diese Kommunikationsverhältnisse optimierte Plattformen, auch wenn sie noch so geschlossen sind (funktional sind die meisten ohnehin offen), den auf Eigentums- und Kontrollverhältnisse optimierten Indieplattformen in der Gunst der Benutzer bei weitem überlegen sind. Benutzer verhalten sich üblicherweise halt funktional rational und nicht asketisch ethisch.

(nur zur sicherheit wie immer als faustregel: sei so indie wie möglich!!11 und backe alles up; aber beharre nicht auf dem indie wo es mehr schadet als nützt oder wo es irrelevant ist)

Lazy Blog Ep. 47

(blogpost über DAS fundamentale dilemma im derzeitigen web: den umstand, dass öfter als nicht das gesamte ‘web’ als beobachtungs- und bewertungsebene für dinge ausgemacht wird)

((was leider eine sinn- weil diskriminationslose abstraktionsebene ist, weil das web keine ontologische substanz ist oder hat, in der irgendwas stattfinden kann, sondern bestenfall die aggregierte summe aller einzelereignisse ist, die auf allen jeweils konkreten plattformen halt stattfinden. das zu unterscheiden ist deshalb wichtig, weil es eben keine allgemeine logik des webs gibt, sondern nur konkrete einzellogiken konkreter plattformen, die aber mitunter auch völlig verschieden sein und verschiedenste dynamiken triggern können))

(((nur als kleines beispiel, weil wir das in letzter zeit häufiger hören: die aussage ‘im web werden die umgangsformen immer barbarischer’ klingt zunächst völlig plausibel; man muss schon ein sehr behütetes dasein führen, wenn man noch nie über kommentare gestolpert ist, wo man sich nur fassungslos fragen konnte, wo man denn da gelandet ist. und gefühlsmässig weitet sich das tatsächlich auch in bereiche aus, die vor einigen jahren noch nicht betroffen waren. es breitet sich also aus, im netz, und da muss man was gegen tun.

das ding ist halt: die kommunikationskultur ist kein abstraktes phänomen, das im web seine ausdruckskraft sucht, kommunikationskultur entsteht immer nur als konkretes produkt auf konkreten plattformen. die gute nachricht dabei ist, dass sich damit das problem sofort zerteilt und dass es also viel leichter ist, die ‘pathologischen’ ereignisse auf plattformen zu isolieren und zu versuchen zu verstehen, was bei ihnen warum ‘schiefläuft’. die schlechte nachricht ist, dass trotzdem immer auch plattformen betroffen sein können, die das wirklich nicht wollen (etwa die kommentarspalten der qualitätszeitungen), oder die eingebaute verstärkungseffekte haben, die das ganze also auch noch multiplizieren (etwa facebook). die gute nachricht ist wieder, dass man das verständnis der plattformdynamik in die bewertung hinein fakturieren kann und man die tatsächliche signifikanz vl. realistischer versteht. die schlechte nachricht ist, dass man sicher auch gelegentlich plattformen gwm. abschreiben bzw. aufgeben muss, zumindest was die erwartungshaltung einer idylle zum erzeugen von kommunikativer vernunft betrifft (was nicht heisst, dass eine solche nicht auch stattfinden kann, das kann sie immer; nur stellen sich plattformen im konkreten gebrauch früher oder später als mehr oder weniger resilient heraus). was als gute nachricht nochmal die einschätzung des stattfindenden diskurses verbessert; das ist übrigens deshalb wirklich wichtig, weil das übliche hysterische skandalisieren oft selbst mehr schadet als nützt.

jedenfalls ist es wichtig im hinterkopf zu behalten, dass der kommunikative umgangston kein symptom vom web ist, sondern immer das symptom einer konkreten plattform, die halt im web ist, aber immer neben allen anderen plattformen steht, die halt auch im web sind und ihre eigenen verhältnisse und dynamiken und umgangstöne erzeugen. es gibt zum glück ja auch viele, die wirklich angenehm funktionieren. der gedanke ist übrigens auch dann nützlich, wenn man sich überlegt, wie man kommunikativ resiliente oder sogar antifragile plattformen bauen könnte)))

(bonuspunkte also wie immer für konkrete fallstudien und sternchen für eine umfassende typologie)

Sauerkrauts Revolutions

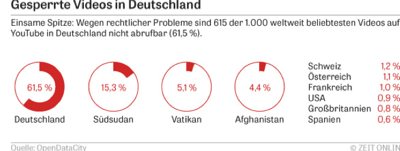

Warum ist Deutschland in allen Dingen Web so daneben?

Ich bin euch ja noch meine Antwort auf Quiz Pt. 61 schuldig.

Und die ist: wegen den Deutschen.

——

Derzeit gibt es wohl zwei dominante Kulturformen, die das allgemeine sozio-technologische Potential einer ‘Gesellschaft’ reflektieren:

(1) das Fernsehen

(2) das Web

Beide Formen sind hochgradig komplex (duh) und auf vielfältige Weise mit mehreren anderen gesellschaftlichen Subsystemen verwoben (duh). Beide sind nicht als Produkt, sondern nur als systemisches Bündel an Produktions-, Rezeptions- und Distributionsbedingungen, die alle selbst wiederum in den verschiedensten systemischen Abhängigkeiten zu Bildung, Technologie, Finanzierung/Kapital, Politik/Recht, etc. stehen, zu verstehen.

Das gesellschaftlich mögliche Potential beider Felder entsteht als Equilibrium im Zusammenspiel der jeweils beteiligten Strukturen, wobei es innerhalb dieses Equilibriums nur beschränkt die Möglichkeit zum ‘Ausbruch’ nach oben gibt.

Sprich: es ist nicht möglich, in einer Kultur einfach schnell mal besseres Fernsehen zu machen, oder einfach schnell mal bessere Startups zu erzeugen, indem man sie ein bisschen fördert oder in Schulen C++ unterrichtet. Will man sich verbessern, muss man das Niveau des Gesamtsystems erhöhen, was nur gelingen kann, wenn man das Zusammenspiel versteht.

(was es allerdings gibt, sind lokale maxima und talente, die auch in anderen milieus funktionieren könnten. ein harald schmidt war in seiner hochzeit mitunter sogar besser als ein david letterman; ein stefan raab macht – egal ob man ihn mag oder nicht – unterhaltsames fernsehen, das in dieser form woanders gar nicht möglich wäre; ein christoph waltz kommt in hollywood überhaupt erst zur entfaltung; usw.)

Spielen wir das nur mal als Milchmädchen frei assoziativ mit Fernsehserien durch: Es gibt die Ebenen der Produktion, die einerseits mehrere kulturelle Gebiete wie Schauspiel, Literatur/Drehbuchschreiberei, Musik/Ton und Regie/Kamera integriert, aber natürlich auch alle anderen Aspekte einer Produktion wie Schnitt, Casting, Kostüme, Bühnenbild und Set Design, Postproduktion und Special Effects, etctrara beinhaltet. Dann gibt es die Ebene der Kritik und der Rezeption, also wie viele Leute es anschauen, welche Leute es anschauen, was von Kritikern oder Sehern darüber gesagt und geschrieben und gevloggt wird, welche Themen oder Charaktere sich ins kulturelle Unbewusste einprägen, welche Bilder oder Themen davon zu zirkulieren beginnen, auch welche Veranstaltungen es dazu gibt (Comic-Con, Bambi), usw. Und es gibt natürlich die Ebene der Finanzierung, Distribution, Vermarktung und Ausstrahlung, also dem Gewebe an öffentlichen und privaten Fernsehanstalten, an Produktionsfirmen, an Programmverantwortlichen, Showrunnern, Werbenden, usw, die auch wiederum alle in unterschiedliche Strukturen mit unterschiedlichen Rahmenbedingungen eingebettet sind.

(nicht jede erwähnte und vergessene schraube wirkt sich sofort auf alle anderen schrauben aus, d.h. es gibt schon grössere und kleinere abstraktionen, aber vieles hängt mit vielem anderen mehr oder weniger direkt zusammen)

Für jede der beteiligten ‘Positionen’ gibt es offizielle oder inoffizielle Bildungswege, Werdegänge und Verfahren der Besetzung (gewerkschaftlich, meritokratisch, nepotistisch, etc.). Und auf jeder Ebene werden sich formelle oder informelle Prozesse etablieren und ausdifferenzieren. Und das Zusammenspiel von allem etabliert dann eben halt das jeweils konkrete gesellschaftliche Gesamtmilieu.

Hier ist nun das Ding: dieses Gesamtmilieu definiert weitgehend einerseits die durchschnittlich erwartbare minimale Qualität von Produktionen und andererseits die maximale Höhe der Idealproduktion. In einer Kultur mit hohem Gesamtmilieu ist nicht nur jede durchschnittliche Produktion viel besser als jede durchschnittliche Produktion aus einer Kultur mit niedrigerem Gesamtmilieu, in einer Kultur mit hohem Gesamtmilieu sind auch die Spitzen (die The Wire’s, die Breaking Bad’s oder die Jon Stewart’s) ungleich viel höher, als sie in einer Kultur mit niedrigerem Gesamtmilieu überhaupt möglich sind.

Innerhalb eines (niedrigeren) Milieus fällt das nicht auf, weil alles andere ja genauso mittelgut ist und es eine lokale Verteilung mit lokalen Hits gibt. Die eigene Höhe im internationalen Vergleich spürt man nur, wenn man die eigenen Programme international verkaufen will. Und bei Fernsehserien kann man sich ja leicht ausmalen, wie das Verhältnis von Import zu Export ist.

Ich glaube die Frage, warum es fast unmöglich ist, aus dem lokalen Milieu auszubrechen, wird am Beispiel Fernsehen recht anschaulich: Bei guten TV-Serien (oder auch Reality TV) sind einfach alle Ebenen irre gut; die Schauspieler sind irre gut und die Stories bzw. die Dialoge sind irre gut und die Cinematographie ist irre gut und der Schnitt ist irre gut und die Musik ist irre gut und die ganze Qualität der Produktion ist irre gut, usw. Was bedeutet, dass es diese guten Schauspieler und Schreiber und Regisseure und Kameramänner und Editoren und alle anderen zuerst einmal geben und dass man sie dann auch finden und bekommen muss. Und in Kulturen mit hohem Milieu haben sich diese Prozesse eben zu einem Grad ausdifferenziert, dass es einerseits einen sich permanent nachfüllenden Pool an Talenten gibt, und andererseits Mechanismen die besten zu entdecken und auf die aktuellen Projekte zu mappen. Und weil sich Talent nicht in einem Vakuum entwickelt sondern nur im Benchmark gegen andere wird dieser Pool an Talenten umso besser, je besser er schon ist. Und je grösser und besser der Pool ist, desto eher professionalisieren und spezialisieren sich die Filterprozesse; Aufgaben wie Casting werden überhaupt erst dann ‘als Kunst’ geschätzt und anerkannt, wenn man aus einem vollen Pool schöpfen kann, aber auch weiß, dass es auch alle anderen tun. (deutsches reality tv beginnt üblicherweise mit wirklich lahmem casting, was ihnen in konsequenz dann kein material für subtileres storytelling gibt, sondern halt nur für ein sich akzelerierendes gegenseitiges anschnauzen)

Komponenten beim Web

Mit dem Web verhält es sich grundsätzlich sehr ähnlich. Es gibt die Ebene der Produktion, die mehrere technische/informatische Gebiete wie Systemanalyse, Programmieren, Entwicklung von bösen Algorithmen, Datenbanken, Testen oder Design integriert, aber natürlich auch alle anderen Aspekte eines Projekts wie Projektmanagement, Qualitätssicherung, Administration, Dokumentation, usw. beinhaltet. Dann gibt es die Ebene der Benutzung und der Rezeption, also wie und wie viele und welche Leute es verwenden, was die Blogger oder Benutzer darüber sagen, welche soziale Objekte erzeugt werden und wie sie fliessen können, wie es via APIs o.ä. mit dem Gesamtsystem anderer Dienste zusammenhängt, usw. Und natürlich die Ebene der Leitung, Finanzierung und Vermarktung, also den Gründern und Managern, dem Gewebe an öffentlichen Förderungen und Einrichtungen und Wagniskapital, an Human Resources und Contractors, an Werbenden und zahlenden Kunden, Presse, Kommunikation, Community Management, usw. die auch alle wiederum in unterschiedliche Strukturen mit unterschiedlichen Rahmenbedingungen eingebettet sind.

Und auch hier gibt es für jede der beteiligten Positionen offizielle oder inoffizielle Wege der Ausbildung und Besetzung und auf jeder Ebene eine Ausdifferenzierung formeller und informeller Prozesse zum gesellschaftlichen Gesamtmilieu, das auch hier wieder ganz weitgehend einerseits die durchschnittlich erwartbare minimale Qualität von und andererseits die maximale Höhe der Idealproduktion definiert. Wir kennen die Logik von oben.

Zu erwähnen ist vielleicht, dass es bei Startups natürlich ein viel breiteres Spektrum an Größenordnungen als beim Fernsehen gibt. Es gibt ja tatsächlich Ein-Personen Startups, die gesellschaftlich durchaus signifikante Effekte erzielen können. Und es gibt Probleme, die mehrere Tausend hochgradig spezialisierte Leute beschäftigen können und manche Milieus beschäftigen sogar zehntausende Leute damit alle andern zu überwachen. Der sweet spot für Startups scheint jedenfalls aber ein Kern von zwei, drei Leuten zu sein. Aber ob groß oder klein, alle sind an ihr Milieu gebunden.

Aber es gibt zwei wichtige Unterschiede:

Die Auswirkungen sind gesellschaftlich deutlich relevanter, weil es nicht nur ein Markt für Unterhaltung ist und/oder die Gesellschaft auf symbolischer Ebene tangiert (was natürlich auch nicht zu unterschätzen ist), sondern eben direkt in grundsätzlich alle anderen gesellschaftlichen Subsysteme einwirkt und diese u.u. transformiert, egal ob die das selbst dann wollen oder nicht. Dieses ‘es ändert sich alles’ klingt zwar wie eine blöde Plattitüde, aber es kann ja jeder versuchen sich zu erinnern, wie die Welt vor nur 20 Jahren noch war und es geht natürlich erst los, nur wissen wir noch nicht wohin.

Und die Bedeutung der ‘Rezeption’, also der Feedbackloops mit den ‘Benutzern’, ist nicht nur ungleich höher, sie ist essentiell, weil die Entwicklung neuartiger Dienste nur in Koevolution mit Benutzern möglich ist. Aus den Standardsituationen (aus 2009, also immer 5 jahre dazurechnen):

gerade im und um das internet lagen eigentlich alle schon immer falsch, man braucht nur an die metaphern und visionen von vor 15 jahren denken. niemand hat vor 10 jahren mit wikipedia, google oder blogs, vor fünf jahren mit facebook, youtube oder flickr, noch vor zweieinhalb jahren mit twitter und mit den damit einhergegangenen strukturveränderungen gerechnet, einfach auch deshalb, weil die meisten tools selbst reine zufälle waren, deren effekte noch nicht mal die gründer auch nur erahnten. facebook entstand, weil zuckerberg ein fauler hund war und aufgaben crowdsourcen wollte; flickr war ein abfallprodukt eines online-games; die wikipedia entstand, weil aus der eigentlich angedachten nupedia, die von experten geschrieben werden sollte, nix wurde; twitter war als sms-dienst unter freunden gedacht, den die user dann umfunktionalisiert haben und zu dem gemacht haben, was es ist. wir wissen alle nix und selbst wenn man mit einer aussage/prognose zufällig richtig liegt, dann eher deshalb, weil irgendeine aussage immer stimmt, und nicht weil man es wissen konnte.

(nts: mich öfter selbst zitieren)

Aber der Zufall kommt, das habe ich damals nicht betont, nicht von allein; er entsteht nur in der Dialektik zwischen der Art, wie Leute ein Angebot be- und oft missnutzen und für sich interpretieren, und der Aufmerksamkeit von Gründern, die sich abzeichnende Flüsse wahrnehmen und im Idealfall aufgreifen und damit laufen. Ohne die Neugier der frühen Benutzer entsteht ganz einfach nichts Neues. (Permutationen sind ab einem gewissen Grad des Verständnisses dann natürlich möglich, aber auch die erhöhen im besten Fall die Wahrscheinlichkeit für einen gewissen Erfolg; man sieht das daran, wie wenige Gründer ihren ersten Erfolg dann wiederholen können, auch wenn sie dann deutlich freundlicher behandelt werden, was natürlich auch schon wieder der Grund für das ‘Nichtfunktioneren’ sein kann, weil ihnen der tatsächliche Gegenwind fehlt; VC folgt übrigens einer anderen Logik, die versuchen Wahrscheinlichkeitsverteilungen zu optimieren)

Und das ist dann eigentlich schon das K.o. für rein deutsche Startups in der ersten Runde, die notwendige Dichte an explorativen Benutzern gibt es hier einfach nicht, weil alles Neue zunächst als reine Zumutung wahrgenommen wird, die einen mit einer Vollbegründung erst von ihrem Sinn und Nutzen überzeugen muss, bevor man sich vl. mal zur temporären Benutzung erbarmt. Rationalität und Erbsenzählerei sind in einigen Bereichen nützliche Eigenschaften, als Katalysatoren für Startups sind sie aber ungeeignet. In Deutschland ist sicherlich einiges suboptimal, aber auch Medien und Politik, die zwei größten absichtlichen Bremser, können nichts verunmöglichen was wirklich ans Tageslicht will. Das große Unglück für die deutschen Startups sind die deutschen User.

(wenn das noch nicht reicht, dann kommt in deutschland noch dazu, dass gründungen häufig bwl-getrieben sind, was auch noch die zweite seite der erwähnten dialektik behindert, weil es bei denen im vergleich zu tech-getriebenen deutlich schwerer ist, aufmerksam zu sein und sich mit agilität anzupassen)

Und das bedeutet leider, dass das ganze Standard-Repertoire an von Politikern, Verbänden, Vertretern und Bloggern geforderten Förderungen überhaupt nichts bringt, weil sie im besten Fall ein Problem lösen, das von diesem Grundproblem dann schon im Keim erstickt wird. Die (oft bemängelte) Anzahl an Startups zb. ist ja überhaupt nur dann bedeutsam, wenn es einerseits zu mehr Variation führt und es andererseits auch eine gesellschaftliche Selektionsfunktion gibt, die die potentiell funktionierenden Startups dann entdecken kann. Ansonsten ist das ein reiner crap shoot. (inkubatoren sind die standard-maschine zur erzeugung dieser variation, nur benötigen auch die wieder eine gewisse systemische dichte als katalysator, die üblicherweise durch eine art hunger-funktion erzeugt wird, die es in deutschland eigentlich – zum glück – auch nicht gibt).

(nur zur sicherheit: mich interessieren hier nur native webstartups, die irgendeine neue beziehung oder verbindung von davor unverbundenem ermöglichen, irgendein neues soziales objekt generieren, irgendwelche neuen ströme erzeugen oder fliessen lassen, irgendeinen neuen möglichkeitsraum erzeugen. mich interessiert hier nicht die abbildung von grundsätzlich ohnehin gut verstandenen verhältnissen jetzt halt auch im web, das folgt mitunter einer etwas anderen logik mit teilweise grösserer steuer- und planbarkeit; auch der komplex internet of things und alles was mikro- oder makroskopisch mit hardware zu tun hat funktioniert anders)

Wenn man sich also sagen wir mal auf mittlerem Niveau überlegt, wo man ansetzen soll und was man tun kann, um international mitzuspielen zu können, dann ist es wichtig, die eigenen Schwächen zu verstehen, damit man an seinen asymmetrischen Stärken arbeiten kann.

Das ist im Falle Web im Vergleich zum Fernsehen auch deshalb relativ wichtig, weil im Web nur die Ebene der Produktion an das lokale Milieu gebunden ist; die Ebene der Rezeption ist zumindest grundsätzlich flüssig, d.h. für Benutzer gibt es keine Notwendigkeit, mittelgute lokale Reinterpretationen zu verwenden, weil man immer auch das Original verwenden kann. Der Name World Wide Web deutet das schon an.

(es ist nicht nur völlig sinnlos, den höchstentwickelten projekten des höchstentwickelten milieus à la ‘wir brauchen ein europäisches google’ direkt konkurrenz machen zu wollen, es ist auch eine verschwendung von ressourcen, die in andere projekte gesteckt werden könnten. mit den 200 mio die etwa in theseus gepumpt wurden, hätte y-combinator 1.667 startups inkubieren können. das problem dabei ist natürlich, dass es im milieu dementsprechende verfahren geben müsste, die diese sinnvolleren projekte erkennen kann, was auf mittelhohem niveau eher unwahrscheinlich ist, es hängt eben alles mit allem zusammen)

Es wird ein bisschen lang und das ist vl. Thema für ein anderes Posting, aber ich glaube es ist die Hoffnung nicht ganz unbegründet, dass das ‘Deutsche’ nicht nur das Problem, sondern auch die Lösung ist, weil es einige tatsächlich distinktive Eigenschaften und ausgeprägte Qualitäten hat, die sich für die zukünftige Ausdifferenzierung vom weltweiten Gesamtmilieu als nützlich erweisen könnten.

-

update: see 260680356

Papierkorb pt. 68

(im grunde wird es wieder einmal zeit, sich an das bekannte beispiel von zizek zu erinnern, in dem er die implizite verlogenheit der antiautoritären erziehung thematisiert:

der ‘autoritäre’ vater sagt einfach, dass das kind die grossmutter am wochenende besuchen gehen soll, und das kind tut das murrend, kann sich dabei aber auch denken, was es will; der ‘postmoderne’ vater sagt, dass er sich von ganzem herzen wünschen würde, dass das kind die grossmutter am wochenende besucht, aber er will das kind auch nicht in seiner persönlichen entfaltung einschränken, es muss also natürlich nicht, sondern soll es nur tun, wenn es selbst wirklich will, auch wenn die grossmutter natürlich sonst alleine und traurig wäre usw. was wie eine freie wahl für das kind klingt ist in wirklichkeit natürlich nur eine noch viel stärkere verpflichtung, weil das kind nicht nur die grossmutter besuchen, sondern es auch noch wollen muss usw.

die geschichte erinnert nämlich stark an das, was wir derzeit im verhältnis zwischen menschen und massenmedien beobachten könnten, nur sind die elemente ein bisschen anders angeordnet. das verhältnis war da ja lange so, dass die medien dem autoritären vater entsprochen haben, die ihren kindern ihr programm einfach vorgesetzt haben, und die kinder konnten problemlos damit leben, weil ohnehin niemand wirklich daran geglaubt hat.

die ‘postmodernen’ medien hingegen sind dazu übergegangen, primär nur noch sich selbst zu thematisieren. ja, natürlich wollen wir über ereignisse angemessen berichten, aber wir müssen auch dazusagen, dass wir wirklichkeit natürlich ohnehin nie objektiv abbilden können, sondern dass wir selbst in unserem tun erst wirklichkeit erzeugen und dabei nicht nur mit menschlichen und prozessualen schwierigkeiten zu tun haben, sondern auch mit historisch kontingenten produktionsprozessen kämpfen müssen und in radikal übergeordnete makroökonomische abhängigkeiten (globaler wettbewerb, beschleunigung, soziales zeugs, volatilität der finanzmärkte) eingebunden sind, usw.

lustigerweise ist der effekt davon nicht ein neurotisches kind, sondern eine art selbstneurotisierung der medien durch erzeugung einer art autoritären vaters in form eines medienkritischen überichs, das die medien mittlerweile fast in echtzeit und üblicherweise deutlich professioneller über jede ungenauigkeit, jede dummheit, jede übertreibung und jeden anderen inhaltlichen oder methodologischen fehler informiert und öffentlich dokumentiert)

Eine Unter

weil gerade links und rechts paywalls aus dem boden schießen:

was zeitungen, glaub ich, noch nicht verstanden haben aber verstehen sollten, ist, dass sich ihr wert für den benutzer als ‘bündel’ nicht nur verändert, sondern sogar umgekehrt hat. was als papier nützlich war, wurde im web ein störfaktor.

ihr wert im ‘analogen’ war, dass sie im monatlichen abo für $40 einen großteil des informationsbedürfnisses des lesers befriedigen konnten. leser mussten sich gwm. aus dem vorhandenen angebot aller zeitungen für eine zeitung entscheiden, und die ausdifferenzierung der zeitungen basierte darauf, für möglichst große oder zumindest gut definierte gruppen von lesern das attraktivste bündel zu schnüren.

das lesen einer und nur einer zeitung war deshalb sinnvoll, weil der wert einer 2. zeitung bei verdopplung der kosten nur wenig zusätzlichen nutzen brachte. gleichzeitig wurde dadurch die eigenleistung der gewählten zeitung überbewertet, weil ihr eben auch das angerechnet wurde, was die baseline ohnehin aller zeitungen ist (dpa-meldungen, fernsehprogramm, usw.).

ihr wert im ‘digitalen’ geht aber plötzlich gegen null, weil es keine distributionsbedingte notwendigkeit mehr gibt, sich auf eine zeitung zu beschränken. jeder artikel steht plötzlich neben allen anderen artikeln aller anderen nationalen und internationalen, grossen, kleinen und kleinsten publisher. im entbündelten stadium gibt es immer etwas besseres direkt daneben.

das lesen einer einzigen zeitung ist also nicht nur nicht mehr sinnvoll, es verursacht für den leser sogar ganz reale kosten, nämlich die verpassten gelegenheiten in gewissen ressorts oder zu bestimmten themen oder für bestimmte funktionen was viel besseres zu lesen oder zu benutzen. noch schlimmer wenn man dafür auch noch geld bezahlt, weil menschen dazu tendieren, ihr investment wieder hereinzubekommen und die zeitung dann auch dann lesen, wenn sie sogar wissen, dass es da was anderes viel g’scheiteres dazu gäbe.

aus dieser sicht täten zeitungen sehr gut daran, wenn sie ihre selbstwahrnehmung von der von den lesern verehrten prinzessin auf ‘eine unter’ umstellen würden, die prinzessin sind sie tatsächlich nur noch für sich selbst.

die gute nachricht ist, dass sie diese ‘eine unter’ für viel, viel mehr leute sein können, und dass sie es auf viele verschiedene weisen sein könnten, was gänzlich neue möglichkeiten eröffnen kann, wenn man sich nicht auf die ehemalige rolle als prinzessin kapriziert.

(minianmerkung zum pricing von paywalls: aus oben genannten gründen sind modelle für ‘full digital access’ für 25$ oder mehr völlig kontraproduktiv, selbst wenn sich einige finden, die es bezahlen. das werden primär ehemalige abonnenten der papierversion sein, die sich freiwillig selbst beschränken wollen oder die möglichkeiten noch nicht kennen oder können. der preis wird ansonsten aber allen anderen, auch den echten sympathisanten, schwer zu verkaufen sein, weil sich die frage aufdrängt, warum gerade für dieses und nicht für das oder für das dort oder für das dort drüben und überhaupt, die ja auch gute arbeit leisten. und für alle bezahlen geht halt auch nicht, das allokierte budget wird für bits kaum viel grösser sein als für papier. auf den selbstempfundenen wert und den hineingesteckte aufwand sollte man da nicht beharren, weil der grenznutzen aus lesersicht wie oben beschrieben eben fast null ist. techdirt’s cwf+rtb ist auch für zeitungen noch immer das einzige schlüssig klingende modell, wobei diese bei ihrem rtb vor allem auch auf eine ‘erzählung’ setzen müssen, wenn sie nur auf der ebene der inhalte bleiben wollen und ihre prozesse und produkte lieber nicht aufbohren)

Lazy Blog Ep. 46

(blogpost über DAS fundamentale dilemma im derzeitigen web: den umstand, dass wir nicht besonders gut dabei sind, die schnittstellen zu erkennen und benennen, die zwischen dem was wir tun/tun wollen und dem angebot/mittel stehen, das wir dafür verwenden, und – vor allem emotional – zu verstehen, dass eigenschaften des angebots/mittels nichts mit den eigenschaften des ergebnisses zu tun haben)

((ein plakatives beispiel: wer will, kann seine allgemeine theorie und praxis zur revolution mit einem proprietären editor auf dem geschlossensten aller systeme schreiben, der text würde dadurch nicht schlechter.

gleichzeitig können die geheimdienste aller länder ihre überwachungsprogramme vollständig auf einem open stack an hard- und software betreiben, das gesellschaftliche vertrauen würde deshalb nicht weniger aufgelöst.

dem text ist es egal, wo und womit er geschrieben wurde.1 dem web ist es egal, mit welchem gerät es betrachtet oder benutzt wird.2 der funktionalen ausdifferenzierung ist es egal, was in der schwarzen schachtel hinter dem interface steckt.

bei text leuchtet glaub ich unmittelbar ein, dass man die schreibumgebung als black box verstehen kann, deren innereien auf das geschriebene keinen einfluss haben.

das gleiche prinzip gilt aber auch für sozialen plattformen oder für das ökosystem an mobilen apps, den üblicherweise ausgemachten feinden des offenen webs, und da wird die assoziation fast reflexartig hergestellt. winer glaubt noch immer, dass an facebook doch wirklich nix so kompliziertes dran sein kann, was man nicht schnell mit open source komponenten emulieren könnte. im cluetrain manifesto wird ganz selbstverständlich davon ausgegangen, dass die benutzung des webs selbst schon ein ethischer akt ist, während die benutzung von apps den wert in sich aufsaugt. usw. fast immer geht es dabei um kontrolle, aber um kontrolle über dinge, bei denen man mit der kontrolle nichts funktionales gewinnt.

das problem der oft falscherweise hergestellten assoziation der eigenschaften vom mittel hinter der schnittstelle mit den eigenschaften des produktes ist, dass im anschluss das falsche problem gelöst werden soll, was der lösung der eigentlichen probleme – es sind dann üblicherweise immer zwei: ein technopolitisches und ein produktqualitatives3 – dann doppelt im weg steht, vor allem aber auch die gesamte ‘schlagkraft’ der grundsätzlich vorhandenen energien für gesellschaftlich sinnvolle offene systeme reduziert, weil nicht nur energien in projekte gesteckt werden, die nix bringen, sondern im verlauf auch alle beteiligten frustriert))

(((bonuspunkte also wie immer für konkrete fallstudien und sternchen für eine umfassende typologie)))

1 was natürlich nicht heisst, dass man nicht auf gewisse technische details achten muss. im falle text etwa, dass man ihn in einem format speichert, der von den verschiedensten editoren auf den verschiedensten plattformen gelesen und geschrieben werden kann. oder dass man bei plattformen darauf achtet, dass man seine posts jederzeit sauber exportieren kann, siehe die pownce lektion.

2 was wiederum nicht heisst, dass es nicht unterschiede in der usability gibt und vor allem natürlich die bildschirmgrösse auch einschränkungen setzen kann.

3 technopolitisch meint etwa, dass es gesellschaftlich nicht wünschenswert ist, wenn es zum dominanten anbieter keine alternative gibt, oder wenn es für bestimmte anwendungsbereiche keine offene software gibt, weil man sich bei gewissen dingen nicht auf den goodwill eines herstellers verlassen will.

Leftovers 2014 (Low Hanging Fruit Edition)

(oops, hab ich damals zum anlass begonnen und wollte ich noch überarbeiten und hab ich dann aber vergessen und jetzt ist es ein bisschen zu spät aber bevor ich es lösche usw.)

auch nicht weitergekommen sind wir 2014 jedenfalls mit dem entschärfen vom komplex urheberrecht/copyright, vor allem in der nicht geschäftsmäßigen benutzung, das wohl eine der unnötigsten fussfesseln vor allem für die entwicklung im deutschen internet ist.

(die gute nachricht ist, dass es damit tatsächlich eine tief hängende frucht gibt, mit der sich der webtechnologische entwicklungsgrad mit hoher wahrscheinlichkeit in absehbarer zeit deutlich verbessern könnte; die schlechte nachricht ist, dass alle anderen interventionen ohne diese frucht ziemlich sicher wirkungslos verpuffen werden)

warum ist eine anale auslegung vom urheberrecht so schädlich?

erinnern wir uns an den jüngsten fall, bei dem ein moderator abgemahnt wurde, weil er auf twitter ein foto gepostet hat. mich interessiert hier weniger das abwägen der verschiedenen positionen, ich möchte nur kurz zu ökosystemischen konsequenzen von einem ‘sich durchsetzenden’ urheberrecht erwähnen:

fotos können von mir aus gerne beschützt werden. wenn ein fotograf partout nicht will, dass sein foto in keinem von ihm nicht abgesegneten kontext erscheint, warum sollte er seinen wunsch nicht erfüllt bekommen?

das problem dabei ist halt, dass man dem foto nicht ansieht, ob sich dahinter ein fotograf mit einer ebensolchen disposition verbirgt (der dann unter umständen auch eine firma angeheuert hat, die das web und soziale netzwerke proaktiv und systematisch nach ‘verletzungen’ durchsucht, um die rechte mit kostennote durchzusetzen usw.), oder ob dahinter ein normaler mensch steckt, der sich über jede weiterverbreitung sogar freuen würde oder den es zumindest nicht stört.

und ich habe keine zahlen, aber ich vermute dass vl. jedes 1.000. geschossene foto urheberrechtlich wirklich beschützt werden will, es allen 999 anderen aber völlig egal wäre, wenn sie mal in einem twitterstrom oder illustrativ in einem blogpost auftauchen würden. (ich beziehe meine schätzung auf den differenzlosen urheberrechtlichen schutz; es gibt natürlich andere valide gründe, fotos nicht öffentlich verteilt zu sehen, das ist aber ein völlig anderes thema)

das problem ist also, dass der schutz nicht nur die tatsächlich schutzsuchenden und/oder schutzfordernden fotos betrifft, sondern auch alle anderen, und dass also das sharen von fotos ganz grundsätzlich mit einem über dem kopf schwingenden damoklesschwert verbunden ist. (ja, fotos können auch etwa cc-lizensiert sein und also selbst quasi die zustimmung geben, aber selbst da besteht immer die möglichkeit, dass die jeweilige quelle selbst nicht die rechte daran hat usw.)1