Gmahte Wiesn

wer jetzt nicht mitzieht, der ist voll daneben

nur mal leise dahingedacht … ich frage mich gerade, ob facebook mit der vorgestellten open graph / graph api / social plugins kombi (eine genauere beschreibung davon gibt’s hier) nicht gerade einen steilpass für twitter hingelegt hat.

twitter könnte nämlich ohne probleme das gesamte prinzip übernehmen und aber gleichzeitig das für die publisher, die user und alle anderen zusammen wesentlich attraktivere angebot schnüren.

![]() was macht facebook?

was macht facebook?

- nun, es gibt einige widgets, allen voran der like-button, den man auf seine eigene seite pappen kann. man macht das, weil man sich zwei dinge verspricht: mehr attraktivität für die besucher, weil sie ggf. schon die spuren ihrer freunde finden können; und für sich selbst, weil die besucher idealerweise liken und also die seite unter den freunden streuen und also neue besucher bringen (omg, 500 mio facebooker liken unser zeug).

- und es gibt einen sich zunehmend verdichtenden und schlauer werdenden supergraph, der den in facebook vorhandenen social graph mit dem ‘open graph’ via iliketrischer impulse verwebt; mit der graph api lässt sich das dann auch befragen.

![]() was könnte twitter machen?

was könnte twitter machen?

der open graph ist ja nichts anderes als die summe aller webseiten, die sich selbst dem protokoll entsprechend semantisch auszeichnen. aber das protokoll ist offen und auf diese daten haben alle zugriff, auch twitter (oder google).

und einen eigenen – mehr als ausreichend grossen – social graph hat twitter auch, mit dem nicht unwesentlichen unterschied, dass er (private accounts ausgenommen) öffentlich ist.

![]()

was twitter also fehlt sind die widgets, eine api und die möglichkeit tweets mit open graph objekten zu verknüpfen.

- aber mit den kommenden annotations hat twitter schon bald die möglichkeit, die tweets mit den open graph daten zu annotieren. jeder tweet zu einem og-objekt könnte also mit den jeweiligen metadaten ausgezeichnet werden.

- und die api ist zwar kein projekt fürs wochenende, aber kein unlösbares problem. und wenn sie die api haben sind die widgets ein klacks.

twitter könnte also dem restweb das gleiche angebot wie facebook machen (pappe unseren like button und widgets drauf, gerne auch neben denen von facebook), nur wäre es für die webseitenbetreiber eigentlich noch viel besser, weil diese widgets nicht den eiertanz rund um die privacy-einstellungen von facebook machen müssten.

anders als facebook könnte twitter die widgets nicht nur personalisieren (die und der deiner freunde haben auch darüber getwittert, das und das könnte dich auf basis des verhaltens deiner verfolgten interessieren) sondern der betreiber könnte die aktivitäten eben auch publizieren und vollwertig in sein angebot integrieren, weil die tweets eben (grösstenteils) public sind.

man könnte das jetzt noch lange weiterspinnen, aber unterm strich: a gmahte wiesn ist das für facebook nicht. das konzept und die umsetzung ist zwar genial und facebook wird damit sich und das web nachhaltig transformieren, aber der relative wettbewerbsvorteil von facebook im bereich social könnte auch abnehmen. twitter könnte damit das fehlende stückchen gefunden haben, das tweets semantisch mit der welt verankert, und auch das offene web könnte damit den notwendigen tritt in den allerwertesten bekommen haben und mit einer eigenen reinterpretation aufwarten.

XAus

Langsam wird es Zeit Siggi Beckers … versuchen nicht das Aufmerksamkeitsproblem zu lösen, sondern für sich zu entscheiden

(sb, siehe attention suckers und blubberrohr) umzuschreiben in … versuchen nicht einmal mehr das Aufmerksamkeitsproblem für sich zu entscheiden, sondern nur noch die verbleibenden Krümel und Reste untereinander zu verteilen.

Jüngstes Beispiel XAuth, eine Art cross platform Autorisierungsthingy, bei dem mit einem JavaScript-Overlay der eigene soziale Graph auf alle unterstützenden Seiten quasi mitgenommen werden kann (siehe, oder, oder, oder, oder)

(was ja auch nicht anundfürsich schlecht ist, das problem ist die anspruchslosigkeit des anspruchs. sie versuchen erst gar nicht mal, eine grundsätzliche alternative zum modell von facebook (und zu teilen twitter) zu entwerfen, den ganzen komplex identität, aufmerksamkeit, social graph zu überdenken und einen radikal ‘offenen’ gegenentwurf zu konzipieren, sie versuchen nur im bestehenden gefüge zumindest einen teil vom kuchen zu behalten; sie versuchen nicht, den (system-) wert vom sharing zu erhöhen, sharing besser, effizienter, vielfältiger, smarter zu machen, sie versuchen nur den marktanteil an herumgeshare ausserhalb von facebook (und zu teilen twitter) zu steigern, usw.)

(abt. ja mei)

What's going on?

kleine anmerkung zu peter kruses vortrag bei der re:publica … so erfreulich seine person in dem ganzen deutschen herumlaberdiskurs auch ist, mit seiner hauptthese, das problem sei ein problem der werte und ist deshalb durch diskurse auf sachlicher ebene nicht ausdiskutierbar, sitzt er glaub ich auf dem falschen dampfer. genauer gesagt hat er mit dem es ist nicht ausdiskutierbar recht, aber aus den falschen gründen und deshalb mit den falschen schlussfolgerungen.

basis seiner thesen sind zwei achsen:

einerseits die beobachtung der beschreibungen des internets, die er in die gruppen ‘das internet macht uns alle dumm und nurgottweisswassonstnochalles kritiker’ und die ‘distanzlosen euphoriker’ teilt.

andererseits eine studie, bei der die wertemuster von ‘heavy usern’ gemessen und gruppiert wurden, und wo sich in der folge zwei paradigmatische typen herauskristallisierten, digital visitors und digital residents, wobei beide gruppen die sachlage richtig beurteilen, aber wegen der jeweils verschiedenen wertelandschaften völlig unterschiedlich interpretieren. ein rationaler disput sei deshalb nicht möglich, solange nicht diese wertedifferenzen von allen beteiligten ausreichend mitreflektiert werden.

ohne jetzt die grundsätzliche bedeutung von werten auf unsere ganz allgemeine operationsweise (wahrnehmungsapparat, etc.) herunterspielen zu wollen, die von ihm extrahierten wertebündel deuten eher auf den grad des verständnisses und auf die jeweils konsumierten quellen und nicht auf eine unveränderliche disposition und ‘echte’ werte hin.

heavy user zu sein heisst zunächst einmal überhaupt nix. (ich kann mein leben lang fernsehen und hab trotzdem null verständnis für medientheorie, creative sitcom writing, fernsehtechnik, etc.)

wenn ich mir den katalog an (die implizit dann die werte beschreibenden) begriffen anschaue, mit denen er die leute vermisst, dann sind die allermeisten grundsätzlich orthogonal zum web. sie haben mit dem web nix zu tun. er konstruiert gegensatzpaare, die aber eigentlich UND-verknüpfungen sind. er konstruiert zuordnungen, die aber eigentlich verkrustete und wiedergekaute diskursfragmente sind.

(es ist dabei nicht hilfreich, dass der diskurs der massenmedien grundsätzlich hysterisch ist, also immer nur nach oben oder unten masslos übertreibt. der organische diskurs krächzt mitunter deshalb so vor sich hin, weil er sich in diesem wirrwarr an genauso blöden und leider oft genauso hysterischen gegenreaktionen verfängt, die ganzen begrifflichkeiten sind oft schon falsch, bevor sie überhaupt erst gefasst werden können)

((das andere, was nicht hilfreich ist, ist, dass die beschreibungen immer mit zu ‘grossen’ begriffen belegt werden, als hätte das web das notwendig, aber das ist eine andere geschichte))

RT @marshallmcluhan Stop asking “Is this a good or bad thing?” and start asking “What’s going on?”

aber um auf meine kritik an kruses diagnose zurückzukommen: ich glaube also nicht, dass unser problem ein problem inkompatibler (und deshalb kaum zu überwindender) wertvorstellungen ist. ich glaube eher, dass die jeweiligen wertebündel nur das symptom des grades und der qualität unserer jeweils spezifischen interpenetration mit dem system web sind. und diese interpenetration ist kein linearer evolutionsprozess (sprich: es ist nicht so, dass die einen weiter sind als die anderen, dass eine stärkere selbstkoppelung an das web fortgeschrittener als eine schwächere ist, etc.), aber es ist doch so, dass es grade an verständnis (oder besser verständnissen) gibt, die die eine oder andere wahrnehmung verunmöglichen oder als scheinwiderspruch erkennen lassen.

(verstehen ist natürlich ein blödes wort, wir können das alles alle zusammen nicht richtig verstehen, verstehen also eher im sinne von verstehen, dass man zwar nix verstehen kann, dass man aber versuchen kann, die möglichkeitsräume von den dingen zu erahnen und für sich und die eigene lebenspraxis abzuchecken, dass man versuchen kann zu beobachten, was andere machen und welche dynamiken dadurch entstehen, dass man für sich herausfinden kann, was für einen selbst funktioniert und was nicht, etc.)

The XX

(anlässlich dieses gmail-emuliert-folders-thingies …)

Folgt man der gemeinen Dialektik, dann kann man die Entwicklung von Phänomenen oft sehr treffend als Spirale von Thesen, Antithesen und auf etwas höherem Niveau quasi doppelt verneinten Synthesen beschreiben.

Einer der eigenartigen Aspekte vom Web ist, dass sich die Synthesen oft nicht auf einem ‘höheren’ Niveau ausdifferenzieren, sondern dass sich die dialektische Spirale gwm. nach unten dreht. Es kommt zu Antisynthesen, die für alle zusammen weniger wert sind.

Beispiel Gmail

Bevor Gmail 2004 lanciert wurde, gab es (ein bissl konstruiert, aber um den punkt zu machen:) als These viele mehr oder weniger gute Mailprogramme für den Desktop und als Antithese einige mehr oder weniger schlechte webbasierte email-Clients (Hotmail, Yahoo, AOL usw.), die zwar im Web liefen, aber die grundsätzliche Metaphorik nicht hinterfragten.

Doch dann kam Gmail und hat Email radikal neu definiert und als Gmail synthetisiert. Man kann sich heute, glaub ich, nur schwer vorstellen, wie radikal anders Gmail damals war; Google hat gesagt: wir geben euch Tags und wir geben euch Threads und wir geben euch Suche und wir geben euch Speicherplatz und wir geben auch Speed und that’s it. Wie so oft war das nichts für alle (jeez, was gab es für ein geschrei und bemängelungen und feature requests und beweisführungen wie viel besser outlook ist, weil es zehntausend spezialfälle behandeln kann), aber wer sein Verhalten unter dem neuen Paradigma redefinieren konnte, für den war das ein Quantensprung.

Zurück in die Gegenwart und was macht Google im Jahr 2010? Sie emulieren mit ihren Labs-Features alles, wovon sich Gmail ursprünglich distanziert hatte; sie bauen peu à peu wieder jede Komplexität ein, deren Ballast sie ursprünglich abgelegt hatten. Sie fördern nicht mehr kreatives und flüssiges Verhalten, das man sich selbst auf Basis der losen Koppelung der Elemente für sich selbst definieren (und auch erlernen) muss, sondern sie versuchen auch die festgefahrensten Verhaltensmuster aus historischen Kontexten abzudecken.

Zurück in die Gegenwart und was macht Google im Jahr 2010? Sie emulieren mit ihren Labs-Features alles, wovon sich Gmail ursprünglich distanziert hatte; sie bauen peu à peu wieder jede Komplexität ein, deren Ballast sie ursprünglich abgelegt hatten. Sie fördern nicht mehr kreatives und flüssiges Verhalten, das man sich selbst auf Basis der losen Koppelung der Elemente für sich selbst definieren (und auch erlernen) muss, sondern sie versuchen auch die festgefahrensten Verhaltensmuster aus historischen Kontexten abzudecken.

Man kann bei Google insgesamt zunehmend beobachten, wie sie ihre ursprüngliche Edge verlieren, weil sie sich mehr und mehr an den Spreadsheets der Marktanteile und am kleinsten gemeinsamen Nenner der Verständlichkeit für möglichst alle orientieren.

Das ist zwar alles nicht gänzlich unverständlich, aber die erzwungenen Kompatibilitäten haben diese Antisynthese als Nebeneffekt, die Dienste werden für alle schlechter.

Das Phänomen Antisynthese lässt sich natürlich auch bei einigen anderen Playern und Bereichen beobachten, aber bei Google ist es halt am auffälligsten, weil Google teilweise meilenweit vor dem Rudel war. Seit zwei, drei Jahren machen sie aber aus den meisten Dingen die sie angreifen eine mess.

Inflection Point

Fred Wilson über Twitter und nochmal hmm.

Er stellt sich natürlich die Gretchenfrage, die sich jeder vernünftige VC stellen würde: “What are the products and services (aka killerapps) that create something entirely new on top of Twitter?”, aber er extrapoliert seine Gedankengänge auf Basis der Beobachtung von Facebook, und das ist das Ungeschickteste, was man machen kann.

Etwas plump gesagt: Die Killerapp für Twitter gibt es nicht.

‘Killerapps’ wie social gaming gedeihen in Facebook, weil Facebook ein implodierendes schwarzes Loch ist, ein Magnet, der alle Aktivitäten und Energien zentriert und auf sich reterritorialisiert. Twitter tut das genaue Gegenteil, es explodiert, deterritorialisiert alle Aktivitäten und Energien, verschiebt die Ränder.

(nur als beispiel: der killer-client von facebook ist facebook; den killer-client von twitter gibt es nicht; es gibt aber hunderte clients, die sich auf einen bestimmten anwendungsfall für twitter spezialisiert haben; facebook lebt von der gleichschaltung, twitter lebt vom ausdifferenzierungspotential; und killerapps wären da systemisch sogar eher dysfunktional)

Kurzschuss

kleine anmerkung zu den angedachten nächsten facebook privacy settings …

der großteil der kritik (siehe, oder, oder) zielt, natürlich nicht zu unrecht, auf das vertrauen ab.

ich glaub aber, dass der jeweilige vertrauensverlust in sie als unternehmen nicht ihr grösstes problem werden wird. sowohl facebook als auch google wissen, dass sie ohne dem grundvertrauen in sie auch schneller wieder weg sein können, als sie gekommen sind. die google buzz geschichte war sicher ein griff auf die herdplatte, aber nix, was das genuine vertrauen in google erschüttert; facebook dehnt auch gerne den bogen, aber sie sagen zumindest immer, was sie tun, und ggf. rudern sie auch zurück; jedenfalls sollte sich niemand mehr weder über facebook noch über google bzgl. ihrer datenminenden und -verwertenwollenden hamsterhaftigkeit grundsätzlich wundern.

ihr grösseres problem könnte die zunehmende komplexität werden, die sie in sich selbst durch die verwässerung der grenze zwischen öffentlich und privat einbauen, und die damit verbundenen unsicherheiten. einerseits ist es ein riesiger aufwand für das tool, verschiedene stufen der privatheit und öffentlichkeit gleichzeitig und/oder abgestuft zu ermöglichen (siehe buzz, umständlicher gehts nimmer). andererseits sind vermischte grenzen auch für die user anstrengend, weil man sich als kommunizierender über nichts mehr sicher sein kann (siehe facebook, was von mir taucht em ende plötzlich wo auf, ohne dass ich einen schimmer davon hab).

(mehr oder weniger alle gut funktionierenden kommunikationsformen im web sind entweder dediziert privat (email, im, icq, skype, das alte facebook, etc.) oder dediziert public (youtube, last.fm, flickr, blogs, twitter, usw.). für den benutzer gibt es keinen mentalen overhead, er weiss, was er zu erwarten hat, sowohl vom dienst als auch von den beziehungen.)

google und facebook kommen von den entgegengesetzten enden (google ist der könig des öffentlichen, facebook der des privaten), beide sind damit aber nicht zufrieden und haben begehrlichkeiten auf das reich des anderen (google will den social graph interpenetrieren, facebook will den vorhandenen social graph veröffentlichen), beide sind auf jeweils unterschiedliche art bereit, ihre stärken dafür zu opfern. beide bauen komplexitäten ein, die das eigene angebot mittelfristig unattraktiver machen.

(ich befürchte facebook hat im bereich öffentlich-sozialer rundfunk den besseren plan (im sinne von ist sich der konsequenzen besser bewusst und nimmt sie bewusster in kauf) und google hat diesbezüglich leider überhaupt keinen plan. leider, weil ein offenes web zumindest auf absehbare zeit wohl google braucht, um unter den neuen bedingungen (echtzeit, mobil, lokal, transsozial, etc.) zu sich zu finden)

((mir ist es ein echtes rätsel, warum google die gier hat, auch das soziale an sich koppeln zu wollen, und sich nicht darauf beschränkt, das vorhandene soziale zu fördern, zu sichten, zu vernetzen und zu organisieren. wenn man so will ist facebook die molare kraft, die zwar böse ist, aber bzgl. der eigenen funktionslogik alles richtig macht, und google ist auf dem besten weg, das eigene molekulare mojo zu verspielen und eine art molares mini-me von facebook zu werden))

Schwarmacher

(minianmerkung bzw. update zu schirrmacher usw., weil ich (wieder nur das ende) seiner keynote bei einer schwarmkonferenz gesehen habe:

das lustige an ihm ist, dass er selbst quasi ein glaubender der von ihm kritisierten ‘internetideologien/-en’ ist, nur die angedachten ergebnisse, visionen, utopien negativ und dystopisch bewertet. er selbst denkt technodeterministisch, nur verzweifelt seine humanistische seele an den entwürfen. auf alle fälle ist er weitaus abgespaceter, als man vermuten würde)

The Object Supposed To Know

schöner artikel von m. lindner zu sozialen objekten im kontext marketing.

(wobei er den begriff social objects nicht im semiotischen sinne (und also mit engeström) sondern im social media sinne (und also mit gapingvoid) interpretiert; es geht also primär um die effektivität von objecten im sozialen raum)

The Feedhead

(anlässlich dieser basicthinking kürzt feed debatte (etwa, oder, oder) eine persönliche miniökonomie der feeds, wobei ich den ganzen komplex monetarisierung und die damit meistens verbundene moralisierung ausklammere, der ist auf mehreren ebenen unfruchtbar)

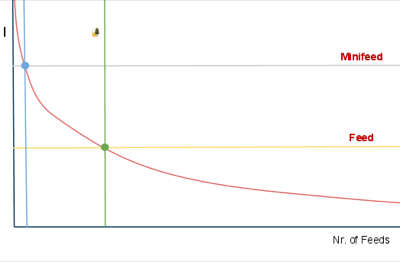

- die y-achse indiziert mein interesse an einer quelle

- die x-achse die anzahl an mit der jeweiligen interessantheit assoziierten quellen

- die rote l-kurve zeigt meine verteilung an

es gibt also nur sehr sehr wenige quellen, an denen ich sehr sehr grosses interesse habe, es gibt hunderte quellen, an denen ich eigentlich doch schon interessiert bin, und es gibt millionen quellen, die sicher auch gelegentlich irgendwas irgendwie interessantes beinhalten.

(welche quelle für einen interessant ist oder nicht ist übrigens nicht nur naturgemäss für jeden verschieden, das hängt auch davon ab, welche anderen quellen man kennt und liest. je mehr andere quellen man liest, desto mehr verschiebt sich das attribut interessant ins kompatibel komplementierende)

nun ist es so, dass es natürlich toll wäre, alles auch nur irgendwie interessante zu lesen, nur geht sich das zeitlich nicht aus. man muss also für sich selbst infoökonomische verfahren entwickeln, was man wie in sich reinlässt und was nicht.

je nach disposition gibt es eine ganze reihe möglicher verfahren. man kann zb. einzelne quellen und/oder redaktionell vorselektierende portale und/oder algorithmisch vorselektierende memetracker bookmarken und täglich ansteuern und alles andere ignorieren (oder mit anderen praktiken kombinieren). oder man kann (wichtige nachrichten finden mich blabla) in div. sozialen empfehlungsströmen treiben und alles aufsaugen und alles andere ignorieren (oder mit anderen praktiken kombinieren). oder man kann – und das ist die mit abstand bequemste und effizienteste methode, um viele heterogene inputströme zu konsumieren – sich sein eigenes bündel an quellen via RSS zusammenstellen und diese in einem feedreader lesen (und das mit anderen praktiken kombinieren).

(welche praktiken für einen passend sind oder nicht ist übrigens wiederum nicht nur naturgemäss für jeden verschieden, es ist auch völlig unwertend. allerdings trifft man idealerweise seine entscheidung, nachdem man sich etwas mit allen möglichkeiten herumgespielt hat)

aber wie gesagt: wer viele quellen effizient lesen möchte, der kommt um einen feedreader nicht herum. das ist nix für alle, es erfordert zeit, aber es hat auch einige von anderen methoden nicht emulierbare vorteile. vor allem bei echtem interesse an einem thema. auch die besten portale, thematisch fokusiertesten memetracker und smartesten aggregatoren tendieren zum hochspülen des kleinsten gemeinsamen nenners, die echten goodies findet man nur im feedreader.

doch zurück zum diagramm:

jedes der oben erwähnten (und aller anderer) verfahren verursacht neben dem sich ergebenden informationsnutzen auch rezeptionskosten (zeit, anzahl an klicks, anzahl an medienbrüchen, usw.). der wert einer quelle unterm strich ergibt sich also nicht alleine aus der interessantheit, sondern auch aus dem damit verbundenen aufwand. (man könnte die rote kurve also auch als indifferenzkurve lesen: je interessanter, desto mehr aufwand nehm ich in kauf, je weniger (aber natürlich immer noch) interessant, desto weniger.)

in meinem setup gibt es zwei grenzwerte:

- blauer punkt: quellen, die ich immer lese, egal ob fullfeed oder excerptfeed oder nofeed. rein theoretisch übrigens, in meinem feedreader hab ich glaub ich zwei excerptfeeds, alle anderen haben ohnehin fullfeeds.

- grüner punkt: quellen, die ich nur lese, wenn es sie im fullfeed gibt.

anders als noch vor zwei, drei jahren ist es mir als kleine randbemerkung mittlerweile übrigens völlig wurscht, ob wer einen fullfeed hat oder nicht; twitter und friendfeed und alle memetracker haben meine klickbereitschaft doch deutlich verändert und im dortigen kontext stört mich auch das herumklicken nicht. aber im feedreader empfinde ich excerptfeeds als extrem störend, weil sie den leseflow doch stark unterbrechen, und also subscribe ich sie nur seltenst. nicht weil ich mich als klickvieh verraten fühle etc., sondern einfach weil es für mich bessere alternativen gibt.

als publisher muss man sich über eines jedenfalls im klaren sein: das umstellen von fullfeeds auf excerptfeeds bringt vl. einige klicks, birgt aber auch mitunter signifikante opportunitätskosten. man verliert nicht nur leser (alle, bei denen man auf deren eigenen indifferenzkurve zwischen dem grünen und blauen punkt liegt), man verliert gerade die, denen das wichtig ist, weil sie mehr als nur eine quelle lesen und ihren output dann sharen und faven und streuen usw, man verliert die katalysatoren und damit alle von diesen getriggerten indirekten klicks. do the math, wobei das natürlich von der verteilung der dispositionen der leserschaft abhängt.

(im falle basicthinking (oder auch heise etc.) ist das, glaub ich, eher egal, weil die vorwiegend, glaub ich wiederum – das müsste mal jemand statistisch auswerten -, vor allem leute ansprechen, die wenige andere quellen kennen, die wenige feeds lesen, und für die basicthinking also ohnehin sehr interessant ist, also im blauen bereich liegt.)

Gift

… selling by giving, or, gift economics hängt schon einige zeit in meiner 2process schleife, und weil ich es entfernen will aber zu faul für mehr bin nur eine anmerkung … stimmt natürlich und die geschwindigkeit des shifts ist tatsächlich erstaunlich, was mich aber stört, ist das framing von dem was passiert auf das sich selbst vermarketingende subjekt. die logik ist die gleiche wie in the good, the bad and the ugly – eine viel grössere amorphe unfassbarkeit, deren potential nicht einschätzbar ist, wird aus der brille des egoistisch-rationalen sichselbstvermarkters reinterpretiert, dinge wie twitter erklären sich dann leicht als haufen von social media experten usw.

Generation Why?

Über einen Mangel an massenmedial vermitteltem Diskurs über das Web kann man sich in letzter Zeit eigentlich nicht beklagen. Eigentlich auch nicht über die Qualität der aufgestellten Protagonisten (im sinne von: sie versuchen wohl wirklich, ‘experten’ für themen und standpunkte zu finden, so ein hau-drauf-journalismus (gaschke usw.), der davor eher die regel war, wird zumindest ergänzt; man denke an diese internetdenker serie in der faz, die besetzung von diskussionsrunden, etc. nicht alles superduper, aber man hat nicht mehr das gefühl, zumindest nicht mehr immer, dass sie absichtlich verblöden wollen).

Und trotzdem findet, kommt mir vor, kaum Vermittlung statt, und zwar jenseits des allgemein üblichen (und in jedem bereich gegebenen) Aneinandervorbeiredens.

Mit persönlich ist es zwar eher egal, was irgendwer über das Internet denkt, aber diese genuine Selbstvermittlungsunfähigkeit des Webs finde ich interessant. Woran liegt es, dass ein Ding, das (neben anderen eigenschaften) auf den verschiedensten Ebenen (persönlich, kollaborativ, wirtschaftlich, sozial, kulturell, you name it) ein enormes Potential für ganz trivialen egoistischen Nutzen hat, bezüglich dessen ‘Verständnis’ es also ein stinknormales Eigeninteresse geben sollte, mit so unfruchtbaren Begriffen und Beschreibungen abgebildet wird?

Diese Unfruchtbarkeit des Diskurses erstreckt sie ja nicht nur auf die Bereiche, in denen man das erwarten könnte – etwa shirkys ‘institutions will try to preserve the problem to which they are the solution’; wer für sich böses ahnt will nachvollziehbarerweise desinformation und regulierung -, sie erstreckt sich über alle Bereiche, auch die Web-nativen.

Something to think about.

PubSubHubbuzz

Buzz ist weder ein Facebook- noch ein Twitter-Killer. Wenn überhaupt von irgendwas ein Killer, dann von Yammer und Konsorten, wenn sie ihre Enterprise Version gestartet haben. Aber der ganze Vergleich hinkt. Leider kann man nicht in Google reinschauen, was sie sich bzgl. ihrer social strategy davon versprechen, aber ich vermute fast, dass ihre primäre Idee eher so in Richtung die Menschen lieben es ganz offensichtlich, im Web Zeug zu sharen, warum sollten sie das nicht bei uns tun? geht, und das dann auf ihre Art weiterdenken (siehe unten).

Was Google aber wie so oft nicht versteht, bzw. versteht, aber nicht besonders gut umsetzt, ist, dass das Sharen von Stuff kein abstraktes Bedürfnis ist, sondern in Dialektik mit der Dynamik eines Dienstes entsteht.

Bei Facebook und Twitter und allen anderen erfolgreichen Diensten ist diese Dynamik klar geregelt. Facebook ist Kommunikation unter Freunden, Twitter ist öffentliche Kommunikation unter Interessierten. Der eigene social graph auf Facebook hat sich, zumindest im Kern, in einer Vorzeit entwickelt (aka Freunde). Der eigene social graph auf Twitter entwickelt sich organisch und adjustiert sich permanent. Buzz macht aus den Versatzstücken social graph und sharing einen Eintopf und rührt ohne Fokus kräftig darin rum. Email-Kontakte z.b. sind weder (notwendigerweise) Freunde, noch Leute, die sich (notwendigerweise) für die eigenen Ergüsse interessieren, noch sind deren shared items (notwendigerweise) für einen interessant. Angezeigt wird, anderes Beispiel, nur, was Google nach Filterung durch eine black box als relevant erachtet. Vertraut uns, das können wir, wir haben das erfunden.

(wobei die versteckenden tabs recht schick sind)

Und es gibt natürlich noch eine Reihe von ans frühe FriendFeed erinnernde rookie mistakes, bei denen man aber davon ausgehen kann, dass sie in kommenden Iterationen ausgemerzt werden, das betonen sie auch selbst.

Und es gibt eine weitere Reihe von falschen (oder besser: kontingenten, aber in ihren konsequenzen nicht bedachten) konzeptionellen Grundannahmen der Google-Hirne, wie man sie bei so ziemlich jedem Google-Dings, das irgendwas mit social zu tun hat, kennt.

Davon abgesehen hat Buzz aber mehr Potential, als alles andere, was bisher von Google im Bereich social gekommen ist. Wenn man von Buzz, dem Produkt in der derzeitigen Form, abstrahiert, schlummert darunter Buzz, die Plattform, die doch eine Art universelle Pumpe für all things social werden könnte, weil Google damit zum ersten Mal zwei Dinge zusammenführt:

- ein Superset von offenen Standards, mit denen sich so ziemlich alles abbilden lässt, was an sozialen Inhalten produziert wird, inklusive Reaktionen und Beziehungen (Atom/RSS, MediaRSS, Activity Streams, Social Graph API, webfinger).

- und die Technologie, das alles und kostenlos an jeden interessierten Endpunkt in Echtzeit zu pumpen (PubSubHubbub, OAuth, AtomPub, Salmon).

Wenn man so will, ist Buzz, das Produkt, eine suboptimale Demoversion für Buzz, die Plattform, und anders als etwa bei Google Wave kann man davon ausgehen, dass es auf Basis der Plattform relativ zeitnah diverseste Services und Integrationen geben wird.

Das heisst nicht, dass damit alle Silos aufgebrochen werden, was wohl auch nicht wünschenswert wäre, Silos haben auch ihren Sinn. Aber auf Basis von Buzz könnte sich ein webweites soziales Nervensystem entwickeln, das dann angezapft und auf tatsächlich neuartige Weise reinterpretiert werden kann.

—

miniproductivity tipp am rande: wenn man zur alten version von gmail wechselt, dann gibts den ganzen buzz nicht. man muss also buzz nicht gleich ganz deaktivieren, wenn einem das phasenweise nicht in die inbox passt.

Das offene Web und seine Feinde

… iDiss revisited, ca. 200 meinungen später.

ein pattern dabei ist recht interessant: die protagonisten der offenheit und des hackens haben wenig vertrauen in die systemkraft der offenheit resp. die kreativkraft der menschen. viele sehen im ipad fast schon eine art endgame, bei dem offenheit und eigensinn kurz vor dem matt stehen, weil sie der grossartigkeit des ipads / dem schrecklichen weil lustvollen matmos / nichts entgegensetzen können.

The iPad is an attractive, thoughtfully designed, deeply cynical thing. It is a digital consumption machine.

alex payne zb macht aus dem ipad fast schon eine art bioadapter der gesellschaft.

(kreativität wird nicht angeregt, sondern unterdrückt; das ist umso schlimmer, weil die vorgeschlagene metapher zur verwendunge von computern u.u. bei vielen sogar besser ankommen könnte als das (sinnlose aber lehrreiche) herumtinkern; wer nur das ipad kennt, wird kein hacker; viele iphone user kennen ausser ihren apps nichts; apple unterstützt das auch noch, die werbung sagt ‘da gibts ne app für’, vom web sagt sie nichts; apple schert sich keinen deut um offenheit und kann oder will offenheit nicht mit usability und eleganz verknüpfen;die entscheidung dafür hat keine technische grundlage, sondern ist strategisch; der weg den uns das ipad weist ist also verführerisch und dystopisch; usw.)

Yet I am concerned that it will get a flow of great apps from people who are willing to compromise on their freedom and users’ freedom.

dave winer rundet die befürchtungen ab. es könnte zu einem brain drain kommen, bei dem entwickler ihre kreativität in eine plattform pumpen, die dann – etwa wegen patentrechten auf multitouch – noch nicht mal auf anderen plattformen emuliert werden kann.

leichter dahergesagt als getan aber trotzdem: wer an die offenheit glaubt, der muss auch an ihre konkurrenzfähigkeit in einem milieu glauben, in dem es auch geschlossene systeme gibt.

Short Cuts Pt. 5 (Early Adopter Edition)

Eine der traurigsten Tropen im Diskurs im und um das Web ist die des Early Adopters. Der Begriff Early Adopter bringt nichts, stört nur und verhindert die Entwicklung von Positionen.

Die Beschreibung von Personen als Early Adopter basiert auf der im Web sinnlosen Notion einer fortschrittlichen Zeitlichkeit. Die Entwicklungsgeschichte wird als linearer, zeitlicher, teleologischer Strahl konzipiert. Wer vor den anderen auf neue Entwicklungen aufspringt, gilt als schneller und besser. Das erworbene kulturelle Kapital ist allerdings kurzlebig, weil es keinen Stillstand geben darf. Es ist schnell wieder verspielt, wenn man nicht immer auf die nächste neue Entwicklung umsteigt.

Aber im Web gibt es keine Zeitlichkeit, weil alles für alle immer schon gleichzeitig ist. Jede neue Anwendung ist sofort für alle verfügbar, jeder neue Inhalt ist sofort für alle zugänglich. Das Web ist keine Serie von disparaten Linearitäten, sondern ein Gewebe, das alles in sich aufnimmt und synchron miteinander verbindet; eine Gleichzeitigkeit von Ungleichzeitigkeiten; ein Potential, dessen Möglichkeiten angezapft werden können, oder nicht. Das Web ist postkontemporär.

Ganz allgemein gesagt sind Webdienste Möglichkeitsräume. Möglichkeitsräume, die zwei Serien triggern können:

Eine Serie der individuellen Intensität, also dem Grad mit dem man den Dienst für sich selbst (aktiv oder passiv) nutzt und sein Leben dadurch besser, interessanter, spannender macht. (Auch wenn man etwas nicht benutzt, ist es gewissermassen doch als Umwelt da. Allerdings ist die persönliche Intensitätsstufe dann halt null.)

Und eine Serie der kollektiven Resonanz, also dem Grad mit dem der Dienst zum Schwingen gerät, Koppelungen und Rückkoppelungen mit anderen Diensten, Systemen, Feldern eingeht und dabei das Leben für die Freunde und die Welt besser, interessanter, spannender macht.

Für jeden Einzelnen geht es also, um zum Early Adopter zurückzukommen, weniger darum, ob man früher oder später damit beginnt, einen Dienst zu nutzen, sondern um die Intensität, mit der man ihn zu einem je gegebenem Zeitpunkt nutzt, und um die Resonanzkörper, die dadurch um ihn herum entstehen. Wenn man etwas nicht verwendet, weil man keinen persönlichen Anknüpfungspunkt darin sieht, dann ist man nicht hinten, sondern handelt rational. Wenn man auf jeden Zug aufspringt, der gerade losdüst, ohne sein Leben dadurch besser zu machen, ist man zwar Early Adopter, aber auch ein Dummkopf.

Das bedeutet jetzt nicht, dass es nicht sinnvoll ist, zu versuchen am Laufenden zu bleiben. Wer kein Sensorium für die ja stetig wachsenden Möglichkeiten entwickelt und kultiviert, wer nicht weiss, was es alles gibt, der hat natürlich die Opportunitätskosten der Nichtbenutzung.

Aber die fast schon penetrante Ungeduld der Neuheit und des jeweils Nächsten hilft dabei selten weiter. Und die Erzählfigur des Early Adopters ist besonders traurig, weil sie gleich zwei Positionen in ihrem Blickwinkel einschränkt:

Die Fremdzuschreibung spart sich durch die Diagnose ‘das ist halt was für Early Adopters’ die Auseinandersetzung mit den Phänomenen. Early Adopters wird gerne mit anderen Begriffen wie ‘selbsternannte Internetelite’ oder (nie konkret benannten) ‘Propheten’ oder ‘Vordenkern’ kombiniert, um eine künstliche Differenz zwischen ‘denen’ und dem ‘normalen wir’ zu konstruieren. Sollen die halt machen, mit ihren Zauberwörtern Blog und Wiki und Flickr und Twitter, wir sind normal und wir wissen, dass das alles ein Blödsinn ist.

Die Selbstzuschreibung ‘ich bin ein Early Adopter, weil ich tool yxr benutze’ ist allerdings fast noch blöder, weil mitunter ein Selbstbild und Gruppengefühl konstruiert wird, das auf nichts begründet ist, und weil ein Tunnelblick entwickelt wird, der blind für die Eigentlichkeiten ist. Es ist keine Leistung früher als andere einen Dienst zu verwenden. Wer ein, zwei Blogs liest und sich überall anmeldet ist der Earliest Adopter schlechthin und erzeugt dadurch alleine noch überhaupt keinen Wert, weder für sich, noch für andere. Was aber getrübt wird, ist der Blick auf das, was funktioniert und warum.

Wer sich selbst als Early Adopter konzipiert, tappt nur allzuleicht in die Falle, eine individuell wertvollere Verwendung von Webdiensten gegen eine wertlosere aber neue Verwendung einzutauschen.

Short Cuts Pt. 4 (Tod von RSS Edition)

In den letzten Wochen war mal wieder viel vom Tod von RSS zu hören. Ohne auf die jeweiligen Thesen im Detail einzugehen trotzdem ein paar Worte dazu, warum das ein blödsinniger hubbub ist.

Zunächst werden oft zwei Dinge vermischt: RSS als Format und RSS als kulturelle Technik des Abonnierens und Lesens von Feeds. Gemeint wird immer zweiteres, aber die Schlussfolgerungen werden manchmal vermischt. Egal, diese Unstimmigkeit erkennt man schnell und kann man abheften.

Was bleibt ist die Annahme, dass Feedlesen eine aussterbende Gattung ist, die von neueren, besseren, effizienteren, fortgeschritteneren Techniken abgelöst wurde. Und diese Annahme ist auf mehreren Ebenen problematisch. Das Äugen auf und die Bervorzugung von Charts (Wachstum hier, Verluste dort) anstelle der Wahrnehmung von Wert; die Notion eines ‘weiter ist besser’ bei blinder Zerstörung der Vorhandenen; der Begriff von Early Adopters, die die fortgeschrittensten Techniken reflektieren aber in Wirklichkeit dichtere Formen gegen dünnere eintauschen; die Annahme, dass was sich nicht als mainstreamtauglich für alle herausstellt nix wert ist; usw.

Das alles ist im Grunde egal, jeder soll machen was er will, und was andere tun tangiert einen persönlich wenig (anders als bei sozialen systemen, wo die koppelung viel stärker ist). Aber ganz stimmt das dann doch wieder nicht, weil man selbst natürlich auch nur irgendwie im Gesamtökosystem verankert ist, und auch wenn man seinen eigenen informationsökonomischen Haushalt selbst bestimmen kann, so schwimmt man eben im aggregierten Ergebnis der Aktionen aller anderen; und die Resonanzräume, die durch die Praktik des Rezipierens und Prozessierens von Feeds getriggert werden, sind interessanter, als die Resonanzräume, die durch verstümmelte Formen wie Beschränkung auf Twitter und Memetracker und Empfehlungssysteme mit anschliessendem Retweeten und Liken getriggert werden.

Nix gegen Memetracker und Twitter und Empfehlungssysteme, die sind super und haben ihren Wert und können einige Dinge viel besser, als das persönliche (zuerst einmal Finden und) Abonnieren und Lesen von Feeds.

Aber das (zuerst einmal Finden und) Abonnieren und Lesen von Feeds ist die potentiell dichteste, effizienteste und persönlich wertvollste Technik. Sie sollte das Herz der individuellen Anbindung an den Gesamtstrom sein.

Die wunderbarste Eigenschaft des Webs sind die kleinen Dinge und die Möglichkeit einer Ausdifferenzierung an den Rändern. Wie strange man auch immer selbst veranlagt ist, wie noch so unwahrscheinlich die eigenen Interessen, im Web gibt es für alles Anschlusskommunikation. Massenmedien müssen per definitionem immer Massen ansprechen, aber niemand ist Masse und also pendelt sich das was sie tun auf irgendeinem kleinsten gemeinsamen Nenner ein. Aber im Web gibt es immer einen, der sich auch mit dem Thema beschäftigt, der Dinge radikaler beschreiben kann, der ohne Rücksichtnahme auf Allgemeinverständlichkeit und also dichter denken kann und vielleicht für einen gerade richtig ist etc. Massenmedien müssen für alle gut genug sein, aber im Web dürfen Spezialisten für andere Spezialisten gut genug sein, und auch wenn das nur 10 Leute sind ist die Welt ein besserer Ort.

Blogs sind nun die ideale Form, um partikulare Expertise von anderen mit spezifischen Interessen zu mappen, und das Abonnieren und Lesen von Feeds ist die ideale Form, um die spezifischen eigenen Interessen zu beliefern. Blogs sind deshalb ideal, weil es drei Dinge besser als jede andere Form vereint: Geschmack, Urteilskraft und Komplementarität.

Geschmack

Über Geschmack kann und braucht man nicht zu streiten, aber es ist eine binäre Kategorie. Wird der eigene Geschmack getroffen, ist man happy, sonst muss man halt durch.

Urteilskraft

Bei der Urteilskraft ist es ein bissl wie bei dem Geschmack, die gefühlte Unterstellung einer Urteilskraft ist immer ein subjektives Gefühl, die vom eigenen Wissenstand abhängt. Anders als beim Geschmack muss das Vertrauen in die Urteilskraft des Anderen allerdings erst aufgebaut werden und wachsen. Auch anders als beim Geschmack kann man über die Urteilskraft schon streiten.

Komplementarität

Bei der Komplementarität geht es darum, zu welchem Grad das, was man selbst ohnehin weiß, ergänzt wird. Auch Dinge mit wunderbarem Geschmack und präzisester Urteilskraft sind völlig witzlos und wertlos, wenn man alles ohnehin schon kennt. (einer der grössten fehler der mehrzahl von systemen ist die annahme, dass sich möglichst gleiches mit gleichem mischen soll)

Short Cuts Pt. 3 (User Edition)

Im Grunde funktioniert das Web sehr einfach. Das Web ist wahrscheinlich der grösste Möglichkeitsraum, den die Menschheit je hervorgebracht hat. Nicht weil die zugrundeliegende Denkleistung so phänomenal ist, sondern weil es eine Infrastruktur definiert, die sämtliche Medien subsummiert und in sich aufnimmt, und vor allem: weil es unsere Möglichkeiten der Kommunikation potenziert.

Das Web macht also ein Angebot, genauer: das Web ist die Summe aller Einzelangebote in Form von Anwendungen und deren Zusammenspiel.

Um ein beliebiges Angebot wahrzunehmen müssen 3 Voraussetzungen erfüllt sein:

- man muss das Angebot kennen.

- man muss das Angebot verstehen.

- man kennt kein ‘besseres’ Bündel das mehr Nutzen bringt.

Unter dem Strich: es geht darum, dass wir durch die Benutzung eines Dienstes besser dastehen, als ohne.

Man kann – wenn man will – Webanwendungen in zwei Kategorien unterteilen:

- Anwendungen, deren Sinn sich selbst erklärt.

- Anwendungen, deren Sinn sich erst durch Nachdenken / Nachahmen / Anwendung etc. erschliesst.

Ich will niemandem zu nahe treten, aber es sprechen einige Symptome dafür, dass die meisten Menschen sehr gut darin sind, Anwendungen die sich selbst erklären für sich nutzbar zu machen, wenn sie ihnen Nutzen bringen (i.e. die meisten schauen mal schnell was in der Wikipedia nach, oder gehen auf ebay auf Schnäppchenjagd, oder bestellen sich Bücher bei Amazon, oder bestellen Zugtickets, oder schauen Videos auf YouTube, usw usf.)

Doch schon deutlich weniger erkennen das Potential von Anwendungen, deren Sinn und Nutzen sich nicht sofort erschliesst und aufdrängt. Man darf glaub ich 2 Fehler nicht machen: glauben, dass man alles verwenden muss. Oder glauben, dass man nichts versäumt. Man darf auch nicht glauben, dass nur Wert hat, was für alle wertvoll ist. Die Schönheit im Web ist das Potential der Ausdifferenzierung, dass sich jeder das Bündel an Anwendungen zusammenstellen kann, das mit den eigenen Interessen am meisten kompatibel ist, dass jeder genau soviel Zeit investieren kann, wie er will.

Dass sich Leute, die beruflich mit dem Web zu tun haben, ein anderes Produktportfolio zusammenstellen und mehr Zeit investieren ist klar, sollte aber nicht darüber hinwegtäuschen, dass es trotzdem Opportunitätskosten gibt, Tools nicht zu kennen und zu verstehen.

Ich stelle mir seit langem die Frage: woher kommt der Widerstand sich 30 Minuten hinzusetzen und zu versuchen RSS zu verstehen, wenn das die eigene Produktivität was den Konsum von Nachrichten betrifft, um den Faktor 5 bis 10 erhöht? Mehr als 30 Minuten dauert es nicht, dennoch halten sich die Adaptionsraten in Grenzen.

Wenn man die Voraussetzungen oben als Matrix verwendet: viele kennen es nicht, und vielen, die irgendwie darüber gestolpert sind, erschlisst sich der Sinn nicht. Es geht nicht darum, ob RSS jetzt ein Hype ist oder nicht und was irgendwer über RSS sagt oder nicht sagt, es geht darum, dass RSS einen enormen Wertvorschlag macht, den man annehmen kann, oder nicht. Und nur wer RSS kennt kann eine informierte Entscheidung darüber treffen, in welchem Umfang er RSS einsetzt oder nicht. Wer dann lieber den Guardian genüsslich in seinem Lieblingscafe liest, der macht alles richtig. Aber wer aufgrund einer Ignoranz die Möglichkeiten erst gar nicht kennt, der bleibt halt auf seinen Opportunitätskosten sitzen. Macht natürlich auch nichts, aber trotzdem ist es schade drum.

Nun sind alleine in den letzten 3 Jahren mindestens 20.000 Services gestartet (keine Hausnummer) und es wäre mehr als ein Fulltimejob, jeden dieser Dienste auf den individuellen Nutzen hin zu überprüfen. Es gibt also auch Informationsbeschaffungskosten. Wenn es mehr Aufwand macht einen Dienst zu finden als er dann nutzen bringt, dann ist es nicht sinnvoll diesen Aufwand einzugehen. Zum Glück hat das Web Mechanismen etabliert, die einem die meiste Arbeit abnehmen. Die Antwort heisst nicht Massenmedien wie TV, Spiegel oder Heise, sondern Blogs. Einige Tausend Blogger haben es sich zur Aufgabe gemacht wie Eichhörnchen auf die Suche nach dem nächsten grossen Ding zu gehen, sie testen aus, filtern, bewerten usw. Blogs, die sich dabei als besonders gut erweisen bekommen grössere Leserschaften und fungieren als Verstärker. Das heisst nicht, dass sie alles finden oder dass sie das beste toll bewerten, aber im grossen und ganzen funktioniert das nicht schlecht.

Erzähls meim Sackerl

psychohygiene bei gapingvoid

(im nächsten eintrag dann folgende stelle:

Yes, all that talk about “Conversation”, “The Social Graph”, “End of Marketing”, “Advertising Is Dead”, “Authenticity”, “Transparency” and “Bypassing The Gatekeepers” had its place.

At the same time, I think we all collectively wasted a lot of time by endlessly yakking on about it. “Building Brand Advocates through Influencer Engagement” and similar corporate drivel.

I think 2010 will the year we all start actually being more TRANSPARENT about why we’re really here in the first place: To make money.

und mit dem letzten satz ist er, glaub ich, was auf der spur. nicht wegen der antwort, aber wegen der frage. irgendwie sind wir auf so einem nullpunkt angelangt, dass es gar nicht anders geht, als sich diese grundsätzliche frage zu stellen und sich selbst also in diesem ganzen gewirr irgendwie zu definieren. und das könnte spannender werden als im ersten loop des social web (2004 – 2009, r.i.p.), weil der einen guten teil der freigesetzten energie daraus bezogen hat, dass sich diese ganzen möglichkeitsräume erschlossen haben und dass man gwm. während dieser explosion mittendrin steckte und dem universum / der umwelt beim entstehen zuschauen konnte. interessant war aber vor allem die verkoppelung der systeme und subsysteme (im grunde alles mit allem und die menschen zwischendrin und live dabei) selbst, nicht so sehr die spezifische ausdifferenzierung.)

the good, the bad and the ugly

Slavoj Zizek hat in letzter Zeit ja immer wieder die Selbstauflösung des linken Diskurses beschrieben, der verloren hat und nichts anderes mehr tut, als zu versuchen dem rechten Diskurs ein ein bisschen humaneres Antlitz zu verleihen (ein bisschen mehr menschenrechte, ein bisschen mehr soziale gerechtigkeit, ein bisschen mehr umweltschutz, …), die Grundannahmen (globaler Kapitalismus, …) wurden aber als einzige Denkbarkeit geschluckt.

(beispiel etwa seine kritik am oskar-prämierten ‘das leben der anderen’ – der film tut zwar so als wäre er eine abrechnung mit dem system der ddr und der stasibespitzelung, zurückgeführt wird das amorphe böse aber dann auf die jedem nachvollziehbaren egoistischen motive des hauptmanns, der einfach das tut, was jedes gesunde neoliberale subjekt täte, nämlich die zur verfügung stehenden mittel für die befriedigung der eigenen begierden (die frau des anderen) einzusetzen usw.)

Wie stark dieses Subjekt das Denken rahmt zeigt Google, es ist ganz einfach eine Undenkbarkeit, dass es da irgendwas gibt, das so was wie eine Moral hat und tatsächlich auch danach handelt, auch wenn es was kostet.

(allgemein etwa jaja, gut tun ist leicht, solange man davon profitiert, aber wartet nur bis die werbeeinnahmen weniger lukrativ sprudeln, dann wird sich die wahre fratze zeigen (vor kurzem louis gray, glaub ich, finds nicht mehr), klingt ja schön, aber kostet es ihnen wirklich soviel, so toll hat sich das geschäft ja nicht entwickelt, und sie schauen gut aus und bringen andere unter zugzwang, etc., ist es jedenfalls nicht so, dass hinter jedem akt, so gut auch immer er tut, oder so offensichtlich böse auch immer er ist, nicht ganz einfach ein banales eigeninteresse steckt? wo kommen wir denn sonst hin.)

Techblogs des Jahres (2009 Edition)

20082009 war ein ein bisschen durchwachsenes Jahr, was die Entwicklung der Techblogs betrifft. Der Trend von 2007, je populärer desto doofer, hat sich nicht mehr fortgesetzt, die Ausdifferenzierung scheint sich eingependelt zu haben, alle posten alles mit mal mehr mal weniger genuinem Blick, Techcrunch wurde sogar wieder lesenswert, Readwriteweb hat etwas abgebaut, echte Impulse/Inspirationen liefern alle zusammen nicht. Insgesamt scheint es sich aber überhaupt etwas ausimpulsiert zu haben, auch die echten Vordenker (Haque, Engeström, Coates, Shirky usw.) sind eher im Rehash-Modus, im Grunde scheint alles denkbare schon gedacht zu sein, sehr komplex ist das Web ja wirklich nicht, es wird nur oft mit falschen Fragestellungen kompliziert gemacht, wobei es natürlich kein falsche Fragestellungen gibt, wer sich was fragt, der fragt sich das halt, falsch also eher im Sinne von unfruchtbar oder am Thema vorbei, wobei es natürlich auch keine falschen Themen gibt.

Irgendwie reicht es aus, in der Intro aus 2008 das Jahr zu ersetzen, um auch mein Gefühl für 2009 zu beschreiben, vielleicht mit der Anmerkung, dass (in den grossen techblogs mit bildungsauftrag) auch der letzte Funke Eigensinn verschwunden zu sein scheint und die einzige verbliebene Metrik für Wert irgendwelche quantifizierbare social media Zahlen sind, was aber im Grunde egal ist, weil sich die Sinnstiftung ohnehin auf den jeweiligen Tools idealerweise organisch entwickelt.

Anyway, die zwei für mich besten Techblogs 2009 waren TechCrunch und echovar. TechCrunch zu nennen ist zwar ein bisschen doof, aber seit sie ihre Position als make-or-break Blog verloren haben (es gibt immer ein mashable, lifehacker, makeuseof, killerstartups, … die alles posten und die dann eine welle triggern können, die alle erreicht) ist die Auswahl der vorgestellten Startups tatsächlich qualitativer geworden und weniger an eine persönliche Gunst gebunden. Dazu kommt ein MG Siegler in Hochform und im Vergleich zu den anderen am wenigsten völlig urteilskraftloses Blabla. echovar (hattip @frankwestphal) war mein Lieblingstechthinkblog. Cliff Gerrish gelingt es ganz grossartig, Techtrends mit Theorie zu lesen ohne das eine für das andere einzuspannen oder vorher schon zu wissen, auf was er hinauswill.

the springs

präzisierende nachfrage: abgesehen von “warum gerade formspring “ (antwort: zufall, abweichungsverstärkung, kritische masse, zackwumm), warum ist so was im prinzip faszinosum für viele?

a in zeitknappheit:

(voraussetzung)

- es ist einfach genug und das prinzip (ah, ich kann entweder eine frage stellen und der antwortet dann oder ich melde mich an und dann können mir andere fragen stellen und ich antworte dann) erschliesst sich den meisten (und jedenfalls allen, die schon ein twitter-account haben) auf den ersten blick.

(distribution)

- die verbreitung hat virales potential. wer angefixt ist will mehr und promotet sein formspring auf twitbook, und weil es einfach genug ist und es sich auf den ersten blick erschliesst, probieren andere das auch.

(narzissmus)

- es hat eine narzisstische komponente (schmeichelfaktor, dass irgendwer gerade von mir etwas wissen will, ich bin das subjekt, dem wissen unterstellt wird, usw.)

- damit verbunden ein emotionales attachment (muss mal die inbox checken, ob es neue fragen gibt)

(platt-form)

- es hat die essenz des prinzips frage&antwort (das es ja im web in hunderten variationen gibt und das sich auf sokrates und sicher auch bis in die steinzeit zurückverfolgen lässt) gwm. als fundamentalen datentyp extrahiert, indem es alle üblichen kontextualisierung eliminiert hat. und es hat sich selbst als plattform dafür etabliert.

- die form ist deshalb also flüssig und passt sich an jede individuelle interpretation an. man kann witzig, eloquent, ehrlich, whatever antworten (bzw. fragen) und soviel aufwand reinstecken, wie man will.

- gleichzeitig sind die formsprings öffentlich aber non-kompetitiv. öffentlich ist wichtig, weil man sonst auch via email, via dm etc. fragen könnte, die öffentlichkeit führt aber die phantasie der universalität und der ‘verantwortung’ ein, weil es publiziert ist; non-kompetitiv ist auch nicht unwichtig, weil man auf seinem platzerl machen kann was man will, und es ist ok.

- das führt wiederum dazu, dass man die wunderlichsten blüten sieht. menschen haben einen eingebauten spieltrieb, und je offener das rohmaterial und das endergebnis ist, desto grösser ist das potential für diverseste spannende selbstselektionen und ausdifferenzierungen.

- unter anderem, weil es reize von aussen gibt, die diskurse triggern

- diese individuellen ausdifferenzierungen führen wiederum zu kollektiven lernprozessen und feedbackschleifen. wir sind affen und haben neben dem spieltrieb ein eingebautes mimetisches potential, machen also das beste nach, bauen darauf aber auch auf. frage hier ist, wieviel davon nachhaltig handlebar wird, sich als stil etablieren kann usw.

((limits))

- es skaliert wohl nicht. es ist lustig, am ersten, zweiten und dritten tag drei (oder bei entsprechender disposition fünfzig) fragen zu beantworten oder sich selbst fragen zu stellen, die man schon immer beantworten wollte. wochenlanges beantworten von hunderten fragen am tag wird, glaub ich, mühsam. zunächst sind alle fragen toll, fragen werden sich wiederholen, werden irgendwann lästig usw. das muss nicht so sein, aber gefühlsmässig fackelt sich das potential ab.

- und wenn die mischung irgendwann nicht mehr stimmt, setzt eine abwärtsspirale ein (man antwortet nicht mehr, oder ungelaunt, das wiederum reduziert die motivation fragen zu stellen etc.)