Selection 2012

New Year's Resolution 2013 Pt. 4

#nts was ich wirklich einmal einfach rein psychohygienisch für mich machen sollte, wäre diesen komplex (dumme) materialität – realität – potentialität – virtualität – virealität usw. zu konkretisieren und terminologisch abzustecken. kann ruhig idiosynkratisch sein, aber eine gewisse festlegung vereinfacht den kognitiven overhead sicher. was sagt man zb, wenn man die grundsätzliche totalität aller möglichkeitsräume einer sache bezeichnen will (die totalität der möglichkeiten von blogs, twitter, facebook, …)? oder was sagt man, wenn man den konkreten, durch das (historisch natürlich kontingente) dispositiv gefilterten und also aber auch aktualisierbaren möglichkeitsraum einer sache bezeichnen will (die zu einem jeweiligen zeitpunkt konkret möglichen realisierungen der möglichkeiten von blogs, twitter, facebook, … sowie die damit verbundenen milieuverschiebungen)? und wie bezeichnet man die übergänge von potentialitäten zu realitäten oder (auf der ebene des imaginären realen) virtualitäten? welche funktionen gibt es überhaupt, die zwischen den aggregatzuständen vermitteln? und natürlich das web als möglichkeitsraum für möglichkeitsräume usw.

Lazy Blog Ep. 17

(blogpost über DAS fundamentale dilemma im derzeitigen web: den umstand, dass das dilemma (meta!) immer als krise der startups lokalisiert wird, was in der folge dann zu vielleicht nicht schädlichen, aber unterm strich völlig sinnlosen massnahmen und prozessen führt, während wir es eigentlich mit einer krise der user zu tun haben, die man natürlich auf ganz andere, wesentlich effizientere weise adressieren könnte.)

((ich weiss, ich wiederhole mich auch wie eine auslaufrille, aber mit ein wenig webtechnischer basisbildung würden sich 95% aller diskussionen und die meisten ignorant-radikalen positionen von allein erledigen und die energie könnte in produktivere und kreativere diskussionen und aktivitäten gesteckt werden. und das wäre, was die startups mehr bräuchten als alles andere, weil sich die qualität ihres eigenen angebots natürlich nur in dialektik mit den usern entwickeln kann, etctrara. bonuspunkte wie immer für konkrete fallstudien, sternchen für eine umfassende typologie einer web literacy))

Lazy Blog Ep. 16

(blogpost über DAS fundamentale dilemma im derzeitigen web: den umstand, dass blogs zwar tatsächlich ein ‘ideales’ format sind, dass das ihnen inhärente potential aber gedämpft wird, weil sie selbst in der triade produktion/distribution/rezeption nur die produktions- und rezeptionsbedingungen in der eigenen hand haben, nicht aber die distributionsketten. die tragik des dilemmas ist, dass die distribution grundsätzlich gelöst ist – aka google reader -, dass der dafür notwendige aufwand aber, so minimal er ist, eine unüberwindbare hürde darstellt. bonuspunkte wie immer für konkrete fallstudien, welche alternativen serien mit welchem erfolg entstehen (tumblr, das eigene distributionscommunities via following und likes etabliert, etc.) und sternchen für eine umfassende typologie aller textbasierten formate)

Die Zeitgenossen der Gesellschaft Pt. 5: Die Bauchrednerpuppe

Die Bauchrednerpuppe ist ein in letzter Zeit öfter gesehener Zeitgenosse, der sich dadurch auszeichnet, dass er Aussagen produziert, die ganz offensichtlich von woanders her kommen und dabei ein unheimliches Verhältnis zum Ausgesagten definieren.

Die Aussagen selbst sind dabei oft gar nicht falsch, die verwendeten Wörter stimmen alle und stammen aus dem aktuellen Diskurs. Was aber irgendwie nicht stimmt ist die Rekonstruktion der Position aus der sie gesagt werden. Wenn man will kommt es zu keiner Schliessung zwischen den Wörtern und den Worten im Imaginären.

(nur als beispiel: einige stellungnahmen oder programme von organisationen oder parteien klingen in letzter zeit entgegen jeder davor gezeigten disposition plötzlich, als wären sie mal schnell von netzpolitik via copy und paste genommen. inhaltlich ist es nicht zu kritisieren, aber man spürt auf der anderen seite der signifikanten nur einen unheimlichen abgrund)

(den begriff beziehe ich übrigens weniger auf subjekte als auf den diskurs selbst; ein verwandtes, aber genuin davon zu unterscheidendes phänomen ist das von they live bekannte prinzip des geheimen/anderen subtextes, also das eine zu sagen aber das andere zu meinen. bei der bauchrednerpuppe ist das verhältnis zum gesagten selbst gespenstisch)

(abt. supermarket studies)

Bartleby

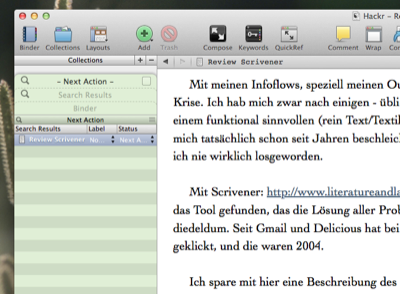

Mit meinen Infoflows, speziell meinen Outputflows, stecke ich ja schon lange in der Krise. Ich hab mich zwar nach einigen – üblicherweise reduzierenden – Iterationen auf einem funktional sinnvollen (rein Text/Textile basierten) Setup eingependelt, aber dieses mich tatsächlich schon seit Jahren beschleichende Gefühl der Nicht-Zeitgemäßheit bin ich nie wirklich losgeworden.

Mit Scrivener habe ich jetzt vielleicht das Tool gefunden, das die Lösung aller Probleme und die Erfüllung aller Hoffnungen ist, diedeldum. Seit Gmail und Delicious hat bei mir kein Tool mehr so schnell so intensiv geklickt, und die waren 2004.

Ich spare mir hier eine Beschreibung des Funktionsumfangs und eine Auflistung aller Vor- und Nachteile, aber vl. kann ich einen von euch mit zwei Anmerkungen etwas dafür interessieren, Scrivener gibt’s nämlich noch 4 Tage oder so im Macheist 4 Bundle , ist derzeit also auch ein Schnäppchen:

1. es geht Scrivener um ein Recherche-basiertes Schreiben, und das spürt man in vielen getroffenen Entscheidungen. Wer also primär am Layout von Texten arbeiten will, ist bei Scrivener falsch (wobei ganz normale Formatierungen oder Layouts ganz normal möglich sind). Wer Texte kollaborativ erstellen will, auch (wobei auch das über den Folder-Sync möglich ist, zumindest was Inhalte betrifft). Wer aber Texte zerstückeln, bearbeiten und dann wieder (gleich oder anders) rekombinieren will, wer Texte effizient und mit Keyboard-Shortcuts unbundlen und rebundlen will, wer neue – via Suchen, Labels oder Metatags parametrisierbare – Schreib- und Leseflows tatsächlich spüren und ausprobieren will, der ist bei Scrivener richtig. Und das klingt jetzt viel abstrakter als es ist und es stimmt eigentlich gar nicht, dass man diese Funktionen für einen ich sag mal ‚postmodernen‘ Schreibstil haben wollen muss. Eher umgekehrt: die von Scrivener offerierten Funktionen Texte zu splitten, als Chunks zu editieren, beliebig zu verschieben und (re-)organiseren und zu (re-)kombinieren läuft völlig intuitiv ab und dient nur dem Zweck, leichter und besser zu schreiben. Auch die (in einigen Reviews gelesene und anscheinend recht verbreitete) Verlustangst über die Integrität des Textes ist völlig unbegründet – die Ansicht über den gesamten Text ist immer nur einen oder maximal zwei Klicks entfernt und auch der Export zu einem finalen ‚Werk‘ – neben PDFs und RTFs und einigen anderen Formaten kann man den Text übrigens auch als E-Book (epub, kindle, sogar iBook) kompilieren – geht ruckzuck.

2. Scrivener ist offen genug. Was man reinsteckt und drinnen verfasst bekommt man zumindest als PDF, RTF oder TXT auch wieder raus. Und noch besser: Projekte können mit Dropbox synchronisiert werden. Der eigentliche Text kann also grundsätzlich mit jedem beliebigen Editor und auf jedem beliebigen Gerät verfasst (oder erfasst) werden. Scrivener lässt sich also in andere Workflows integrieren und kann andere Workflows integrieren.

Nützliche Unterscheidungen pt. 7 (The Moo Edition)

Eine weitere besonders nützliche Unterscheidung ist ganz sicherlich die Unterscheidung: ist ein Argument ein Moo Point oder nicht?

Das Konzept des Moo Points stammt natürlich von Joey Tribbiani: ein Argument, das so relevant ist, wie die Meinung einer Kuh. Unwichtig, also moo.

(nur als kleines beispiel: sagt man etwa etwas negatives über app.net, kommt unweigerlich einer angelaufen, der sagt: „aber du übersiehst den wichtigsten punkt. app ist kein twitterklon, app will viel mehr – ein central messaging bus für das offene web, ein offenes ökosystem/plattform und nicht nur die app (haha) – sein, offeriert ja eine uneingeschränkte API, etc..“ das problem dabei ist natürlich, dass es einen unterschied zwischen dem ‘etwas sein wollen’ oder dem ‘sagen etwas zu sein’ und dem ‘etwas sein’ gibt.

es ist dabei durchaus legitim, den eigenen ansatz zu kommunizieren und mit den technischen attributen zu bewerben. aber es liegt im wesen von netzwerk-, plattform- und ökosystemeffekten, dass sie erst ab einer gewissen größe auftreten. bis dahin ist das kommunizieren des potentials – und das haben vor app schon dutzende sich anschickende ökosysteme gemacht und das werden auch nach app noch dutzende sich anschickende plattformen machen – eben leider moo. was wiederum nicht gegen app spricht, aber halt das argument relativiert)

(abt: draw the distinction!)

Die Zeitgenossen der Gesellschaft Pt. 3: Der Sturschädel

Der Sturschädel bleibt stur bei einer Verhaltensweise, die er als richtig empfindet, auch wenn ihm die Welt das Gegenteil sagt.

Dabei ist grundsätzlich egal, ob er mit seinem Konstrukt ‘hinten’ oder ‘vorne’ ist, ob er re- oder deterritorialisieren will, ob er alte Machtstrukturen bewahren oder utopische Kraftstrukturen bewirken will – der Punkt ist, dass er sein Handeln an seinem Glauben wie es sein sollte und nicht an der Welt wie sie ist ausrichtet.

(für systemische ausdifferenzierungen ist der sturschädel wichtig, weil er – anders als der binäre switcher oder der solipsistische generalisierer – verharrt und damit stabilisiert; ein system bekommt natürlich ein problem, wenn es zu viele sturschädel gibt. und er ist wichtig, weil ‘glaube’ auch systemwirksam werden kann)

(abt. supermarket studies)

Nützliche Unterscheidungen pt. 5 (The Inception Edition)

Eine weitere besonders nützliche Unterscheidung ist ganz sicherlich die Unterscheidung: auf welcher Ebene befinde ich mich mit meinen Unterscheidungen (meta!) und Beschreibungen und was bedeuten die diagnostizierten Effekte und Gesetze eigentlich eine Ebene darüber oder darunter?

(systemtheoretisch stellt sich diese frage natürlich nicht, weil in den systembeschreibungen davon ausgegangen werden kann, dass die jeweiligen systeme ihre selektionsroutinen usw. selbst generieren, da ist es wenn als strategische kalkulation der möglichen umweltreaktionen relevant, das für sich durchzuspielen; die vorgeschlagenen unterscheidung meint eher die groben vertikalen schichten; und da vermute ich, dass von vielen auf der einen ebene stattfindenden prozessen, beschleunigungen und potentialitäten oft – sicher nicht immer, es gibt natürlich eine ganze palette der möglichen interpenetrationen und nichtlineare relationen wie tipping points – auf der anderen eigentlich wenig übrigbleibt, zb weil die betrachtete ebene das phänomen ganz gut einkapselt; sprich: manche dinge wirken zwar unglaublich interessant, sind aber schon eine ebene höher völlig irrelevant)

(abt: draw the distinction!)

Near Miss Squirrel

In einer Zeit technischer Perfektion ist der gut ausgewählte near miss interessanter als das, was das System für einen hit hält.

(irgendwie eine gute zustandsbeschreibung von eigentlich fast allem; auch diskurse etwa brauchen ‘ausgewählte’ unscharfe begriffe/müssen ein katalysierendes mass an fehlern und irritation enthalten, um anschlussfähig zu bleiben, eine lücke im realen offen zu lassen, usw.)

Nützliche Unterscheidungen pt. 4 (The Problematic Edition)

Eine weitere besonders nützliche Unterscheidung ist ganz sicherlich die Unterscheidung: ist etwas ein Problem oder nicht? wenn man nur solche Dinge als Probleme definiert, die sich nicht durch ein zumutbares Maß an wissbarem Wissen oder machbarem Machen von selbst erledigen.

(das ist natürlich eher eine phantastische differenz, weil man deren effekte nur selbst aber dafür sehr bestimmt sieht)

(abt: draw the distinction!)

Nützliche Unterscheidungen pt. 2 (The Society of Control Edition)

Eine weitere besonders nützliche Unterscheidung ist ganz sicherlich die Unterscheidung brauch ich die publizistische Kontrolle über meinen Output/oder nicht.

Die muss man niemandem erklären, aber es ist eine andere Sache, den eigenen Output dann auch (a) tatsächlich so zu unterscheiden und dann (b) auch an die Unterscheidung zu halten und das geeignete Medium zu wählen.

(ein nicht nur gelegentlich gesehenes problem entsteht dann, wenn man so tut als müsste der inhalt unbedingt unter der eigenen kontrolle stehen, man aber gleichzeitig eine plattform wie facebook/twitter/g+ verwendet, die jederzeit ihre bedingungen ändern kann und das in der vergangenheit wohl auch getan hat. der saure apfel ‘gut, dann hoste ich das selbst’ ist da zwar die eine option, die andere ist aber, einfach den anspruch an die kontrolle bewusst abzugeben; dann lebt es sich leichter und man kann es sich auch in einem (mit sterling gesprochen) favela gemütlich machen und die kommunikation eher als mündliche und abschreibbare zu verstehen, was sie in den meisten fällen ohnehin ist, nur fallen die kosten für das so-tun als wär es nicht so und die gesamte unsicherheit weg)

(abt: draw the distinction!)

Nützliche Unterscheidungen pt. 1 (The Trinity Edition)

Eine besonders nützliche Unterscheidung ist ganz sicherlich das Bündel der Dreiheit Produktions-, Distributions- und Rezeptionsbedingungen.

Wenn man sich überlegt, welche Auswirkungen das Web (oder eine neue Technologie, oder eine soziale Praktik oder Plastik, etc.) auf die Art, wie und warum wer oder was produziert, wie und warum das in der Folge verteilt werden kann, wer was wie und warum konsumiert haben könnte und wie sich diese drei Faktoren auch wechselseitig beeinflussen und zu welchen Milieus sie sich formieren könnten, dann bekommt man eine durchaus gute Intuition von den mittelfristig erwartbaren Effekten.

Man kann damit nicht wissen, wie sich das dann im Detail realisieren wird, aber man wird sich über wenig wirklich wundern müssen und man wird auch naive Vorhersagen oder Arbeiten an unfruchtbaren Äckern als solche erkennen können.

(abt: draw the distinction!)

—

ad hoc bonus case study: bildung

(nur als oberflächlich angerisses beispiel zur bestimmung des ballparks könnte man sich zb die frage stellen, wie sich das internet auf unser bildungssystem, unsere ausbildung, weiterbildung, bildungsinhalte, etc. auswirkt. konkrete analysen sind natürlich etwas differenzierter und ich schliesse hier die ‘erzeugung von neuem wissen’ aus, da schaut es nämlich etwas anders aus und kombiniert würde das schnell wieder eine verkettung von bedingungen und ein- und ausschlussklauseln etc. geben. und ich schliesse hier auch konkretes handlungswissen wie kochen oder stricken oder diy etc. aus, auch das hat nämlich wieder eine andere dynamik. der faktor produktion bezieht sich also eher auf die erzeugung und bündelung von (durchaus auch nano- aber) kanonischen lehrinhalten. und es geht auch nicht um die problematisierung der gesellschaftlichen interpenetration, also die funktion von ausbildung als produktionsfaktor von arbeitsfähigen subjekten, etc. als beispiel hier geht es wirklich nur – und das ist ja trotzdem massiv – um die dynamik der vermittlung bestehender wissenssysteme, also schulwissen und nicht forschendem universitärem und sonstigem fachwissen)

- produktion

schocker: im bereich der produktion ändert sich nicht viel.

(grund: es bleibt im grunde genauso teuer, inhalte zu erzeugen und die ‘kosten’ dafür liegen jedenfalls deutlich über dem ‘ich mach dann halt mal so’, das sieht man jetzt schon auf vielen lernplattformen mit ugc: nach dem hello world ‘so geht in javascript die for-loop’ verlässt fasst alle die lust. es ändern sich teilweise die motivationsstrukturen, einige sonderfälle werden sicherlich getriggert; vor allem bei inhalten an den rändern wird man das vl. auch spüren; und es gibt einige neue formen – youtube, ipad, plattformen wie moodle oder course builder – die befüllt werden wollen, aber that’s about it.)

((in einer zweiten iteration gibt es dann eine riesiges möglichkeitsfenster für die, die die inhalte unter den neuen distributions- und rezeptionsbedingungen reproduzieren, man denke an udacity, wenn sie ihren coursera-komplex nicht hätten, aber auch das ist ein eher triviales und rein technisches problem. die inhalte selbst sind da.))

- distribution

omg: hier ändert sich alles, das problem ist mit dem web im grunde gelöst.

(sprich: das gesamte wissen – das gesamte schulwissen und jede vorlesung und die gesamte aufgezeichnete vorgeschichte – könnte grundsätzlich jedem zur verfügung stehen. nur inhalte, die sich explizit verweigern, würden es nicht. aber auch die verweigerung tut (anders als bei anderen bereichen wie literatur, film oder musik) dem system nicht weh, weil dann halt ein anderer (oder tausend andere) den inhalt zur verfügung stellt.)

- rezeption

autsch, die wird für den ‘lernenden’ teuer, plötzlich hat nämlich er das problem.

(etwas überspitzt sehen wir den übergang von einem vorgegebenem linearen system mit wenigen auswahlmöglichkeiten – welche schule vor ort, ggf. welcher studiengang bei welcher uni – bei denen die leistung institutionell überprüft und sanktioniert wird zu einem völlig rhizomatischen system mit hundertausenden ein- und ausgängen. das ist zwar grundsätzlich super, aber die möglichkeiten triggern eine palette an problemen – suche von inhalten, die riesigen kosten der bewertung von inhalten für den lernenden, motivation, legitimation, etctrara. -, die eine lösung suchen und deren ausdifferenzierung das feld in den nächsten jahren massgeblich festlegen werden (und wo es noch lange nicht ausgemacht ist, welcher anteil am potential freigesetzt werden kann, wir sehen jetzt schon, wie sich frühe verkrustungen bilden, wie etwa coursera die luft aus dem raum ‘vertrauen durch reputation’ saugt)).

(abt: draw the distinction!)

Lazy Blog Ep. 12

(blogpost über DAS fundamentale dilemma im derzeitigen web: den umstand, dass man irgendwann voll ist – voll an tools, die man verwendet; voll an feeds, die man abonniert hat; voll an ‘freunden’ bei tfg+, etc. – und dass sich völligkeitsbedingt aber verkrustungen bilden und man immer weniger im strom schwimmt; bonuspunkte für eine theorie der escape velocity dafür)

Swan Farming

Paul Graham’s September Sermon geht um schwarze Schwäne und gute schlechte Ideen.

Seine Theorie der guten schlechten Idee orientiert sich dabei an Peter Thiel und geht etwa so:

der sweet spot für Startups sind Ideen, die wie schlechte Ideen klingen (sonst wären sie schon gemacht1) aber gute Ideen sind (sonst wär es witzlos sie zu machen) und nur die Gründer erfolgreicher Startups erkennen das.

Facebook zb. klang für ihn wie eine wirklich blöde Idee – eine Seite auf der Studenten abhängen könnnen, wtf – aber Zuckerberg hat das durchschaut und jetzt sehen wir ja wie nützlich so eine Weitsicht sein kann.

Die falsche Grundannahme – wir kennen das Thema langsam – ist natürlich zu glauben, dass Ideen schon mit einer ihnen eigenen inhärenten Qualität geboren / formuliert werden. Die Qualität / der Wert einer Idee ist ihr aber nicht eingebaut, also kein latentes Potential, sondern ein Virtual für alle möglichen Zukünfte, das nur retrospektiv in seiner Realisierung beschrieben werden kann.

(etwas schwammige analogie: aus jedem spermium oder eizelle könnte der nächste zizek werden und aus einigen wird auch zumindest was respektables, aber man sieht es halt nicht unter dem mikroskop)

((wenn man will ist graham also ein naiv/romantischer modernist, während die samwers schon viel weiter sind und eher als zynische postmodernisten beschrieben werden können; auch bzgl. der phantasie sind die samwers weiter als graham: paul träumt eher davon, dass sich investments vermillionenfachen und sich die startups in ein schlaraffenland verwandeln; die samwers suchen eher die intensitäten an den oberflächen))

1 man fühlt sich auch an den witz erinnert, bei dem ein ökonom auf der strasse 20 dollar sieht, sie aber nicht aufhebt, weil sie schon ein anderer aufgehoben hätte, wenn es echte 20 dollar wären

Lazy Blog Ep. 8

(blogpost über DAS fundamentale dilemma im derzeitigen web: den umstand, dass von allen – ich sag mal – massensozialen plattformen, also google, facebook, apple und twitter, ausgerechnet facebook als einzige alles (ok, den börsengang vl. ausgenommen) richtig macht, während alle anderen immer noch sozialdümmer werden und ihre eigentliche grimasse zeigen. bonuspunkte für einen schlüssigen quadranten der sozialen kompetenz, falls sich einer anbietet, etwa: facebook will und kann, google will und kann nicht, twitter will nicht und kann, apple kann nicht und will nicht oder so)

Text and Nothingness

noch ein quiz und ich unfollowe mich.

— Markus Spath (@hackr) August 22, 2012(nts: mich öfter selbst zitieren)

sorry, eindeutig zu viele quizzes lately. also nur noch schnell meine antwort für quiz pt. 67 die natürlich mit dem gleichen grundgedanken spielt, wie social and nothingness, die antwort auf quiz pt. 64, nämlich dass sascha schon wieder (genauer gesagt auch schon davor) den falschen prozess (bloggen erleichtern) für das falsche problem (texte aus den klauen der plattformen emanzipieren) fordert. ich ersetze mal in social and nothingness sozial mit diskurs:

“die falsche grundannahme (nicht nur von lobo, auch von allen anderen ohnehin reflexartig geforderten ‘befreiungen’ von auf ‘geschlossenen’ plattformen geführten texten, aussagen und diskursen) ist, dass es ein abstraktes mitgeteiltes gibt, das eine öffentlichkeit sucht.

es gibt aber keinen ungebunden diskurs, der an keine konkrete formation gebunden ist. diskurs ist im web immer an eine konkrete formation (und deren je spezifische produktions-, rezeptions- und resonanzbedingungen) gebunden. vielleicht nachvollziehbarer: es gibt auch kein abstraktes bedürfnis sich mitzuteilen, für das man nur einen container sucht, und falls es der eine nicht tut, dann verwendet man halt den anderen. jede erfolgreiche plattform erzeugt ihre diskurse aus dem nichts. (das ist die saure lektion, die blogger noch verstehen müssen.) und es gibt auch keinen abstrakten text, den man halt bei gelegenheit aus facebook oder twitter oder g+ ausräuchern und an einem offenen blog in freiheit reterritorialisieren könnte.

der diskurs ist nicht die ursache für, sondern der effekt von plattformen (und wieder: deren je spezifische produktions-, rezeptions- und resonanzbedingungen). und das verhältnis ist nicht struktur-funktional, sondern – wenn man will – quantenphysikalisch.”

(passt zwar nicht ganz, aber gar nicht so schlecht. wer sich betätigen will: siehe Lazy Blog Ep. 3)

Quiz Pt. 65 Solution

da anscheinend nix mehr kommt: meine antwort für quiz 65 ist:

weil wir die zukunft nicht kennen und wir deshalb damit die soziale zukunft ausdünnen und austrocknen würden.

(für soziale netzwerke zu bezahlen und diese dadurch von anderen monetarisierungsnotwendigkeiten zu befreien, könnte dann funktionieren, wenn wir (1) in der gegenwart aus der zukunft zurückblickend wissen könnten, welche plattformen wir in der zeit zwischen der gegenwart und der zukunft benützen werden, und wir (2) auch wissen, dass alle anderen die gleiche zeitmaschine haben und das also auch für sich wissen, und wir (3) davon ausgehen können, dass sie sich dann auch wie wir denken: ja ok, $x im jahr ist mir das wert, das bezahl ich doch gerne.

aber dieses wissen haben wir natürlich nicht. ‘das soziale’ ist ein bienenstock und niemand KANN im voraus wissen, wie und wo er sich manifestiert. die ausdifferenzierung der sozialen plattformen erfolgt organisch, jeder betreibt andauernd trial und error, probiert die plattform aus, ‘interpenetriert’ sich mit dem jeweiligen system, verwirft den grössten teil, lässt sich auf wenigen nieder. dabei entstehen natürlich stabilere temporäre strukturen und krusten wie facebook oder twitter, aber es gibt immer und jederzeit auch die möglichkeit zu brüchen und paradigmenwechseln, etctrara. aber um das geht es hier nicht, der für die frage relevante gedanke daraus ist:

dass geld, und zwar schon der kleinste symbolische obolus, die ‘freie’ ausdifferenzierung des sozialen verstopft, weil man auch als wohlgenährter mittelschichtler mit kreditkarte (und auch das ist eine durchaus zu problematisierende voraussetzung und aber auch das ist ein anderes thema) sich gerne bei einer, wenn es sein muss sicher auch bei zwei oder drei kostenpflichtigen plattformen anmeldet, aber sicher nicht bei zehn oder zwanzig oder allen 20.000, die es gibt. 15 euro im monat für sozial, na gut, wäre denkbar. 100 dann wohl nur ungern und 100.000 im monat ganz sicher nicht. der gesamte möglichkeitsraum wird künstlich verknappt, aus der losen koppelung ‘wohin es uns trägt’ wird die enge koppelung ‘wofür wir bezahlt haben’.

und da gehen die probleme dann aber erst los. wie gesagt: wir wissen nicht, für was wir uns in einem jahr entscheiden würden. bei einem kostenpflichtigen dienst legen wir uns aber quasi jetzt schon darauf fest. und es gibt ganz pragmatische probleme wie die frage: was passiert mit meinen daten, wenn ich in zwei jahren nicht mehr zahle, weil ich zu einer anderen plattform wechseln möchte? (es könnte eine garantie der konservation geben, aber alle beispiele, dich ich kenne, löschen das einfach aus dem system und man steht schlechter da als bei jeder kostenlosen plattform). und für welche plattform entscheidet man sich, wenn die einen freunde auf der einen und die anderen auf der anderen und die kollegen auf der dritten sind? individuell werden also die möglichkeitsräume eingeschränkt und die auswahl wird künstlich limitiert. die plattformen selbst werden sozial eingeschränkt und also ökosystemisch uninteressant, was mitunter den effekt hat, dass die katalysierende kritische masse überhaupt nicht mehr erreicht werden kann. usw. man kann das noch lange weiter spinnen, es ist einfach eine wirklich nette aber blöde idee.)

Message from the Desert of the Real

passenderweise stellt auch Twitter die neuen Regelungen für die Twitter API vor.

Unterm Strich machen sie eines: sie transformieren sich von der Larve 140 Char in ihre Endform den Tweet, für dessen angemessene Darstellungen nicht mehr Empfehlungen sondern verpflichtende Richtlinien gelten. Systemtheoretisch verabschieden sie sich von den unendlichen Möglichkeiten einer losen Koppelung, bei der es Systemen völlig frei steht, wie sie Twitter interpretieren (alles was mit 140 char möglich ist, was natürlich den gesamten empfehlungsraum an links, aber auch alle formen der selbstorganisation via konventionen, adhoc standards, whatever, und alle formen der reinterpretation beinhaltet), hin zu einem von Twitter kontrollierten Subset der Möglichkeiten mit vorgeschriebener Koppelung, bei der Systeme jederzeit auch ausgeschlossen werden können.

Jeff Winger

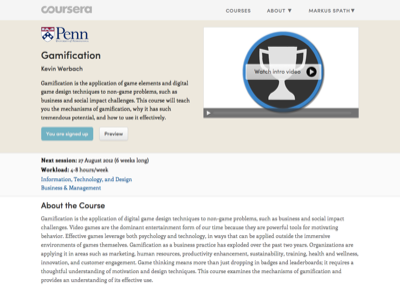

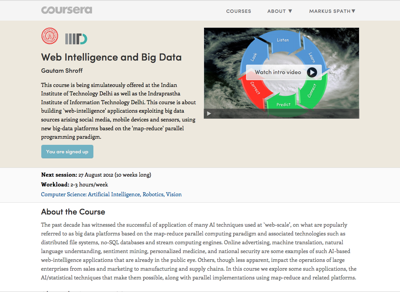

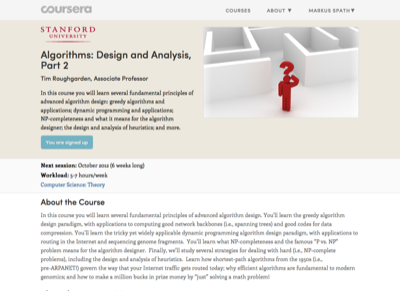

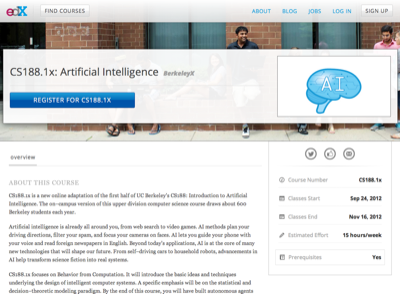

huch, der kommende Pulsschlag an Kursen von Coursera und Udacity hat schon wieder eine Tendenz zu Mathematik/Algorithmik/Big Data:

Making Math Matter (Udacity, ab 3.9.)

Intro to Theoretical Computer Science (Udacity, ab 1.10.)

Gamification (Coursera, ab 27.8.)

Web Intelligence and Big Data (Coursera, ab 27.8.)

Social Network Analysis (Coursera, ab 1.9.)

Networked Life (Coursera, ab 1.9.)

Introduction to Mathematical Thinking (Coursera, ab 17.9.)

Computing for Data Analysis (Coursera, ab 24.9.)

Algorithms: Design and Analysis, Part 2 (Coursera, ab 1.10.)

Artificial Intelligence (edX, ab 24.9.)

Coursera hat sich meine Kritik in Craig Pelton übrigens zu Herzen genommen und deutlich in das Design investiert, teilweise haben sogar die Kurse einen Hauch an eigenem Branding.

Übrigens sickerten unlängst einige Details zu den Deals zwischen Universitäten und Coursera durch und einerseits muss man sich dann schon wundern, andererseits wundert man sich über was anderes nicht mehr:

Die Unis bekommen für die Veröffentlichung der Kurse je nach Lebensdauer auf Coursera zwischen 6 und 15% der Einnahmen, worin die Einnahmen bestehen ist aber noch unklar, ein paar Überlegungen gibt es aber bereits.

Dass die Unis dabei mitmachen, ist das Verwunderliche. Ich vermute es liegt daran, dass sie die Karotten ’1 Mio Studenten’ und ‘es ist 11:55’ vor die Nase gesetzt bekommen, ohne eigene Handlungskompetenz als mögliche Alternative zu sehen. (ist natürlich spekulativ, aber es deutet einiges darauf hin, u.a. die von einigen professoren gebetsmühlartig wiedergegebenen floskeln mit teilweise jenseitiger einschätzung des impacts ihres kurses.)

Dass die Kurse bei Coursera sind wie sie sind, ist das damit Erklärte. Natürlich wird unter diesen Konditionen der Aufwand minimiert und also die ohnehin vorhandenen Vorlesungen halt wo notwendig adaptiert.

Udacity ist gleichzeitig in den letzten 2 Monaten ein bisschen vom Pfad abgekommen. Ich habs ja hier schon angedeutet, für Udacity war dieses Hexamester inhaltlich eine kleine Katastrophe – von einem angekündigten Kurs zum SE hat man überhaupt nichts mehr gehört, der Mathematikkurs wurde zunächst mit fadenscheinigen Argumenten verschoben, und jetzt gecancelt, der Statistikkurs war zwar eigentlich nicht schlecht, der gecover’te Raum spannte sich von basics, über charts, Mittelwerte, Varianz, Wahrscheinlichkeitstheorie, Bayes, diversen Verteilungen, Vertrauensintervallen und statistischen Hypothesen bis zur linearen Regression, allerdings war auch vieles schlampig, unfertig, ungetestet und irgendwie adhoc begonnen und mittendrin beendet, der Algorithmenkurs war recht nett, siehe unten, der Physikkurs war angeblich sehr gut, der Softwaretestingkurs war ich würd einmal sagen auch nicht schlecht und teilweise interessant aber insgesamt durchwachsen und nicht wirklich udacious.

Allen gemein war leider (und wirklich völlig unverständlicherweise, sie sollten die bedeutung kennen), dass die formale Konsistenz mehr oder weniger aufgegeben wurde. Statt einem erwartbaren Puls mit mütterlichem Behagen für die Studenten – alle 9 wochen ein neuer jahrgang mit 4 oder 5 neuen kursen, alle kurse dauern 7 wochen, jeden montag gibts neue inhalte, jeden dienstag gibts neue problem sets und die auflösung der letzten woche, exams in der letzten wochen mit deadline, usw. – sind sie einerseits zu einem völlig offenen Format für alles gewechselt (start, dauer und exam wann man will), wurden andererseits aber beim Posten neuer Inhalte ebenso ungenau (nicht fertig, technische probleme, inhaltliche probleme bei den formulierungen und den gradern).

Ihre eigentliche Hauptleistung – die Synchronisierung der Zeitlichkeiten – haben auch sie gegen die Werbebotschaft ‘join the revolution’ eingetauscht, nur dass sie es eher den Medien und nicht anderen Unis erzählen, die Kosten dafür sind, dass sie sich plötzlich mit allen anderen mehr oder weniger statischen Angeboten vergleichen lassen müssen, und bei allen Bereichen in denen es einen definierten Kanon gibt, werden sie es schwer haben. Ihre andere Hauptleistung würde ich in Anlehnung an opinionated software ‘opinionated education’ nennen, und da haben sie nach wie vor die Nase vorn und wohl mittelfristig zumindest von coursera und edx und der khan academy nichts zu befürchten.

(uff, das wird mir zu lang, den oben versprochenen vergleich der algorithmuskurse bei coursera und udacity spar ich mir, nur ein satz dazu: man konnte die jeweiligen vor- und nachteile der jeweiligen ansätze fast in reinkultur beobachten und für den interessierten schüler ist tatsächlich die heterogenität das tüpfelchen auf dem i)

Appheimer

Der zweite Megatrend 2012 sind ganz eindeutig diese überall aus dem Boden schiessenden Boutique-Networks.

(als boutique-netzwerk bezeichne ich all jene webapps und ggf. plattformen, die ihr primäres momentum aus der vernetzung einer kleinen gruppe von gründern/bloggern/angels im valley und in sf beziehen oder den zugang dazu überhaupt auf diese beschränken. das erste mal ist mir das als genre bei quora aufgefallen, dort hat es ja einige zeit fast zum guten ton gehört, als founder auf fragen zum eigenen startup zeitnah und ausführlichst zu antworten. beispiele der jüngeren zeit sind branch (exklusives diskutieren) oder svbtle (exlusives bloggen) usw.)

auf svbtle hat übrigens passenderweise gerade der jüngste Ableger seinen Ausgang genommen: App.net, ein kostenpflichtiges ($50/y für benutzer, $100/y für entwickler) und dafür werbefreies Twitter, das verspricht immer die Interessen der Benutzer zu wahren, was auch immer das bedeutet. Vom Auslöser – dem Rant gegen Facebook und der Anküdigung eines neuen Zeitalters – bis zur abgeschlossenen Finanzierung auf Kickstarter hat es nicht mal 2 Wochen gedauert.

(nur am rande: grundsätzlich finde ich überhaupt nichts schlimmes daran, wenn leute ihr netzwerk mobilisieren, was sollen sie denn sonst machen. aber in dieser konstellation ist auch ein dysfunktionales element enthalten: die keimenden plattformen entwickeln sich nicht ‘organisch’ sondern bekommen von anfang an ein uneigenheitliches weil reziprozitätsbedingt eigeninteressegetriebenes momentum. das muss nicht in die irre führen, aber es kann. dennoch wird die beobachtung von app.net sehr spannend, weil es auf mehreren ebenen ein fast pures symptom der derzeitigen verhältnisse ist. vom timing: der bruch mit twitter und facebook (wtf, was ist mit dem rest von uns?), vom barometer: wie viele leute lassen sich mobilisieren, etc.)

(siehe Googleheimer)

Social and Nothingness

ergänzend zu pfefferle und marcelweiss ist meine antwort für quiz pt. 64, dass sascha den falschen prozess (öffentlich/politisch diskutieren) für das falsche problem (offene/alternative öffentlichkeit) fordert.

die falsche grundannahme (nicht nur von lobo, auch von allen ohnehin reflexartig entstehenden offenen alternativen, auch von allen goldschürfern, auch von der wechselseitigen beobachtung und imitationen der GAFA selbst und auch von allen anderen) ist, dass es ein abstraktes soziales gibt, das eine öffentlichkeit sucht.

es gibt aber kein ungebundes soziales, das an keine konkrete formation gebunden ist. sozial ist im web immer an eine konkrete formation gebunden. vielleicht nachvollziehbarer: es gibt auch kein abstraktes bedürfnis zu sharen, für das man nur einen container sucht, und falls es der eine nicht tut, dann verwendet man halt den anderen. jede erfolgreiche plattform erzeugt ihr soziales objekt aus dem nichts. (das ist die saure lektion, die google mit ihrem g+ noch lernen muss.) und es gibt auch keinen abstrakten social graph, den man halt bei gelegenheit aus facebook oder twitter ausräuchern und an einem offenen stock in freiheit reterritorialisieren könnte.

das soziale ist nicht die ursache für, sondern der effekt von webanwendungen. und das verhältnis ist nicht struktur-funktional, sondern – wenn man will – teilchenphysikalisch.

Lazy Blog Ep. 3

(blogpost über DAS fundamentale dilemma im derzeitigen web: den umstand, dass man sich im web zwischen autonomer obskurität / unsichtbarer geschichtlichkeit und heteronomer sozialität / einpulsiger geschichtslosigkeit entscheiden muss; bonuspunkte für eine typologie der gesellschaftlichen störungen und neurosen, die durch dieses double bind getriggert werden)

Craig Pelton

Apropos New School of Education: das etwas umtriebige Verhalten von Udacity’s Sebastian Thrun – es gibt ja kaum ein Medium, in dem er in den letzten Wochen kein Interview gegeben und die Revolution der Bildung angedeutet hat – war Coursera dann doch ein bisschen zu suspekt und sie haben nicht nur Partnerschaften mit 12 weiteren Universitäten sondern auch zunächst mal 111 weitere Kurse angekündigt. edX wiederum bekommt eine Million von der Gates Foundation, das Feld beschleunigt sich ganz offenkundlich.

Und dabei lustig: alles, was für den derzeitigen Umbruch notwendig war, ist, dass einer (Udacity) Gas gegeben und ein Eitzerl mehr Aufwand investiert hat, sprich nicht nur vorhandenes Material adaptiert, sondern dediziert neues Material in einem geeigneteren Format erstellt hat; die Form der Vorlesung nicht unreflektiert übernommen (Coursera) oder pragmatisch aufgelöst (Khan) sondern eine erwartbare Form definiert hat; und vor allem: Design nicht völlig ignoriert sondern ein bisschen in das Design der Website, das Design der Umgebung und das Branding investiert hat. (ich hab die problemchen mit udacity schon gelegentlich erwähnt und wiederhole sie hier jetzt nicht; entscheidend ist tatsächlich die disposition, und da hat udacity alle auf dem falschen fuss erwischt)

(nur als gefühl am rande: mir kommt vor, dass thrun gerade ein bisschen überverkauft und überverspricht. mit der statistik klasse wollte er etwa einen neuen teilnehmerrekord aufstellen, angemeldet haben sich dann 25.000 und nicht die erhofften 160k+; als neue zielgruppe wurden schüler ausgemacht, und das hat sich dann auch im ‘anspruch’ und der zumindest anfänglichen gegen null gehenden schwierigkeitsstufe manifestiert, die sich dann aber in eine bipolare unentschiedenheit transformiert hat, was der kurs sein soll (prepre-algebra in den lectures mit sich wiederholenden ‘doesn’t this blow your mind?’ und irgendwie aus dem nichts kommenden problem sets, die dann komplexere integralrechnung und mathematische beweisführung erforderten, wechseln sich freudig ab). udacity hat afaics ein riesiges potential, aber auch einige löcher, in die sie fallen können, wenn sie zu früh zu viel wollen oder hudeln oder zu früh erfolgreich werden, so blöd das klingt)

I/O 2012 (Neue Bescheidenheit Edition)

noch ein kleiner Nachtrag zu Google Plus Eins und I/O 2012 State of Google Edition nachdem ich mich durch eine ganze Reihe an – teilweise wirklich sehr interessanten – Sessions geschaut habe:

@pfefferle hatte sie ja schon entdeckt und mit der History API (session vid) bekommt Google+ nun gwm. eine Art Schreib-API und der Ansatz scheint mir für G+ zu stimmen: wenn eine Anwendung History unterstützt und ein User die Anwendung autorisiert, dann kann eben jener User auf eben jener Anwendung Dinge zunächst mal für den eigenen Gebrauch auf G+ posten, um es dort dann ggf. öffentlich oder mit Gruppen zu sharen. Das ist zwar ein bisschen umständlich, aber damit vermeiden sie wohl, dass Anwendungen die Erfahrung von G+ übernehmen.

Was mir aber insgesamt – neben dem Ausbleiben der großen blöden Projekte und der an deren Stelle getretenen großen Schlüssigkeit – aufgefallen ist, ist eine fast durchgehende neue Bescheidenheit, die vl. wieder der Grund für das Ausbleiben der Projekte und der Schlüssigkeit ist.

Ich vermute, dass Google die Zusammenfassung meines keimenden Unbehagens mit Google gelesen und nicht nur gelesen sondern in der größtmöglichen Intensität studiert hat. Fast alle dort aufgeworfenen Problemfelder wurden irgendwie adressiert.

Realistischerweise sollte ich aber vermuten, dass hier Google eher einen anderen Umstand utilisiert: die Tatsache, dass sie ein datengetriebenenes Unternehmen sind, welches alles misst und seine Prozesse und Entscheidungen auf Basis dieser Messungen adjustiert. Sprich: auch wenn ihnen der gesunde Hausverstand fehlt (was wiederum modelltechnisch nichts als ein Problem mangelnder Diversifikation ist), ihre Logfiles zeigen ihnen, was nicht funktioniert. Und während sie Flops wie Buzz, Wave, Knol, Lively, Jaiku, Health, Answers, Aardvark, Bookmarks, Notebook, Video, Music, etctrara immer auf Umstände schieben konnten, Google+ war Chefsache, sie haben alles draufgeworfen und es blieb dennoch ein Dud. Also konnte sich auch Google endlich mal die Fragen stellen, wo wie und warum es kratzt. Auf was konkret sie da gekommen sind kann man leider nicht deduzieren – da wär ich aber gern ein Mäuschen gewesen – , aber eine Lektion war eindeutig, den Anspruch und die Erwartungshaltung mal ein bisschen zu relativieren. Eine konkrete deduzierbare Einsicht war, dass ihnen die soziale Masse nicht einfach zufliegt, nur weil sie 250 Mio (~50% der Gmail-Accounts) Benutzer zum ‘upgraden’ zu G+ usurpiert quasi geschupst und mit seotechnischen Karotten für die Verbreitung auf Webseiten gesorgt haben. Auch wenn sie nicht wie alle anderen bei Null beginnen müssen, auch sie müssen sich auch die kleinen und kleinsten konkreten Aktivitäten verdienen, mit neuen experimentieren, iterieren und dann das verstärken was funktioniert. Es schaut so aus als hätten sie jetzt damit begonnen.

I/O 2012 (State of Google Edition)

(ok, blöder titel, nur ein paar kleine anmerkungen zu google, da die ankündigungen auf der google i/o jetzt ja gemacht wurden und nix wichtiges mehr kommt)

das vl. spannendste an der i/o war das völlige ausbleiben der grossen blöden würfe, die man von google kennt und schätzt. mehr oder weniger alles, was vorgestellt wurde (siehe tag 2 und tag 1), ist eine inkrementelle verbesserung von vorhandenem, die kopfgeburten wurden rigoros abgesägt; alles verbliebene wurde schneller, besser, kleiner, mehr user, hübscher, billiger. primär ging es darum, die lücke zu apple zu schliessen. und wenn man den demos glauben kann, dann ist ihnen das auch durchaus gelungen. sekundär ging es darum, den möglichkeitsraum für web- und mobile anwendungen zu verscheiben. und wenn man den demos glauben kann, dann ist ihnen auch das durchaus gelungen (maps werden wirklich immer irrer, spracherkennung, docs und einiges andere funktioniert auch offline, rein css-basierte games schauen aus wie aus der konsole, etc.). aber auch wenn es dann einige dinge gab, die in dieser skalierung dann nur noch google anbieten kann – für 100.000$/h kann man etwa 700.000 kerne anmieten und auch als privatperson komplexere berechnungen vornehmen -, kaum ein feature war noch nicht woanders gesehen.

(was ist mit google glass, könnte man hier einwerfen, aber glass ist natürlich keinen funken innovativ, sondern ein reines engineering problem von einem gedanken, den sich science fiction autoren oder screenwriter nicht mal mehr trauen würden aufzuschreiben, so klar liegt er auf der hand. aber gleichzeitig muss man das dann halt auch machen und warum nicht google etc.)

aber wenn schon nix neu war, alles war auf eine fast schon beängstigende weise schlüssig. und auch wenn vieles dann auch doch sehr an apple erinnert, sie scheinen sich auch erstmals wirklich designer und ui-spezialisten geleistet zu haben; alles war auf eine fast schon beängstigende weise optisch erträglich. wie man’s macht ist’s falsch, aber dieser neue pragmatismus ist irgendwie auch total langweilig. hoffentlich haben die ganzen rückschläge google nicht die träume ausgetrieben.

Google Plus Eins

Heute vor einem Jahr hat Google Google+ vorgestellt: Real-life sharing, rethought for the web . Und seit gestern veranstaltet Google den alljährlichen Sanity-Check Google I/O (für einen Überblick der Keynote siehe Google I/O Tag eins), dort wurde mit den Google+ Events, dem Party Mode und der Version für Tablets das vorläufige Zwischenergebnis markiert; eine adhoc Diagnose von G+:

- sie scheinen die fixe Idee, Facebook Konkurrenz machen zu wollen, zumindest vorläufig aufgegeben zu haben. Für Google+ ist das gut, weil sie einen Kardinalfehler nicht mehr in die Grundannahmen von G+ hineinbauen: den Glauben, es gäbe Social und den Wunsch zu Sharen als abstraktes Bedürfnis. Ich glaub zwar nicht, dass sie das wirklich verstanden und deshalb reagiert haben, aber man kann mit einem Blödsinn ja auch aufhören, ohne zu wissen warum das ein Blödsinn war.

- für G+ bedeutet das, dass es das erste Mal eine konkrete Richtung bekommt und Google tatsächlich mit Elementen spielt, die sie haben, und auf eine Weise spielt, die sie auch können. (sie kommen zwar aus mind. drei richtungen: hangouts aka facetime; tabletview aka socialized flipboard bzw. google currents; events aka facebook, aber die stören sich nicht gegenseitig)

- es bedeutet auch, dass die Werbebotschaft plötzlich besser passt. Die war davor irgendwie völlig schizoid, weil sie geglaubt haben, dass man mit dem Stil von Apple auch ‘Soziale Systeme’ verkaufen könne. Nur verkauft Apple natürlich das genaue Gegenteil von dem, was sie bewerben; die regressive Phantasie eines phantastischen Lebens mit liebender Jungfamilie und lachenden Freunden ist gwm. die imaginäre Ergänzung zum ‘masturbatorischen’ Gadget. Mit einem iPhone oder iPad kann man diese Imagination dann auch aufrechterhalten; auf G+ findet man sich schnell in der Wüste des Realen wieder.

- von einer API bis dato kein Wort, wobei es für handerlesene Partner wohl eine gibt. Mich würde es zwar wundern, wenn sie nicht heute oder morgen eine vorstellen würden, aber ich verstehe Google irgendwie sogar, wenn sie es nicht tun. Ich weiss, Ökosystem und so, aber Google muss hier andere Phasen durchmachen, als ein neues Startup.

- neben den endlich einmal genannten sinnvollen Zahlen – ca. 50 mio daily active users – kann ich bestätigen, dass sich der Google+ Button und/oder eine Google+ Page zumindest unter den Startups doch als Standard etabliert hat. Eigentlich gibt es nur noch drei Buttons im Web: Twitter (auf 90+% aller Seiten), Facebook (auf 80+% aller Seiten) und eben G+ (auf 60-70% aller Seiten, zumindest der neueren). Pinterest, Tumblr, Linkedin, etc. sieht man dann noch sporadisch, alle anderen sind fast schon Fundstücke. (nur am rande aber erfreulich: fast jedes, also wirklich fast jedes startup hat auch noch ein eigenes blog, und auch da geht der trend fast weg vom tumblr oder posterous)

Unterm Strich ist Google+ also auf einem guten Weg.

Lazy Blog Ep. 1

(blogpost über DAS fundamentale dilemma im derzeitigen web: den umstand, dass ‘news’ bzw. die verkündung einer neuigkeit der einzige dominante synchronisierungsmechanismus zwischen den verschiedenen gleichzeitigen ungleichzeitigkeiten der ‘benutzer’ verblieben ist. dass das dann nicht wirklich überraschend ist, zumal massenmediale ‘news’ ja auch im pre-web milieu gwm. den gesellschaftlichen pulsschlag vorgegeben haben (sei es jetzt tagesschau oder bild oder spiegel oder whatever), nur dass die kosten für die verpassten gelegenheiten alternativer mechanismen im web um mannigfaltigkeiten grösser sind, weil sich die ausdifferenzierung des gesamtsystems so auf einem deutlich verkümmerteren niveau einpendelt, als es schon einmal war usw. bonuspoints für eine ethnographie der der zurückentwicklung, die dokumentiert, welche elemente in jeder iteration abfallen und zurückgelassen werden)

The Walking Dead

Google, observing the growth of these gesture farms, rightly recognizes that the Web is no longer enough. The Google+ project attempts to graft a living Network entity on to the footprint analyzing machine they already have in place. But does this move Google from the land of the dead to the land of the living? If Google is mostly dead, does it operate more like a zombie? Is it subject to disease and viruses? And if it’s not, is it really alive?

Echovar wieder einmal sehr schön über die Unterschiede zwischen Facebook (ein lebender Organismus bestehend aus lebenden und likenden Suborganismen, der in seinem Charakter als Farm aber auch anfällig für Krankheiten und Seuchen ist) und Google (ein Bot, der die Fussspuren und Exkremente der lebenden Organismen untersucht, der jetzt aber auch leben will, aber weder weiß, was das bedeutet, noch die Probleme sieht, die damit verbunden sind)

Quiz Pt. 61 (The Sauerkrauts Edition)

das eingebaute paradox: wenn unsere it-elite die antwort hätte, dann wären wir nicht so weit hinten und/oder daneben http://t.co/mBhcH9da

— Markus Spath (@hackr) May 31, 2012(nts: mich öfter selbst zitieren)

Offenes Quiz: Warum ist Deutschland in allen Dingen Web so daneben?

(hint1: der erste teil der lösung besteht darin zu zeigen, warum der tweet eigentlich ein blödsinn ist, oder genauer: warum die diagnose eines ‘hinten seins’ nicht nur falsch, sondern völlig in die irre führend ist.)

((hint2: die antwort ist überraschend einfach, aber es gibt sehr viele falsche antworten, die richtig klingen. es hilft, wenn man sich überlegt, warum jede der möglichen antworten von politik und vc’s jeweils falsch ist (wobei man aufpassen muss, nicht in die falle falscher schlussfolgerungen bei richtigen propositionen zu tappen; nur als beispiel: die wohl zutreffende beschreibung, dass deutschland derzeit die technisch/infrastrukturelle komplexität eines google oder facebooks wohl tatsächlich nicht stemmen könnte, bedeutet nicht, dass es ein deutsches google oder facebook gäbe, wenn man nur 10 milliarden in die technische und personelle infrastruktur pumpen und also die voraussetzungen grundsätzlich erfüllen würde.)))

(((hint3 und wichtigster hint: das deutsche web verhält sich zum us web wie sich deutsche fernsehserien (bzw. das ökosystem de tv) zu us fernsehserien (bzw. dem ökosystem us tv) verhalten.)))

The Amazing Race

So, noch ein vorläufig letztes Update zu der Community Serie (siehe Greendale und Señor Chang und Pierce Hawthorne und Troy Barnes) und auch meine Antwort für Quiz #60 :

diese Woche sind die Finals und unterm Strich ist wirklich irre, wie weit man in sechs Wochen kommen kann. Die Exams selbst sind nicht leicht aber machbar (bei CS101 etwa die Optimierung vom Ranking Algorithmus, indem reziproke Links bis zu einer definierbaren Tiefe als solche erkannt und also nicht gewichtet werden oder die Realisierung von einem einfachen zellulären Automaten, bei CS253 die Entwicklung eines auch wieder einfachen Wikis mit Versionskontrolle, und sechs harte Knochen / Puzzles von Norvig) und runden die Kurse doch schön ab.

Was uns zum Quiz bringt:

Die primäre Leistung von Udacity (und Coursera und dem kommenden edX usw.) besteht in der Bündelung der Zeitlichkeiten der ‘Studenten’ und ‘Lehrer’.

Die Inhalte selbst sind die längste Zeit schon irgendwie da. Aber auch wenn es super ist und bleibt, wenn das MIT oder Berkeley oder Stanford ihre Vorlesungen aufnehmen und dann ggf. mit einigen Slides ins Web stellen, in Zukunft reicht diese Geste der Gnade beim gleichzeitigen ‘lasst uns bitte ansonsten zufrieden’ nicht mehr aus (wobei natürlich themen bleiben, die sich so auch gut abbilden lassen; ein crashkurs in poststrukturalistischer literaturkritk ist auch als vorlesung nicht schlecht, siehe).

Was fehlte war der persönliche Anspruch an die Teilnehmer, das Gefühl der Aufgehobenheit (i.g.z oben angesprochenen erwarteten Dankbarkeit) und eben die Synchronisierung der Zeiten bei gleichzeitigem Setzen von Deadlines für Homeworks und Exams. Nur durch diese Gleichzeitigkeit ist dieser persönliche Anspruch und das Gefühl der Aufgehobenheit möglich, nur durch die Gleichzeitigkeit entsteht genügend Dichte, dass sich die Leute bei Problemen – Verständnisschwierigkeiten in den Lectures, Stocken in den Homeworks – auch selbst helfen können.

Das für sich nutzbar machend hat sich Udacity thematisch in einem sweet spot positioniert, der bis dato zumindest massentauglich nicht angegangen wurde: im Niemandsland zwischen dem ‘hello world’ und den Problemen von Leuten, die schon jahrelang in dem Feld arbeiten. Hello worlds gibts zu allem, aber es ist schwer dann zum nächsten Schritt zu kommen (man denke an das Codeyear der Codacademy). Auch vielleicht nicht gelöst, aber sicher nicht unterorganisiert ist der Austausch und die Weiterbidung von ohnehin schon Professionals (Kurse, Kongresse, Zertifikate, Blogs von und für Spezialisten, etctralala.) Und wirklich gelöst ist das Problem der Nanochunks sprich konkreten Fragen. Spezifisch genug kann man diese ohne Umformulierung in Google stellen und wird dann üblicherweise zur passenden Frage/Antwort-Kombi bei Stack Overflow verwiesen.

Was aber fehlte war ein ‘Curriculum’ das zwischen den Erleuchtungsebenen vermittelt und wenn man sich das überlegt, dann ist das tatsächlich ein Problem, das sich nicht wirklich leicht durch das Web lösen lässt (zu unterscheiden vom im web vermitteln; einmal gelöst lässt es sich natürlich ideal im web vermitteln). Und das Problem für das Problem ist natürlich einerseits der Aufwand der Erstellung und andererseits das Risiko der Evaluation auf seiten der Azubis. Es ist einfach zu riskant, einige Wochen zu investieren, nur um dann draufzukommen, dass das alles ein veralteter und stilistisch grauenhafter Blödsinn war, der einen eigentlich nur noch dummer gemacht hat, als man ohnehin schon war.

Aber Udacity (und zu einem geringeren Grad Coursera – die stecken eher noch im alten Modell fest und tendieren den Mehraufwand ab gefilmter Vorlesung eher zu minimieren, da basiert der Wert derzeit eher noch auf der Qualität und dem Einsatz der ‘Lehrer’) schickt sich an, sukzessive die Blöcke für solche Curricula zu entwickeln und dadurch einige mögliche Probleme für Selbstlerner zu lösen. Vor allem das der Roadblocks.

Roadblocks

Roadblocks sind – wie wir von the Amazing Race wissen – Blockaden, die wir aus dem Weg räumen müssen, bevor wir unsere Reise fortsetzen können. Oft sind das nur Kleinigkeiten – deshalb bleibt der modus face to face so wichtig, ein anderer sieht oft in 5 Sekunden, warum es hängt -, aber bevor man sie nicht gelöst hat, geht es nicht weiter. Und Udacity versucht auf allen Ebenen und ich würde sagen nicht ganz erfolglos, diese Roadblocks zu vermeiden. Das beginnt mir der Auswahl der Tools und der technischen Infrastrukur (fast alles kann man im online editor machen, es wird sofort diagnostiziert, Google App Engine läuft bei den meisten out-of-the-box), geht über die Auswahl und Entwicklung der Themen bis zur semibetreuten (TAs springen eig. immer ein) Community. Für Autodidakten jedenfalls ein guter Modus.

(es gab durchaus auch zu kritisierendes; die automatischen grader etwa sind sehr pingelig und die anweisungen waren oft viel zu uneindeutig und teilweise auch selbstwidersprüchlich, da ein externes paar augen drüberschauen zu lassen wäre vl. keine schlechte idee gewesen, denken wir an die diversity models der model thinking klasse. pädagogisch ‘zumutbar’ sind einige einheiten sich auch nicht usw, aber ich will hier nicht jammern)

((nur am Rande aber ein Ding ist mir ganz extrem aufgefallen: die Kluft zwischen schnell hingeklopft und verschiffbar ist gigantisch. Einen Prototypen zu bauen, der funktional das meiste kann und im eigenen Setup problemlos funktioniert ist eine ganz andere Nummer als in der freien Wildbahn zumutbar zu sein und alle möglichen Kontingenzen abzufedern. Ich schätze das Verhältnis liegt irgendwo zwischen 1:10 und 1:20. Nicht nur deshalb hab ich aber jedenfalls einen ganz neuen Respekt vor jeglichen Anwendungen, aber es nützt ja nix, es is halt trotzdem wie’s is))

/dev/+

number of bookmarks: ~30.000; in den letzten 7 jahren nachgeschlagen: ~30x. /dev/delicious

— Markus Spath (@hackr) May 13, 2012(nts: mich öfter selbst zitieren)

(weil ich wieder plussen kann: auch wenn für mich bookmarks tatächlich eher eine dump-funktion haben, so haben sie gleichzeitig den charakter einer mentalen versicherung, dass man ja irgendwann in der ontologie des eigenen lebens nachschauen könnte usw. g+ ist als dump ins leere wesentlich konsequenter, weil man ja weder an kommentare noch an plusse jemals wieder rankommt, die dienen ja nur noch als phatische geste (ausser man bookmarkt sie eben, was den kreis wieder schliesst)).

Pierce Hawthorne

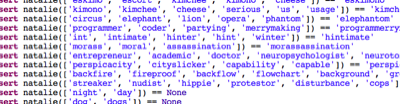

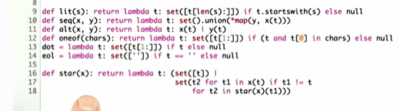

kl. Nachtrag zu Señor Chang und Greendale : die Dichte und das angeschlagene Tempo der von Udacity offerierten Kurse ist doch erstaunlich, vor allem Peter Norvig’s CS212 (was als fortsetzungskurs für das CS101 und also für leute mit einem 6-wöchigen kurs als basis offeriert wird; peter norvig ist übrigens auch die antwort von quiz pt. 57) ist nichts für Leute mit schwachen Nerven oder einem niedrigen Frustrationsthreshold, der ist in Woche 3 schon bei der Implementierung eines Compilers für regular expressions gelandet (fast noch erstaunlicher: der code passt auf 18 zeilen, siehe screenshot, aber norvig schreibt auch einen spell checker auf basis von bayesian probability theory in 21 zeilen), davor hat man dafür eine API und einen Interpreter geschrieben, danach – und spätestens da bin ich dann aber völlig ausgestiegen – kommt auch noch ein Generator für alle möglichen ‘Sprachen’, Mashups von Functions, bei denen alle möglichen Zeitlichkeiten vorgespeichert werden, dynamisches Mapping von Funktionen und Meta-Dekorators, Memoization via Caches für Funktionen, ein injiziertes Tracetool und Programmieren in verschiedenen virtualisierten Timelines. Und das alles in 60min oder so. Die programmiertechnisch notwendigen Konzepte wie list comprehensions, generator expressions, generator functions und voodoo mit den eingebauten Collections werden on the fly erwähnt.

2499

2499 tage live.hackr! (und irgendwie hab ich immer weniger zu sagen, lol. wobei das mitunter schon daran liegt, dass ich doch eher ein fauler blogger bin und sich mir zumindest die ersten fünf jahre die themen quasi aufgedrängt haben, weil in den jahren 2005 – 2010 das web die phase einer evolutionären explosion durchgemacht hat, in der eigentlich alles irgendwie interessant war, siehe 5 Jahre live.hackr oder noch besser homer simpson, und ziemlich genau mit diesem zeitpunkt aber tatsächlich eine art lokales maximum erreicht war, nach dem es dann wieder sich zunehmend beschleunigend nach unten ging (und ich meine jetzt natürlich nur den allgemeinen vektor, nicht einzelne stränge wie etwa kickstarter, die plötzlich möglich wurden); einige der kollektiven entdifferenzierungsprozesse, ökosystemisch ungesunden reterritorialisierungen, diskursverdünnungen etc. hab ich eh beschrieben und das ist natürlich weder abendfüllend noch zumutbar. wobei das natürlich alles kein problem ist. oder besser gesagt: das web ist sowieso kein problem sondern stinklangweilige (aber natürlich potentiell extrem komplexitätssteigernde) umwelt, nur sind die gesellschaftlichen aussagen über diesen neuen zustand noch nicht ganz mitgezogen und laufen wie die zeichentrickfiguren schon einige zeit in der luft, ohne gemerkt zu haben, dass der boden längst nicht mehr da ist usw.)

Object Socials Revisited

Heute vor zwei Jahren: Social Objects vs. Object Socials

(mit dem übergang von social objects zu object socials – also von objekt-vermittelter intersubjektivität zur subjekt-vermittelten interobjektivität – war ich doch erstaunlich nahe dran, nur war es eher noch aus einer perspektive des humanismus verfasst; die formel stimmt zwar, aber man müsste sie rekursiv ergänzen, sprich den wechsel der perspektive wieder in den jeweiligen perspektivenwechsel einführen; der subjekt-anteil der subjekt-vermittelten interobjektivität ist also selbst nichts anderes als das ergebnis der objekt-vermittelter intersubjektivität usw. und dann landen wir in der effektivsten timeline halt beim kurzschluss, den ich witzigerweise ein paar tage davor eh schon gesehen hab usw.)

Linkinfarkt

(hatte vorhin gelinde gesagt einen kleinen schock, als ich das ergebnis meiner zu delicious importierten getwitterten (und gefavten usw.) links sah; ausserhalb des kontexts – und der ist dann natürlich selbst das hauptproblem – sind sie nichts anderes als eine zumutung, was ich aber in der dimension echt nicht geahnt hätte)

Preseason

(frage mich gerade, ob es möglich/sinnvoll wäre, ein blog wie fernsehserien in seasons zu betreiben; wenn man das format von serien mit dem format von blogs vergleicht, dann gibt es ja durchaus ähnlichkeiten in den paradigmen; da gibt es die episodisch angelegten serien, bei denen jede folge in sich funktioniert/funktionieren muss (auch wenn es natürlich oft auch ein übergeordnetes motiv gibt). das blogtechnische äquivalent ist hierzulande gut bekannt, so ziemlich jedes prof. betriebene blog und jedes nachrichtenportal folgt diesem muster; und es gibt andererseits serien wie the wire, die eine oder mehrere handlungsbögen über mehrere folgen – üblicherweise eben eine season – hinweg serialsieren. die vorteile sind klar: es lassen sich ganz andere geschichten erzählen, die geschichten lassen sich ganz anders erzählen, bestimmte dinge können bzw. müssen als bekannt vorausgesetzt werden, etc. die nachteile auch: es wird mehr von den zuschauern erwartet, für neue zuschauer ist es schwer, später einzusteigen, etc. wenn man so will fällt auch live.hackr in diese kategorie, nur dass es hier keinen punkt gibt, auf den ich hinaus oder zu dem ich hin will. in diesem spannungsfeld zwischen episodischen monaden und mäandernden universal- oder molekulargeschichten haben sich im fernsehen zwei strategien entwickelt: (a) die injektion vom episodischen ins serialisierte, also serien, die zwar primär einen langen oder sogar offenen handlungsbogen haben, der aber zumindest teilweise in episoden zerhackt ist, die auch für sich alleine funktionieren können. man denke an fringe. (b) die radikale begrenzung von searials auf doch noch überschaubare zeiträume wie miniseries, das hbo-format (12 folgen) oder eben seasons. und während (a) die gwm. naheliegende technik in blogs ist, i.e. auch wenn man viel herumlabert auch mal ein feuilletonistisches highlight setzen usw., so könnte doch (b) ein wirklich spannendes format sein. viele beispiele fallen mir nicht ein, am ehesten noch so buchbegleitende blogs wie etwa anderson beim long tail oder kelly bei what technology wants, aber die waren trotzdem eher excerpts und/oder utilitaristisch)

Mission Accomplished

Who the fuck was I chasing?

McNulty Season 3 Episode 12 11:30

What the fuck was I thinking?

Mayor Clarence V. Royce Season 3 Episode 12 24:50

(hab mich über ostern endlich an the wire herangewagt und die ersten drei seasons angeschaut)

((die zwei zitate rollen die season 3 sehr nett zusammen und bei beiden funkelt etwas auf, was man im fernsehen eigentlich nie sieht, und zwar eine art ungekünstelte wahrheit, die man durch die augen der protagonisten erlebt; das Who the fuck was I chasing?

stammt von mcnulty, nachdem er nach dem tod von stringer bell dessen wohnung durchsucht, die er so nicht erwartet hat; das What the fuck was I thinking?

kommt von Mayor Royce, als er die medienberichte über hamsterdam mitansehen musste; in beiden fällen ist es natürlich so, dass mcnulty resp. royce weniger bzw. anderes über die sachverhalte wissen, als die zuschauer, aber in beiden fällen ermöglicht das aha-erlebnis von mcnulty resp. royce auch im zuschauer das aufblitzen eines unmittelbaren zugangs zu den dingen an sich, zumindest für den moment, wo sich in den protagonisten der blick verschiebt, weil sich im gleichen moment auch im zuschauer der blick (auf etwas andere art) verschiebt; zumindest für mich wurde stringer bell damit irgendwie zum eigentlichen ethischen charakter von the wire, weil das medium wohnung seine ehrliche sehnsucht nach, hmm, schwer, weil es nicht nach dem guten ist, aber auch nicht nach was besserem oder sonstwas, jedenfalls dieser seiner ehrlichen utopischen sehnsucht vermittelt; und der fall royce konstruiert eine aussergewöhnliche dialektik: die wahrheit versteckt sich in der ‘falschheit’ der medien; auch wenn sich die medien natürlich reisserisch auf hamsterdam stürzen, sie haben, wenngleich aus den falschen gründen, recht, und durch den knacks, den royce erlebt, wird auch der eigene knacks getriggert, der zwar schon lange davor naheliegend war – man denke an den trip von bubbles in den strassen von hamsterdam – aber noch nicht wirklich da; dabei interessant, dass diese vermittlung selbst die vermittlung via royce braucht, sprich: die berichte der medien allein hätten nicht ausgereicht und die sympathien mit dem phantasma eher verstärkt))

Model Studies

kl. Nachtrag zu Community College : die Model Thinking Klasse hat gerade ihr Midterm und deshalb nochmal ein kleiner Anstups; die Videos sind auch ohne Anmeldung einsehbar, ein langes Wochenende reicht wohl auch zum Catchup aus und zumindest ich hatte in den letzten Jahren selten mehr Bang für den Buck (Time).

Der Kurs ist (wenn man allem folgen will, was auch nicht notwendig ist, weil er sehr modular ist) nicht ganz einfach, aber Hausverstand und ein bisschen Lust an logischem Denken reicht (im Gegensatz zu den anderen Stanford-Kursen, in die ich hineingeschnuppert habe) locker aus, also keineswegs schwer, aber sehr gut (mich dünkt man müsste viel viel mehr Zeit investieren, um dann einen signifikant höheren Nutzen zu haben); Scott Page hat spürbar Lust am Thema und ist extrem gut darin, die Modelle auf einem Abstraktionsniveau zu erklären, das gleichzeit verständlich und non-trivial ist, und sie dann auch in ihrer Relevanz für unser Dasein zu positionieren.

(fast bei jedem modell hat es bei mir irgendwie kling kling kling gemacht und plötzlich hatte ich ein instrumentarium dafür, irgendein phänomen zu fassen, das davor irgendwie meistens in der konzeptionellen suppe der überkompliziertheit geschwommen ist. und eines der ersten dinge die man lernt, ist, die bedingungen zu klären, unter denen die jeweils getroffenen grundannahmen gültig sind (was mir, so blöd es klingt, schon alleine dabei geholfen hat, meinen gereiztheitszustand gegenüber einigen feldern zu senken, weil ich mich z.b. bei aussagen nicht mehr über die inkonsistenzen und willkürlichen grundannahmen ärgere, sondern eher den gültigkeitsbereich skizziere, den es ja trotzdem meistens auch gibt). ein anderes ist, dass man plötzlich ein auge für modelle bekommt und sie erkennt, wenn sie etwa von anderen menschen angewandt werden (ob sie es jetzt wissen oder nicht). auch das führt mitunter zu einer defrustrierung mit den mitmenschen, weil man ihren irr- und unsinn oft als rationales verhalten (halt unter suboptimalen grundannahmen) zumindest nachvollziehen kann; viele der aktuellen konfikte sind halt einfach ein clash zwischen optimierung eines big coefficient der sich leider einer new reality gegenüber (nicht) sieht. oder sie helfen beim etablieren eines ‘feelings’ für die dynamik von equilibrien von szenarien, die übrigens oft contraintuitiv sind)

On Stranger Tides

(wenns nicht so lustig wär, wärs eigentlich traurig, aber mit dem erfolg der piraten im saarland hat sich nun endgültig eine situation etabliert, bei der sich einige gesellschaftliche paradoxien entladen wollen, an denen davor noch unbekümmert vorbeigeschaut werden konnte, die als lästiger kinderkram abgetan werden konnten, usw. wohin nur mit der plötzlichen kognitiven dissonanz, die ja nach dem aha-erlebnis ja auch retrospektiv gedeutet werden muss? und hier erleben wir derzeit wohl eine art theater, das es nicht so oft gibt: man kann einem kollektiv (besonders natürlich leuten aus politik und medien, aber nur deshalb, weil die halt einerseits bedrohte investments und andererseits exposition haben) förmlich beim nichtverstehen zusehen. in dieser dichte (es muss ja sowohl eine quantitatives momentum als auch eine zeitliche synchronisation geben) gibt es das selten und vor allem: aus irgendeinem grund wird auch die lösung nicht gefunden, alle stehen gemeinsam auf dem schlauch)

((die lösung ist natürlich: reboote deinen blick. man muss wirklich nur hinschauen, ohne die mantras ‘dagegen’ im kopf zu haben und vor allem auch ohne den mantras ‘dafür’, weil die oft noch danebener sind und in die falle der dann doppelt falschen widerlegung locken. aber den notwendigen ersten schritt, die de-essentialisierung vom web als ding, von der internetgemeinde als gruppe, etc., der ist anscheindend schwer zu machen))

Sisquoc and Shatash

kl. Nachtrag zur Eagle Cam : die Condor Cam (via)

(anhand der popularität und ‘stickiness’ der einzelnen bird- und wildlife cams ließen sich übrigens verschiedene modellarten (informationsdiffusionsmodelle von netzwerken, tippingpointmodelle, etc.) recht gut parametrisieren, weil es ja zu den verschiedensten effekten und aufmerksamkeitsverteilungen kommt, die aber tatsächlich ‘reine’ systemeffekte sind) ((wobei, vl. spielen da doch auch so archetypische oder totemistische elemente eine rolle, hmm))

Twitterous

devoha: Twitter hat Posterous übernommen (ann) – war wohl eher eine Talent Acquisition und nicht ganz zu unrecht, von einigen Patzern und kleineren Blödheiten abgesehen waren sie tatsächlich durchgehend innovativ.

(ist natürlich als problem nicht neu sondern ein dauerzustand aber hier auf alle fälle wieder mal reaktualisiert: das web differenziert sich nicht mehr auf basis interner kräfte und milieuverschiebungen aus, sondern wurde zu einem globalen investitionsobjekt, das weniger von ökosystemischen mechanismen als von spekulativer spieltheorie geprägt wird; wir kennen das ergebnis aus der echten welt, abholzung des regenwaldes, monsanto, nutzland und nahrung als spekulationsobjekte mit angeschlossenen hungersnöten, etctrara, zum glück im web weniger tragisch und mit tatsächlich echten alternativen; jedenfalls bedenklich, wie wahrscheinlich es mittlerweile ist, dass ganze kulturen oder landstriche einfach ausgelöscht werden, weil die gründer die eigene position innerhalb ihres metaspiels gewinnen oder zumindest konsolidieren wollen)

Leftovers 2011 (Axis of Good Edition)

doch noch ein Leftover (siehe die Filter oder die non sequiturs oder die allgemeine Cluelessness oder die Begrenzung der Wirksamkeit oder die Gleichzeitigkeit der Ungleichzeitigkeiten oder die Differenzen oder das Web als Selbstdifferenz): Auch nicht wirklich weitergekommen sind wir beim Bewerten von Aussagen für oder gegen (das Web | whatever). Aussagen, die sich vermeintlich für das jeweilige aussprechen, was man auch gerade glaubt, werden zitiert und verstärkt, egal wie blöd sie sind; Aussagen dagegen werden undifferenziert und mit einer fast schon feudalistischen Hörigkeit disqualifiziert und/oder ignoriert.

(das läuft auf allen ebenen, aber als beispiel ganz furchtbar ist etwa netzpolitik.org und die netzpolitik crowd mit dem pawlowschen interpretieren von ereignissen; oder die G+ crowd; etc. die liste ist aber lang.)

Leftovers 2011 (Dead Man Edition)

Auch nicht (siehe die Filter oder die non sequiturs oder die allgemeine Cluelessness oder die Begrenzung der Wirksamkeit oder die Gleichzeitigkeit der Ungleichzeitigkeiten oder die Differenzen) wirklich weitergekommen sind wir mit dem Töten vom Web.

Das Web ist natürlich schon längst tot. Nicht als Technologie oder System bzw. Umwelt. Aber als Begriff zur Beschreibung und Erklärung von Ereignissen die stattfinden, weil es das Web eben gibt.

Wir sind mit der Ausdifferenzierung an einem Punkt angekommen, an dem das Web eine systemische Autonomie erreicht hat, an der es nicht länger sinnvoll ist, sich über ‘das Web’ als Ursache der durch das Web ausgelösten Ereignisse und Phänomene zu wundern oder das Web selbst deshalb zu bejubeln oder zu kritisieren oder sich insgesamt groß zu wundern. Es ist mittlerweile auch schlicht sinnlos, ‘für’ oder ‘gegen’ das Web zu sein, dem Web kritisch gegenüberzustehen oder nicht, etc.

Das Web verhält sich zur Gesellschaft in einer losen Analogie wie sich unser Gehirn zu unserem Bewußtsein oder die Sprache zu unseren Gedanken oder die Technologie Film zu Filmen verhält.

Damit wir als Biosysteme Bewußtsein haben können, brauchen wir ein Gehirn. Damit wir sprachlich denken können, brauchen wir die Sprache. Aber so faszinierend wohl das Gehirn und die Hirnforschung und alle Varianten der Linguistik sind, die konkreten Gedanken setzen Gehirn und Sprache voraus, emanzipieren sich einmal gedacht aber davon und unser sprachlicher Alltag funktioniert auch (oder weil) wir nicht jeden Gedanken in seinen materialistischen Voraussetzungen kontextualisieren; auch wer viel redet wird nicht als Sprachaktivist angesehen oder als Mitglied irgendeiner Gehirngemeinde.

Damit es Filme geben kann braucht es die (Erfindung der) Technologie Film (die selbst wiederum natürlich in einen historisch gewachsenen technokulturellen komplex eingebettet ist, wie auch das web in einen historisch gewachsenen technokulturellen komplex eingebettet ist). Aber jeder Film ist ein eigenes Ding, das zwar das Medium benötigt, aber in seiner Wesensheit mehr mit der Ausdruckskraft der Beteiligten zu tun hat, dem Bündel aus Regie, Script, Schauspielern, Montage, Sound, usw.

Komplexe Systeme wie Gehirn, Film oder eben das Web spannen neue Möglichkeitsräume auf, fungieren als Katalysatoren, sind Zentren und Knoten, durch die andere Kräfte und Vektoren verstärkt, beschleunigt, verdichtet oder auch erst ermöglicht werden können oder auch nicht, etctrara. Die auf ihnen stattfindenden partikularen Ereignisse und emergenten Phänomene basieren dann zwar auf ihnen, lassen sich aber nicht mehr damit begründen oder zurückführen.

Und das gilt nicht nur für das Web als ganzes, sondern auch für alle webbasierten Plattformen wie Facebook oder Twitter, die technologisch und konzeptionell vl. trivial sind, aber eine komplexe soziale Eigenlogik triggern können. Wir müssen lernen, die Effekte (und deren ‘Sinn’) getrennt vom tragenden Kanal zu behandeln, uns also eher anzuschauen, ‘was’ da genau passiert und uns nicht high fives zu geben, nur weil was im Web oder auf Twitter passiert. Diese Zeit ist vorbei.

(die gute nachricht am rande: auch wenn das derzeit primär ein symptom der denkfaulheit ist, bei dieser art an diskurs handelt sich wohl auch nur um ein übergangsphänomen, das in ein paar jahren einfach verschwunden sein wird)

Leftovers 2011 (Difference Edition)

Auch nicht (siehe die Filter oder die non sequiturs oder die allgemeine Cluelessness oder die Begrenzung der Wirksamkeit oder die Gleichzeitigkeit der Ungleichzeitigkeiten ) wirklich weitergekommen sind wir beim Einführen, Prozessieren und Postprozessieren von (nützlichen) Differenzen.

(die effekte reichen von naja, schade und ärgerlich bis fatal und unerträglich; und natürlich auf allen ebenen, persönlich, peergroupig, sozial, global, universal; oft sind differenzen fast selbstevident fassbar durch das simple verwenden von begriffen, und doch zerfliessen sie uns unter den fingern, wenn wir sie nicht habituell reaktualisieren)

((nicht deshalb aber dazu passend sei hier nochmal auf die model thinking klasse verwiesen; die hilft vl. nicht beim definieren der idealen differenzen für die eigenen idiosynkratischen gegebenheiten, aber sie hilft doch beim reduzieren der komplexitäten und schult das konsequente durcharbeiten von annahmen; und auch bei einfachsten annahmen kommt man schon erstaunlich weit; u.a. lässt sich etwa die gesamte aufregung um gauck mit einer leichten variation des standing ovations modells erklären, ohne auf semiotische, memetische oder demokratiepolitische verwebungsszenarien zurückgreifen zu müssen, die die analyse in eine komplexitätsbedingte unendliche unauflösbarkeit verscheiben))

Bot Bot Go

Apropos Twitter, New, Etc. : wirklich sehr angetan bin ich von Tweetbot for the iPad (ann) – die haben zum Glück Twitters idiotische Empfehlung doch besser keinen Twitter-Client mehr zu entwickeln ignoriert und eine gut durchdachte und elegante Alternative gebaut, die das offizielle Twitter alt ausschauen lässt (wobei ich die offizielle iPad-App an sich nicht schlecht finde, sie ist eine Baseline-Version, die die durschnittliche Benutzung reflektieren muss; aber das ist ja genau der Grund für die Schwachsinnigkeit von Twitter: gut genug für den durchschnittlichsten Anwendungsfall bedeutet halt auch nicht wirklich gut für gar nix; usw.)

Vor allem haben sie den Client-Filter implementiert, den ich mir schon sehr lange wünsche. Weitere nette Features: im eingebauten Browser zum Betrachten von Links kann man gleich auf Readability stellen; man kann sich einige Dienste (Instapaper, Pinboard, …) zum Späterlesen konfigurieren (genial!), man kann das Retweet-Format konfigurieren, also auch etwa mit ‘RT @name ..’ retweeten (auch super), überhaupt kann man so ziemlich alles konfigurieren, auch die Gesten usw.; Listen sind vollwertige Timelines; und vieles mehr. Eine Empfehlung.

Quiz Pt. 54 Solution

Ich bin euch/Marcel ja noch die Auflösung von Quiz 54 bzw. der Frage, warum Pinterest so erfolgreich werden konnte, schuldig. Wie gesagt, richtige Antwort gibt es sowieso nicht, natürlich spielt da eine Reihe von Faktoren zusammen. Anyway:

(1) Die Pflicht: Es hat die notwendigen inhärenten Merkmale einer guten Webanwendung. Das Design stimmt, man versteht schnell um was es geht, die Features stimmen, die sozialen Achsen stimmen und laufen auf mehreren Dimensionen, die Performanz stimmt, es befriedigt den Impuls des Jagens, Sammelns und Kuratierens, etc. Alles zumindest gut genug.

(dieser punkt ist üblicherweise notwendig, aber natürlich keineswegs hinreichend. i.e. nicht jede auch sensationell gut gemachte seite wird erfolgreich, duh)

(2) Die Kür: Es etabliert – und das ist doch eine Leistung an sich – einen neuen fundamentalen Datentyp: den Pin.

(das ist dann auch das flottierende soziale objekt)

(3) Die Kernreaktion: Es hatte sich eine funktionierende Community etabliert gehabt, bevor die Pundits, ‘early adopters’ und Massenmedien drauf gestossen sind. Das ist der wichtigste Punkt.

Pinterest ist ja vor fast zwei Jahren gestartet, ist also keineswegs vom Himmel gefallen. Dann blieb es allerdings ca. 1,5 Jahre lang mehr oder weniger unentdeckt, hat sich aber in der ‘kreativen’ Szene nicht nur als Geheimtipp etabliert. Ein früher Eindruck :

Ein schneller Blick verrät: Pinterest zieht vor allen Dingen weibliche Nutzer an; vom Moodboard für die eigene Hochzeit, über Mode und Ausgehfrisuren sowie Inneneinrichtungsideen bis zu Designinspirationen ist so ziemlich alles vertreten, was das kreative Web derzeit umtreibt.

Damit haben sie sich selbst die Bedingung für die spätere Möglichkeit zur viralen Explosion geschaffen, weil – als dann der Impuls zur sich beschleunigenden Ausbreitung kam – etwas da war, an das neue User anknüpfen konnten. Es gab Kultur, Material, funktionierende Praktiken und eine gutgelaunte Community. Als neuer Gast fand man sich durch Zufall auf einer unerwartet coolen Party ein (bevor die social media crowd draus ein saufgelage am ballermann macht, anders als ‘geplante’ erfolge wie alles von google, wo man sich eher wie der zehnte besucher in einem ansonsten leeren stadion fühlt; das ist auch der grund, warum google nix soziales machen kann; bei ihnen gibt es nichts, was zwischen der steppe und der horde liegen kann).

Ein glückliches Timing ist zwar wichtig (wir sehen ja immer wieder: ein und die gleiche idee kann zwei oder zehn jahre zu früh kommen; eine welt, in der jeder ein iphone hat und bei facebook und tumblr ist und in der man den sinn von twitter nicht mehr erklären muss ist eine andere als eine welt davor; usw. siehe Timing oder Timing II), aber nur wegen der schon existierenden Community konnte Pinterest die durch den Hype und Metahype (wie damals bei twitter) ausgelöste Kraftwelle in echte neue Benutzer konvertieren, die die Welle dann verstärken.

Postinventory X