Selection 2010 Pt. 2

5 Jahre live.hackr

![]()

![]()

![]()

![]()

![]()

live.hackr feiert heute seinen 5ten Geburtstag!

fünf jahre sind doch ein kompakter block, guter anlass für einen kleinen (eher assoziativen und nicht ansatzweise vollständigen) rückblick:

wie wars?

vor fünf jahren stellte sich die situation etwa so dar, dass der übergang zum ‘web 2.0’ quasi vollzogen war. o’reilly hat die elemente und die sich daraus ergebende dynamik sehr treffend erkannt und benannt, die fundamentalen datentypen (links: delicious, fotos: flickr, video: youtube, musik: last.fm, maps: google maps, location: plazes, usw.) wurden gerade besetzt, die zutaten (profile, tags, ajax) waren bekannt, die design-ästhetik wurde (sicherlich auch damals schon ironisch affirmativ) eingehalten.

vieles davon war auch damals schon nicht neu (es gab zb. auch 2004 eine gefühlte social network erschöpfung (yasn/yet another social network), einen seit jahren vor allem akademisch geführten diskurs über social software, usw.), aber es war auch spürbar, dass sich eine spezifische formation (die abstraktion von allem tu- und denkbaren in den raum web; die interpenetration der systeme menschen und maschinen) gebündelt hat, die ein aufbruch zu etwas neuartigem war. und das war es dann auch und wir stecken mittendrin.

was ist passiert?

- die besetzung der fundamentalen datentypen hat sich weitestgehend granularisiert (neben delicious: ma.gnolia, diigo, pinboard.in, …; neben flickr: picasa, ffffound, zooomr, …; neben youtube: ustream, blip, dailymotion, hulu, …; neben last.fm: hypemachine, soundcloud, spotify, pandora, …; neben google maps: openstreetmap, bing maps, yahoo maps, …; neben plazes: brightkite, fireeagle, foursquare, …)

dienste entstanden entlang aller sinnvollen achsen (regionale klone, thematische vertikale, achse zeit (live video, timestamp check-in), open source, etc.). üblicherweise gab es zunächst viele direkte klone, nachdem sich aber ein gewinner abgezeichnet hat, kam es zu stratifizierungen und spezialisierungen.

- so gut wie jeder andere sozialisierbare datentyp wurde besetzt und in das gesamtgewebe eingebunden (ich bin über 25.000 webapps gestolpert, die zu guten teilen kleinere datentypen sozialisieren; nur ein paar beispiele: bücher: library thing, farben: kuler, dokumente: scribd, finanzen: mint, …) das kernkonzept dabei ist das der social objects – die dienste entstanden rund um beziehungsgeflechte rund um getauschte objekte.

- was die traditionellen medien betrifft kam es zu einer atomarisierung der vorherigen, an bestimmte formen geknüpfte aggregatszustände für inhalte (stichworte: unbundling, microchunking) und zu verschiedenen formen der rekombination.

das betraf im übrigen nicht nur die traditionellen formen (albums zu tracks zu samples; zeitung zu artikel zu zitaten; etc.) sondern auch die webnativen formen wie etwa blogging (micro aka twitter, tumblelogs wie tumblr, soup.io).

- es enstanden einige genuin neue und eben molekulare fundamentale datentypen: tweets / twitter (die kleinste gedankentragende einheit), check-ins / foursquare (die kleinste ortbesetzende einheit), likes / facebook (die kleinste aufmerksamkeit-indizierende einheit), usw., und eine neue semiotik bzw. ökonomie der produktion, distribution und rezeption dieser neuen datentypen.

- the rise of the stream

der stream wurde in der folge zur zentralen metapher für den konsum (input) und die transformation (output) dieser klein- und kleinstformatigen inhalte.

der konsum von streams ist nach dem lesen von feeds tatsächlich auch die zweite grundsätzliche, web-native kulturtechnik des rezipierens. beide muss man sich aneignen bzw. erlernen, wenn man sie nicht kann, versteht man bestimmte phänomene nicht bzw. ist mit ihnen nicht kompatibel.

imho ist das lesen von feeds die wertvollere (effizientere, optimierbarere, personalisierbarere) technik, aber das schwimmen im strom hat natürlich auch seine qualitäten (wireds proprioception / social 6th sense).

(nur am rande: insofern ist es mehr als verwunderlich, dass es da nicht mehr gute lösungen gibt; friendfeed gibt’s jetzt auch schon drei jahre und viel hat sich seither nicht getan, buzz etwa hinkt konzeptionell und technisch noch immer hinter friendfeed stand 2008 hinterher).

- the rise of mobile

(devoha weil nicht wirklich mein thema; das iphone hat mehr oder weniger alleine das potential des mobilen internets freigesetzt, mit dem ipad machen sie jetzt das gleiche mit tablets, apps!, google versucht mit android den anschluss zu halten, etc; damit verbunden natürlich auch die zarten versuche rund um location).

- der shift in die cloud.

auch das war als vision und wunschvorstellung nicht neu (man denke an suns ansatz in den 90ern, grid computing, etc.) – aber auch hier hat sich wohl in den letzten fünf jahren eine konkrete formation gebildet, die erstmals auch marktfähig ist und auch gefühlsmässig hier ist; um zu den 25.000 webapps zurückzukommen: ein guter anderer teil davon sind tools, die ehemalige desktop apps in die cloud bringen; wie immer entlang der achsen private tools, kollaborative tools, enterprise tools und per definitionem auch soziale tools; man kann mittlerweile wirklich fast alles im browser machen. neben der abwanderung von funktionalitäten in die cloud hat sich auch eine neue infrastruktur für die cloud entwickelt, sprich amazons cloud-folio, google app engine, heroku, etctrara.

- the rise and fall of the real time

auch das real time web war nichts neues – technorati hat sich glaub ich schon 2004 damals das ‘live web’ auf die fahne geschrieben, instant messaging gab’s schon immer usw. – aber die letzte meile (von minuten zu sekunden) sind wir wohl erst jetzt gegangen. was aber ausblieb waren wirklich schlüssige anwendungen. das kleine gefühl der sich autoaktualisierenden intimität braucht eben nicht nur zufällige zeitgleichheit, sondern auch noch den unwahrscheinlichen fall der aufmerksamkeitskoinzidenz.

(würde ich als thema nicht abschreiben, da werden sicher weniger ‘naive’ anwendungsfälle kommen, vor allem im bereich rekombination, filtering, analytics der gigantischen mengen an rohen echtzeitdaten)

- the death of theory

konzeptionell hingegen hat sich das web jeden funken theorie ausgetrieben. der eher akademische diskurs rund um social software wurde von niemandem gelesen und in der folge vom eher technokratischen diskurs web 2.0 abgelöst, dieser wiederum wurde von niemandem verstanden und in der folge von social media abgelöst, der aber eigentlich nur angewandte pr ist. was fehlt ist eine theorie, die konsequent den wirklichen wert für den user (entlang des gesamten spektrums individuum – gruppe – gesellschaft – system) in den mittelpunkt stellt. (in ansätzen gibt es das bei shirky (wie transformieren wir den cognitive surplus in civic value) und haque (was sind die relevanten kennzahlen für eine nicht selbstzerstörerische ökonomie)).

- die gleichzeitigkeit von ungleichzeitigkeiten

ohne das breit zu problematisieren, 2004/05 gab es eine art kultur der gleichzeitigkeit, einfach deshalb, weil alles für alle neu war und gerade kollektiv erarbeitet wurde. heute ist die situation eher eine radikale gleichzeitigkeit von ungleichzeitigkeiten, ständig fliessen neue gruppen hinzu und werden ein einer art atemporality, die auch die gesamte vergangenheit schluckt, aufgelöst.

ein effekt davon ist, dass es für neue user insgesamt sehr viel schwerer geworden ist, die wichtigsten basics zu verstehen, weil das web nicht sehr gut dabei ist, wissen zu bewahren, und weil natürlich tonnenweise gänzlich uninformierte aussagen zirkulieren (nicht nur das systematische und hysterische verblödungsprogramm der massenmedien, auch die social media platituden, etc.), aber woher soll man das als frischling wissen oder richtig einschätzen können.

- die übersättigung

für neue apps wurde es ab einem gewissen grad der sättigung an apps unglaublich schwer, eine gesunde grund-community anzuziehen. eine solche ist aber unendlich wichtig, weil sie die kultur des dienstes definiert, den vibe vorgibt, weil sie sich und den dienst gegen einflüsse und angriffe von aussen verteidigt, weil sie oft überhaupt erst den dienst erfindet – siehe twitter. (das gefüge der community kann sich verändern und in den meisten fällen verändert es sich auch und oft zieht die grundcommunity weiter, aber sie wirkt trotzdem nach. man denke an delicious, flickr, ffffound oder dysfunktional digg). viele neue tools suchen ihr heil in der flucht (we’re in it to win it, fokus auf betriebswirtschaftliche zahlen und die social media metriken, herankarren von beliebigen usern, virality) – aber ignorieren die kulturelle dynamik von diensten. die sensiblere variante setzt derzeit auf game mechanics (paradebeispiele foursquare und gowalla mit ihren badges), aber auch hier muss man aufpassen, welche anreize man setzt. ein dienst ist nicht nur das von ihm ermöglichte angebot, sondern auch das spezifische ökosystem an usern und das zusammenspiel mit dem ökosystem at large.

neben dieser serie an entwicklungen, die (tendenziell) expandierende und deterritorialisierende kräfte freisetzte, gab es eine andere serie an entwicklungen, die (tendenziell) alles wieder aufsaugte und auf sich reterritorialisierte:

darth facebook

an sich ist facebook eine extrem gut gemachte und extrem gut durchdachte seite, die für viele leute wirlich ganz super ist. etwas abstrahiert betrachtet ist facebook ein ding gelungen: sie haben grössere teile ehemals privater kommunikation ins web gebracht und vernetzt. für sich allein betrachtet ist das super aber für das web at large ist der aufstieg von facebook zum schwarzen loch ein holzweg. nicht wegen facebook selbst, sondern wegen der reaktionen aller anderen (was man facebook eigentlich nicht vorwerfen kann.)

(privacy ist bei facebook übrigens kein echtes problem. wer sich eine stunde mit den settings auseinandersetzt, der kann die sichtbarkeit seiner outputs grundsätzlich kontrollieren; ein echtes problem wäre eher die übertragung der ownership des eigenen outputs an facebook, die auslieferung unter die willkür der tos, usw., aber das ist dann teilweise auch egal, weil die aktivitäten oft nur einen temporären charakter haben und von einem selbst gwm. abgeschrieben werden können.)

einige der sich aus facebook ableitenden probleme sind:

die neutralisierung des potentials des offenen webs

die dominanz von facebook hat dazu geführt, dass grosse teile des offenen webs (natürlich nicht alle, es gab auch eine fülle an interessantesten entwicklungen) von facebooks grösse quasi mesmerisiert nur noch eines wollen: offene alternativen zu facebook zu schaffen. reflexartig wird bei jedem neuen feature von facebook oft innerhalb von wenigen tagen ein offenes gegenprodukt ausgerufen (fb connect – openid; likes – openlike; share – openexchange; facebook plattform – open social; usw.)

effekt ist, dass sie nur von facebook ohnehin schon gelöste probleme nochmal lösen, aber keinen neuen horizont öffnen, keine bessere alternative offerieren. der einzige anspruch ist, von facebook vl. ein paar prozentpunkte marktanteil abzuknabbern.

der wahrscheinlich blockierendste selbstgewählte würgegriff: sie setzen auf noch mehr privacy – wir alle wissen: facebook kann man nicht trauen, das ist unser usp – und machen dadurch für sich selbst alles wirklich kompliziert. wenn das open web privacy zunächst einmal ausklammern würde und versuchen würde, das fliessen von allem öffentlichen zu katalysieren, dann wären wir schon jahre weiter.

the one social graph

ein weiterer von facebook ausgehender bremsklotz für die entwicklung des webs ist die grundannahme, dass jeder seinen sozialen graphen hat und den dann idealerweise von dienst zu dienst mit sich mitschleppt (was eben auf facebook zentralsiert geschieht).

schon die vorstellung ist schrecklich: man kann gehen wohin man will – und überall sind immer schon die gleichen leute da.

der ganze punkt am web aber ist, dass man nicht auf den handlungs- und denkkosmos seiner freunde beschränkt bleibt, sondern dass man sich interessengetrieben ausdifferenzieren kann. die eigenen freunde sind immer die besten und sie bleiben es auch, aber einerseits weiss man ohnehin, was man von ihnen erwarten kann (i.e. ich weiss wen ich fragen kann, was ich lesen oder hören oder mir anschauen soll, und wen ich besser nicht frage), und andererseits macht sie die tatsache der freundschaft nicht notwendigerweise in jedem bereich interessant.

(ich vermute mal der studentische background von facebook ist der grund, dass facebook das noch nicht erkannt hat. in der high school und im college hängt man halt mit seinen freunden ab und darüber hinaus interessiert einen wenig; es ist jedoch unverständlich, dass etwa google etwas noch viel blöderes glauben konnte, nämlich dass das adressbuch des email-accounts auch nur irgendwas bedeutet, geschweige denn ein indikator für globales interesse ist, wobei sich das wahrscheinlich daraus erklärt, dass das im googleverse zusammenfällt)

wir brauchen jedenfalls eine entkoppelung vom engen social graph der freunde und eigentlich auch vom halt mitgeschleppten social graph aus twitter, gmail und allen anderen sammelgraphen und bessere mechanismen für frei flottierende graphen, die sich konkret via der zirkulation von social objects ausdifferenzieren können. das ist jetzt sicher nicht das grösste problem, aber angesichts der tatsache, dass jeder zweite neue dienst als erste amtshandlung facebook connect anbietet und mehr als eine million seiten die social widgets integrieren, zumindest ein bedenkenswerter.

das verlernen von sharing

das klingt ein bisschen paradox, aber facebook verlernt uns das sharen oder genauer: erschwert den moment des aha-erlebnis des erkennens des prinzips sharing, das uns quasi zu sozialen bürgern macht (und der, wenn man will, mit dem spiegelstadium vergleichbar ist, also jenem moment, in dem ein kind sich selbst als individuum neben anderen erkennt). sharing ist ja mehr als ein bloßes veröffentlichen, sharing ist eine sehr spezifische, soziale form des publizieren, die das milieu eines dienstes kennt und berücksichtigt, die das jeweils gegebene beziehungsgeflecht kennt und berücksichtigt, usw.

der parasit

es gibt viele gute köpfe auch im deutschen web, aber mit der kollektiven kompatibilität mit dem web ist es so eine sache. irgendwie läuft es mit selbstauferlegten fussfesseln herum. für das dahinmurksen gibt es wohl viele gründe, zumindest einen strukturellen, den ich sehr spannend finde, möchte ich erwähnen:

das nicht ertragen können, dass ein anderer aus der eigenen existenz ungefragt und ohne direkte bezahlung irgendeinen nutzen zieht.

dieses grundgefühl zieht sich durch alle schichten und ist – so verständlich auch die haltung ist, wer wollte das schon – im web die blockade schlechthin.

paradigmatisch wird das von der kulturindustrie repräsentiert: zeitungsverleger halten es nicht aus, dass eine nachricht ohne direkte bezahlung gelesen wird und dass google davon sogar finanziell profitiert, musikverwerter halten es nicht aus, dass ein track ohne bezahlung angehört oder als untermalung einer slideshow benutzt werden kann und dass google davon sogar finanziell profitiert, usw., aber – wie wir eben im fall faz vs. mspro miterleben konnten – es reicht schon aus, einmal ein falsch lizenziertes bild zu verwenden, um als ausbeuter wahrgenommen zu werden, oder noch viel schlimmer: als jemand, der sich als gänzlich unsensibel gegenüber den globalen ausbeutungszusammenhängen erweist.

komplementär zu diesem grundgefühl kommt der anspruch, aus der verwertung eines produktes auch noch den letzten tropfen wert aussaugen zu wollen.

dass auch die produzenten vorteile davon hätten, wenn sie ihre objekte/produkte netzwerktauglich machten, ist dabei egal. ich schneide mir lieber den finger ab, bevor ein anderer von meiner leistung profitiert, ohne dass ich direkt bezahlt werde oder mein explizites einverständnis gebe, und den finger schneide ich mir übrigens ganz sicher nicht ab, also fordere ich umfassende kontroll- und sanktionssysteme, die diesem treiben der nutznießer einhalt gebieten. die kosten für die systemische verunmöglichung von missbrauch sind aber üblicherweise um faktoren höher, als der tatsächliche schaden selbst.

im web gilt aber (mit o’reilly): erzeuge mehr wert als du abschöpfst. niemand im web will die produzenten, egal jetzt ob gross oder klein, um die früchte ihrer arbeit bringen. aber man muss sich vom anspruch befreien, die gesamte wertschöpfungskette kontrollieren zu können und jeden tropfen wert abschöpfen zu müssen. gefragt ist nicht das pochen auf sein recht und das festbetonieren von monetarisierungsmodellen und der krieg gegen die fans, gefragt sind neue geschäftsmodelle unter den bedingungen des webs. dass man nicht jeden track und jeden artikel verkaufen (oder oft nur lizenzieren) kann, bedeutet nicht, dass man damit kein geld verdienen kann.

inklusion : exklusion

eine der mich am meisten nervenden immer wieder gestellten forderungen ist, dass alles für alle voraussetzungslos zugänglich und unmittelbar verständlich sein muss, dass das internet viel zu kompliziert ist. mir ist klar, dass das gut gemeint ist (alle sollen sich an den früchten erfreuen dürfen/können/wollen, sonst verbaut man sich die chance, dass es jeder verwenden könnte, etc.) – aber der effekt davon ist, dass alles wertloser wird.

natürlich sollten verschiedene klassen von diensten so verständlich und bedienbar sein, dass sie auch von leuten, die nur seltenst das web benutzen und nicht täglich vier stunden webtechblogs lesen, angstfrei benutzt werden können. aber für spannendere geschichten ist es üblicherweise fast eine voraussetzung, wenn sie etwas sperriger sind, wenn man vorab einen bestimmten grad an eigener kognitiver leistung aufbringen muss, wenn man ein spezifisches set an problemen haben muss, bevor das tool als sinnvoll erscheint.

es geht mir um himmelswillen nicht um ausschlussmechanismen (türsteher vorm p1: mit diesen schuhen kommst du hier nicht rein) sondern um komplexitäten, die selbstselektionen ermöglichen, die in der folge eine kulturelle ausdifferenzierung auf diensten triggern (torhüter bei kafka: dieser eingang war immer schon nur für dich bestimmt).

nanocasestudy delicious: bis zum verkauf an yahoo gab sich delicious in der neuuserakquise sehr, wirklich sehr spröde, es hat sich tatsächlich überhaupt nicht erklärt. viele haben es nicht verstanden (warum soll ich überhaupt bookmarken? warum sollte ich meine bookmarks auch noch öffentlich machen? was sollen diese tags überhaupt? die seite schaut ja hässlich aus! etc.) – der effekt des nichterklärens war aber, dass es in den ersten jahren fast ausschliesslich leute verwendet haben, die sich diese fragen selbst beantworten konnten. der effekt davon war, dass die qualität der geposteten links und der vergebenen tags sehr hoch war und dass eine community entstand, die ein regelwerk an akzeptablen verhalten entwickelte und die sich gegen störungen verteidigte. auch nach dem verkauf an yahoo blieb es spröde. sie haben zwar eine art begründung und anleitung geschrieben, aber auch nach yahoo blieb das wichtigste feature die verweigerung der implementierung von geforderten features.

nanocasestudy hacker news: hacker news ist ein paradebeispiel dafür, wie sich ein dienst durch eigensinn auch in einem gesättigt scheinenden markt positionieren kann. 2007 gab es schon hunderte soziale aggregatoren für technews, allen voran digg. aber diggs dna war traffic und einfluss, es wurde zu einer art MMORPG mit der währung diggs und dem sozialen objekt links, das in der folge in die inhaltliche irrelevanz gegamed wurde (aber natürlich noch immer tonnen an traffic verschickte, was leider als relevanz interpretiert wurde). hackr news tat einen teufel, um auf sich aufmerksam zu machen, und hat der quantität an usern, links, diggs und klicks ein einfaches regelwerk entgegengesetzt, welches die höchste qualität an startup news und fast immer auch interessante kommentar-threads produzierte. der unterschied ist die qualität der community und das ignorieren unfruchtbarer metriken.

livecasestudy tumblr vs. posterous: ein interessanter fall spielt sich gerade vor unseren augen ab: der kampf zwischen tumblr und posterous um die hegemonie unter den tumblogs. beide tun im grunde das gleiche, aber tumblr setzt (tendenziell) auf kultur und community und posterous setzt (tendenziell) auf alles was sich bewegt (inklusive yo mama und abwerbeaktionen von anderen publishing-plattformen) und auf ein aggressives virales cross-posting der posteroustings auf jeder möglichen plattform. der ausgang ist ungewiss (die lage ist etwas komplizierter, weil die soziale dynamik nur eine und vielleicht nicht die wichtigste komponente bei der benutzung ist. posterous ist, bei aller platzhirschigkeit, ein gutes tool und nichts verhindert das betreiben von coolen posterous-blogs. gleichzeitig sind diverse traffic acquisition stunts auch tumblr nicht fremd), aber tumblr sollte die kulturell interessantere plattform werden, weil es wuchernde serien fördert, die sich aufeinander beziehen. beide sind übrigens schon so gross, dass es auch wieder platz für nachzügler gibt, wenn sie das problem gute und selbstselektierende community knacken.

dienste für alle sind also völlig ok, aber es muss nicht jeder dienst für alle sein. wir brauchen mehr tools, die sich an den rändern ausdifferenzieren, die für wenige aber für diese dafür extrem gut geeignet sind. auch die spezielleren dienste brauchen üblicherweise eine gewisse kritische masse, davor greifen die verstärkungslogiken und sozialen dynamiken nicht. es gibt aber auch eine kritische masse nach oben, einen punkt, an dem der dienst nur noch schlechter wird. (dabei ganz interessant: facebook ist gegen diesen punkt resistent, weil es kein eigentliches ‘soziales’ tool ist, sondern nur ein überraum über partialgraphen; auch wenn facebook eine milliarde mitglieder hat, tangiert mich das nicht).

mit d/g könnte man sagen: wir brauchen ein web der tausend plateaus, der milieus, der falten.

konversation

words are cheap und conversation ist auch cheap.

natürlich nichts gegen das prinzip konversation, aber wie oben im bereich theorie hat auch der begriff konversation in den letzten fünf jahren eine eine konzeptionelle abwertung erlebt; ging es im cluetrain manifesto noch um die veränderung und transformation von märkten, fehlt mittlerweile in der gleichung die transformation der märkte und der reine akt der konversation als solcher wird gefeiert. die folge ist leider systematisierte zeitverschwendung.

ich kann mich an keinen tag in den letzten drei jahren erinnern, wo nicht irgendwer irgendwarum irgendwas über konversation gefaselt hat, sei es weil sie fehlt, oder als lobende erwähnung, weil sie da ist, oder als kategorischer imperativ für das web. ich kann mich aber nicht daran erinnern, dass irgendwer in den letzten drei jahren den tatsächlichen wert der tatsächlich geführten konversationen jenseits ihres bloßen haltdaseins hinterfragt hat. natürlich, sie muss authentisch und menschlich sein, engaging sein, auf augenhöhe geführt werden, durch zuhören getriggert sein, etc., aber wenn sie das ist (oder so tut, was auch nicht so schwer ist), dann geht schnell die la ola los und alle sind über sich selbst gerührt. und kann man mit seiner checkliste technische fehler ausmachen, dann wird gleich mit verve erklärt, wie man das jetzt in social media so macht. aber niemand schaut sich an, was der eigentliche mehrwert der konversation ist und vor allem: ob es tatsächlich effekte gibt. (ok, ok, jarvis hat natürlich dell vom taylorismus ins googlezeitalter geführt).

mein eindruck: unterm strich sind grösste teile des gequatsches (von unternehmen auf ihren gefundenen social media kanälen) eine reine beschäftigungstherapie und also reine zeitverschwendung für alle beteiligten. ich habe zwar überhaupt nichts gegen selbstbestimmte zeitverschwendung. wer jeden tag eine stunde (oder drei stunden) farmville spielen will, weil ihm das spass macht, der soll das tun, besser als fernsehen ist es allemal. das problem ist, wenn unternehmen diese zeitverschwendung künstlich und systematisch in ihre aussenkommunikation hineinbauen, um irgendwelche (engagement-) metriken optisch aufzubessern, ohne aber auch nur im ansatz darüber nachzudenken, wie sie bessere produkte und weniger crap produzieren. (den unternehmen kann man wie oben facebook natürlich keinen vorwurf machen. klar findet es coca-cola super, wenn ein promoted tweet 85 mio impressions und 6% engagement kriegt und leute dann auf dem youtube-kanal von coke landen, wo man teil der coca-cola jubelkette werden kann).

uff, ist doch etwas länger geworden. und auch etwas jammernder, als es mir lieb ist. und natürlich teilweise auch sehr pauschalisierend.

Einen herzlichen Dank an alle, die es bis hierher geschafft haben oder gelegentlich hier mitlesen und kommentieren, ohne euch wäre es nicht so lustig!

Man Child

Robert Scoble skizziert bei TechCrunch seine Vision der Zukunft (unterm strich einen HAL, der sich aus sich selbst intelligent miteinander verknüpfenden diensten zusammensetzt)

Als Persona ist Scoble wirklich super; er ist der User, der nie im Da ist, dem immer gerade zumindest ein Feature und ein Jahr zum Glücklichsein fehlt (2009 hat er sein 2010 web ausgerufen, 2010 faselt er von location 2012), usw.

Als Persona ist Scoble wirklich super; er ist der User, der nie im Da ist, dem immer gerade zumindest ein Feature und ein Jahr zum Glücklichsein fehlt (2009 hat er sein 2010 web ausgerufen, 2010 faselt er von location 2012), usw.

(insofern ist er der anti-macgyver; während angus ein bastler ist, der jedes auch noch so unlösbar scheinende problem durch geschickte kombination vorhandener mittel dann doch noch löst, will robert maschinen, die genau das können, was er sich gerade denkt (rob-bots))

(abt. die rote oder die blaue pille)

Huh?

Beim Lesen des Feuilletons und beim Betrachten der Diskussionen mit Feuilletonisten im Fernsehen stellt sich (wenn es um das Thema Web geht) unweigerlich die Frage: Warum tun sich Intellektuelle mit dem Web so schwer?

Man möchte glauben, dass zumindest grosse Teile ob des offensichtlichen Potentials frohlocken (die Möglichkeiten! für einen selbst!! für die Zusammenarbeit!!! für die Gesellschaft!!!!), aber nein, ohne Übertreibung sind fast alle Ergüsse pseudokritischer gequirrlter Bockmist oder Themenverfehlungen, diplomatischer formuliert. Aber warum nur?

These: Intellektuelle tun sich mit dem Web deshalb so schwer, weil sie intuitiv spüren, dass sie dem Web egal sind.

—

Exkurs: Was tun Intellektuelle?

Hobby-soziologisch betrachtet produzieren und engagieren sie sich in Diskursen, mit denen sie auf dem Sprachmarkt Distinktionsgewinne erzielen, die sie in der Folge an verschiedenen institutionellen oder wirtschaftlichen Positionen einlösen können (siehe dazu das Gesamtwerk von Pierre Bourdieu).

Damit das funktioniert, müssen sie natürlich einen gewissen Systemnutzen (oder zumindest eine vom System angenommene Systemnutzensimulation) stiften, z.b. in Form von Irritation oder Vermittlung (Professoren, Journalisten, Kritiker, ..). Ihre Aktivitäten müssen also einerseits differenzierter (zumindest komplizierter) als der durchschnittliche Hausverstand sein (sonst wären sie überflüssig), gleichzeitig müssen sie aber anschlusskommunikabel sein (sonst würden sie nicht angenommen).

—

Vor und in das Web gestellt befinden sich Intellektuelle nun vor einem Dilemma: Es ist so gut wie unmöglich, (von außen) Aussagen über das Web zu formulieren, die (innen) beide Kriterien erfüllen (weltweit gibt es vl. eine Handvoll Leuten, denen das gelingt; die Wahrscheinlichkeit, dass der Hausundhofintellektuelle der lokalen Tageszeitung da dabei ist, geht gegen null).

Ein Grund dafür ist, dass das Web eher – ja was eigentlich? – ist. Die Analogie stimmt zwar nicht ganz, aber auf gewisse Weise entspricht das Web der Funktionslogik der Sprache. Um (mit anderen) sprechen zu können, muss man sich der symbolischen Ordnung der Sprache ‘unterwerfen’. Die Sprache definiert in der Folge den grundsätzlichen Möglichkeitsraum des Sagbaren, aber nicht, was gesagt wird. Und auch das Web spannt einen neuen Möglichkeitsraum auf, definiert aber auch wiederum nicht, was daraus gemacht wird. (systemtheoretisch ist das web kein system, sondern eine art umwelt-öl, das es anderen systemen ermöglicht, sich als umwelten wahrzunehmen und sich also auf neue art zu interpenetrieren; unterm strich: alles interpenetriert alles). Das Web ist zwar an sich trivial, aber das durch Praxis realisierbare Potential ist natürlich gewaltig.

Ich glaube zwar nicht, dass es grundsätzlich unmöglich ist, einen adäquaten Diskurs über das Web zu führen ohne daran teilzunehmen, aber ein halbwegs entwickeltes Gespür kann man wohl nur durch Partizipation bekommen. (adäquat bedeutet natürlich nicht, möglichst viele positive aussagen zu sammeln, die sind fast immer noch blöder als die negativen; adäquat bedeutet auch nicht ‘richtig’). Aber teilnehmende Beobachtung meiden – zumindest die deutschen Intellektuellen – aus irgendeinem Grund wie den Beelzebub.

Wenn die meisten Intellektuellen vom Web blabbern, führen sie also keinen Diskurs über das Web, sondern einen Diskurs über ihre eigenen Aussagen (und gelegentlich über genauso irrelevante zitate von ‘protagonisten’) über das Web. Keiner versucht zu verstehen ‘what’s going on?’ und schon gar keiner versucht seinen Denkraum durch Teilnahme zu erweitern, stattdessen werden einige etablierte Erzählungen in einer Auslaufrille wiederholt und notdürftig auf das eigene Thema gemappt.

Das ist zwar ein durchaus rationales Verhalten, siehe oben, Distinktionsgewinne sind damit aber nur ausserhalb des Webs möglich (einfach deshalb, weil der großteil ihrer aussagen von jedem im web als ganz offensichtlicher blödsinn wahrgenommen werden). Was bleibt ist also die Rolle des konfirmativen Beschützers von Feldern, die im Web (oft nicht zu unrecht) eine Verunsicherung/Erschütterung vermuten. Damit erweisen sie ihrer Klientel zwar einen Bärendienst, reproduzieren aber natürlich ihre Existenzgrundlage.

Wie vglw. einfach es wäre, ihre Distinktionsgewinne auch in das Web zu übertragen, zeigt uns der Fall Peter Kruse. Auch Kruse ist eher ein Zaungast im Web, aber er erfüllt die zwei oben erwähnten Kriterien (background hirnforschung als vertrauensbildende einleitung, ein bisschen jargon aus der netzwerktheorie (grundrauschen, kopplungsdichte, kreisende erregungen, …) also differenzierter als der hausverstand; anschlusskommunikabel, weil er das web positiv besetzt (angriff auf die etablierten machtstrukturen, das ist / ihre alle seid realität und das wird nur noch mehr, …)).

Flat und Flattr

die frage warum flattr und (ein bissl weniger aber auch) kachingle vor allem in deutschland einen so fruchtbaren boden findet ist irgendwie nicht uninteressant. ich tippe fast auf einen einfluss der protestantischen ethik (rastloses bloggen soll nicht unbelohnt bleiben) die in flattr blogmonetarisierungstechnisch die erste form gefunden hat, die durch alle anderen ablehnungs- und kritikfilter durchgerutscht ist und den latenten wunsch nach ent- aber auch nach belohnung zumindest als geste befriedigt.

im grunde kann man auch sagen why not, aber was glaub ich übersehen wird sind die symbolischen kosten.

mspro hat das in der gebotenen länge thematisiert (nach mauss – geschenke sind ein trickreiches soziales konstrukt, weil sie den beschenkten in eine art schuld setzt, die aber nicht durch ein gegengeschenk zum tausch neutralsiert werden kann), aber er kommt bzgl. flattr imo exakt zum falschen schluss:

Flattr berücksichtigt sowohl die Asynchronität der Gabe und die Unmöglichkeit ihrer Rückerstattung, als auch die Freiwilligkeit und Freizügigkeit des Schenkens. Flattrn ist anonym, der Geflattrte weiß nicht, von wem er beschenkt wird, was das Flattern widerum zum echten Geschenk macht. … Flattrn ist kein Zurückgeben, aber auch keine Spende. Es ist wie Bloggen ein freies Schenken. Es bietet eine Gabeninfrastruktur die einer Spiegelung der Gabeninfrastruktur von Blogs nahe kommt.

genau das gegenteil ist der fall. flattr etabliert – wenn man die ohnehin eher problematische grundannahme von blogs als geschenke schluckt – eine infrastruktur, mit der leser ihre ‘schuld’ auf die leichtest mögliche art neutralisieren können (klick auf einen button, abbuchung von 2 oder 5 cent). die anonymität ist in dieser konstellation irrelevant, weil der leser das psychohygienisch für sich selbst tut. es ist aber kein freies schenken, der blogger nämlich bietet durch das einbinden des flattr-buttons das tauschgeschäft an und der leser nimmt es an.

die tatsache des einbindens des buttons selbst ändert also die beziehung, ein davor offener bzw. unbestimmterer raum (in dem sich die anschlusskommunikation ans gebloggte quasi frei ausdifferenzieren muss) wird strukturiert und etabliert ein verhältnis zwischen (content-)produzenten und (content-)konsumenten und unter den konsumenten die flattrnden und alle anderen, die durch diese unterscheidung zu ‘free ridern’ werden. (und wem mein letzter erguss keine 5c wert ist, auf den kann ich auch verzichten usw.)

(pragmatisch betrachtet ist das alles natürlich egal, vl. bringt es auch eine art spielerisches moment in die sache; für formen die eher dienstleistungen sind ist es vl. sogar eine funktionierende möglichkeit)

Social Objects vs. Object Socials

eigentlich spannend… wir befinden uns derzeit vl. gerade im übergang von social objects zu object socials.

there is always an object

die theorie der social objects – in a nutshell – besagt, dass es zwischen subjekten keine ‘natürlichen’ beziehungen gibt, sondern dass eine beziehung immer via eines objekts vermittelt wird. es gibt keinen (meister-) social graph, sondern fluktuierende ensembles an partial-graphen, die sich durch den austausch von objekten ausdifferenzieren.

facebook stellt diese logik aber auf den kopf. um engeström zu paraphrasieren:

there is always a subject

die objekte sind nicht länger nur die mittel, um subjekte miteinander zu verbinden, das ganze system wird objekt-zentrisch. auch im entstehenden open graph (der objekte) gibt es zwischen den objekten keine ‘natürlichen’ beziehungen (wie es zb. noch die semantic web crowd via ontologien, rdf, microformats, etc. glauben konnte), sondern die beziehungen zwischen objekten werden immer via eines subjekts vermittelt. anders als beim social graph wird aus den zunächst fluktuierenden ensembles an partial-graphen aber wohl tatsächlich so was wie ein (meister-) object graph. die subjekte selbst werden jedenfalls nur zum mittel, das objekte verbindet.

(dabei ganz witzig: die ‘asoziale’ grundannahme der social objects führt zu einem sozialen system; die ‘soziale’ grundannahme der object socials führt zu einem postsozialen system)

Das unsichtbare Dritte

photo credit: wikimedia

Facebook ist, das wissen wir alle, das Böse unter der Sonne.

Frage: na und‽

Der Touch of Evil von Facebook liegt, kommt mir vor, nicht in einer radikalen Bösheit – was machen die Leute? sie tauschen sich aus, sharen, spielen Farmville -, sondern in der Fähigkeit, alle anderen von dieser Bösheit besessen (im sinne von um diese bösheit herumzuobsessieren) zu machen.

Das Problem mit Facebook ist also nicht Facebook, sondern die Dummheit des Restwebs im Zumsichselbstfinden unter den Bedingungen von Facebook. Facebook hat einerseits die Messlatte für die meisten Beobachter (Blogger, Gründer, VCs) so verschoben, dass nichts anderes mehr sichtbar ist (ein dienst mit 50.000 usern, roflmao, facebook hat 10.000 mal soviel). Und andererseits treibt es das ‘offene’ Web in diesen vor kurzem beschriebenen antisynthetischen Reaktionsstrudel. Offen bedeutet immer seltener intensivierend/molekular und immer öfter verdoppelnd/molar aber halt offen.

XAus

Langsam wird es Zeit Siggi Beckers … versuchen nicht das Aufmerksamkeitsproblem zu lösen, sondern für sich zu entscheiden

(sb, siehe attention suckers und blubberrohr) umzuschreiben in … versuchen nicht einmal mehr das Aufmerksamkeitsproblem für sich zu entscheiden, sondern nur noch die verbleibenden Krümel und Reste untereinander zu verteilen.

Jüngstes Beispiel XAuth, eine Art cross platform Autorisierungsthingy, bei dem mit einem JavaScript-Overlay der eigene soziale Graph auf alle unterstützenden Seiten quasi mitgenommen werden kann (siehe, oder, oder, oder, oder)

(was ja auch nicht anundfürsich schlecht ist, das problem ist die anspruchslosigkeit des anspruchs. sie versuchen erst gar nicht mal, eine grundsätzliche alternative zum modell von facebook (und zu teilen twitter) zu entwerfen, den ganzen komplex identität, aufmerksamkeit, social graph zu überdenken und einen radikal ‘offenen’ gegenentwurf zu konzipieren, sie versuchen nur im bestehenden gefüge zumindest einen teil vom kuchen zu behalten; sie versuchen nicht, den (system-) wert vom sharing zu erhöhen, sharing besser, effizienter, vielfältiger, smarter zu machen, sie versuchen nur den marktanteil an herumgeshare ausserhalb von facebook (und zu teilen twitter) zu steigern, usw.)

(abt. ja mei)

What's going on?

kleine anmerkung zu peter kruses vortrag bei der re:publica … so erfreulich seine person in dem ganzen deutschen herumlaberdiskurs auch ist, mit seiner hauptthese, das problem sei ein problem der werte und ist deshalb durch diskurse auf sachlicher ebene nicht ausdiskutierbar, sitzt er glaub ich auf dem falschen dampfer. genauer gesagt hat er mit dem es ist nicht ausdiskutierbar recht, aber aus den falschen gründen und deshalb mit den falschen schlussfolgerungen.

basis seiner thesen sind zwei achsen:

einerseits die beobachtung der beschreibungen des internets, die er in die gruppen ‘das internet macht uns alle dumm und nurgottweisswassonstnochalles kritiker’ und die ‘distanzlosen euphoriker’ teilt.

andererseits eine studie, bei der die wertemuster von ‘heavy usern’ gemessen und gruppiert wurden, und wo sich in der folge zwei paradigmatische typen herauskristallisierten, digital visitors und digital residents, wobei beide gruppen die sachlage richtig beurteilen, aber wegen der jeweils verschiedenen wertelandschaften völlig unterschiedlich interpretieren. ein rationaler disput sei deshalb nicht möglich, solange nicht diese wertedifferenzen von allen beteiligten ausreichend mitreflektiert werden.

ohne jetzt die grundsätzliche bedeutung von werten auf unsere ganz allgemeine operationsweise (wahrnehmungsapparat, etc.) herunterspielen zu wollen, die von ihm extrahierten wertebündel deuten eher auf den grad des verständnisses und auf die jeweils konsumierten quellen und nicht auf eine unveränderliche disposition und ‘echte’ werte hin.

heavy user zu sein heisst zunächst einmal überhaupt nix. (ich kann mein leben lang fernsehen und hab trotzdem null verständnis für medientheorie, creative sitcom writing, fernsehtechnik, etc.)

wenn ich mir den katalog an (die implizit dann die werte beschreibenden) begriffen anschaue, mit denen er die leute vermisst, dann sind die allermeisten grundsätzlich orthogonal zum web. sie haben mit dem web nix zu tun. er konstruiert gegensatzpaare, die aber eigentlich UND-verknüpfungen sind. er konstruiert zuordnungen, die aber eigentlich verkrustete und wiedergekaute diskursfragmente sind.

(es ist dabei nicht hilfreich, dass der diskurs der massenmedien grundsätzlich hysterisch ist, also immer nur nach oben oder unten masslos übertreibt. der organische diskurs krächzt mitunter deshalb so vor sich hin, weil er sich in diesem wirrwarr an genauso blöden und leider oft genauso hysterischen gegenreaktionen verfängt, die ganzen begrifflichkeiten sind oft schon falsch, bevor sie überhaupt erst gefasst werden können)

((das andere, was nicht hilfreich ist, ist, dass die beschreibungen immer mit zu ‘grossen’ begriffen belegt werden, als hätte das web das notwendig, aber das ist eine andere geschichte))

RT @marshallmcluhan Stop asking “Is this a good or bad thing?” and start asking “What’s going on?”

aber um auf meine kritik an kruses diagnose zurückzukommen: ich glaube also nicht, dass unser problem ein problem inkompatibler (und deshalb kaum zu überwindender) wertvorstellungen ist. ich glaube eher, dass die jeweiligen wertebündel nur das symptom des grades und der qualität unserer jeweils spezifischen interpenetration mit dem system web sind. und diese interpenetration ist kein linearer evolutionsprozess (sprich: es ist nicht so, dass die einen weiter sind als die anderen, dass eine stärkere selbstkoppelung an das web fortgeschrittener als eine schwächere ist, etc.), aber es ist doch so, dass es grade an verständnis (oder besser verständnissen) gibt, die die eine oder andere wahrnehmung verunmöglichen oder als scheinwiderspruch erkennen lassen.

(verstehen ist natürlich ein blödes wort, wir können das alles alle zusammen nicht richtig verstehen, verstehen also eher im sinne von verstehen, dass man zwar nix verstehen kann, dass man aber versuchen kann, die möglichkeitsräume von den dingen zu erahnen und für sich und die eigene lebenspraxis abzuchecken, dass man versuchen kann zu beobachten, was andere machen und welche dynamiken dadurch entstehen, dass man für sich herausfinden kann, was für einen selbst funktioniert und was nicht, etc.)

The XX

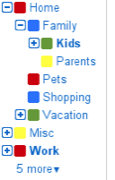

(anlässlich dieses gmail-emuliert-folders-thingies …)

Folgt man der gemeinen Dialektik, dann kann man die Entwicklung von Phänomenen oft sehr treffend als Spirale von Thesen, Antithesen und auf etwas höherem Niveau quasi doppelt verneinten Synthesen beschreiben.

Einer der eigenartigen Aspekte vom Web ist, dass sich die Synthesen oft nicht auf einem ‘höheren’ Niveau ausdifferenzieren, sondern dass sich die dialektische Spirale gwm. nach unten dreht. Es kommt zu Antisynthesen, die für alle zusammen weniger wert sind.

Beispiel Gmail

Bevor Gmail 2004 lanciert wurde, gab es (ein bissl konstruiert, aber um den punkt zu machen:) als These viele mehr oder weniger gute Mailprogramme für den Desktop und als Antithese einige mehr oder weniger schlechte webbasierte email-Clients (Hotmail, Yahoo, AOL usw.), die zwar im Web liefen, aber die grundsätzliche Metaphorik nicht hinterfragten.

Doch dann kam Gmail und hat Email radikal neu definiert und als Gmail synthetisiert. Man kann sich heute, glaub ich, nur schwer vorstellen, wie radikal anders Gmail damals war; Google hat gesagt: wir geben euch Tags und wir geben euch Threads und wir geben euch Suche und wir geben euch Speicherplatz und wir geben auch Speed und that’s it. Wie so oft war das nichts für alle (jeez, was gab es für ein geschrei und bemängelungen und feature requests und beweisführungen wie viel besser outlook ist, weil es zehntausend spezialfälle behandeln kann), aber wer sein Verhalten unter dem neuen Paradigma redefinieren konnte, für den war das ein Quantensprung.

Zurück in die Gegenwart und was macht Google im Jahr 2010? Sie emulieren mit ihren Labs-Features alles, wovon sich Gmail ursprünglich distanziert hatte; sie bauen peu à peu wieder jede Komplexität ein, deren Ballast sie ursprünglich abgelegt hatten. Sie fördern nicht mehr kreatives und flüssiges Verhalten, das man sich selbst auf Basis der losen Koppelung der Elemente für sich selbst definieren (und auch erlernen) muss, sondern sie versuchen auch die festgefahrensten Verhaltensmuster aus historischen Kontexten abzudecken.

Zurück in die Gegenwart und was macht Google im Jahr 2010? Sie emulieren mit ihren Labs-Features alles, wovon sich Gmail ursprünglich distanziert hatte; sie bauen peu à peu wieder jede Komplexität ein, deren Ballast sie ursprünglich abgelegt hatten. Sie fördern nicht mehr kreatives und flüssiges Verhalten, das man sich selbst auf Basis der losen Koppelung der Elemente für sich selbst definieren (und auch erlernen) muss, sondern sie versuchen auch die festgefahrensten Verhaltensmuster aus historischen Kontexten abzudecken.

Man kann bei Google insgesamt zunehmend beobachten, wie sie ihre ursprüngliche Edge verlieren, weil sie sich mehr und mehr an den Spreadsheets der Marktanteile und am kleinsten gemeinsamen Nenner der Verständlichkeit für möglichst alle orientieren.

Das ist zwar alles nicht gänzlich unverständlich, aber die erzwungenen Kompatibilitäten haben diese Antisynthese als Nebeneffekt, die Dienste werden für alle schlechter.

Das Phänomen Antisynthese lässt sich natürlich auch bei einigen anderen Playern und Bereichen beobachten, aber bei Google ist es halt am auffälligsten, weil Google teilweise meilenweit vor dem Rudel war. Seit zwei, drei Jahren machen sie aber aus den meisten Dingen die sie angreifen eine mess.

Kurzschuss

kleine anmerkung zu den angedachten nächsten facebook privacy settings …

der großteil der kritik (siehe, oder, oder) zielt, natürlich nicht zu unrecht, auf das vertrauen ab.

ich glaub aber, dass der jeweilige vertrauensverlust in sie als unternehmen nicht ihr grösstes problem werden wird. sowohl facebook als auch google wissen, dass sie ohne dem grundvertrauen in sie auch schneller wieder weg sein können, als sie gekommen sind. die google buzz geschichte war sicher ein griff auf die herdplatte, aber nix, was das genuine vertrauen in google erschüttert; facebook dehnt auch gerne den bogen, aber sie sagen zumindest immer, was sie tun, und ggf. rudern sie auch zurück; jedenfalls sollte sich niemand mehr weder über facebook noch über google bzgl. ihrer datenminenden und -verwertenwollenden hamsterhaftigkeit grundsätzlich wundern.

ihr grösseres problem könnte die zunehmende komplexität werden, die sie in sich selbst durch die verwässerung der grenze zwischen öffentlich und privat einbauen, und die damit verbundenen unsicherheiten. einerseits ist es ein riesiger aufwand für das tool, verschiedene stufen der privatheit und öffentlichkeit gleichzeitig und/oder abgestuft zu ermöglichen (siehe buzz, umständlicher gehts nimmer). andererseits sind vermischte grenzen auch für die user anstrengend, weil man sich als kommunizierender über nichts mehr sicher sein kann (siehe facebook, was von mir taucht em ende plötzlich wo auf, ohne dass ich einen schimmer davon hab).

(mehr oder weniger alle gut funktionierenden kommunikationsformen im web sind entweder dediziert privat (email, im, icq, skype, das alte facebook, etc.) oder dediziert public (youtube, last.fm, flickr, blogs, twitter, usw.). für den benutzer gibt es keinen mentalen overhead, er weiss, was er zu erwarten hat, sowohl vom dienst als auch von den beziehungen.)

google und facebook kommen von den entgegengesetzten enden (google ist der könig des öffentlichen, facebook der des privaten), beide sind damit aber nicht zufrieden und haben begehrlichkeiten auf das reich des anderen (google will den social graph interpenetrieren, facebook will den vorhandenen social graph veröffentlichen), beide sind auf jeweils unterschiedliche art bereit, ihre stärken dafür zu opfern. beide bauen komplexitäten ein, die das eigene angebot mittelfristig unattraktiver machen.

(ich befürchte facebook hat im bereich öffentlich-sozialer rundfunk den besseren plan (im sinne von ist sich der konsequenzen besser bewusst und nimmt sie bewusster in kauf) und google hat diesbezüglich leider überhaupt keinen plan. leider, weil ein offenes web zumindest auf absehbare zeit wohl google braucht, um unter den neuen bedingungen (echtzeit, mobil, lokal, transsozial, etc.) zu sich zu finden)

((mir ist es ein echtes rätsel, warum google die gier hat, auch das soziale an sich koppeln zu wollen, und sich nicht darauf beschränkt, das vorhandene soziale zu fördern, zu sichten, zu vernetzen und zu organisieren. wenn man so will ist facebook die molare kraft, die zwar böse ist, aber bzgl. der eigenen funktionslogik alles richtig macht, und google ist auf dem besten weg, das eigene molekulare mojo zu verspielen und eine art molares mini-me von facebook zu werden))

Kurzschluss

(bin in letzter zeit über einige ‘social media müdigkeits, – erschöpfungs, – auf sich selbst bezogene wie viel ist es wirklich wert, etc.’ posts gestolpert worden, zumindest eines ist dabei interessant: es gibt ganz offensichtlich nicht wenige, bei denen es zu einem kurzschluss zwischen der emischen und der etischen wahrnehmung kommt. die leute subordinieren sich gwm. unter das social media blabla und bewerten ihre aktivitäten nicht mehr selbstbestimmt – nach dem spassfaktor, nach eigenen motiven warum sie twittern oder flickern, nach den sich für einen selbst und in der streukraft der peergroup ergebenden möglichkeitsräumen, etc. – sondern nehmen sich selbst als social media objects wahr und bewerten sich selbst mit den damit assoziierten metriken; für eine kulturelle ausdifferenzierung ist das natürlich eher ungünstig)

(abt. gleichzeitigkeit der ungleichzeitigkeiten)

Schwarmacher

(minianmerkung bzw. update zu schirrmacher usw., weil ich (wieder nur das ende) seiner keynote bei einer schwarmkonferenz gesehen habe:

das lustige an ihm ist, dass er selbst quasi ein glaubender der von ihm kritisierten ‘internetideologien/-en’ ist, nur die angedachten ergebnisse, visionen, utopien negativ und dystopisch bewertet. er selbst denkt technodeterministisch, nur verzweifelt seine humanistische seele an den entwürfen. auf alle fälle ist er weitaus abgespaceter, als man vermuten würde)

The Object Supposed To Know

schöner artikel von m. lindner zu sozialen objekten im kontext marketing.

(wobei er den begriff social objects nicht im semiotischen sinne (und also mit engeström) sondern im social media sinne (und also mit gapingvoid) interpretiert; es geht also primär um die effektivität von objecten im sozialen raum)

Im Wald

What I think both this and the whole ad blocking discussion come down to is a question of how different sites look at and treat their audiences. If they feel they need to take a short-term view and “monetize” every interaction with them, or if they realize that there’s a long-term value in building up a strong and loyal relationship. It’s also quite similar to the constant debates over the music industry — where the music industry feels that it wants to get paid pennies every time you hear a song. That’s the short-term “we have to monetize every use” view, compared to the longer term view, which recognizes that free songs and building up a relationship between the fans and the musicians can lead to something much more lucrative that benefits everyone.

unglaublich konzise zusammenfassung der ganzen minifeed- und monetarisierungs-geschichte bei techdirt.

(das einzige, woran er ein bissl blauäugig vorbeischaut, ist die erzwungene wahl vor der die verlage stehen und bei der was sie auch machen aus ihrer sicht tatsächlich falsch ist; anders als self-publishers, die bei null beginnen und für die jeder neue (interessierte) leser ein irre wertvolles weil extremst unwahrscheinliches ereignis (ein neues pfänzchen) ist, beginnen verlage im web mit gesättigter aufmerksamkeit, weil sie zunächst ihre offwebmarke erben (sie sitzen also im wald). für sie ist die aufmerksamkeit aller etwas gegebenes, die von ihm oben beschriebene funktionslogik ist für sie deshalb sinnlos. die strukturelle dummheit besteht natürlich darin, dass sie diese zunächst gegebene aufmerksamkeit nicht als asset verstehen, sondern als etwas bezüglich seiner melkbarkeit zu verwaltendes.)

The Feedhead

(anlässlich dieser basicthinking kürzt feed debatte (etwa, oder, oder) eine persönliche miniökonomie der feeds, wobei ich den ganzen komplex monetarisierung und die damit meistens verbundene moralisierung ausklammere, der ist auf mehreren ebenen unfruchtbar)

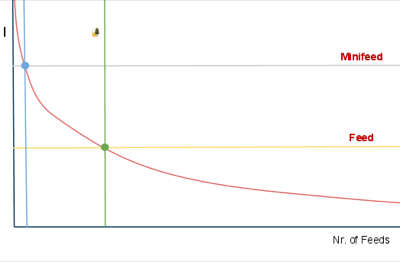

- die y-achse indiziert mein interesse an einer quelle

- die x-achse die anzahl an mit der jeweiligen interessantheit assoziierten quellen

- die rote l-kurve zeigt meine verteilung an

es gibt also nur sehr sehr wenige quellen, an denen ich sehr sehr grosses interesse habe, es gibt hunderte quellen, an denen ich eigentlich doch schon interessiert bin, und es gibt millionen quellen, die sicher auch gelegentlich irgendwas irgendwie interessantes beinhalten.

(welche quelle für einen interessant ist oder nicht ist übrigens nicht nur naturgemäss für jeden verschieden, das hängt auch davon ab, welche anderen quellen man kennt und liest. je mehr andere quellen man liest, desto mehr verschiebt sich das attribut interessant ins kompatibel komplementierende)

nun ist es so, dass es natürlich toll wäre, alles auch nur irgendwie interessante zu lesen, nur geht sich das zeitlich nicht aus. man muss also für sich selbst infoökonomische verfahren entwickeln, was man wie in sich reinlässt und was nicht.

je nach disposition gibt es eine ganze reihe möglicher verfahren. man kann zb. einzelne quellen und/oder redaktionell vorselektierende portale und/oder algorithmisch vorselektierende memetracker bookmarken und täglich ansteuern und alles andere ignorieren (oder mit anderen praktiken kombinieren). oder man kann (wichtige nachrichten finden mich blabla) in div. sozialen empfehlungsströmen treiben und alles aufsaugen und alles andere ignorieren (oder mit anderen praktiken kombinieren). oder man kann – und das ist die mit abstand bequemste und effizienteste methode, um viele heterogene inputströme zu konsumieren – sich sein eigenes bündel an quellen via RSS zusammenstellen und diese in einem feedreader lesen (und das mit anderen praktiken kombinieren).

(welche praktiken für einen passend sind oder nicht ist übrigens wiederum nicht nur naturgemäss für jeden verschieden, es ist auch völlig unwertend. allerdings trifft man idealerweise seine entscheidung, nachdem man sich etwas mit allen möglichkeiten herumgespielt hat)

aber wie gesagt: wer viele quellen effizient lesen möchte, der kommt um einen feedreader nicht herum. das ist nix für alle, es erfordert zeit, aber es hat auch einige von anderen methoden nicht emulierbare vorteile. vor allem bei echtem interesse an einem thema. auch die besten portale, thematisch fokusiertesten memetracker und smartesten aggregatoren tendieren zum hochspülen des kleinsten gemeinsamen nenners, die echten goodies findet man nur im feedreader.

doch zurück zum diagramm:

jedes der oben erwähnten (und aller anderer) verfahren verursacht neben dem sich ergebenden informationsnutzen auch rezeptionskosten (zeit, anzahl an klicks, anzahl an medienbrüchen, usw.). der wert einer quelle unterm strich ergibt sich also nicht alleine aus der interessantheit, sondern auch aus dem damit verbundenen aufwand. (man könnte die rote kurve also auch als indifferenzkurve lesen: je interessanter, desto mehr aufwand nehm ich in kauf, je weniger (aber natürlich immer noch) interessant, desto weniger.)

in meinem setup gibt es zwei grenzwerte:

- blauer punkt: quellen, die ich immer lese, egal ob fullfeed oder excerptfeed oder nofeed. rein theoretisch übrigens, in meinem feedreader hab ich glaub ich zwei excerptfeeds, alle anderen haben ohnehin fullfeeds.

- grüner punkt: quellen, die ich nur lese, wenn es sie im fullfeed gibt.

anders als noch vor zwei, drei jahren ist es mir als kleine randbemerkung mittlerweile übrigens völlig wurscht, ob wer einen fullfeed hat oder nicht; twitter und friendfeed und alle memetracker haben meine klickbereitschaft doch deutlich verändert und im dortigen kontext stört mich auch das herumklicken nicht. aber im feedreader empfinde ich excerptfeeds als extrem störend, weil sie den leseflow doch stark unterbrechen, und also subscribe ich sie nur seltenst. nicht weil ich mich als klickvieh verraten fühle etc., sondern einfach weil es für mich bessere alternativen gibt.

als publisher muss man sich über eines jedenfalls im klaren sein: das umstellen von fullfeeds auf excerptfeeds bringt vl. einige klicks, birgt aber auch mitunter signifikante opportunitätskosten. man verliert nicht nur leser (alle, bei denen man auf deren eigenen indifferenzkurve zwischen dem grünen und blauen punkt liegt), man verliert gerade die, denen das wichtig ist, weil sie mehr als nur eine quelle lesen und ihren output dann sharen und faven und streuen usw, man verliert die katalysatoren und damit alle von diesen getriggerten indirekten klicks. do the math, wobei das natürlich von der verteilung der dispositionen der leserschaft abhängt.

(im falle basicthinking (oder auch heise etc.) ist das, glaub ich, eher egal, weil die vorwiegend, glaub ich wiederum – das müsste mal jemand statistisch auswerten -, vor allem leute ansprechen, die wenige andere quellen kennen, die wenige feeds lesen, und für die basicthinking also ohnehin sehr interessant ist, also im blauen bereich liegt.)

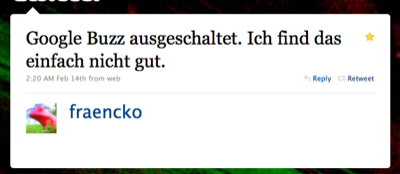

Tweet des Tages 9078059209

(irgendwie mag ich die unaufgeregte selbstbestimmtheit in diesem tweet, meistens wird diese erkenntnis bzw. entscheidung ja ironisch bzw. passiv aggressiv geframt)

((nur am rande: man ist nicht ‘hinten’, wenn man buzz nicht verwendet, und man ist schon gar nicht ‘vorne’, wenn man es verwendet, diese ganze notion einer progressiven zeitlichkeit ist im web völlig unsinnig))

Generation Why?

Über einen Mangel an massenmedial vermitteltem Diskurs über das Web kann man sich in letzter Zeit eigentlich nicht beklagen. Eigentlich auch nicht über die Qualität der aufgestellten Protagonisten (im sinne von: sie versuchen wohl wirklich, ‘experten’ für themen und standpunkte zu finden, so ein hau-drauf-journalismus (gaschke usw.), der davor eher die regel war, wird zumindest ergänzt; man denke an diese internetdenker serie in der faz, die besetzung von diskussionsrunden, etc. nicht alles superduper, aber man hat nicht mehr das gefühl, zumindest nicht mehr immer, dass sie absichtlich verblöden wollen).

Und trotzdem findet, kommt mir vor, kaum Vermittlung statt, und zwar jenseits des allgemein üblichen (und in jedem bereich gegebenen) Aneinandervorbeiredens.

Mit persönlich ist es zwar eher egal, was irgendwer über das Internet denkt, aber diese genuine Selbstvermittlungsunfähigkeit des Webs finde ich interessant. Woran liegt es, dass ein Ding, das (neben anderen eigenschaften) auf den verschiedensten Ebenen (persönlich, kollaborativ, wirtschaftlich, sozial, kulturell, you name it) ein enormes Potential für ganz trivialen egoistischen Nutzen hat, bezüglich dessen ‘Verständnis’ es also ein stinknormales Eigeninteresse geben sollte, mit so unfruchtbaren Begriffen und Beschreibungen abgebildet wird?

Diese Unfruchtbarkeit des Diskurses erstreckt sie ja nicht nur auf die Bereiche, in denen man das erwarten könnte – etwa shirkys ‘institutions will try to preserve the problem to which they are the solution’; wer für sich böses ahnt will nachvollziehbarerweise desinformation und regulierung -, sie erstreckt sich über alle Bereiche, auch die Web-nativen.

Something to think about.

PubSubHubbuzz

Buzz ist weder ein Facebook- noch ein Twitter-Killer. Wenn überhaupt von irgendwas ein Killer, dann von Yammer und Konsorten, wenn sie ihre Enterprise Version gestartet haben. Aber der ganze Vergleich hinkt. Leider kann man nicht in Google reinschauen, was sie sich bzgl. ihrer social strategy davon versprechen, aber ich vermute fast, dass ihre primäre Idee eher so in Richtung die Menschen lieben es ganz offensichtlich, im Web Zeug zu sharen, warum sollten sie das nicht bei uns tun? geht, und das dann auf ihre Art weiterdenken (siehe unten).

Was Google aber wie so oft nicht versteht, bzw. versteht, aber nicht besonders gut umsetzt, ist, dass das Sharen von Stuff kein abstraktes Bedürfnis ist, sondern in Dialektik mit der Dynamik eines Dienstes entsteht.

Bei Facebook und Twitter und allen anderen erfolgreichen Diensten ist diese Dynamik klar geregelt. Facebook ist Kommunikation unter Freunden, Twitter ist öffentliche Kommunikation unter Interessierten. Der eigene social graph auf Facebook hat sich, zumindest im Kern, in einer Vorzeit entwickelt (aka Freunde). Der eigene social graph auf Twitter entwickelt sich organisch und adjustiert sich permanent. Buzz macht aus den Versatzstücken social graph und sharing einen Eintopf und rührt ohne Fokus kräftig darin rum. Email-Kontakte z.b. sind weder (notwendigerweise) Freunde, noch Leute, die sich (notwendigerweise) für die eigenen Ergüsse interessieren, noch sind deren shared items (notwendigerweise) für einen interessant. Angezeigt wird, anderes Beispiel, nur, was Google nach Filterung durch eine black box als relevant erachtet. Vertraut uns, das können wir, wir haben das erfunden.

(wobei die versteckenden tabs recht schick sind)

Und es gibt natürlich noch eine Reihe von ans frühe FriendFeed erinnernde rookie mistakes, bei denen man aber davon ausgehen kann, dass sie in kommenden Iterationen ausgemerzt werden, das betonen sie auch selbst.

Und es gibt eine weitere Reihe von falschen (oder besser: kontingenten, aber in ihren konsequenzen nicht bedachten) konzeptionellen Grundannahmen der Google-Hirne, wie man sie bei so ziemlich jedem Google-Dings, das irgendwas mit social zu tun hat, kennt.

Davon abgesehen hat Buzz aber mehr Potential, als alles andere, was bisher von Google im Bereich social gekommen ist. Wenn man von Buzz, dem Produkt in der derzeitigen Form, abstrahiert, schlummert darunter Buzz, die Plattform, die doch eine Art universelle Pumpe für all things social werden könnte, weil Google damit zum ersten Mal zwei Dinge zusammenführt:

- ein Superset von offenen Standards, mit denen sich so ziemlich alles abbilden lässt, was an sozialen Inhalten produziert wird, inklusive Reaktionen und Beziehungen (Atom/RSS, MediaRSS, Activity Streams, Social Graph API, webfinger).

- und die Technologie, das alles und kostenlos an jeden interessierten Endpunkt in Echtzeit zu pumpen (PubSubHubbub, OAuth, AtomPub, Salmon).

Wenn man so will, ist Buzz, das Produkt, eine suboptimale Demoversion für Buzz, die Plattform, und anders als etwa bei Google Wave kann man davon ausgehen, dass es auf Basis der Plattform relativ zeitnah diverseste Services und Integrationen geben wird.

Das heisst nicht, dass damit alle Silos aufgebrochen werden, was wohl auch nicht wünschenswert wäre, Silos haben auch ihren Sinn. Aber auf Basis von Buzz könnte sich ein webweites soziales Nervensystem entwickeln, das dann angezapft und auf tatsächlich neuartige Weise reinterpretiert werden kann.

—

miniproductivity tipp am rande: wenn man zur alten version von gmail wechselt, dann gibts den ganzen buzz nicht. man muss also buzz nicht gleich ganz deaktivieren, wenn einem das phasenweise nicht in die inbox passt.

Das offene Web und seine Feinde

… iDiss revisited, ca. 200 meinungen später.

ein pattern dabei ist recht interessant: die protagonisten der offenheit und des hackens haben wenig vertrauen in die systemkraft der offenheit resp. die kreativkraft der menschen. viele sehen im ipad fast schon eine art endgame, bei dem offenheit und eigensinn kurz vor dem matt stehen, weil sie der grossartigkeit des ipads / dem schrecklichen weil lustvollen matmos / nichts entgegensetzen können.

The iPad is an attractive, thoughtfully designed, deeply cynical thing. It is a digital consumption machine.

alex payne zb macht aus dem ipad fast schon eine art bioadapter der gesellschaft.

(kreativität wird nicht angeregt, sondern unterdrückt; das ist umso schlimmer, weil die vorgeschlagene metapher zur verwendunge von computern u.u. bei vielen sogar besser ankommen könnte als das (sinnlose aber lehrreiche) herumtinkern; wer nur das ipad kennt, wird kein hacker; viele iphone user kennen ausser ihren apps nichts; apple unterstützt das auch noch, die werbung sagt ‘da gibts ne app für’, vom web sagt sie nichts; apple schert sich keinen deut um offenheit und kann oder will offenheit nicht mit usability und eleganz verknüpfen;die entscheidung dafür hat keine technische grundlage, sondern ist strategisch; der weg den uns das ipad weist ist also verführerisch und dystopisch; usw.)

Yet I am concerned that it will get a flow of great apps from people who are willing to compromise on their freedom and users’ freedom.

dave winer rundet die befürchtungen ab. es könnte zu einem brain drain kommen, bei dem entwickler ihre kreativität in eine plattform pumpen, die dann – etwa wegen patentrechten auf multitouch – noch nicht mal auf anderen plattformen emuliert werden kann.

leichter dahergesagt als getan aber trotzdem: wer an die offenheit glaubt, der muss auch an ihre konkurrenzfähigkeit in einem milieu glauben, in dem es auch geschlossene systeme gibt.

iDiss

yay, das iPad ist da, von hinten nach vorne nachzulesen etwa bei engadget.

(in meinem stream witzigerweise fast ausschliesslich herumgemotze, das deutsche äquivalent zum amerikanischen fanboy mit consumerblick ist der dissboy mit ingenieursblick, meh, das soll es sein, ein grösseres iphone, wer braucht denn das, und zugeschraubt ist es auch noch, …)

((ich verstehe die argumentationslinie closed platform, die angst vor einem quasimonopol der istores, nach music und apps jetzt auch noch bücher, usw., aber unterm strich ist es das geilste fenster ins internet und also mit allen damit verbunden möglichkeitsräumen yet, warum faseln wir denn alle seit vier jahren von der cloud, und auch preislich ist es mit $500 + monatlich $30 ohne vertragliche knebelung mehr als attraktiv; die fraktion open hätte mehr davon, apple als benchmark für die eigenen aktivitäten zu verwenden))

Short Cuts Pt. 5 (Early Adopter Edition)

Eine der traurigsten Tropen im Diskurs im und um das Web ist die des Early Adopters. Der Begriff Early Adopter bringt nichts, stört nur und verhindert die Entwicklung von Positionen.

Die Beschreibung von Personen als Early Adopter basiert auf der im Web sinnlosen Notion einer fortschrittlichen Zeitlichkeit. Die Entwicklungsgeschichte wird als linearer, zeitlicher, teleologischer Strahl konzipiert. Wer vor den anderen auf neue Entwicklungen aufspringt, gilt als schneller und besser. Das erworbene kulturelle Kapital ist allerdings kurzlebig, weil es keinen Stillstand geben darf. Es ist schnell wieder verspielt, wenn man nicht immer auf die nächste neue Entwicklung umsteigt.

Aber im Web gibt es keine Zeitlichkeit, weil alles für alle immer schon gleichzeitig ist. Jede neue Anwendung ist sofort für alle verfügbar, jeder neue Inhalt ist sofort für alle zugänglich. Das Web ist keine Serie von disparaten Linearitäten, sondern ein Gewebe, das alles in sich aufnimmt und synchron miteinander verbindet; eine Gleichzeitigkeit von Ungleichzeitigkeiten; ein Potential, dessen Möglichkeiten angezapft werden können, oder nicht. Das Web ist postkontemporär.

Ganz allgemein gesagt sind Webdienste Möglichkeitsräume. Möglichkeitsräume, die zwei Serien triggern können:

Eine Serie der individuellen Intensität, also dem Grad mit dem man den Dienst für sich selbst (aktiv oder passiv) nutzt und sein Leben dadurch besser, interessanter, spannender macht. (Auch wenn man etwas nicht benutzt, ist es gewissermassen doch als Umwelt da. Allerdings ist die persönliche Intensitätsstufe dann halt null.)

Und eine Serie der kollektiven Resonanz, also dem Grad mit dem der Dienst zum Schwingen gerät, Koppelungen und Rückkoppelungen mit anderen Diensten, Systemen, Feldern eingeht und dabei das Leben für die Freunde und die Welt besser, interessanter, spannender macht.

Für jeden Einzelnen geht es also, um zum Early Adopter zurückzukommen, weniger darum, ob man früher oder später damit beginnt, einen Dienst zu nutzen, sondern um die Intensität, mit der man ihn zu einem je gegebenem Zeitpunkt nutzt, und um die Resonanzkörper, die dadurch um ihn herum entstehen. Wenn man etwas nicht verwendet, weil man keinen persönlichen Anknüpfungspunkt darin sieht, dann ist man nicht hinten, sondern handelt rational. Wenn man auf jeden Zug aufspringt, der gerade losdüst, ohne sein Leben dadurch besser zu machen, ist man zwar Early Adopter, aber auch ein Dummkopf.

Das bedeutet jetzt nicht, dass es nicht sinnvoll ist, zu versuchen am Laufenden zu bleiben. Wer kein Sensorium für die ja stetig wachsenden Möglichkeiten entwickelt und kultiviert, wer nicht weiss, was es alles gibt, der hat natürlich die Opportunitätskosten der Nichtbenutzung.

Aber die fast schon penetrante Ungeduld der Neuheit und des jeweils Nächsten hilft dabei selten weiter. Und die Erzählfigur des Early Adopters ist besonders traurig, weil sie gleich zwei Positionen in ihrem Blickwinkel einschränkt:

Die Fremdzuschreibung spart sich durch die Diagnose ‘das ist halt was für Early Adopters’ die Auseinandersetzung mit den Phänomenen. Early Adopters wird gerne mit anderen Begriffen wie ‘selbsternannte Internetelite’ oder (nie konkret benannten) ‘Propheten’ oder ‘Vordenkern’ kombiniert, um eine künstliche Differenz zwischen ‘denen’ und dem ‘normalen wir’ zu konstruieren. Sollen die halt machen, mit ihren Zauberwörtern Blog und Wiki und Flickr und Twitter, wir sind normal und wir wissen, dass das alles ein Blödsinn ist.

Die Selbstzuschreibung ‘ich bin ein Early Adopter, weil ich tool yxr benutze’ ist allerdings fast noch blöder, weil mitunter ein Selbstbild und Gruppengefühl konstruiert wird, das auf nichts begründet ist, und weil ein Tunnelblick entwickelt wird, der blind für die Eigentlichkeiten ist. Es ist keine Leistung früher als andere einen Dienst zu verwenden. Wer ein, zwei Blogs liest und sich überall anmeldet ist der Earliest Adopter schlechthin und erzeugt dadurch alleine noch überhaupt keinen Wert, weder für sich, noch für andere. Was aber getrübt wird, ist der Blick auf das, was funktioniert und warum.

Wer sich selbst als Early Adopter konzipiert, tappt nur allzuleicht in die Falle, eine individuell wertvollere Verwendung von Webdiensten gegen eine wertlosere aber neue Verwendung einzutauschen.

Short Cuts Pt. 4 (Tod von RSS Edition)

In den letzten Wochen war mal wieder viel vom Tod von RSS zu hören. Ohne auf die jeweiligen Thesen im Detail einzugehen trotzdem ein paar Worte dazu, warum das ein blödsinniger hubbub ist.

Zunächst werden oft zwei Dinge vermischt: RSS als Format und RSS als kulturelle Technik des Abonnierens und Lesens von Feeds. Gemeint wird immer zweiteres, aber die Schlussfolgerungen werden manchmal vermischt. Egal, diese Unstimmigkeit erkennt man schnell und kann man abheften.

Was bleibt ist die Annahme, dass Feedlesen eine aussterbende Gattung ist, die von neueren, besseren, effizienteren, fortgeschritteneren Techniken abgelöst wurde. Und diese Annahme ist auf mehreren Ebenen problematisch. Das Äugen auf und die Bervorzugung von Charts (Wachstum hier, Verluste dort) anstelle der Wahrnehmung von Wert; die Notion eines ‘weiter ist besser’ bei blinder Zerstörung der Vorhandenen; der Begriff von Early Adopters, die die fortgeschrittensten Techniken reflektieren aber in Wirklichkeit dichtere Formen gegen dünnere eintauschen; die Annahme, dass was sich nicht als mainstreamtauglich für alle herausstellt nix wert ist; usw.

Das alles ist im Grunde egal, jeder soll machen was er will, und was andere tun tangiert einen persönlich wenig (anders als bei sozialen systemen, wo die koppelung viel stärker ist). Aber ganz stimmt das dann doch wieder nicht, weil man selbst natürlich auch nur irgendwie im Gesamtökosystem verankert ist, und auch wenn man seinen eigenen informationsökonomischen Haushalt selbst bestimmen kann, so schwimmt man eben im aggregierten Ergebnis der Aktionen aller anderen; und die Resonanzräume, die durch die Praktik des Rezipierens und Prozessierens von Feeds getriggert werden, sind interessanter, als die Resonanzräume, die durch verstümmelte Formen wie Beschränkung auf Twitter und Memetracker und Empfehlungssysteme mit anschliessendem Retweeten und Liken getriggert werden.

Nix gegen Memetracker und Twitter und Empfehlungssysteme, die sind super und haben ihren Wert und können einige Dinge viel besser, als das persönliche (zuerst einmal Finden und) Abonnieren und Lesen von Feeds.

Aber das (zuerst einmal Finden und) Abonnieren und Lesen von Feeds ist die potentiell dichteste, effizienteste und persönlich wertvollste Technik. Sie sollte das Herz der individuellen Anbindung an den Gesamtstrom sein.

Die wunderbarste Eigenschaft des Webs sind die kleinen Dinge und die Möglichkeit einer Ausdifferenzierung an den Rändern. Wie strange man auch immer selbst veranlagt ist, wie noch so unwahrscheinlich die eigenen Interessen, im Web gibt es für alles Anschlusskommunikation. Massenmedien müssen per definitionem immer Massen ansprechen, aber niemand ist Masse und also pendelt sich das was sie tun auf irgendeinem kleinsten gemeinsamen Nenner ein. Aber im Web gibt es immer einen, der sich auch mit dem Thema beschäftigt, der Dinge radikaler beschreiben kann, der ohne Rücksichtnahme auf Allgemeinverständlichkeit und also dichter denken kann und vielleicht für einen gerade richtig ist etc. Massenmedien müssen für alle gut genug sein, aber im Web dürfen Spezialisten für andere Spezialisten gut genug sein, und auch wenn das nur 10 Leute sind ist die Welt ein besserer Ort.

Blogs sind nun die ideale Form, um partikulare Expertise von anderen mit spezifischen Interessen zu mappen, und das Abonnieren und Lesen von Feeds ist die ideale Form, um die spezifischen eigenen Interessen zu beliefern. Blogs sind deshalb ideal, weil es drei Dinge besser als jede andere Form vereint: Geschmack, Urteilskraft und Komplementarität.

Geschmack

Über Geschmack kann und braucht man nicht zu streiten, aber es ist eine binäre Kategorie. Wird der eigene Geschmack getroffen, ist man happy, sonst muss man halt durch.

Urteilskraft

Bei der Urteilskraft ist es ein bissl wie bei dem Geschmack, die gefühlte Unterstellung einer Urteilskraft ist immer ein subjektives Gefühl, die vom eigenen Wissenstand abhängt. Anders als beim Geschmack muss das Vertrauen in die Urteilskraft des Anderen allerdings erst aufgebaut werden und wachsen. Auch anders als beim Geschmack kann man über die Urteilskraft schon streiten.

Komplementarität

Bei der Komplementarität geht es darum, zu welchem Grad das, was man selbst ohnehin weiß, ergänzt wird. Auch Dinge mit wunderbarem Geschmack und präzisester Urteilskraft sind völlig witzlos und wertlos, wenn man alles ohnehin schon kennt. (einer der grössten fehler der mehrzahl von systemen ist die annahme, dass sich möglichst gleiches mit gleichem mischen soll)

Short Cuts Pt. 3 (User Edition)

Im Grunde funktioniert das Web sehr einfach. Das Web ist wahrscheinlich der grösste Möglichkeitsraum, den die Menschheit je hervorgebracht hat. Nicht weil die zugrundeliegende Denkleistung so phänomenal ist, sondern weil es eine Infrastruktur definiert, die sämtliche Medien subsummiert und in sich aufnimmt, und vor allem: weil es unsere Möglichkeiten der Kommunikation potenziert.

Das Web macht also ein Angebot, genauer: das Web ist die Summe aller Einzelangebote in Form von Anwendungen und deren Zusammenspiel.

Um ein beliebiges Angebot wahrzunehmen müssen 3 Voraussetzungen erfüllt sein:

- man muss das Angebot kennen.

- man muss das Angebot verstehen.

- man kennt kein ‘besseres’ Bündel das mehr Nutzen bringt.

Unter dem Strich: es geht darum, dass wir durch die Benutzung eines Dienstes besser dastehen, als ohne.

Man kann – wenn man will – Webanwendungen in zwei Kategorien unterteilen:

- Anwendungen, deren Sinn sich selbst erklärt.

- Anwendungen, deren Sinn sich erst durch Nachdenken / Nachahmen / Anwendung etc. erschliesst.

Ich will niemandem zu nahe treten, aber es sprechen einige Symptome dafür, dass die meisten Menschen sehr gut darin sind, Anwendungen die sich selbst erklären für sich nutzbar zu machen, wenn sie ihnen Nutzen bringen (i.e. die meisten schauen mal schnell was in der Wikipedia nach, oder gehen auf ebay auf Schnäppchenjagd, oder bestellen sich Bücher bei Amazon, oder bestellen Zugtickets, oder schauen Videos auf YouTube, usw usf.)

Doch schon deutlich weniger erkennen das Potential von Anwendungen, deren Sinn und Nutzen sich nicht sofort erschliesst und aufdrängt. Man darf glaub ich 2 Fehler nicht machen: glauben, dass man alles verwenden muss. Oder glauben, dass man nichts versäumt. Man darf auch nicht glauben, dass nur Wert hat, was für alle wertvoll ist. Die Schönheit im Web ist das Potential der Ausdifferenzierung, dass sich jeder das Bündel an Anwendungen zusammenstellen kann, das mit den eigenen Interessen am meisten kompatibel ist, dass jeder genau soviel Zeit investieren kann, wie er will.

Dass sich Leute, die beruflich mit dem Web zu tun haben, ein anderes Produktportfolio zusammenstellen und mehr Zeit investieren ist klar, sollte aber nicht darüber hinwegtäuschen, dass es trotzdem Opportunitätskosten gibt, Tools nicht zu kennen und zu verstehen.

Ich stelle mir seit langem die Frage: woher kommt der Widerstand sich 30 Minuten hinzusetzen und zu versuchen RSS zu verstehen, wenn das die eigene Produktivität was den Konsum von Nachrichten betrifft, um den Faktor 5 bis 10 erhöht? Mehr als 30 Minuten dauert es nicht, dennoch halten sich die Adaptionsraten in Grenzen.

Wenn man die Voraussetzungen oben als Matrix verwendet: viele kennen es nicht, und vielen, die irgendwie darüber gestolpert sind, erschlisst sich der Sinn nicht. Es geht nicht darum, ob RSS jetzt ein Hype ist oder nicht und was irgendwer über RSS sagt oder nicht sagt, es geht darum, dass RSS einen enormen Wertvorschlag macht, den man annehmen kann, oder nicht. Und nur wer RSS kennt kann eine informierte Entscheidung darüber treffen, in welchem Umfang er RSS einsetzt oder nicht. Wer dann lieber den Guardian genüsslich in seinem Lieblingscafe liest, der macht alles richtig. Aber wer aufgrund einer Ignoranz die Möglichkeiten erst gar nicht kennt, der bleibt halt auf seinen Opportunitätskosten sitzen. Macht natürlich auch nichts, aber trotzdem ist es schade drum.

Nun sind alleine in den letzten 3 Jahren mindestens 20.000 Services gestartet (keine Hausnummer) und es wäre mehr als ein Fulltimejob, jeden dieser Dienste auf den individuellen Nutzen hin zu überprüfen. Es gibt also auch Informationsbeschaffungskosten. Wenn es mehr Aufwand macht einen Dienst zu finden als er dann nutzen bringt, dann ist es nicht sinnvoll diesen Aufwand einzugehen. Zum Glück hat das Web Mechanismen etabliert, die einem die meiste Arbeit abnehmen. Die Antwort heisst nicht Massenmedien wie TV, Spiegel oder Heise, sondern Blogs. Einige Tausend Blogger haben es sich zur Aufgabe gemacht wie Eichhörnchen auf die Suche nach dem nächsten grossen Ding zu gehen, sie testen aus, filtern, bewerten usw. Blogs, die sich dabei als besonders gut erweisen bekommen grössere Leserschaften und fungieren als Verstärker. Das heisst nicht, dass sie alles finden oder dass sie das beste toll bewerten, aber im grossen und ganzen funktioniert das nicht schlecht.