Stream Studies

Sharegorischer Imperativ

Der sharegorische Imperativ (im Folgenden kurz SI) lautet in seiner Grundform:

Share so, dass die Maxime deines Sharens Grundlage einer allgemeinen Strombildung werden kann.

Wenn man nun davon ausgeht, dass jeder tun können soll, wo und wie er will, und also niemand beim Senden oder Empfangen von Strömen zur Verwendung eines bestimmten Dienstes genötigt werden darf, dann stellt der SI nur eine einzige Anforderung an den Strömenden:

der jeweilige Strom muss (alternativ) auch als Feed zur Verfügung gestellt werden.

Gibt es (auch) einen Feed, dann werden alle anderen Kontingenzen hinfällig.

(die verantwortung dafür würde ich fast beim strömer sehen und nur sekundär beim verwendeten dienst. dieser unterstützt das im idealfall out of the box (natürlich blogs aber zb. auch app.net), oder er ermöglicht es zumindest via einer api (zb. twitter), oder er versucht es andererseits möglichst zu verhindern (zb. google+), die verwendung bleibt aber in jedem fall eine freie entscheidung des strömers, der deshalb also einen feed für den strom mit workarounds (die es immer gibt) generieren sollte.)

299,999

(was wir eig. bräuchten, wär eine art infonationalprodukt, das eine halbwegs verbindliche kennzahl für das infoökoomische leistungsvermögen einer gesellschaft darstellt, wobei das natürlich anders als etwa das bruttoinlandsprodukt den fokus nicht auf die produktion von gütern (was weiss ich, summe aller blogposts, tweets, kommentare, bookmarks, videos, etctrara) legen dürfte, sondern auch die distribution (eben subscriptions, aber auch shares, likes und alles andere geströme) und vor allem auch die rezeption legen müsste, also die aggregierte gesamtheit der erzeugten lust, des übertragenen wissens, der dialektisch upgemashten und rekombinierten ideen und lolcats, etctrara)

((abt. the man of the crowd))

(((subabt. the quantenfied self)))

Postinventory

kleiner Nachtrag zu Inventory Requirements Specification : das Inventarisieren der Daten war dann weniger Aufwand als vermutet, da hat die Nullpunktserie (siehe) dann doch noch nachgewirkt; wie beim Zeugs wird zwar die drinsteckende Arbeit teilweise erst beim Hineinzommen sichtbar, aber wie beim Clutter erhöht sich die Qualität der Projekte (lernprojekte, leseprojekte, hörprojekte, schauprojekte, vervollständigungsprojekte, tagisierungsprojekte, data improvement projekte, programmierprojekte, usw.) spürbar und auch hier ist dieses Gefühl ok, das ist es doch angenehm.

(ein wahnsinn war diese selbstfragmentierung und -auflösung auf webdiensten; ich hab mich über die jahre bei mehr als 2000 seiten angemeldet und zumindest 200 dann auch zumindest eine zeit lang mit zumindest ein bisschen regelmässigkeit befüllt, und ich liebe sie wirklich alle, aber irgendwie muss ich da wirklich mal nen schlussstrich ziehen. das bedeutet nicht die abstinenz, aber das ziehen einer deutlichen grenze zwischen diensten die ich in die persönliche narration einbaue [workflow tbd] und dem explorativen rest)

Man könnte natürlich eine ganze Palette von wichtigen Differenzen zum Handling von Daten einführen (ist es für die persönliche narration relevant oder nicht; steckt ein actionable item drin oder nicht; hat es referenzwert oder nicht; ist es sozial oder nicht; etc.), mit zweien deckt man aber schon viel ab:

- ist es privat oder nicht

- muss es archiviert werden oder nicht

Beide kann man für ein- und ausgehende Daten durchdenken, und man erspart sich schon mal viel (Nachdenken oder Aufwand), wenn es nicht privat ist oder wenn es nicht archiviert werden muss – also Verbrauchskommunikation ist, oder weil es öffentlich ist ohnehin jederzeit nachgeladen werden kann, etc. (für alle, die facebook benutzen, ist es genau andersrum, dann erspart man sich das nachdenken, wenn es privat ist).

(insgesamt ist bei allem, was mit daten und infoströmen zu tun hat, das ziehen von grenzen viel wichtiger als eine etwaige reduktion oder minimalismus; wenn konzeptionell klar ist, was was wo und wie ist (was ja nur ein technisches subset von gtd ist), dann ist schon das meiste gewonnen.)

The Shower of Data

This is what always happens when something goes from scarce to surplus. First we bathe in it, then we waste it.

The subjot supposed to know

![]()

Subjot – die konsequenteste Granularisierung vom Microstreaming, seit es Twitter gibt (oder so). Die Idee ist super: Man kann seinen Output in beliebig definierbare Subjects kanalisieren und als geneigter Leser beliebige Subjects anderer abonnieren.

Ganz nett auch: Natürlich gibt es Themenseiten für einzelne Subjects (etwa), aber man kann die Subjects auch kombinieren (etwa).

(wird es gross werden? eher nicht, dafür sind die opportunitätskosten zu hoch, seinen senf kann man wesentlich effektiver auf twitter abgeben usw. was mittelfristig sicher auch ein problem würde, ist das management der subjects. es gibt aber durchaus szenarien für gangs und kleinere horden, wo es seinen platz finden könnte)

update: ist nicht mehr, war aber nett

Die Zuvielisation

Peter Glaser über den digitalen Medienfluss.44456097054072832

das frustrierende am xx-zero ist die inhärente instabilitätIn and out

That’s one of the most important decisions you’ll make today.

Event Horizon

Infinity takes the form of too much stuff. The web seems to have so much stuff, that finding your stuff amongst all the stuff is becoming a problem. The dilution of the web with stuff that’s not your stuff decreases the web’s value. Any random sample of the web will likely contain less and less of your stuff.

…

When considering human scales, the farthest point we can apprehend is the horizon. The line that separates earth from sky provides a limit within which a sense of human finitude is defined. […] Once the curvature of a spherical earth entered our thinking, we understood there was something — more earth — beyond the horizon.

echovar über den übergang von endlicher zu unendlicher information usw.

Google Mini-Me

gerüchte um ein kommendes ‘google me’ kursieren ja schon eine weile, was ich mir wünschen würde, pretty please:

google sollte sich auf das konzentrieren, was sie ursprünglich wollten und auch wirklich gut können – “die auf der Welt vorhandenen Informationen zu organisieren und allgemein zugänglich und nutzbar zu machen” – und nicht versuchen, selbst ein player im social zu werden. ersteres ist im bereich social web noch nicht gelöst und schreit fast nach einer lösung, zweiteres ist gelöst und sie haben dafür einfach kein händchen, wie sie immer wieder demonstrieren.

wenn man ihr mission statement auf das soziale web überträgt, dann wäre die aufgabe für google – ‘die auf der welt von menschen auf sozialen plattformen erzeugten informationen zu organisieren und allen daran interessierten zugänglich und damit interagierbar zu machen’.

mit fünf kleinen komponenten könnte ein google me diesen anspruch leicht und mit bestehenden mitteln, protokollen, apis und gegebenheiten erfüllen und sich selbst in eine soziale metawollmilchsau verwandeln:

- social search

- social reader

- social writer

- social contacts

- profile

social search

die social search sucht und findet: (1) alles, was ich selbst auf den verschiedensten diensten gepostet habe, auch im privaten also nicht für alle sichtbaren. (2) alles, was meine freunde auf den verschiedensten diensten geposten haben, auch im privaten, wenn ich es auf dem jeweiligen dienst sehen dürfte. (3) alles, was alle anderen auf den verschiedensten diensten geposten haben, wenn es public ist.

mit buzz sind sie teilweise schon dort, friendfeed ist es schon fast ganz, auch mit den sinnvollen such-operatoren, nur suchen buzz und ff derzeit halt nur im von auf buzz resp. friendfeed publizierten anteil, google me müsste nur noch in die tiefen der tools hineingehen (wie es etwa greplin tut). und sie sollten zumindest nicht ausschliesslich auf den googleschen relevanz-saft setzen (wie bei buzz), sondern ergebnisse auch chronologisch anzeigen. eine google-gute suche im gesamten selbstoutput wär jedenfalls auch die beste motivation, leute zum anmelden und verknüpfen von services zu bewegen.

social reader

der social reader ist ein reader für alles soziale: (1) als reader für alles, was meine freunde auf den verschiedensten diensten geposten haben, auch im privaten, wenn ich es auf dem jeweiligen dienst sehen dürfte, auch wenn sie nicht bei google me angemeldet sind (think brizzly nicht nur für facebook und twitter sondern jeden beliebigen dienst). (2) als reader für alles, was alle anderen auf den verschiedensten diensten geposten haben, wenn es public ist.

unterm strich also wie der google reader, nur dass man damit alle existierenden sozialen outputs konsumieren und darauf reagieren kann. der reader sollte vollständig und nahtlos mit den anderen diensten integriert sein, reaktionen auf die beiträge anderer sollten nativ auf dem jeweiligen dienst erfolgen (ein like auf irgendwas auf facebook sollte ein facebook like sein, eine antwort auf einen tweet ein tweet mit gesetztem in_reply_too, ein kommentar auf einen blogeintrag sollte dort als echter kommentar erscheinen, ggf. mit assoziierung des eigenen disqus handles, etc.) google sollte aber keine weitere ebene der privacy einführen, könnte aber die google contacts in den mix werfen und dort dann mit irgendwelchen gruppen differenzieren, und sollte die auf den jeweiligen diensten gewählten settings respektieren und auch ströme von leuten integrieren, die nicht auf google me sind.

der knackpunkt aber auch das potential beim social reader sind die filter und views. im grunde reicht es aber schon aus, wenn man sich beliebig viele views selbst erstellen könnte. eine view ist der output einer liste von usern mit beliebig vielen include und exclude filtern (etwa: aus der liste meiner kontaktgruppe webmonkeys (skopus der user) zeige mir alle status updates von twitter, laconica und buzz (include filter), verstecke aber alle, die dort jeweils nur syndiziert wurden (also via twitterfeed, foursquare, …; exclude filter)).

die filter könnten durchaus dumm sein, durch die verknüpfung ließen sich aber supernützliche konstrukte bauen (unix prinzip der pipes).

social writer

mit dem social writer kann man von google me aus auf allen anderen diensten publizieren. bonuspunkte, wenn man selbst dafür regelwerke definieren könnte (wie etwa bei tarpipe). der writer ist eig. nur eine standalone ergänzung zu den reaktionsmöglichkeiten vom reader, man müsste dann aber google me nie mehr verlassen, wenn man nicht will.

der vorteil eines writers wäre auch, dass alle anwendungen mit einem schlag inputdevice-agnostisch würden, solange google me das gerät unterstützt (web, email, android, sms, …). think posterous ohne die posterous-einträge.

social contacts

das ist ein bisschen trickreich, man könnte hier auch sehr coole g’schichten machen, aber wichtig würde ich finden, dass google hier zwar den existierenden social graph (also die summe alle existierenden partialgraphen auf twitter, facebook, gmail contacts, etc.) aufsaugt und ggf. aufwertet, es aber bei en bestehenden beziehungen auf den jeweiligen diensten belässt und selbst keine zusätzliche komplexitäten einführt, ausser vl. listen.

in der minimalversion ist es ein sich selbst aktualisierendes adressbuch, das sich automagisch aus den bestehenden beziehungen befüllt, egal ob wer auf google me ist oder nicht. think friendfeed mit den virtual contacts.

profile

ums profil kommt man wohl nicht herum, hier kann man selbst jene dienste hinzufügen und verwalten, die man claimen möchte (auch mehrere twitter accounts, etc.). alle anderen sehen die kerndaten, die assoziierten dienste und einen lifestream mit den letzten outputs, für die sie sichtbarkeitsberechtigung haben (freunde bei facebook sehen meine facebook updates, die anderen nicht, usw.). man kennt das prinzip von den lifestream-aggregatoren und auch von google profiles, zu ergänzen wäre diese aber um eine vollständige und nahtlose integration mit autorisierungspflichtigen diensten (im grunde ein etwas aufgemotztes friendfeed). auch ums folgen/verfolgt werden kommt man wohl nicht herum, eigentlich sollten sie aber die finger davon lassen und das nur auf reader-basis verwenden.

—

(hmm, friendfeed habe ich ja mehrmals erwähnt, friendfeed hat wirklich einen schönen sprung – zumindest auf der social-reader seite und bzgl. der filter – vorgelegt. friendfeed hat aber (neben dem verkauf an facebook) einen grossen fehler gemacht: sie haben den reader selbst an einen eigenen social graph gekoppelt und in der folge einerseits weniger den nutzen als reader vom sozialen der freunde sondern als distributionsplattform für das eigene soziale (inkl. dem anhäufen von followern, cross postings auf gruppen, etc.) promotet, andererseits die gesamten ströme auf sich gwm. reterritorialisiert und die diskussion damit vom ursprünglichen auslöser dissoziiert (man muss an die ebene des limbo bei inception denken: plötzlich befindet man sich in einem kommentarstrang, weil ein kontakt bei einem friendfeed kommentar-thread mitdiskutiert, der selbst nur der like des retweets eines tweets über einen artikel auf digg ist, usw.). diese vertikale vernestelung hat natürlich auch was an sich und auch die dissoziation ist an sich nicht tragisch, aber es ist vielen nicht sehr leicht gefallen, für sich einen i/o-modus zu finden.)

anyway, in einem satz sollte google me ein dashboard für das social web sein, ein meta-read/writer für alles soziale. google hätte damit zwar nichts eigenes, würde aber das gesamte soziale weitestgehend durchdringen (alles was öffentlich ist und zusätzlich alles private, was mit dem eigenen account verbunden wurde), hätte damit also eigentlich ohnehin alles.

und das alles ließe sich, wie gesagt, mit existierenden standards und technologien realisieren (inputs via apis, pubsubhubbub oder als fallback rss, autorisierung via oauth, etwaigen anderen mechanismen oder un/pw, posts via api, likes, comments via api oder salmon, etc.).

Follownomics

nach twitter bekommt jetzt auch buzz verfolgungsempfehlungen.

bei beiden ist offensichtlich warum (erhöhung der netzwerkdichte etc.), aber beide lösen damit nicht das eigentliche problem, nämlich einen effizienten verfolgungsmarkt zu ermöglichen. das paradox der ansätze ist, dass die effizienz umso mehr abnimmt, je besser die empfehlungsalgorithmen werden.

wer rational infoökonomisch folgt, der wird so lange neuen leuten folgen, solange deren nutzen (gute links oder gedanken etc.) grösser als deren kosten (zeit, die man mit dem durchklicken oder lesen oder überlesen verbringt) ist.

empfehlungsalgorithmen haben nun zwei offensichtliche möglichkeiten: sie empfehlen entweder auf basis des social graphs (viele deiner freunde folgen auch xy, die populärsten von deinen freunden verfolgten sind yz, etc.) oder auf basis von einem vermeintlichen interesse (dich interessieren ja lolcats, beliebte lolcats buzzer sind xyz).

folgt man aber allen, denen auch die freunde folgen, dann folgen irgendwann alle den gleichen in verfolgungsclustern und das system verliert die filter- und aggregierungsleistung auf kosten des mehraufwands für alle – ich muss aber eben gerade nicht allen folgen, weil andere ihnen folgen und für mich die rosinen retweeten o.ä.; und folgt man leuten mit gleichen interessen, dann nimmt die redundanz der geposteten infos zunehmend zu – auf sozialer ebene ist die dysfunktionalität ja quasi eingebaut: je mehr man sich für ein thema interessiert, desto weniger interessant werden alle anderen, die sich für das gleiche interessieren.

informativer sind nach dem in jedem fall nützlichen grundrauschen also eher die, die komplementäre und kompatible interessen haben, die also einen bereich abdecken, für den man sich peripher interessiert. und genau die kann ein empfehlungssystem nicht vorschlagen, die muss man für sich selbst entdecken.

das ist natürlich alles sehr simplifiziert dargestellt, auch redundanz ist informativ (beobachtung welche themen aufgegriffen werden, wie sie aufgegriffen werden, usw.) und infoökonomische effizienz ist auf twitter oder buzz auch nicht unbedingt das anzustrebende ziel, etc., aber der effekt von gepushten aber ineffizienten empfehlungssystemen mit dem hauptziel verbindungen zu vermehren ist eine inflation der beziehungen.

Aggregation, syndication and the delicacies of smart knowledge worker workflows

Show me yours I'll show you mine Infoflowchart von Martin Koser.Schwimmen, nicht filtern. Peter Kruse im Interview

Nicht uninteressantes Interview.The Feedhead

(anlässlich dieser basicthinking kürzt feed debatte (etwa, oder, oder) eine persönliche miniökonomie der feeds, wobei ich den ganzen komplex monetarisierung und die damit meistens verbundene moralisierung ausklammere, der ist auf mehreren ebenen unfruchtbar)

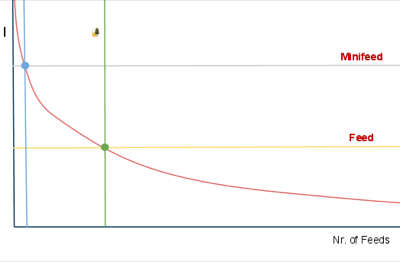

- die y-achse indiziert mein interesse an einer quelle

- die x-achse die anzahl an mit der jeweiligen interessantheit assoziierten quellen

- die rote l-kurve zeigt meine verteilung an

es gibt also nur sehr sehr wenige quellen, an denen ich sehr sehr grosses interesse habe, es gibt hunderte quellen, an denen ich eigentlich doch schon interessiert bin, und es gibt millionen quellen, die sicher auch gelegentlich irgendwas irgendwie interessantes beinhalten.

(welche quelle für einen interessant ist oder nicht ist übrigens nicht nur naturgemäss für jeden verschieden, das hängt auch davon ab, welche anderen quellen man kennt und liest. je mehr andere quellen man liest, desto mehr verschiebt sich das attribut interessant ins kompatibel komplementierende)

nun ist es so, dass es natürlich toll wäre, alles auch nur irgendwie interessante zu lesen, nur geht sich das zeitlich nicht aus. man muss also für sich selbst infoökonomische verfahren entwickeln, was man wie in sich reinlässt und was nicht.

je nach disposition gibt es eine ganze reihe möglicher verfahren. man kann zb. einzelne quellen und/oder redaktionell vorselektierende portale und/oder algorithmisch vorselektierende memetracker bookmarken und täglich ansteuern und alles andere ignorieren (oder mit anderen praktiken kombinieren). oder man kann (wichtige nachrichten finden mich blabla) in div. sozialen empfehlungsströmen treiben und alles aufsaugen und alles andere ignorieren (oder mit anderen praktiken kombinieren). oder man kann – und das ist die mit abstand bequemste und effizienteste methode, um viele heterogene inputströme zu konsumieren – sich sein eigenes bündel an quellen via RSS zusammenstellen und diese in einem feedreader lesen (und das mit anderen praktiken kombinieren).

(welche praktiken für einen passend sind oder nicht ist übrigens wiederum nicht nur naturgemäss für jeden verschieden, es ist auch völlig unwertend. allerdings trifft man idealerweise seine entscheidung, nachdem man sich etwas mit allen möglichkeiten herumgespielt hat)

aber wie gesagt: wer viele quellen effizient lesen möchte, der kommt um einen feedreader nicht herum. das ist nix für alle, es erfordert zeit, aber es hat auch einige von anderen methoden nicht emulierbare vorteile. vor allem bei echtem interesse an einem thema. auch die besten portale, thematisch fokusiertesten memetracker und smartesten aggregatoren tendieren zum hochspülen des kleinsten gemeinsamen nenners, die echten goodies findet man nur im feedreader.

doch zurück zum diagramm:

jedes der oben erwähnten (und aller anderer) verfahren verursacht neben dem sich ergebenden informationsnutzen auch rezeptionskosten (zeit, anzahl an klicks, anzahl an medienbrüchen, usw.). der wert einer quelle unterm strich ergibt sich also nicht alleine aus der interessantheit, sondern auch aus dem damit verbundenen aufwand. (man könnte die rote kurve also auch als indifferenzkurve lesen: je interessanter, desto mehr aufwand nehm ich in kauf, je weniger (aber natürlich immer noch) interessant, desto weniger.)

in meinem setup gibt es zwei grenzwerte:

- blauer punkt: quellen, die ich immer lese, egal ob fullfeed oder excerptfeed oder nofeed. rein theoretisch übrigens, in meinem feedreader hab ich glaub ich zwei excerptfeeds, alle anderen haben ohnehin fullfeeds.

- grüner punkt: quellen, die ich nur lese, wenn es sie im fullfeed gibt.

anders als noch vor zwei, drei jahren ist es mir als kleine randbemerkung mittlerweile übrigens völlig wurscht, ob wer einen fullfeed hat oder nicht; twitter und friendfeed und alle memetracker haben meine klickbereitschaft doch deutlich verändert und im dortigen kontext stört mich auch das herumklicken nicht. aber im feedreader empfinde ich excerptfeeds als extrem störend, weil sie den leseflow doch stark unterbrechen, und also subscribe ich sie nur seltenst. nicht weil ich mich als klickvieh verraten fühle etc., sondern einfach weil es für mich bessere alternativen gibt.

als publisher muss man sich über eines jedenfalls im klaren sein: das umstellen von fullfeeds auf excerptfeeds bringt vl. einige klicks, birgt aber auch mitunter signifikante opportunitätskosten. man verliert nicht nur leser (alle, bei denen man auf deren eigenen indifferenzkurve zwischen dem grünen und blauen punkt liegt), man verliert gerade die, denen das wichtig ist, weil sie mehr als nur eine quelle lesen und ihren output dann sharen und faven und streuen usw, man verliert die katalysatoren und damit alle von diesen getriggerten indirekten klicks. do the math, wobei das natürlich von der verteilung der dispositionen der leserschaft abhängt.

(im falle basicthinking (oder auch heise etc.) ist das, glaub ich, eher egal, weil die vorwiegend, glaub ich wiederum – das müsste mal jemand statistisch auswerten -, vor allem leute ansprechen, die wenige andere quellen kennen, die wenige feeds lesen, und für die basicthinking also ohnehin sehr interessant ist, also im blauen bereich liegt.)

DRYF

Unlink Your Feeds – eine Art Manifest der Entkoppelung von Feeds und Streams (schadet den freunden, schadet einem selbst, schadet dem web, drafte und crafte) mit begleitendem tumblr

(weekend mini project: das einmal für sich selbst durchdenken)

(extra points für eine umfassende typologie der dienste und usergruppen; die ist wohl gar nicht so einfach, weil es so einige faktoren und parameter und dispositionen gibt, und weil es natürlich nirgends ein richtiges oder falsches verhalten gibt (die wenigsten (sozialen) dienste erfinden sich selbst, werden vielmehr durch die mitunter verschiedenarten benutzungen erfunden), sondern nur ökosystemische mischungen die sich auf dem jeweiligen milieu eines dienstes ausdifferenzieren, innerhalb derer ein jeweiliges verhalten funktioniert oder nicht, (rezeptions-) kosten und (informations-) nutzen verursachen oder nicht usw. usf.)

PubSubHubbuzz

Buzz ist weder ein Facebook- noch ein Twitter-Killer. Wenn überhaupt von irgendwas ein Killer, dann von Yammer und Konsorten, wenn sie ihre Enterprise Version gestartet haben. Aber der ganze Vergleich hinkt. Leider kann man nicht in Google reinschauen, was sie sich bzgl. ihrer social strategy davon versprechen, aber ich vermute fast, dass ihre primäre Idee eher so in Richtung die Menschen lieben es ganz offensichtlich, im Web Zeug zu sharen, warum sollten sie das nicht bei uns tun? geht, und das dann auf ihre Art weiterdenken (siehe unten).

Was Google aber wie so oft nicht versteht, bzw. versteht, aber nicht besonders gut umsetzt, ist, dass das Sharen von Stuff kein abstraktes Bedürfnis ist, sondern in Dialektik mit der Dynamik eines Dienstes entsteht.

Bei Facebook und Twitter und allen anderen erfolgreichen Diensten ist diese Dynamik klar geregelt. Facebook ist Kommunikation unter Freunden, Twitter ist öffentliche Kommunikation unter Interessierten. Der eigene social graph auf Facebook hat sich, zumindest im Kern, in einer Vorzeit entwickelt (aka Freunde). Der eigene social graph auf Twitter entwickelt sich organisch und adjustiert sich permanent. Buzz macht aus den Versatzstücken social graph und sharing einen Eintopf und rührt ohne Fokus kräftig darin rum. Email-Kontakte z.b. sind weder (notwendigerweise) Freunde, noch Leute, die sich (notwendigerweise) für die eigenen Ergüsse interessieren, noch sind deren shared items (notwendigerweise) für einen interessant. Angezeigt wird, anderes Beispiel, nur, was Google nach Filterung durch eine black box als relevant erachtet. Vertraut uns, das können wir, wir haben das erfunden.

(wobei die versteckenden tabs recht schick sind)

Und es gibt natürlich noch eine Reihe von ans frühe FriendFeed erinnernde rookie mistakes, bei denen man aber davon ausgehen kann, dass sie in kommenden Iterationen ausgemerzt werden, das betonen sie auch selbst.

Und es gibt eine weitere Reihe von falschen (oder besser: kontingenten, aber in ihren konsequenzen nicht bedachten) konzeptionellen Grundannahmen der Google-Hirne, wie man sie bei so ziemlich jedem Google-Dings, das irgendwas mit social zu tun hat, kennt.

Davon abgesehen hat Buzz aber mehr Potential, als alles andere, was bisher von Google im Bereich social gekommen ist. Wenn man von Buzz, dem Produkt in der derzeitigen Form, abstrahiert, schlummert darunter Buzz, die Plattform, die doch eine Art universelle Pumpe für all things social werden könnte, weil Google damit zum ersten Mal zwei Dinge zusammenführt:

- ein Superset von offenen Standards, mit denen sich so ziemlich alles abbilden lässt, was an sozialen Inhalten produziert wird, inklusive Reaktionen und Beziehungen (Atom/RSS, MediaRSS, Activity Streams, Social Graph API, webfinger).

- und die Technologie, das alles und kostenlos an jeden interessierten Endpunkt in Echtzeit zu pumpen (PubSubHubbub, OAuth, AtomPub, Salmon).

Wenn man so will, ist Buzz, das Produkt, eine suboptimale Demoversion für Buzz, die Plattform, und anders als etwa bei Google Wave kann man davon ausgehen, dass es auf Basis der Plattform relativ zeitnah diverseste Services und Integrationen geben wird.

Das heisst nicht, dass damit alle Silos aufgebrochen werden, was wohl auch nicht wünschenswert wäre, Silos haben auch ihren Sinn. Aber auf Basis von Buzz könnte sich ein webweites soziales Nervensystem entwickeln, das dann angezapft und auf tatsächlich neuartige Weise reinterpretiert werden kann.

—

miniproductivity tipp am rande: wenn man zur alten version von gmail wechselt, dann gibts den ganzen buzz nicht. man muss also buzz nicht gleich ganz deaktivieren, wenn einem das phasenweise nicht in die inbox passt.

the springs

präzisierende nachfrage: abgesehen von “warum gerade formspring “ (antwort: zufall, abweichungsverstärkung, kritische masse, zackwumm), warum ist so was im prinzip faszinosum für viele?

a in zeitknappheit:

(voraussetzung)

- es ist einfach genug und das prinzip (ah, ich kann entweder eine frage stellen und der antwortet dann oder ich melde mich an und dann können mir andere fragen stellen und ich antworte dann) erschliesst sich den meisten (und jedenfalls allen, die schon ein twitter-account haben) auf den ersten blick.

(distribution)

- die verbreitung hat virales potential. wer angefixt ist will mehr und promotet sein formspring auf twitbook, und weil es einfach genug ist und es sich auf den ersten blick erschliesst, probieren andere das auch.

(narzissmus)

- es hat eine narzisstische komponente (schmeichelfaktor, dass irgendwer gerade von mir etwas wissen will, ich bin das subjekt, dem wissen unterstellt wird, usw.)

- damit verbunden ein emotionales attachment (muss mal die inbox checken, ob es neue fragen gibt)

(platt-form)

- es hat die essenz des prinzips frage&antwort (das es ja im web in hunderten variationen gibt und das sich auf sokrates und sicher auch bis in die steinzeit zurückverfolgen lässt) gwm. als fundamentalen datentyp extrahiert, indem es alle üblichen kontextualisierung eliminiert hat. und es hat sich selbst als plattform dafür etabliert.

- die form ist deshalb also flüssig und passt sich an jede individuelle interpretation an. man kann witzig, eloquent, ehrlich, whatever antworten (bzw. fragen) und soviel aufwand reinstecken, wie man will.

- gleichzeitig sind die formsprings öffentlich aber non-kompetitiv. öffentlich ist wichtig, weil man sonst auch via email, via dm etc. fragen könnte, die öffentlichkeit führt aber die phantasie der universalität und der ‘verantwortung’ ein, weil es publiziert ist; non-kompetitiv ist auch nicht unwichtig, weil man auf seinem platzerl machen kann was man will, und es ist ok.

- das führt wiederum dazu, dass man die wunderlichsten blüten sieht. menschen haben einen eingebauten spieltrieb, und je offener das rohmaterial und das endergebnis ist, desto grösser ist das potential für diverseste spannende selbstselektionen und ausdifferenzierungen.

- unter anderem, weil es reize von aussen gibt, die diskurse triggern

- diese individuellen ausdifferenzierungen führen wiederum zu kollektiven lernprozessen und feedbackschleifen. wir sind affen und haben neben dem spieltrieb ein eingebautes mimetisches potential, machen also das beste nach, bauen darauf aber auch auf. frage hier ist, wieviel davon nachhaltig handlebar wird, sich als stil etablieren kann usw.

((limits))

- es skaliert wohl nicht. es ist lustig, am ersten, zweiten und dritten tag drei (oder bei entsprechender disposition fünfzig) fragen zu beantworten oder sich selbst fragen zu stellen, die man schon immer beantworten wollte. wochenlanges beantworten von hunderten fragen am tag wird, glaub ich, mühsam. zunächst sind alle fragen toll, fragen werden sich wiederholen, werden irgendwann lästig usw. das muss nicht so sein, aber gefühlsmässig fackelt sich das potential ab.

- und wenn die mischung irgendwann nicht mehr stimmt, setzt eine abwärtsspirale ein (man antwortet nicht mehr, oder ungelaunt, das wiederum reduziert die motivation fragen zu stellen etc.)

Other People

The problem with abdicating your content consumption to other people, though, is other people.

Alex Paynes sehr treffende Beschreibung eines infoökonimischen Hauptdilemmas in einem auch ansonsten sehr treffenden Text über Feedreader.

(ich glaube aktuell straucheln ja so einige mit ihrem inputstrom-setup, meines zumindest ist derzeit ziemlich verzettelt und paradoxerweise weit weniger weder effizient noch effektiv als vor 3, 4 jahren. grund dürfte sein, dass beim übergang vom prinzip subscribe zum prinzip stream die ausdifferenzierungsparameter geschmack und urteilskraft zerbröselten; die mit dem an den strom gekoppelten praktiken und technologien streben vor allem nach einem schlaraffenland (wichtige nachrichten finden mich, social analytics, auf geht’s, der geiß nach, blabla), effekt ist aber eher eine – halt soziale – reader’s digest version vom web)

Why the real-time web isn’t important

Alexander van Elsas thematisiert Geschwindigkeit und zeigt einige Ineffizienzen auf, die das via Twitter oder FriendFeed vermittelte Echtzeit-Web beinhaltet.Mother Twitter

No service has stepped up to offer even the semblance of an alternative to Twitter’s value proposition, that being a digital soapbox on which to debate the ideas, events, and emotions that course through the place formerly known as the blogosphere. In an oddly ironic way, FriendFeed and Identi.ca have siphoned off the most vocal critics of Twitter’s failures and kept them occupied long enough for Twitter to recover.

For their part, Identi.ca and FriendFeed proponents have gone from anger to despair to revolutionary fervor to silence as users offer muted reassurance while at the same time wandering “aimlessly” back to Mother Twitter. FriendFeed’s strategy of cultivating a new A-List has largely succeeded, but micro-blogging depends more on a personalized A-List then a generalized one. Ultimately, a unified inbox is more valuable than an elite one.

Grossartiger Text über die soziologische und informationsökonomische Grundstruktur (Twitter vs. FriendFeed vs. Friendfeed vs. Jaiku vs. Laconi.ca vs. Gnip) von Steve Gillmor bei TCIT

(via)

Aggregation Wars

next up im sich beschleunigenden Output (jaiku auf seine Art schon länger, intuuch, Noserub/Identoo, …) an second order (also post-twitter, post-facebook, trans-app) Aggregatoren: FriendFeed und wie bei allen kann man seine eigenen Aktivitäten bei allen Standardseiten bündeln und bekommt die gebündelten Aktivitäten von den Bekannten und Verwandten vorserviert aka die Minifeed-Normalisation, aber eben ausserhalb von Facebook und mit dem netten Zusatzfeature, dass man sich virtuelle Freunde anlegen kann, also die Aktivitäten auch von Leuten die sich nicht bei FriendFeed angemeldet haben zu integrieren, und mit dem Doppelgag dass das Ganze primär dazu gedacht ist wieder nach Facebook zurückgespiegelt zu werden.

bonuszitat:

this was made as a joke right? cuz if it was serious then ure a dumbass. if it was a joke then it was funny.

(aus einem kommentar hierzu [tot] was wiederum ein kommentar dazu war)

WinWinWin

Ich hab am Nachmittag mal ein bisschen die Facebook Platform Developer Docs gescannt und mich mit ein paar Anwendungen herumgespielt, und das ist huge. Nicht super alles auf den Kopf stellend und die Industrie völlig verändernd huge, aber doch ziemlich huge.

Hat wohl jeder mitbekommen, aber falls nicht: seit gestern ermöglicht Facebook, dass beliebige andere Anwendungen direkt in Facebook integriert werden können. Und sie müssen kein monadisches (und oft nur parasitär geduldetes) Widget-dasein fristen, sondern sie werden Bürger erster Klasse, die gleichberechtigt neben den eingebauten Facebook Apps stehen, die diese sogar ersetzen können und die den gleichen Zugang zur DNA von Facebook – den Beziehungen der User untereinander, den Lifestreams der User in Form ihrer Timeline – bekommen.

Und da haben alle was davon:

- Die Anwendungsentwickler haben was davon, weil sie ihre bestehenden Anwendungen (in mehr oder weniger abgespeckten Versionen) der gesamten Userbasis von Facebook (24 Mio, jede Woche 100.000+) schmackhaft machen können. Und nicht nur schmackhaft. Werden sie einmal adaptiert, dann verbreiten sie sich im jeweiligen Netzwerk eines Users quasi von selbst (iLike etwa mit einem Verbreitungsgrad von 100 neuen Usern/Minute), weil die Freunde dessen Output der jeweiligen Aktivitäten in seiner timeline sehen. (sogar der Spiegel hat das (was den Bereich webtech angeht völlig überraschenderweise) gut kapiert und schön beschrieben )

Irgendwie löst Facebook u.a. auch das chicken or egg Problem vieler Seiten, die an-und-für-sich nützlich wären, wenn nur schon alle Bekannten und Verwandten mitmachen würden. Nur tun sie es nicht, also hat man keinen Anreiz das Tool zu verwenden, also entsteht nie eine Situation, in der es für die Bekannten und Verwandten interessant erscheint…

Gleichzeitig eröffnen sich natürlich auch für einen Schwarm von speziell für die Facebook Platform entwickelte Anwendungen tatsächlich ganz neue Möglichkeiten, einfach weil sie eben direkt an die bestehenden Netzwerke andocken können.

- Die User haben was davon, weil sie nach Lust und Laune das geliebte Facebook erweitern, Funktionalitäten per Klick hinzufügen können, ohne es jemals zu verlassen. Schon jetzt gibt es an die 100 Anwendungen, bald sind es tausend, bald werden diese immer besser für Facebook optimiert. Facebook wird für sie attraktiver.

- und Facebook hat davon am allermeisten, weil mit jeder Anwendung der Wert von Facebook steigt, sowohl weil eben mehr Funktionalität angeboten wird, als auch und besonders weil jede Anwendung weitere und andere Vernetzungs-, Interaktions-, und Aufmerksamkeitsdaten generiert, von denen Facebook letztlich lebt (und die in ihrer vernetzten Aggregiertheit / aggregierten Vernetztheit viel wertvoller sind als der Verzicht auf eine Gewinnbeteiligung). Dadurch wird Facebook nicht nur attraktiver als andere social networks, auch die Kosten für’s etwaige Switchen werden für den bestehenden User immer grösser, je mehr und auf je vielfältigere Weise er seine Zeit investiert und je leichter er die auch wieder immer vielfältigeren Ströme seiner Freunde rezipieren kann.

Geschickter Zug. Und wer in den nächsten 3 Monaten seine Anwendung nicht auf Facebook portiert hat (wär eigentlich witzig: StudiVZ in Facebook), ist selbst schuld. Bald wird es wesentlich schwieriger sein, eine Initialverbreitung anzustossen.

reBlog

muss mir selbr in den Arsch beissen, weil ich reBlog nicht schon früher entdeckt habe. (Oder eigentlich: habs schon vor ewiger Zeit einmal gebookmarkt, aber dann nicht weiter verfolgt, wurde aber vor kurzem durch Lifehacker wieder heraufgespült – dort gibt’s auch ein Screencast und Installationshilfe)

reBlog ist zwar eigentlich zum reBloggen gedacht, also dem unveränderten oder irgendwie annotierten Nochmalpublizieren von im Web gefundenen Dingen, und das tut es natürlich auch, aber das Killerfeature ist der eingebaute Feedreader, weil

- dieser erstens die Metapher Tagging durchzieht, man also sowohl die Feeds als auch einzelne Einträge taggen kann, und das ermöglicht sehr differenzierte Abstufungen was man wann wie lesen möchte, und weil

- man sich mit Keyboard Shortcuts sehr sehr schnell herumnavigieren kann, viel braucht man ja nicht, vor, zurück, löschen, publizieren (also merken). Ich habs die letzten zwei Tage gegen Bloglines gebenchmarkt, und ich bin mit reBlog etwa 4 Mal so schnell.

Das reBloggen kommt dann als Gustostückerl am Rande wieder dazu, weil man die Einträge die man behalten möchte eben dann auch nach MT bzw. WP posten kann, man bekommt also ein persistentes Volltextarchiv als kleinen Nebeneffekt.

Einziger Nachteil den ich entdeckt habe ist, dass das updaten der Feeds nicht gerade schnell ist, bei 300 Feeds kann man inzwischen eine kleine Runde um den Blog drehen. Und man braucht eine freie MySQL DB und PHP.

Irgendwie

… tut sie mir doch leid, die Musikindustrie mit ihrem aussichtslosen Kampf, nicht um ihre Kunden, sondern gegen sie (und gegen alles was diese wollen), nicht um das Internet und alle damit verbundenen Möglichkeiten und Ströme, sondern frontal dagegen. [Produzieren kann heute jeder, distribuieren auch, die Stars werden künftig an den Rändern gemacht und nicht von Werbefritzen, man muss kein Ökonom sein, um sich auszurechnen was mit ihr passiert.] Es nervt.