Richtig Klonen

A global community couple of servers answering one simple question: What’s your website doing? Receive answers on your phone, IM, or right here on the web!

(grundsätzlich spricht ja wirklich nichts gegen klone, die ganze kulturkreislehre etwa basiert auf der grundannahme, dass den menschen so oft nicht was neues einfällt, dass sie aber schlau genug sind, gute einfälle als solche zu erkennen und für sich zu adaptieren (übergang von handcraft zu clonecraft). andererseits ist es trotzdem irgendwie lustiger, wenn ideen ein bisschen um- oder weitergedacht und nicht nur als die eigenen verkauft werden)

The 6th Sense

Sind Zeitungen schon Gespenster, nur wissen sie es noch nicht?

media-ocean sagt ja, die blogrolle zitiert ein obskures paid-content bzw. paper only Rettungsmodell für Zeitungen eines WSJ-Opinionisten, aber ganz sind sie sich dort wohl auch nicht einig, in A Reality Check for Newspapers (via) beschreibt ein anderer WSJ-Kolumnist recht schlüssig die Situation für Content-Produzenten bzw. Rechteinhaber unter Internetbedingungen, Zitat:

Whether or not content creators like it, this is the age of fragmentation. In industry after industry, consumers are voting with their feet against old methods of packaging and distributing information. They want to pick and choose what’s of interest to them, without having to pay for or wade through what isn’t. That change, midwived by technology, has shaken or shattered content companies’ business models. It’s made everything they do more risky. And it’s stripped them of power they once enjoyed, forcing them to work with new companies and industries that somehow got to set the rules.

(eines der grundprobleme das zeitungen haben ist, dass sie sich im web nicht länger oligopolistisch einen kuchen aufteilen können, indem sie sich gegen die jeweils lokal vorhandenen anderen zeitungen positionieren (boulevard vs. bildungsbürgertum, rechts vs. links, alles eben noch gut genug), sondern dass sie sich gegen das gesamte weltweit vorhandene und frei zugängliche informationsangebot (nicht nur andere zeitungen) ausdifferenzieren müssen, und das ist nicht leicht, mit abgeschriebenen dpa/ap/reuters meldungen, faden kommentaren, fernsehprogramm und dem bild von einem busen ist das dann jedenfalls nicht mehr getan, andererseits kann ein tatsächlich erzeugter (informations/meinungs/kontextualisierungs/vollständigkeits/…-) wert ganz neue dynamiken und auch monetarisierungsmöglichkeiten (hier herrscht erstaunliche phantasielosigkeit, ads und classifieds) eröffnen. wert wird im internet ganz automatisch verstärkt, wenn es ihn gibt, wenn man es zulässt und wenn man sich mit den neuen katalysatoren (suchmaschinen, memetracker, aggregatoren, den lesern, den potentiell interessierten, …) arrangiert; gefahren gibt’s natürlich auch – u.a. powerlaw effekte, bei denen weniges überproportional verstärkt wird und der rest so dahindümpelt – aber wer die schoten dicht macht (paid content) ((dass das beim wsj funktioniert ist eher ein sonderfall, oft exklusiver und für geldentscheidungen relevanter content, eine zielgruppe die die abogebühr nicht kratzt)) oder den kopf in den sand steckt (es gibt kein problem nicht) schliesst sich selbst aus und muss auf die unfähigkeit der leserschaft hoffen, sich jemals webskills anzueignen.)

UGCV

Miniserie zu User Generated Company Value – (1) – (2) – (3) von Cem Basman.

die Diagnose: Internetunternehmen profitieren von der Leistung der User, sackeln nach der Vertafelsilberung Millionen/Milliarden ein, die User gehen leer aus!

die Idee: warum nicht User konkret mit Aktien, die nach einem Aktivitätspunkteschlüssel vergeben werden, angemessen beteiligen?

das Ergebnis: alle sind happy, die User besonders motiviert, die Unternehmen dadurch im Wettbewerbsvorteil.

So gut das klingt und so gerecht das vielleicht wäre, er löst damit das falsche Problem.

Funktionierende soziale Anwendungen basieren vereinfacht gesagt auf 3 Achsen entlang derer Wert erzeugt werden muss (höre Tom Coates’ (mp3) Vortrag beim Future of Web Apps Summit 06):

- individuelle Beiträge erzeugen Wert für den Beitragenden selbst (sonst würde er/sie es ganz einfach nicht tun, es muss ihm zumindest seine Zeit wert sein)

- jeder dieser Beiträge erzeugt auch Wert für andere

- die Organisation extrahiert daraus zwar wie auch immer gearteten Wert für sich selbst (sonst würden sie die Plattform nicht machen), verdichtet, organisiert, kondensiert, kanalisiert aber auch die individuellen Beiträge, Datenströme und Feedback-Loops zu einem Ding, bei dem das Leben für alle besser wird.

Nun gibt es unterschiedlichste Motive, warum die User was beitragen (hängt von der jeweiligen Anwendung ab), und unterschiedlichste Werte, die sie daraus ziehen (hängt auch wieder von der jeweiligen Anwendung ab), der systemisch dysfunktionalste ist dabei jedenfalls Geld.

Warum? Weil man mit Geld die falschen Verhaltensweisen belohnt und die falsche Art von Leuten (bzw. bots) anzieht. Bei social software ist Geld für Spam das was Licht für die Motten ist.

Man kann sich recht einfach für so ziemlich jede Anwendung ausmalen, was passiert, wenn mit Geld gewunken wird;

exemplarisch del.icio.us:

- ich bezahle für das Posten von Links; Effekt: Leute posten hunderte Links täglich, bots posten tausende, das System wird aufgebläht und gemolken, der Wert des Systems für alle anderen sinkt.

- oder ich bezahle für das erstmalige Hineinstellen von Links, wenn sie dann populär werden (aka Einfluss); Effekt: Leute posten täglich hunderte Links, von denen sie annehmen, dass sie populär werden (andere Aggregatoren werden gescannt, …), bots posten immer noch tausende, auch diese mit angepassten Quellen, fake accounts werden angelegt um die geposteten Links populär zu machen, das System wird homogenisiert und gemolken, der Wert des Systems sinkt.

- oder ich bezahle die Top 100 User; Effekt: Leute knacken den Algorithmus, der für die Berechnung der Top 100 herangezogen wird und spammen das System entsprechend zu, um auf diese Liste zu kommen, der Wert des Systems wird auch nicht grösser.

- usw.

Ay, so schönes Wetter, muss raus, noch schnell: anstatt sich also ein genossenschaftliches Modell zu überlegen, das Arbeit fair vergütet, sollte man eher an der Idee (ist die Welt mit ihr ein besserer Platz), am Modell (welche Verbindungen werden ermöglicht, welche Daten können wie fliessen, …) und an der Plattform arbeiten, dass der Nutzen und der Wert für alle Beteiligten maximiert wird. Wir leben im Zeitalter der Hypereffizienz und der Grenzwert der individuellen Leistung geht im System gegen Null. Es gibt sicher einige Möglichkeiten, wie man mit finanziellen Anreizen hier oder da ein paar Akzente setzen kann, aber wer sein Modell grundsätzlich auf Vergütung basiert, hat im social software Bereich schon verspielt.

(über gegenbeispiele wäre ich dankbar)

Timing II

ist wirklich von Vorteil (siehe Timing). Tumblelogs gibt’s ja eigentlich schon lange (anarchaia etwa seit 2 Jahren, happy birthday), wurden dann immer wieder auch von nicht unbekannten reflektiert, aber während der Launch von tumblr noch nicht für wirklich viel Aufsehen sorgte, bekommt es jetzt im Sog von Twitter so einiges an Hype ab (Lifehacker, Center Networks, Webware, Juxtaviews, … unisono: Tumblen ist das bessere Twittern) – und im Grunde keinen unverdienten, weil sich – glaub ich – durch Twitter tatsächlich unsere Wahrnehmungskompetenz von atomisierten Informationseinheiten verschoben hat.

(abt. dialektische spirale)

Update für das Internet

Schönes Feature von Thomas Reintjes im Deutschlandfunk: Web 2.0 – Update für das Internet (via) – im Gegensatz zu den Printmedien mal tatsächlich eine nicht ganz blöde Einführung ins Web 2.0, sogar das Ironisieren, Verniedlichen und die ganze Pseudokritik hält sich in Grenzen, insofern echt erfreulich.

Kleiner Wermutstropfen: die Beschreibung ist ziemlich vollständig, aber neben der Nennung der Standardfeatures wird bzgl. keiner Achse etwas tiefer geschürft, es werden halt die Nährstoffangaben von der Verpackung vorgelesen, aber es wird nicht darüber nachgedacht, warum die Mahlzeit dann auch schmeckt (oder nicht), wie’s überhaupt dazu kommen kann, etc, aber wer tut das schon.

(grund dafür ist – glaub ich – der hierzulande vorhandene solipsismus, der unter ausklammerung des gesamten internationalen diskurses das web 2.0 halt nochmal neu erfindet und den begriff dann in operativer geschlossenheit so lange kursieren lässt, bis man selbst an ihn glaubt)

(abt. hörtippderwoche)

Metahyping

Eigentlich erstaunlich:

es gibt (im deutschen Diskurs jetzt) keinen eigentlichen Hype über das Web 2.0, es gibt nur einen Hype um einen vermeintlichen Hype ums Web 2.0.

Es gibt auch keinen Hype um Twitter (dieser hypersozialen, mobilen Microtumbling Plattform), es gibt . nur . einen . Hype . um . den . Hype . um . Twitter

(abt. kulturkreislehre)

Rewire

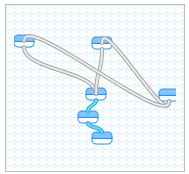

Wow, gleich zwei Meilensteine des Web innerhalb von zwei Tagen. Nachdem mit Useless Account [http://uselessaccount.com/] gewissermassen das konzeptionelle Nirvana des Web 2.0 markiert wurde (derzeit tun 6111 User begeistert nichts), legt Yahoo! nun mit pipes [http://pipes.yahoo.com/] nach und schenkt der Welt die erste als vollständig bezeichenbare Remixingplattform.

Pipes is a hosted service that lets you remix feeds and create new data mashups in a visual programming environment. The name of the service pays tribute to Unix pipes, which let programmers do astonishingly clever things by making it easy to chain simple utilities together on the command line.

Digger

Vor 2 Tagen hat digg-Gründer Kevin Rose verkündet, dass die Top Digger Liste nicht mehr angezeigt wird, seither tobt die Blogo- und Diggosphäre, die Liste ist an anderer Stelle wiederauferstanden, …

Rose hat das natürlich damit begründet, dass ein möglicher digg-für-die-eigenen-mediokren-Interessen-ausnützen-wollender Anker (die Top Digger dafür bezahlen, dass sie eine Seite auf die Frontpage diggen, derzeitige Gage dafür zwischen 100$ und 500$) ausgehoben werden soll, aber im Grunde sieht man dabei eines: wie eine früh getroffene Entscheidung im sozialen Design zurückkommen und einen in den eigenen Arsch beissen kann.

Ursprünglich ist digg ja aus der Idee heraus entstanden, eine Art demokratische Version von slashdot zu sein. Im Gegensatz zu slashdot konnte jeder Stories reinstellen, wie bei slashdot konnte jeder kommentieren, wie bei del.icio.us konnte jeder diggen was ihm gefällt, und die besten Stories eines Tages, die dann auch für den Gelegenheitsuser und Streuner attraktiv sind und die dann die Klickzahlen generieren, weil sie einer riesigen Leserschaft vorgesetzt werden, wurden so auf die Frontpage promoted. Geniales Prinzip und nicht umsonst wurde digg zu einer der paradigmatischen und erfolgreichsten Anwendungen des Web 2.0.

Nur wurde digg in den letzten paar Monaten ein Opfer der eigenen Popularität. Derzeit werden alle 3, 4 Minuten 15 neue Stories geposted. Die erscheinen zunächst in der upcoming Sektion auf der ersten Seite, nur bleiben sie dort nicht lange, sondern werden in den nächsten 10, 15 Min. von den nachrückenden Stories in die Unsichtbarkeit geschoben – selbst der leidenschaftlichste digger klickt sich nicht bis Seite 308 eines jeweiligen Tages durch. Die einzigen Stories, die es in die popular Sektion schaffen, sind die, die von populären Diggern gepostet oder gediggt werden (in etwa 60% der Frontpage Stories kommen von 100 Diggern, der Rest von den nächsten 400 – aus bald 1 Mio. Usern), nicht deshalb weil sie die besten Stories posten, sondern weil nur diese dann auch von deren (zahlreichen) Freunden gesehen und optional auch gediggt werden.

Es entbehrt nicht einer gewissen Ironie, dass dieser demokratische Ansatz unter den Bedingungen einer freien Informationswirtschaft die gleichen Kastenstrukturen herausgebildet hat, die eigentlich gestürzt werden sollten und dass ausgerechnet die soziale Komponente der Freundesnetzwerke Ursache dafür ist.

Der Planet der Affen

Robert Basic beklagt eine Innovations-Pause im US-Web – seit 2005 tue sich nichts mehr wegweisendes, 2006 nur Nachahmer, für 2007 sei nix in Sicht.

Naja.

Was man ev. sagen kann ist, dass die Zeit der neuen Megaseiten die dann auch bis zum Spiegel oder der Zeit durchdringen (myspace, youtube, craigslist, flickr, facebook, digg, delicious, lastfm) wohl für die nächste Zeit vorbei ist. Das liegt aber nicht an einer damals vorhandenen aber seit 2 Jahren stagnierenden Innovationsfähigkeit, sondern eher daran, dass diese Seiten quasi die Pilger / Kolonialisten der fundamentalen Datentypen (Text, Bild, Ton, Video, soziale Beziehungen, Waren, Bookmarks als webspezifischer Anker) unter readwriteweb-Bedingungen waren. Und nachdem die Pfründe bzgl. dieser fundamentalen Datentypen einmal gesichert waren und der Paradigmenwechsel vom (im allgemeinen jetzt) Empfänger zum (zumindest von der gegebenen Möglichkeit her) Sender einmal stattgefunden hat, haben sich die Gewinner bzgl. der jeweiligen Bereiche eben als supererfolgreiche Plattformen positioniert. Smash Hits waren sie aber nicht deshalb, weil sie besonders innovativ waren, sondern weil diese Bereiche mehr oder weniger jeden tangieren (Teenager gibt’s in den USA 50Mio -> myspace, Leute die ihre Haustiere verkuppeln wollen schon deutlich weniger -> matchmypet; digitale Photos hat jeder -> flickr, Bücher auch schon wieder weniger -> librarything, hmm, Amazon Reviews…, egal).

Ende 2004 waren die Rezepte mehr oder weniger bekannt (Usability: Gmail; alle für alle: del.icio.us; Allesschlucker: MySpace), O’Reilly fand dafür einen Namen, Breitband war bezahlbar, die Einstiegskosten für Startups waren mitunter aus der eigenen Tasche finanzierbar, 2005/2006 kam es zu einer tatsächlichen Explosion von realisierten Ideen, anders kann man die mehr als 10.000 (keine Hausnummer) neuen Tools die in den letzten 2 Jahren entwickelt wurden nicht beschreiben, nur stecken die Innovationen dann eher im Detail, in der Verfeinerung und Spezialisierung, in der Ausdifferenzierung der beteiligten Subsysteme (S3, Elastic Compute Cloud), in der Art und Weise wie diese sich wechselseitig durchdringen und verkoppeln und verkuppeln, im Graben von Kanälen wie Daten fliessen können (Mashups, Widgets), im Dekonstruieren und Reaggregieren (Memetracker, smart Aggregators), im Finden von anderen ökonomischen Modellen (Crowdsourcing, social Commerce Modelle), usw.

Natürlich gibt es Nachäffer, der 500ste digg-Klon ist mit pligg oder etwa auf crispynews schnell aufgesetzt und als innovativ lässt sich das dann schwer beschreiben, aber auch die machen mitunter Sinn, wenn sie sich lokalisieren (etwa yigg) oder thematisch spezialisieren (etwa pick!t) oder die Metapher etwas umdeuten (etwa reddit) oder sich mit einem bestehenden Angebot vermischen (etwa newsvine). Aber damit war es ja nicht getan, ganz im Gegenteil, man muss nur genauer hinschauen (wenn einen das interessiert, wenn einen das nicht interessiert verpasst man natürlich auch nichts). 2007 wird wunderbar.

Kollektivismus

Stranges Interview mit Jaron Lanier im Spiegel.

(der Wikipedia wird kein Gefallen getan, wenn ihr eine (erschwarmte) Weisheit oder (kollektive) Intelligenz angedichtet wird, die ihr dann auch gleich wieder abgesprochen oder ironisch kritisiert wird – Prinzip Wiki: Ist es dumm, an die Klugheit der Masse zu glauben? fragt etwa der Spiegel und meint natürlich ja. Dumm ist jedoch nur, die Frage so zu stellen. Die Wikipedia ist die organisierte und teilweise selbstorganisierende Summe von Einzeleinträgen, und in keinem Eintrag manifestiert sich irgendeine Intelligenz einer Masse (an die man glauben könnte). Im besten Fall sind sie das dialogisch ausgehandelte Ergebnis eines oder mehrerer aber nicht zu vieler intelligenter und informierter oder recherchierender Individuen, die sich ergänzen und/oder auf die Finger schauen. Für sehr sehr viele Themen funktioniert das jedenfalls für die meisten Informationsbedürnisse gut genug.)

Plastilin

Web 2.0 ist ein plastischer Begriff. Die Bedeutung ist nicht festgelegt oder fixiert, sondern muss gewissermassen von jedem für sich selbst erarbeitet werden. Es gibt keine ultimative Referenz oder Definition. Die Aussagekraft des Begriffes hängt deshalb also von der Arbeit ab, die man selbst hineinsteckt. Wer es sich leicht macht (wie etwa ein Großteil der Massenmedien, wo ein Journalist mal schnell irgendwas zusammengesampelt hat und die anderen die immer gleichen Ressentiments, Vorurteile und 5 Paradebeispiele von Firmen dann abgeschrieben und weitergetragen haben), der agiert dann mit einem einfachen, aber eben auch undifferenzierten Begriff, der dann halt tatsächlich auch wenig bzw. nichts bringt.

Das bedeutet nicht, dass man Web 2.0 beliebig definieren kann – zumindest wenn man mit anderen kommunizieren will. Web 2.0 entsteht sicherlich irgendwo als Beschreibung der Ensembles von neuen Möglichkeiten, die die zunehmende Ausdifferenzierung der beteiligten Systeme (Mensch und Maschine, Soziologie und Ökonomie, …) und deren Zusammenspiel, zunehmende Interpenetration und Koppelungen, etc. ermöglichen. Je nach Interesse machen dabei unterschiedliche Beobachtungspostionen Sinn, man sollte aber im Hinterkopf behalten, dass es immer auch andere gibt. Wer Tomaten auf den Augen hat und glaubt, da sei überhaupt nichts ausser einem Buzzword oder Hype, dem kann man auch nicht helfen.

(abt. nur mal so)

Zeitungen

Auf Basis einer Studie der Bivings Group, die die wichtigsten US-amerikanischen Zeitungen auf ihre Internettauglichkeit ausgewertet hat

The Use of the Internet by America’s Newspapers, we researched the websites of America’s top 100 newspapers by circulation, and evaluated them based on their use of 14 different Web 2.0 features. These criteria were comprehensive, and included a wide variety of Web tools, such as reporter blogs, video and podcasts, message boards, and RSS feeds. We pursued this study in order to determine whether newspapers are trying to compete with the Internet or use it to expand readership over a different medium. The results of our research clearly showed that America’s newspapers … are generally embracing the Internet and are using new and improving Web tools to their advantage.

(meine Hervorhebung) organisiert Wortfeld das für die deutschen Zeitungen auf einem Wiki

Die Kriterien sind:

- RSS-Feed: Bietet die Zeitung einen RSS-Feed an? Wenn ja, mit vollständigen Inhalten oder nur Teilen?

- RSS-Feed für unterschiedliche Bereiche: Wenn die Zeitung RSS-Feeds anbietet, gibt es Feeds für unterschiedliche Teilbereiche?

- Werbung in RSS-Feeds: Wenn die Zeitung RSS-Feeds anbietet, enthalten diese Werbung?

- Häufig gelesen: Bietet die Zeitung eine Liste der am häufigsten gelesenen, beliebtesten oder am meisten per Mail verschickten Meldungen an?

- Videos: Bietet die Zeitung Video-Inhalte an?

- Podcasts: Bietet die Zeitung Podcasts an?

- Chats: Bietet die Zeitung Live-Chats oder Chatrooms an?

- Journalisten-Blogs: Bietet die Zeitung Weblogs von Journalisten an?

- Journalisten-Blogs mit Kommentaren: Falls die Zeitung Weblogs von Journalisten anbietet, können Leser auf diesen Weblogs kommentieren?

- Blogroll: Falls die Zeitung Weblogs von Journalisten anbietet, enthalten diese Links zu externen Weblogs?

- Leser-Kommentare: Können Leser Artikel auf der Website kommentieren?

- Registrierung: Ist eine Registrierung notwendig, um die Artikel zu sehen?

- Bookmarking: Bietet die Zeitung eine Bookmarking-Funktion an, also Artikeln mit Lesezeichen zu versehen? Ist es ein internes (also eigenes) System oder ein externes (wie del.icio.us)?

- Foren: Bietet die Zeitung Foren?

(aggregiert gibt dieser Fragekatalog sicher eine gute allgemeine Zustandsbeschreibung. Aber es wird dabei impliziert, dass eine Zeitung dann gut im Internet agiert, wenn sie viele Häkchen abhakt. Mit den meisten sozialen Features wird allerdings bestenfalls das falsche Problem gelöst (wie kann ich die Leser durch Einbindung ev. noch retten, auf meinem Angebot halten, verhindern, dass sie womöglich auch noch woanders hin gehen); das eigentliche Problem (was bin ich? unter der Bedingung, dass Inhalte (zumindest die der Konkurrenz, der Blogger, usw.) plastisch geworden sind (siehe Bubblegen.), zerstückelt werden, herumschwirren, disseminiert und rekombiniert werden, diskutiert, gelinkt, getaggt, gevotet, gerankt und sortiert werden, blablabla) wird irgendwie noch verschoben.)

(interessant wie diese in der checkliste beschriebene ‘pflicht’ 2012 gelesen quasi von jedem onlineangebot von verlagen grösstenteils abgehakt wurde, aber die kür – und eigentliche pflicht – der neuerfindung unter den bedingungen web noch immer vollständig verdrängt blieb)

Modellgeschäft

Die Frage nach dem Geschäftsmodell des Web 2.0 scheint in gewissen Rhythmen zu kommen. Gerade wo bei den Bloggern das Fragen etwas nachgelassen hat (der Höhepunkt war so im Dezember letzten Jahres erreicht, als Flock released wurde) scheint sie sich jetzt bei Unternehmen vermittelt/verstärkt durch die Massenmedien vermehrt aufzustauen.

Martin Röll sagt jetzt jedenfalls

Als ob es [das Web 2.0] eins haben müsste.

Er relativiert das zwar damit, dass man schon schauen sollte was denn “das Internet für das bestehende Geschäft und innerhalb der existierenden Geschäftsmodelle tun kann” – und das ist als catch-all Phrase irgendwie nicht falsch (naja liebe Buchhändler, hätten sie halt geschaut, was das Internet für ihr existierendes Geschäftsmodell tun hätte können) aber es ist doch erstaunlich wie naiv seine Einschätzungen bzgl. der Auswirkungen, die Geschäftsmodelle die unter den Bedingungen des Web 2.0 entstehen auf die unterschiedlichsten Bereiche haben werden, sind.

(der konzeptionelle Fehler der bei der Frage nach (und der impliziten Erwartung einer Antwort an) einem Geschäftsmodell wohl begangen wird ist, den Begriff auf dem Niveau einer buchhalterischen Monetarisierung zu beschränken und dabei zu übersehen, welche ökonomischen Strukturveränderungen mit gleichzeitiger Wertschöpfungsexplosion jenseits einer an Firmen gekoppelten Input/Output-Maschinerie stattfinden, welche Kanäle entstehen, die diese distribuieren, usw. – Strategien dazu etwa im Gesamtwerk von Bubblegeneration, oder praxistauglicher etwa bei Exciting Commerce)

Money equals Spam

… im social software Kontext (Nachtrag zu dem hier)

- in dem Moment in dem es bei Services Top 10/100 Listen gibt wird bei einigen Usern ein kompetitiver Reflex getriggert und sie wollen da rein; noch schlimmer wird’s natürlich, wenn auch noch eine monetäre Vergünstigung auf dem Spiel steht

Bzw. – um dieses Theorem leicht abzuwandeln – Netzwerke sind dann qualitiativ wenig hochwertig, wenn es möglich und lukrativ ist, durch Systembeobachtung und darauf aufbauende Verhaltensanpassung zum Star zu werden.

(abt. der weisheit letzter schluss)

diggscape

Nur ein Satz zum unmoralischen Angebot von Jason Calacanis (gebe den top-Bookmarkern $1000 wenn sie zu Netscape wechseln): fast jeder Beitrag den ich dazu gelesen habe war irgendwie moralisierend (ja darf man das? wieviel ist die Seele wert? ist es gerecht die User nicht zu bezahlen und die Gründer auscashen zu lassen? community kann man nicht kaufen, etc.) – aber ich bin über keine einzige Analyse gestolpert, die aus der entsprechenden Systemhaftigkeit dieser Communities die Schnapshaftigkeit dieses Ansatzes (jenseits davon, dass es wahscheinlich trotzdem ein verglw. günstiger PR Stunt war) geschlussfolgert hätte.

digg, delicious, flickr, youtube, usw. sind seltsame Pflanzen die wunderbar blühen, aber warum gerade die und nicht andere, die schöner, technisch raffinierter, etc. sind, das weiss kein Mensch, das lässt sich auch nicht vorhersagen oder reproduzieren, jedenfalls liegt’s nicht an der Software, sondern an irgendeiner Dynamik des zur rechten Zeit am rechten Platz Seiendem und dabei die richtigen Leute anzuziehen, deren Microbeiträge sich über die Powerlaweffekte dann zu hypereffizienten Megaeffekten aufsummieren (Videos die millionenfach gesehen, Links die hundertausendfach geklickt, … werden) bei denen aber der Wert eben nicht im jeweiligen Beitrag liegt (das Superlink, -video) sondern in den Netzwerkeffekten, die aber ab einer gewissen Dynamik immer irgendwas populär machen (irgendwelche 20 Links sind immer auf der Frontpage von digg und bekommen dann 10.000 visits in einer Stunde und die Betreiber freuen sich über die wisdom der crowd); den Kopf des langen Schwanzes kann man also abschlagen sooft man will, der wächst sofort wieder nach, man schwächt also digg nicht durch das Abwerben der derzeitigen Top-User, das Link ist dann halt 3 min. später gediggt, oder halt eine anderes; und Netscape gewinnt nichts durch die 3000 zusätzlich im Monat eingereichten Stories, weil die an der dortigen Demographie völlig vorbeigehen (also wieder most popular auf YouTube als Tagsschau) bzw. keinen Sinn machen und dementsprechenden keine votes kriegen und also nicht populär werden und eben überhaupt keinen Effekt mehr auslösen.

Readers Edition II

und die Readers Edition [war http://www.readers-edition.de/] ging gestern live (und wurde ziemlich einhellig gut aufgenommen [war http://technorati.com/search/readers-edition.de])

Ich hoffe, dass ich mich sehr irre, aber ich befürchte, dass der dahinterstehende Gedanke interessanter sein wird als das Ergebnis.

Die traditionellen Massenmedien leiden ja vorwiegend deshalb unter einem psychologischen Knacks, weil sie merken, dass ihr Modell (Content generieren bzw. einkaufen, verpacken, Zugang kontrollieren bzw. verkaufen) unter den Bedingungen bei denen überall und von allen generiert wird, nicht auf eine, sondern auf hunderte Arten verpackt und umverpackt wird, der Datenfluss letztendlich völlig unregelmentiert ist aber sich via menschlicher Filter (Linkblogger), maschineller Filter (smart aggregators) und allen hybriden Filtern (etwa digg), usw. einfach nicht mehr bzw. immer weniger greift. Das spricht nicht gegen die Medien (eine gute Zeitung ist und bleibt was sehr schönes), sondern für die Hypereffizienzen der Ränder

Die Readers Edition ist nun von der Struktur her eher noch zentralistisch (es wird für die RE geschrieben, es wird moderiert und redigiert, …) und outsourced lediglich die Erstellung der Inhalte.

Mal so dahingesagt erbt die Readers Edition dadurch die Nachteile des einen Modells ohne die Vorteile des anderen Modells (rezeptionstechnisch: ein auf die eigenen Interessen und Lesegewohnheiten optimierter Inputstrom extrahiert aus hunderten Quellen, blabla; produktionstechnisch: ein positives Aufwand/Nutzen-Verhältnis wie etwa bei flickr (weil man die Photos halt hat) oder bei del.icio.us (weil man sich die Links merken und für sich selbst organisieren will) oder irgendwie auch bei der Wikipedia (weil man irgendwie für die Ewigkeit schriebt)) zu nutzen.

Handelsblatt

Das Handelsblatt – ich schätze mal Thomas Knüwer, kaum sonst jemand liegt mit seinen Einschätzungen zum Web 2.0 so konsistent daneben – zum Label beta:

Wer würde in ein Flugzeug steigen, über dessen Bordtüren ein Schriftzug warnt: “Dieses Flugzeug haben wir noch nicht zu Ende entwickelt und seine Absturzsicherheit ist noch nicht getestet.”? Wer würde Medikamente schlucken, deren Packungsbeilage informiert: “Über Risiken und Nebenwirkungen wissen wir noch nichts. Sollten Sie welche verspüren, füllen Sie bitte beiliegendes Formular aus.”? Was in der Alltagswelt absurd erscheint, hat bei modernen Web-Diensten Hochsaison.

Der Vergleich mit der Luftfahrt / den Medikamenten hinkt natürlich, das Schlimmste, was einem bei irgendeinem Web 2.0 Dienst üblicherweise passieren kann, ist, dass man ein paar Daten verliert – und das kommt so gut wie nie vor. Aber interessant ist dann doch, dass eigentlich gerade das Gegenteil vom Vermeinten der Fall ist: im Web 2.0 ist beta weniger ein Indikator für Mangelware, sondern eher das Pendant zum ISO 9001 Gütesiegel für Qualität. Das Durchschnittsbeta ist bei weitem ausgereifter, hübscher, hipper, … als das Durchschnittsnichtbeta. Grottenschlechte Releases gibts en masse, wirklich schlechte Betas eigentlich kaum.

(als Grund dafür vermute ich mal die kognitive Dissonanz, die üblicherweise auftritt, wenn man seine eigenen Fähigkeiten in Relation zu den Fähigkeiten aller anderen einschätzen soll. Je schlechter die eigenen Kompetenzen, desto eher die Selbsteinschätzung als besonders gut, weil natürlich jeder Maßstab fehlt; je grösser die Kompetenzen, desto grösser die Fähigkeit zur Selbstkritik. Der berechtigte Grössenwahn von 37signals ist da eher die Ausnahme.)