Generation Why?

Über einen Mangel an massenmedial vermitteltem Diskurs über das Web kann man sich in letzter Zeit eigentlich nicht beklagen. Eigentlich auch nicht über die Qualität der aufgestellten Protagonisten (im sinne von: sie versuchen wohl wirklich, ‘experten’ für themen und standpunkte zu finden, so ein hau-drauf-journalismus (gaschke usw.), der davor eher die regel war, wird zumindest ergänzt; man denke an diese internetdenker serie in der faz, die besetzung von diskussionsrunden, etc. nicht alles superduper, aber man hat nicht mehr das gefühl, zumindest nicht mehr immer, dass sie absichtlich verblöden wollen).

Und trotzdem findet, kommt mir vor, kaum Vermittlung statt, und zwar jenseits des allgemein üblichen (und in jedem bereich gegebenen) Aneinandervorbeiredens.

Mit persönlich ist es zwar eher egal, was irgendwer über das Internet denkt, aber diese genuine Selbstvermittlungsunfähigkeit des Webs finde ich interessant. Woran liegt es, dass ein Ding, das (neben anderen eigenschaften) auf den verschiedensten Ebenen (persönlich, kollaborativ, wirtschaftlich, sozial, kulturell, you name it) ein enormes Potential für ganz trivialen egoistischen Nutzen hat, bezüglich dessen ‘Verständnis’ es also ein stinknormales Eigeninteresse geben sollte, mit so unfruchtbaren Begriffen und Beschreibungen abgebildet wird?

Diese Unfruchtbarkeit des Diskurses erstreckt sie ja nicht nur auf die Bereiche, in denen man das erwarten könnte – etwa shirkys ‘institutions will try to preserve the problem to which they are the solution’; wer für sich böses ahnt will nachvollziehbarerweise desinformation und regulierung -, sie erstreckt sich über alle Bereiche, auch die Web-nativen.

Something to think about.

PubSubHubbuzz

Buzz ist weder ein Facebook- noch ein Twitter-Killer. Wenn überhaupt von irgendwas ein Killer, dann von Yammer und Konsorten, wenn sie ihre Enterprise Version gestartet haben. Aber der ganze Vergleich hinkt. Leider kann man nicht in Google reinschauen, was sie sich bzgl. ihrer social strategy davon versprechen, aber ich vermute fast, dass ihre primäre Idee eher so in Richtung die Menschen lieben es ganz offensichtlich, im Web Zeug zu sharen, warum sollten sie das nicht bei uns tun? geht, und das dann auf ihre Art weiterdenken (siehe unten).

Was Google aber wie so oft nicht versteht, bzw. versteht, aber nicht besonders gut umsetzt, ist, dass das Sharen von Stuff kein abstraktes Bedürfnis ist, sondern in Dialektik mit der Dynamik eines Dienstes entsteht.

Bei Facebook und Twitter und allen anderen erfolgreichen Diensten ist diese Dynamik klar geregelt. Facebook ist Kommunikation unter Freunden, Twitter ist öffentliche Kommunikation unter Interessierten. Der eigene social graph auf Facebook hat sich, zumindest im Kern, in einer Vorzeit entwickelt (aka Freunde). Der eigene social graph auf Twitter entwickelt sich organisch und adjustiert sich permanent. Buzz macht aus den Versatzstücken social graph und sharing einen Eintopf und rührt ohne Fokus kräftig darin rum. Email-Kontakte z.b. sind weder (notwendigerweise) Freunde, noch Leute, die sich (notwendigerweise) für die eigenen Ergüsse interessieren, noch sind deren shared items (notwendigerweise) für einen interessant. Angezeigt wird, anderes Beispiel, nur, was Google nach Filterung durch eine black box als relevant erachtet. Vertraut uns, das können wir, wir haben das erfunden.

(wobei die versteckenden tabs recht schick sind)

Und es gibt natürlich noch eine Reihe von ans frühe FriendFeed erinnernde rookie mistakes, bei denen man aber davon ausgehen kann, dass sie in kommenden Iterationen ausgemerzt werden, das betonen sie auch selbst.

Und es gibt eine weitere Reihe von falschen (oder besser: kontingenten, aber in ihren konsequenzen nicht bedachten) konzeptionellen Grundannahmen der Google-Hirne, wie man sie bei so ziemlich jedem Google-Dings, das irgendwas mit social zu tun hat, kennt.

Davon abgesehen hat Buzz aber mehr Potential, als alles andere, was bisher von Google im Bereich social gekommen ist. Wenn man von Buzz, dem Produkt in der derzeitigen Form, abstrahiert, schlummert darunter Buzz, die Plattform, die doch eine Art universelle Pumpe für all things social werden könnte, weil Google damit zum ersten Mal zwei Dinge zusammenführt:

- ein Superset von offenen Standards, mit denen sich so ziemlich alles abbilden lässt, was an sozialen Inhalten produziert wird, inklusive Reaktionen und Beziehungen (Atom/RSS, MediaRSS, Activity Streams, Social Graph API, webfinger).

- und die Technologie, das alles und kostenlos an jeden interessierten Endpunkt in Echtzeit zu pumpen (PubSubHubbub, OAuth, AtomPub, Salmon).

Wenn man so will, ist Buzz, das Produkt, eine suboptimale Demoversion für Buzz, die Plattform, und anders als etwa bei Google Wave kann man davon ausgehen, dass es auf Basis der Plattform relativ zeitnah diverseste Services und Integrationen geben wird.

Das heisst nicht, dass damit alle Silos aufgebrochen werden, was wohl auch nicht wünschenswert wäre, Silos haben auch ihren Sinn. Aber auf Basis von Buzz könnte sich ein webweites soziales Nervensystem entwickeln, das dann angezapft und auf tatsächlich neuartige Weise reinterpretiert werden kann.

—

miniproductivity tipp am rande: wenn man zur alten version von gmail wechselt, dann gibts den ganzen buzz nicht. man muss also buzz nicht gleich ganz deaktivieren, wenn einem das phasenweise nicht in die inbox passt.

Das offene Web und seine Feinde

… iDiss revisited, ca. 200 meinungen später.

ein pattern dabei ist recht interessant: die protagonisten der offenheit und des hackens haben wenig vertrauen in die systemkraft der offenheit resp. die kreativkraft der menschen. viele sehen im ipad fast schon eine art endgame, bei dem offenheit und eigensinn kurz vor dem matt stehen, weil sie der grossartigkeit des ipads / dem schrecklichen weil lustvollen matmos / nichts entgegensetzen können.

The iPad is an attractive, thoughtfully designed, deeply cynical thing. It is a digital consumption machine.

alex payne zb macht aus dem ipad fast schon eine art bioadapter der gesellschaft.

(kreativität wird nicht angeregt, sondern unterdrückt; das ist umso schlimmer, weil die vorgeschlagene metapher zur verwendunge von computern u.u. bei vielen sogar besser ankommen könnte als das (sinnlose aber lehrreiche) herumtinkern; wer nur das ipad kennt, wird kein hacker; viele iphone user kennen ausser ihren apps nichts; apple unterstützt das auch noch, die werbung sagt ‘da gibts ne app für’, vom web sagt sie nichts; apple schert sich keinen deut um offenheit und kann oder will offenheit nicht mit usability und eleganz verknüpfen;die entscheidung dafür hat keine technische grundlage, sondern ist strategisch; der weg den uns das ipad weist ist also verführerisch und dystopisch; usw.)

Yet I am concerned that it will get a flow of great apps from people who are willing to compromise on their freedom and users’ freedom.

dave winer rundet die befürchtungen ab. es könnte zu einem brain drain kommen, bei dem entwickler ihre kreativität in eine plattform pumpen, die dann – etwa wegen patentrechten auf multitouch – noch nicht mal auf anderen plattformen emuliert werden kann.

leichter dahergesagt als getan aber trotzdem: wer an die offenheit glaubt, der muss auch an ihre konkurrenzfähigkeit in einem milieu glauben, in dem es auch geschlossene systeme gibt.

iDiss

yay, das iPad ist da, von hinten nach vorne nachzulesen etwa bei engadget.

(in meinem stream witzigerweise fast ausschliesslich herumgemotze, das deutsche äquivalent zum amerikanischen fanboy mit consumerblick ist der dissboy mit ingenieursblick, meh, das soll es sein, ein grösseres iphone, wer braucht denn das, und zugeschraubt ist es auch noch, …)

((ich verstehe die argumentationslinie closed platform, die angst vor einem quasimonopol der istores, nach music und apps jetzt auch noch bücher, usw., aber unterm strich ist es das geilste fenster ins internet und also mit allen damit verbunden möglichkeitsräumen yet, warum faseln wir denn alle seit vier jahren von der cloud, und auch preislich ist es mit $500 + monatlich $30 ohne vertragliche knebelung mehr als attraktiv; die fraktion open hätte mehr davon, apple als benchmark für die eigenen aktivitäten zu verwenden))

Short Cuts Pt. 5 (Early Adopter Edition)

Eine der traurigsten Tropen im Diskurs im und um das Web ist die des Early Adopters. Der Begriff Early Adopter bringt nichts, stört nur und verhindert die Entwicklung von Positionen.

Die Beschreibung von Personen als Early Adopter basiert auf der im Web sinnlosen Notion einer fortschrittlichen Zeitlichkeit. Die Entwicklungsgeschichte wird als linearer, zeitlicher, teleologischer Strahl konzipiert. Wer vor den anderen auf neue Entwicklungen aufspringt, gilt als schneller und besser. Das erworbene kulturelle Kapital ist allerdings kurzlebig, weil es keinen Stillstand geben darf. Es ist schnell wieder verspielt, wenn man nicht immer auf die nächste neue Entwicklung umsteigt.

Aber im Web gibt es keine Zeitlichkeit, weil alles für alle immer schon gleichzeitig ist. Jede neue Anwendung ist sofort für alle verfügbar, jeder neue Inhalt ist sofort für alle zugänglich. Das Web ist keine Serie von disparaten Linearitäten, sondern ein Gewebe, das alles in sich aufnimmt und synchron miteinander verbindet; eine Gleichzeitigkeit von Ungleichzeitigkeiten; ein Potential, dessen Möglichkeiten angezapft werden können, oder nicht. Das Web ist postkontemporär.

Ganz allgemein gesagt sind Webdienste Möglichkeitsräume. Möglichkeitsräume, die zwei Serien triggern können:

Eine Serie der individuellen Intensität, also dem Grad mit dem man den Dienst für sich selbst (aktiv oder passiv) nutzt und sein Leben dadurch besser, interessanter, spannender macht. (Auch wenn man etwas nicht benutzt, ist es gewissermassen doch als Umwelt da. Allerdings ist die persönliche Intensitätsstufe dann halt null.)

Und eine Serie der kollektiven Resonanz, also dem Grad mit dem der Dienst zum Schwingen gerät, Koppelungen und Rückkoppelungen mit anderen Diensten, Systemen, Feldern eingeht und dabei das Leben für die Freunde und die Welt besser, interessanter, spannender macht.

Für jeden Einzelnen geht es also, um zum Early Adopter zurückzukommen, weniger darum, ob man früher oder später damit beginnt, einen Dienst zu nutzen, sondern um die Intensität, mit der man ihn zu einem je gegebenem Zeitpunkt nutzt, und um die Resonanzkörper, die dadurch um ihn herum entstehen. Wenn man etwas nicht verwendet, weil man keinen persönlichen Anknüpfungspunkt darin sieht, dann ist man nicht hinten, sondern handelt rational. Wenn man auf jeden Zug aufspringt, der gerade losdüst, ohne sein Leben dadurch besser zu machen, ist man zwar Early Adopter, aber auch ein Dummkopf.

Das bedeutet jetzt nicht, dass es nicht sinnvoll ist, zu versuchen am Laufenden zu bleiben. Wer kein Sensorium für die ja stetig wachsenden Möglichkeiten entwickelt und kultiviert, wer nicht weiss, was es alles gibt, der hat natürlich die Opportunitätskosten der Nichtbenutzung.

Aber die fast schon penetrante Ungeduld der Neuheit und des jeweils Nächsten hilft dabei selten weiter. Und die Erzählfigur des Early Adopters ist besonders traurig, weil sie gleich zwei Positionen in ihrem Blickwinkel einschränkt:

Die Fremdzuschreibung spart sich durch die Diagnose ‘das ist halt was für Early Adopters’ die Auseinandersetzung mit den Phänomenen. Early Adopters wird gerne mit anderen Begriffen wie ‘selbsternannte Internetelite’ oder (nie konkret benannten) ‘Propheten’ oder ‘Vordenkern’ kombiniert, um eine künstliche Differenz zwischen ‘denen’ und dem ‘normalen wir’ zu konstruieren. Sollen die halt machen, mit ihren Zauberwörtern Blog und Wiki und Flickr und Twitter, wir sind normal und wir wissen, dass das alles ein Blödsinn ist.

Die Selbstzuschreibung ‘ich bin ein Early Adopter, weil ich tool yxr benutze’ ist allerdings fast noch blöder, weil mitunter ein Selbstbild und Gruppengefühl konstruiert wird, das auf nichts begründet ist, und weil ein Tunnelblick entwickelt wird, der blind für die Eigentlichkeiten ist. Es ist keine Leistung früher als andere einen Dienst zu verwenden. Wer ein, zwei Blogs liest und sich überall anmeldet ist der Earliest Adopter schlechthin und erzeugt dadurch alleine noch überhaupt keinen Wert, weder für sich, noch für andere. Was aber getrübt wird, ist der Blick auf das, was funktioniert und warum.

Wer sich selbst als Early Adopter konzipiert, tappt nur allzuleicht in die Falle, eine individuell wertvollere Verwendung von Webdiensten gegen eine wertlosere aber neue Verwendung einzutauschen.

Short Cuts Pt. 4 (Tod von RSS Edition)

In den letzten Wochen war mal wieder viel vom Tod von RSS zu hören. Ohne auf die jeweiligen Thesen im Detail einzugehen trotzdem ein paar Worte dazu, warum das ein blödsinniger hubbub ist.

Zunächst werden oft zwei Dinge vermischt: RSS als Format und RSS als kulturelle Technik des Abonnierens und Lesens von Feeds. Gemeint wird immer zweiteres, aber die Schlussfolgerungen werden manchmal vermischt. Egal, diese Unstimmigkeit erkennt man schnell und kann man abheften.

Was bleibt ist die Annahme, dass Feedlesen eine aussterbende Gattung ist, die von neueren, besseren, effizienteren, fortgeschritteneren Techniken abgelöst wurde. Und diese Annahme ist auf mehreren Ebenen problematisch. Das Äugen auf und die Bervorzugung von Charts (Wachstum hier, Verluste dort) anstelle der Wahrnehmung von Wert; die Notion eines ‘weiter ist besser’ bei blinder Zerstörung der Vorhandenen; der Begriff von Early Adopters, die die fortgeschrittensten Techniken reflektieren aber in Wirklichkeit dichtere Formen gegen dünnere eintauschen; die Annahme, dass was sich nicht als mainstreamtauglich für alle herausstellt nix wert ist; usw.

Das alles ist im Grunde egal, jeder soll machen was er will, und was andere tun tangiert einen persönlich wenig (anders als bei sozialen systemen, wo die koppelung viel stärker ist). Aber ganz stimmt das dann doch wieder nicht, weil man selbst natürlich auch nur irgendwie im Gesamtökosystem verankert ist, und auch wenn man seinen eigenen informationsökonomischen Haushalt selbst bestimmen kann, so schwimmt man eben im aggregierten Ergebnis der Aktionen aller anderen; und die Resonanzräume, die durch die Praktik des Rezipierens und Prozessierens von Feeds getriggert werden, sind interessanter, als die Resonanzräume, die durch verstümmelte Formen wie Beschränkung auf Twitter und Memetracker und Empfehlungssysteme mit anschliessendem Retweeten und Liken getriggert werden.

Nix gegen Memetracker und Twitter und Empfehlungssysteme, die sind super und haben ihren Wert und können einige Dinge viel besser, als das persönliche (zuerst einmal Finden und) Abonnieren und Lesen von Feeds.

Aber das (zuerst einmal Finden und) Abonnieren und Lesen von Feeds ist die potentiell dichteste, effizienteste und persönlich wertvollste Technik. Sie sollte das Herz der individuellen Anbindung an den Gesamtstrom sein.

Die wunderbarste Eigenschaft des Webs sind die kleinen Dinge und die Möglichkeit einer Ausdifferenzierung an den Rändern. Wie strange man auch immer selbst veranlagt ist, wie noch so unwahrscheinlich die eigenen Interessen, im Web gibt es für alles Anschlusskommunikation. Massenmedien müssen per definitionem immer Massen ansprechen, aber niemand ist Masse und also pendelt sich das was sie tun auf irgendeinem kleinsten gemeinsamen Nenner ein. Aber im Web gibt es immer einen, der sich auch mit dem Thema beschäftigt, der Dinge radikaler beschreiben kann, der ohne Rücksichtnahme auf Allgemeinverständlichkeit und also dichter denken kann und vielleicht für einen gerade richtig ist etc. Massenmedien müssen für alle gut genug sein, aber im Web dürfen Spezialisten für andere Spezialisten gut genug sein, und auch wenn das nur 10 Leute sind ist die Welt ein besserer Ort.

Blogs sind nun die ideale Form, um partikulare Expertise von anderen mit spezifischen Interessen zu mappen, und das Abonnieren und Lesen von Feeds ist die ideale Form, um die spezifischen eigenen Interessen zu beliefern. Blogs sind deshalb ideal, weil es drei Dinge besser als jede andere Form vereint: Geschmack, Urteilskraft und Komplementarität.

Geschmack

Über Geschmack kann und braucht man nicht zu streiten, aber es ist eine binäre Kategorie. Wird der eigene Geschmack getroffen, ist man happy, sonst muss man halt durch.

Urteilskraft

Bei der Urteilskraft ist es ein bissl wie bei dem Geschmack, die gefühlte Unterstellung einer Urteilskraft ist immer ein subjektives Gefühl, die vom eigenen Wissenstand abhängt. Anders als beim Geschmack muss das Vertrauen in die Urteilskraft des Anderen allerdings erst aufgebaut werden und wachsen. Auch anders als beim Geschmack kann man über die Urteilskraft schon streiten.

Komplementarität

Bei der Komplementarität geht es darum, zu welchem Grad das, was man selbst ohnehin weiß, ergänzt wird. Auch Dinge mit wunderbarem Geschmack und präzisester Urteilskraft sind völlig witzlos und wertlos, wenn man alles ohnehin schon kennt. (einer der grössten fehler der mehrzahl von systemen ist die annahme, dass sich möglichst gleiches mit gleichem mischen soll)

Short Cuts Pt. 3 (User Edition)

Im Grunde funktioniert das Web sehr einfach. Das Web ist wahrscheinlich der grösste Möglichkeitsraum, den die Menschheit je hervorgebracht hat. Nicht weil die zugrundeliegende Denkleistung so phänomenal ist, sondern weil es eine Infrastruktur definiert, die sämtliche Medien subsummiert und in sich aufnimmt, und vor allem: weil es unsere Möglichkeiten der Kommunikation potenziert.

Das Web macht also ein Angebot, genauer: das Web ist die Summe aller Einzelangebote in Form von Anwendungen und deren Zusammenspiel.

Um ein beliebiges Angebot wahrzunehmen müssen 3 Voraussetzungen erfüllt sein:

- man muss das Angebot kennen.

- man muss das Angebot verstehen.

- man kennt kein ‘besseres’ Bündel das mehr Nutzen bringt.

Unter dem Strich: es geht darum, dass wir durch die Benutzung eines Dienstes besser dastehen, als ohne.

Man kann – wenn man will – Webanwendungen in zwei Kategorien unterteilen:

- Anwendungen, deren Sinn sich selbst erklärt.

- Anwendungen, deren Sinn sich erst durch Nachdenken / Nachahmen / Anwendung etc. erschliesst.

Ich will niemandem zu nahe treten, aber es sprechen einige Symptome dafür, dass die meisten Menschen sehr gut darin sind, Anwendungen die sich selbst erklären für sich nutzbar zu machen, wenn sie ihnen Nutzen bringen (i.e. die meisten schauen mal schnell was in der Wikipedia nach, oder gehen auf ebay auf Schnäppchenjagd, oder bestellen sich Bücher bei Amazon, oder bestellen Zugtickets, oder schauen Videos auf YouTube, usw usf.)

Doch schon deutlich weniger erkennen das Potential von Anwendungen, deren Sinn und Nutzen sich nicht sofort erschliesst und aufdrängt. Man darf glaub ich 2 Fehler nicht machen: glauben, dass man alles verwenden muss. Oder glauben, dass man nichts versäumt. Man darf auch nicht glauben, dass nur Wert hat, was für alle wertvoll ist. Die Schönheit im Web ist das Potential der Ausdifferenzierung, dass sich jeder das Bündel an Anwendungen zusammenstellen kann, das mit den eigenen Interessen am meisten kompatibel ist, dass jeder genau soviel Zeit investieren kann, wie er will.

Dass sich Leute, die beruflich mit dem Web zu tun haben, ein anderes Produktportfolio zusammenstellen und mehr Zeit investieren ist klar, sollte aber nicht darüber hinwegtäuschen, dass es trotzdem Opportunitätskosten gibt, Tools nicht zu kennen und zu verstehen.

Ich stelle mir seit langem die Frage: woher kommt der Widerstand sich 30 Minuten hinzusetzen und zu versuchen RSS zu verstehen, wenn das die eigene Produktivität was den Konsum von Nachrichten betrifft, um den Faktor 5 bis 10 erhöht? Mehr als 30 Minuten dauert es nicht, dennoch halten sich die Adaptionsraten in Grenzen.

Wenn man die Voraussetzungen oben als Matrix verwendet: viele kennen es nicht, und vielen, die irgendwie darüber gestolpert sind, erschlisst sich der Sinn nicht. Es geht nicht darum, ob RSS jetzt ein Hype ist oder nicht und was irgendwer über RSS sagt oder nicht sagt, es geht darum, dass RSS einen enormen Wertvorschlag macht, den man annehmen kann, oder nicht. Und nur wer RSS kennt kann eine informierte Entscheidung darüber treffen, in welchem Umfang er RSS einsetzt oder nicht. Wer dann lieber den Guardian genüsslich in seinem Lieblingscafe liest, der macht alles richtig. Aber wer aufgrund einer Ignoranz die Möglichkeiten erst gar nicht kennt, der bleibt halt auf seinen Opportunitätskosten sitzen. Macht natürlich auch nichts, aber trotzdem ist es schade drum.

Nun sind alleine in den letzten 3 Jahren mindestens 20.000 Services gestartet (keine Hausnummer) und es wäre mehr als ein Fulltimejob, jeden dieser Dienste auf den individuellen Nutzen hin zu überprüfen. Es gibt also auch Informationsbeschaffungskosten. Wenn es mehr Aufwand macht einen Dienst zu finden als er dann nutzen bringt, dann ist es nicht sinnvoll diesen Aufwand einzugehen. Zum Glück hat das Web Mechanismen etabliert, die einem die meiste Arbeit abnehmen. Die Antwort heisst nicht Massenmedien wie TV, Spiegel oder Heise, sondern Blogs. Einige Tausend Blogger haben es sich zur Aufgabe gemacht wie Eichhörnchen auf die Suche nach dem nächsten grossen Ding zu gehen, sie testen aus, filtern, bewerten usw. Blogs, die sich dabei als besonders gut erweisen bekommen grössere Leserschaften und fungieren als Verstärker. Das heisst nicht, dass sie alles finden oder dass sie das beste toll bewerten, aber im grossen und ganzen funktioniert das nicht schlecht.

Rutsch

einen guten Rutsch ins neue Jahr!

Short Cuts Pt. 2 (Worthless Edition)

Über den (vor allem) Unsinn Rupert Murdochs Plan, seine Properties vor Google zu verstecken, wurde schon genug geschrieben, einen Punkt möchte ich aber dennoch erwähnen:

Zitat aus dem Telegraph

“The traffic which comes in from Google brings a consumer who more often than not read one article and then leaves the site. That is the least valuable of traffic to us… the economic impact [of not having content indexed by Google] is not as great as you might think. You can survive without it.”

Das mag so stimmen, die haben sicher gemessen usw., was er dabei aber völlig übersieht, ist, dass Kunden, die für einen selbst wertlos sind, für die Konkurrenz durchaus wertvoll sein können. Jeder nicht-Klick auf ein Angebot bei News Corp bedeutet per definionem einen Klick auf ein anderes Angebot.

Massenmedien haben im Web einen immensen Startvorteil. Sie nehmen ihre Reputation von aussen mit und können sie idealerweise ausbauen. Neue Anbieter beginnen bei Null, sie müssen sich ihre gesamte Reputation erarbeiten.

Paywalls führen einerseits zu einem sukzessiven Verlust der eigenen Reputation (ich würds mir anschauen, aber zahlen tu ich dafür nichts also schau ich mich woanders um) und zu einem Aufbau der Reputation anderer.

Was er auch nicht sieht, sind nicht direkt messbare Effekte. Einer der kommt und wieder geht, verschickt vl. die URL an Freunde, bloggt darüber, twittert darüber uswusf. Nicht-Sharebarkeit macht das Angebot auch für bezahlende User wertloser, weil sie es eben nicht sharen können.

(nicht unsympathisch ist übrigens das interview von zeit-geschäftsführer christian röpke mit meedia. er sucht zwar das heil in der preisstabilisierung von ads und nicht etwa in besseren sds, besseren formaten, aber er wirkt nicht unrefletkiert)

Standardsituationen

Netter Text zu den Standardsituationen der Technologiekritik [war http://www.online-merkur.de/seiten/lp200912adz.htm] von Kathrin Passig, eine Art Systematisierung der Reflexe auf Neues, zuletzt also auch auf iPhone, Twitter und Co (was natürlich auf twitter zu einem sturm an über sich selbst gerührten schulterklopfern führte; aber schaut als kleines weekend project mal nach, wann ihr aufgehört habt, twitter und hype in einem satz zu verwenden oder als dingsbums für early adopters abzutun).

(die auflistung von offensichtlichen dummheiten von anderen aus einer position des im nachhinein ist natürlich immer amüsant. was mich ein bisschen stört, ist der fokus auf die luddistischen neinsager, weil er impliziert, als hätte man es immer schon gewusst. für jeden neinsager gab es zu jedem zeitpunkt immer auch einen jasager, dessen utopien im nachhinein genauso lächerlich wirken. gerade im und um das internet lagen eigentlich alle schon immer falsch, man braucht nur an die metaphern und visionen von vor 15 jahren denken. niemand hat vor 10 jahren mit wikipedia, google oder blogs, vor fünf jahren mit facebook, youtube oder flickr, noch vor zweieinhalb jahren mit twitter und mit den damit einhergegangenen strukturveränderungen gerechnet, einfach auch deshalb, weil die meisten tools selbst reine zufälle waren, deren effekte noch nicht mal die gründer auch nur erahnten. facebook entstand, weil zuckerberg ein fauler hund war und aufgaben crowdsourcen wollte; flickr war ein abfallprodukt eines online-games; die wikipedia entstand, weil aus der eigentlich angedachten nupedia, die von experten geschrieben werden sollte, nix wurde; twitter war als sms-dienst unter freunden gedacht, den die user dann umfunktionalisiert haben und zu dem gemacht haben, was es ist. wir wissen alle nix und selbst wenn man mit einer aussage/prognose zufällig richtig liegt, dann eher deshalb, weil irgendeine aussage immer stimmt, und nicht weil man es wissen konnte.)

((was es glaub ich gibt, ist das verständnis von prinzipien, deshalb sind leute wie kevin kelly, umair haque, clay shirky, bruce sterling immer so spot-on; was uns normalsterblichen bleibt, ist die entwicklung eines mehr oder weniger feinen sensoriums für das wahrnehmen von wellen und strömungen im ozean, in dem wir alle treiben))

beckmann, jauch, schirrmacher

hab gestern, durch twitter aufgescheucht, ein paar minuten der beckmann, jauch, schirrmacher runde geschaut, die über die gefahren von computern und web für denken, bildung und volkswirtschaft sinnierten, und während es mit der beschreibung ‘ältere herren, die nichts raffen und die nicht raffen, dass sie es nicht raffen’ auch recht zutreffend beschrieben wäre, ist mir witzigerweise auch das erste mal in gewisser klarheit bewusst geworden, warum es die, die es nicht raffen, nicht raffen.

ganz pauschal gesagt sind viele dieser generation vom internet schlicht und einfach überfordert. nicht weil sie zu dumm oder zu begriffsstutzig sind, sondern weil es durch das internet einen exzess der kommunikation gibt, den sie nicht verarbeiten können, mit dem sie nichts anfangen können, den sie nicht einschätzen können.

der grund dafür ist, dass ihnen das organ fehlt, wichtiges von unwichtigem zu unterscheiden.

fast jedes vorgetragene beispiel lässt sich auf diese genuine nicht-unterscheidungsfähigkeit zurückführen, fast jedes vorgetragene problemszenario wäre keines mehr, würde man die unterscheidung treffen.

die kommen alle aus einer welt, in der alles wichtig ist bzw. in der es ein vorgefertigtes ordnungssystem für wichtiges gibt. wer jede email, jeden blogpost, jedes kommentar bei heise, jeden tweet gleich behandelt wie einen liebesbrief, eine rechnung oder einen leitartikel in der faz, der kommt im web nicht weit, weil die sicherungen nach 10 minuten durchbrennen.

das problem dabei ist, dass dann auch alle anschlussüberlegungen falsch sind, weil sie auf einer falschen prämisse basieren, und dass sie nie durch herumexperimentieren adäquat einschätzen können, für was das web gut ist und (fast noch wichtiger) für was nicht. das ist zunächst ein problem für den jeweiligen selbst, ein gesellschaftliches problem wird es allerdings, wenn das meinungsmacher oder politische einflüsterer sind, weil dadurch gesellschaftliche opportunitätskosten angehäuft werden, einerseits indem unfruchtbare praktiken weitergetragen werden, andererseits indem unfruchtbare strukturen etabliert werden. sie meinen es sicher gut, aber sie werden zu verhinderern.

(es gibt im web natürlich eine dialektik der unwichtigkeit, sprich: die grössten glücksgefühle entstehen im einen selbst überraschenden übergang von vermeintlich unwichtigem in persönlich wichtiges, vl. kann man auch lernen oder persönliche entwicklung dazu sagen, das unwichtige ist jedenfalls genauso wichtig wie das wichtige; aber die unterscheidung in wichtiges und unwichtiges muss als primäre unterscheidung zunächst einmal getroffen werden und das organ zur effizienten unterscheidungskraft muss in der folge ausgebildet werden, weil man sich nur dann nicht in dinge verzettelt und verbeisst, die eben unwichtig und also nicht verzettel- und verbeissenswert sind.)

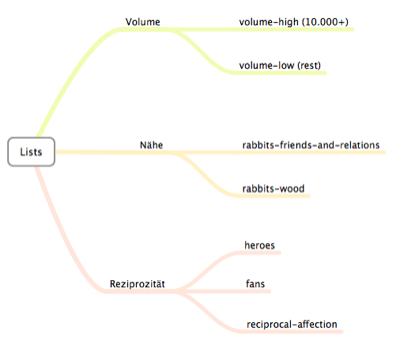

Lists (Transformers Edition)

Hab mich, nachdem die API für die Twitter Lists jetzt dokumentiert ist, am Wochenende ein bisschen damit herumgespielt, und man kann doch einiges damit machen. Neben dem expliziten Layer (vor allem natürlich: Twitterer nach Themen sortieren) tun sich vor allem Möglichkeiten auf, einige implizite Schichten herauszuschälen bzw. zu organisieren.

Ich glaube zwar es ist wichtig, trotz aller listgegebenen Segmentierungsmöglichkeiten einen in sich intakten Hauptstrom zu behalten (sprich: nicht hunderten/tausenden zu folgen, um sie dann in listen abzuheften) – die Selektionskosten sind wertvoll, aber es gibt doch einige interessante (und am besten komplementär genossene) List-Paare. Etwa:

Filter nach Volumen

Alle Twitterer sind gleich, aber einige sind fleissiger als andere. Ich habs bei mir mal überflogen: 10% aller Tweeps (bei mir 20) erzeugen die Hälfte aller Tweets. Das ist bei anderen Accounts sicher nicht anders.

Diese Tweets können natürlich genauso super etc. sein, es stellt sich aber die Frage, ob man will, dass wenige den eigenen Strom dominieren, nur weil sie es halt tun. Immerhin verdrängen sie u.U. auch Tweets von denen, die weniger twittern.

Manchen fehlt das Gespür für einen Filter, manche sehen auch einfach nicht, dass Tweets neben dem Nutzen auch Rezeptionskosten verursachen. (Richtwert: mehr als 10.000 Tweets insgesamt, wer noch nicht lange dabei ist: mehr als 100 Tweets in der Woche).

Listen:

- volume-high für die Vieltwitterer

- volume-low für alle anderen

Filter nach Nähe

Alle Twitterer sind gleich, aber einige kennt man, oder man hat einen Bezug (liest seit Jahren das Blog etc.), und andere kennt man nicht.

Auch hier gibt es keine direkte Relation zur Superheit der Tweets (eher im gegenteil, lol), diese ergibt sich jedoch durch den Bezug. Anyway, man will eigentlich nicht, dass der Strom aller die Tweets der friends-and-relations verdrängt.

Listen:

- rabbits-friends-and-relations für die Bezugspersonen

- rabbits-wood für alle anderen

Filter nach Reziprozität

Alle Twitterer sind gleich, aber manchen folgt man, aber sie folgen einem nicht, und manche folgen einem, aber man folgt ihnen nicht, und manche folgen sich gegenseitig.

Listen:

- heroes für die, denen man folgt, die nicht zurückfolgen

- fans für die, die einem folgen, denen man nicht folgt

- reciprocal-affection für wechselseitiges Verfolge

Ich bin zwar kein Fan vom Auge ums Auge Prinzip (i.e. automatisches reziprokes unfollowen), aber es bietet sich doch an, die heroes Liste sauber zu halten, man sollte wissen warum man denen folgt. Wenn sie sie weder friends-and-relations sind, noch thematisch interessant, und dann auch noch high-volume, dann konsumieren sie Bandbreite, die man anders besser nützen könnte.

Und es bietet sich an, die reciprocal-fans Liste zu scannen, weil man Leute entdecken kann, deren Notification man verpasst hat. Wer einem folgt, muss ja eigentlich interessant sein.

Public Service Announcement

Ich habe Scripts für die Volume- und Reziprozitäts-Listen, kann sie also für beliebige Accounts generieren. Ping me, wenn ihr so eine Liste wollt.

Facebotter

The functional act of constructing a tweet or a status update is very similar. Produce text in roughly 140 characters or less inside a single line text box and click a button. Voila! Even the stream based ways in which the text gets consumed look awfully similar. Yet, the more I talk with people engaged in practices around Twitter and Facebook, the more I’m convinced these two things are not actually the same practice. Why? Audience.

danah boyd über die unterschiede zwischen twitter und facebook, auch über normen, kulturelle praktiken, usw.

stimmt schon alles irgendwie, und sie schält schön heraus, dass ein ding, auch wenn es von aussen gleich ausschaut, jeweils ganz was anderes sein kann, nur macht sie den gleichen fehler wie alle anderen, nämlich alles am mantra konversation mit der ausrichtung auf zuhörerschaft / audience aufzuhängen.

natürlich wird gebabbelt und natürlich gibts zuhörerschaften und natürlich wird jeweils unterschiedlich gebabbelt für jeweils unterschiedliche zuhörerschaften, aber der eigentliche unterschied liegt im grundsätzlichen gewebe von facebook resp. twitter, die beide völlig verschiedene motive der produktion, erwartungshaltungen an die rezeption und serien der anschlusskommunikation haben (privat vs. öffentlich; kommunikation unter freunden vs. information unter interessierten; reterritorialisierung auf dem ursprünglichen thread vs. deterritorialisierung via retweets und den 2000 twitterapps; etc.).

der grund, warum es so schwer zu sein scheint, diese beiden sphären auseinanderzuhalten und nicht konzeptionell zu vermischen, liegt glaub ich an oben erwähntem mantra der konversation bzw. audience. nicht nur rekonzipieren privatpersonen ihre freunde bei facebook als ‘audience’ auf die sie einfluss ausüben wollen, für die sie publishen wollen und anderen blödsinn (der übergang vom auf ein bier gehen zum social networken), auch facebook selbst rekonzipiert sich als twitter.

der twitterneid von facebook ist zwar verständlich – was soll denn das? da sind wir der 350 mio pfund schwere gorilla und dieser makake bekommt die ganze aufmerksamkeit? – aber facebook begibt sich auf ganz dünnes eis. im versuch die streams der user öffentlich zu machen, schaut her, auch bei uns wird ganz toll über produkte und gott und die welt geplaudert, viel mehr noch als bei twitter, das könnte man auch echtzeitmässig aufbereiten, viel besser noch als twitter, unterminiert facebook sukzessive den grundvertrag, den es mit seinen usern eingegangen ist, und dekonstruiert sich selbst.

Hackr Minifesto

Hacking is most commonly associated with computers, and people who break into or otherwise subvert computer systems are often called hackers. Although this terminology is occasionally disputed, I think it is essentially correct — these hackers are discovering the actual rules of the computer systems (e.g. buffer overflows), and using them to circumvent the intended rules of the system (typically access controls).

Paul Buchheit mit einer Minitheorie des Hackens.

(er unterscheidet zwei serien: offizielle regeln – wie die dinge sein sollen – und eigentliche regeln – wie die dinge sind, realität – und die hacker gehen der realität auf die spur)

((natürlich nicht schlecht, wobei er als techniker naturgemäss noch an der ‘echten realität’ hängt und ein lacansches mapping (symbolisches/reales/imaginäres, mit dem hacken als ausdifferenzieren des imaginären, quick shot) gefühlsmässig noch fruchtbarer wäre))

Weiter weiter

Eine der falschen Grundannahmen ist, Entwicklung automatisch als Progression zu verstehen. Zuerst war Radio, TV und Printjournalismus, dann kamen Podcasts, Vidcasts und Blogs, dann kamen Tumblr, Microblogging und Lifestreaming, dann kam das mobile Realtime Web. Die jeweils letzte Form ist grösser, besser, weiter und löst das bisherige ab.

(in der frühphase ist das phylogenetisch zu verstehen; manchmal braucht es einen psychohygienischen reflex der abgrenzung und selbstwahrnehmung als in-crowd, wenn die anderen medienformen sich dumm stellen und über einen lachen; das macht diese selbstwahrnehmung aber nicht treffender oder schlauer)

Passender wäre zu versuchen, die verschiedenen Ausdrucksformen im jeweiligen Milieu zu verstehen und die Milieuverschiebungen zu beschreiben. Was sind ihre Produktionsbedingungen, was ihre Vernetzungsdynamiken, was ihre Rezeptionsbedingungen, wo haben sie Stärken, für was sind sie eher weniger gut geeignet. Die Ausdifferenzierung erledigt den Rest.

Formen werden seltenst völlig abgelöst. Die Zeitung und der Roman haben auch im Zeitalter von Twitter und dem Handyroman noch ihren Wert, einfach weil sie ein bestimmtes Problem gut lösen. Was sich allerdings verändert, sind die relativen Wettberwerbsvorteile gegenüber den anderen Medien.

Beispiel Blogs: eine der grossen Stärken ist die Anschlusskommunikation. Auch wenn es Feuilletonisten lieber anders sehen, besser als Gedichte schreiben oder Seminararbeiten zu verfassen oder die Demokratie zu verteidigen sind Blogs geeignet, um Themen aufzugreifen und mehr oder weniger annotiert zu diffusieren. Blogs als kommentierendes Nervensystem der News. Doch ein Ding hat sich als wesentlich effektiver für die Verbreitung von News herausgestellt: Twitter. Und auch Dienste wie Tumblr oder Posterous sind besser fürs einfache Sharen geeignet. Für die Entwicklung von Blogs ist das vielleicht gar nicht das Schlechteste, vieles macht unter den Bedingungen von Twitter und Co keinen Sinn, es bleiben aber andere Qualitäten.

Social Media

Das schöne am Begriff Social Media ist, dass er nicht falsch verstanden werden kann.

Social Media ist die eingedampfte und von jedem konzeptionellen Überbau befreite Version von Web 2.0. Web 2.0 beschrieb eine sehr spezifische Form der Ausdifferenzierung im System Web; Social Media übernimmt ein Element – es gibt Seiten mit user generated content – und verkauft einige ausgewählte Effekte dieser Tatsache als gelobtes Land. Web 2.0 hat sich für den disruptiven Wert interessiert, den spezifische neue Formationen generierten; Social Media übernimmt die entstandenen Plattformen als leeres Gefäß, macht eine quantitative Bestandsaufnahme und stellt die Frage ‘bist du schon drin?’. Die Zielgruppe von Web 2.0 waren Webmonkeys; die Zielgruppe von Social Media sind Leute und Organisationen, die vom Web keine Ahnung haben. Und während Web 2.0 immer unter der Diskrepanz zwischen dem, was es eigentlich bedeutet, und dem, wie es ankam, zu leiden hatte, liefert Social Media zwar nur wenig diskursiven Unterscheidungswert, ist deshalb aber auch kaum misszuverstehen.

Alle sind auf dem gleichen Blatt und der kognitive Overhead des Interpretationsaufwands für Aussagen fällt weg. Wenn wer von Social Media faselt, muss man als Zuhörer nicht mehr die zwangsemphatische Maschine anwerfen, die versucht zu rekonstruieren, wie derjenige gestrickt sein muss, damit er die jeweilige Aussage treffen kann.

Das bedeutet natürlich nicht, dass Social Media völlig sinnlos ist. Die Sphären Web und Nichtweb haben Synchronisierungsbedarf und Social Media ist verständlich und kann vermitteln, während sich Web 2.0 retrospektiv als völlig unverständlich und unvermittelbar erwiesen hat. Das bedeutet aber natürlich auch nicht, dass die auf Basis von Social Media getriggerte Anschlusskommunikation deshalb fruchtbarer ist, ganz im Gegenteil. Begrifflichkeiten helfen bei systemischen Ausdifferenzierungen und schwächere Begriffe machen bestimmte Phänomene nicht greifbar und triggern bestimmte Entwicklungen nicht (siehe dazu exciting commerce).

(es entbehrt ja nicht einer gewissen ironie, dass die deutsche verdünnung von web 2.0 zum mitmachweb schon 2006 social media mehr oder weniger vorweggenommen hat und also der welt zwei jahre voraus war. der einzige unterschied ist, dass der deutsche blick damals vornehmlich aus dem (wenig fruchtbaren) blickwinkel des andere-arbeiten-lassen getroffen wurde, social media aber den (fruchtbareren) blickwinkel der konversation einnimmt. das mantra konversation ist natürlich noch viel problematischer als social media, aber das ist eine andere geschichte)

Lauwarme Cervisia

Twitter redesignt die Startseite und switcht den eigenen Daseinsgrund von der Frage ‘What are you doing?’ zur Aufforderung ‘Share and discover what’s happening right now, anywhere in the world’.

Ich glaub zwar nicht, dass ihnen das gross weh tun wird, aber es verwandelt Twitter von einem eiskalten Medium – die Sinnstiftung musste von jedem selbst vorgenommen werden, was in der Folge aber eine umso stärkere Binding bewirkte; das Erkennen des Mehrwerts von Twitter war ja fast mit dem Spiegelstadium vergleichbar, also dem Moment, in dem sich ein Kind von aussen als sich selbst erkennt – in ein lauwarmes.

![]() ->

-> ![]()

Symptomatisch ist auch der Übergang des Vogels, weg vom minimalistischen Modernismus hin zum kitschigen Infantilismus.

Das Bündel

Andreas Göldi ist manchmal irgendwie echt ein Anti-Haque, dachte ich in meinem Ohrensessel, als ich Smart Bundling: Was die Medienkonzerne von Microsoft lernen können las.

(nach einem crashkurs in preisdifferenzierung empfiehlt er medienkonzernen das schnüren von attraktiveren bündeln für ihre angebote; ich glaub zwar, dass das in einigen bereichen eine inkrementelle verbesserung der situation bewirken könnte, aber der ansatz an sich ist zum scheitern verurteilt, weil er sich gegen die logik des web sperrt. bündeln (die organisation aller prozesse die am ende eine zeitung, die man dann verkaufen kann, ausspucken etc.) ist ja genau die kernkompetenz der traditionellen medienkonzerne, die dann vom web untergraben wurde. das unbundling und dekonstruieren von allem in seine atomaren einzelteile mit anschliessendem, eigenen gesetzen folgenden rebundling und rekonstruieren in neue formationen und rekombinationen (memetracker, smart aggregators, usw.) ist genau die kraft, gegen die kein kontrollkraut gewachsen ist. ein ein bisschen smarteres bundlen bringt da nix, sie müssten sich eher überlegen, wie sie ihre produkte besser mit der funktionslogik des web verknüpfen. aber genau das erfordert eine moral/dna, die sie wie den beelzebub meiden, weil sie nicht mehr ausschliesslich auf sich und die sicherung ihrer interessen denken dürften. je mehr sie aber mauern, desto effizienter werden die antikörper in form von google, twitter und co.)

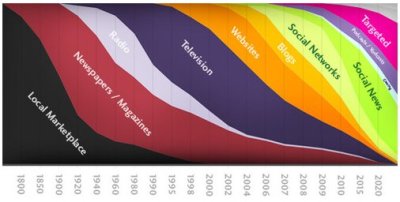

Geologie

nettes Diagramm zur Geologie der Medien von baekdal

(via rubel der mit seiner ankündigung sich fortan dem lifestream zu widmen und sein blog blog sein zu lassen einiges an sinnstiftungssuche ausgelöst hat, etwa #1 oder #2 oder #3 oder #4 oder #5 und viele mehr)

((anders als andere solche debatten und sinnsuchen ist diese gar nicht so uninteressant, der übergang von der formation blog mit den damit verbundenen produktions-, distributions- und rezeptionshaushalten zur formation stream mit den gänzlich anderen produktions-, distributions- und rezeptionshaushalten ist derzeit die primäre verschiebung; sie leidet aber darunter, dass die achse ganz altbacken in einem vermeintlichen vorne und/oder weiter und nicht im jeweiligen wert gesucht wird. den ersten begriff, den man kicken müsste, ist der early adopter, der ist im web sinnlos, weil damit weder kosten noch eine individuelle leistung verbunden ist))

Twittable Twitter Tricks Pt. 4: Three Digit Following

Folge niemandem, der selbst mehr als 1000 Leuten folgt.

(wenn das alle normalen twitterer machen würden, würden sich damit mit einem schlag 98% des follower-spams erübrigen; die, die systematisch folgen/beinichtreziprozitätwiederentfolgen, würden ab der 1000er marke nur noch andere mit der gleichen strategie und bots und also die wertlosesten accounts anhäufen und noch teuerer: echte follower per definitionem ausschliessen)

((ausnahme wie immer: wenn man jemandem folgen will, dann soll man das tun))