Selection 2007

Summit

Hmm, also allzuviel Streukraft hat der/die/das Web 2.0 Summit in der Blogberichterstattung nicht ausgelöst, wenn man bedenkt, dass der das wichtigste 2.0 Event ist. Von ca. 15 Fathead-Bloggern die vor Ort waren und die alle die Announcements oder was halt passiert ist mehr oder weniger gleichlautend dokumentiert haben (Paarbloggen) ((was natürlich nicht schlecht ist, was sollen sie denn sonst machen)) einmal abgesehen, weiter diffusiert sind die Themen kaum. Das kann jetzt auch eine Vergangenheitsverklärung sein, aber mir kommt es so vor also hätte es 2004 und 2005 doch ganz anders gebrodelt.

Das ist irgendwie auch sinnvoll – wenn sich ein topic einmal blogtechnisch stabilisiert hat, gibt es für die tieferen Straten keinen Grund mehr, irgendwas nochmal wiederzukauen, weil ohnehin davon ausgegangen werden kann, dass das von der möglichen Leserschaft schon wahrgenommen wurde. Das spricht für eine systemeigene Schlauheit bzw. einer Reife in der Aufmerksamkeitseffizienz, aber in dieser Radikalität ist das doch verwunderlich.

Unisono 2.0

Das Problem ist weniger, dass die SZ nicht schnallt, was Web 2.0 ist (und glaubt es hat was mit Mitmachweb und Blogs zu tun etc.); das Problem ist eher, dass das nicht einmal die Blogger schnallen (und auch glauben, es hat irgendwas mit Mitmachweb und Blogs zu tun, etc., mit dem einzigen Unterschied, dass die einen glauben und sich immer wieder versichern, dass es Kinderkram sei, und die anderen glauben und sich immer wieder versichern, das sei durchaus auch super.) Dass das in Deutschland halt unisono so verstanden wird, macht diese Auffassung nicht richtiger.

(es ist natürlich völlig egal, was web 2.0 ist und wer wasauchimmer glaubt, was web 2.0 ist, und ich will da auch nicht darauf herumreiten, aber wenn der begriff den funken einer bedeutung jenseits von freien assoziationshöfen, die man halt hat, wenn hinter irgendwas ein 2.0 steht, haben soll, dann würde es nicht schaden wenn man entweder das oder das liest und sich kurz durchüberlegt, denn mehr als das oder das (und allem, was man unter den bedingungen davon sagen kann und was unter den bedingungen davon gesagt wurde, und das ist nicht viel und seit 2005 ist nichts dazugekommen) ist es nicht, aber da bin ich wieder hier)

Neumachine

Nachtrag zu Hypenetz, Hypemachine ist ja echt die Bombe, instant Hochgenuss.

Warum wieso siehe nochmal bei Marcel, hier nur noch die Anmerkung, dass das auch sn-topographisch ein echter Geniestreich ist, der zeigt, dass man wenn man das Web ernst nimmt und hinschaut auch keinen facebook’schen social graph und noch nicht mal eine last.fm’sche Community braucht, um Intensitäten zu verdichten, weil ohnehin schon alles da ist.

Musik ist natürlich das paradigmatische Medium, bei dem sich das Web (in Form von Communities, in Form von Networks, in Form von Marktplätzen, oops: bubblegen) als Killer von allen sich von der Musikindustrie ausgedachten Produktions- und Marketingmodellen erwiesen hat, einfach deshalb, weil fast jeder an Musik Gefallen findet, der eigene Geschmack trugsicher ist und man ganz automatisch hin zum für einen persönlich intensivsten Zentrum oszilliert, auf Basis von Empfehlungen, dem was die Freunde hören, etc., wenn man einen lässt. Und das findet man ganz einfach, wenn man in einem System, das sich frei ausdifferenziert und die eingespeisten Tracks über diverse Feedbackloops schwingen lässt, den Spuren von anderen folgt und in dem System selbst mitschwingt – und nicht wenn man etwaigen Monokanälen folgt, die einem die MI mit viel Werbeaufwand vorsetzt.

Die Ineffizienz dabei – und Musik ist ein bisschen ein Sonderfall – bei den SNs ist, dass sie diesbezüglich einerseits einen Hang zu Monokulturen haben (Geschmackskluster bei last.fm) und dass andererseits die Peers nicht notwendigerweise den besten Geschmack haben (Gruppengeschmacksautopoesis bei Facebook). Bei MySpace ist das ev. noch am offensten, einfach weil sich Zehntausende Gruppen selbst immer wieder proaktiv einschleusen, aber da nimmt auch schnell wieder der Noise-Faktor zu.

Der Witz bei Hypemachine: es braucht kein social network und keinen sozialen Graphen, um jemanden an das Musiksystem anzudocken, weil die Leistung des Filterns, Verstärkens, Empfehlens usw. ein gelöstes Problem ist, und zwar von den Bloggern.

Wenn Blogs in was gut sind, dann im obsessiven Sammeln, Verstärken, Filtern. Und der Bereich Musik ist denkbar gut beackert. Und weil Musik eben so stark an Geschmack gekoppelt ist, kann der Wert der Empfehlungen eines einzigen Blogs, das mit einem geschmackskompatibel ist, riesig sein und Welten öffnen.

Jetzt gibt’s ganz offensichtlich tausende – man sehe sich nur die Liste von gescannten Blogs bei Hypemachine an – solcher potentiellen Intensitätszentren. Das Problem bis Hypemachine war das Finden bzw. der damit verbundene Informationsbeschaffungsaufwand. Hypemachine hat das im Grunde unspektakulär aber kongenial gelöst, indem es die diese Blogs aggregiert, den Zugang zu den Tracks optimiert und mit einem personalisierbaren und post-sozialen Layer versieht.

Die guten Web-Kopien

und bei Holtzbrinck’s eLab freut man sich über die eigenen guten Web-Kopien, die sich ob der eigenen Aktivitäten als das Erfolgreichste erweisen, und irgendwie entspricht das einem Restaurant, das ein paar uninspirierte Köche hat und sich darüber freut, dass sich das aufgewärmte Convenience Food bei den Gästen als das Amliebstengegessene erweist, ohne dabei auf die Idee zu kommen, dass man auch gut kochen könnte, was man aber auch nicht muss, weil alle Gasthäuser in der Nähe auch nicht besser kochen.

(abt. anspruchslosigkeit des eigenen anspruchs)

Xtra Long Tail

Gleich nochmal Seth Godin (einer meiner Lieblingsblogger) zum longest tail – und haha, der Eintrag ist gleich auf mehreren Ebenen völlig daneben.

Er stöbert also in einer Ramschkiste von CDs, kennt nix und denkt sich:

It’s almost impossible to buy music with no frame of reference. There were no hits, no recommendations, no “if you like x, you’ll like y”. I realized that the time it would take to decide if I liked an album was probably worth more than the $3 it would cost to buy one – in other words, not even worth it for ‘free.’

erste falsche Annahme: als hätte man jemals keinen Referenzrahmen. Den hat man immer, der ist das, was man in seinem bisherigen Leben aufgesogen und für sich als Geschmack kultiviert hat, das persönliche Wissen um Bands, Musiker, Labels, Stile, … das man sich (üblicherweise höchst ausdifferenziert) angeeignet hat. Und wer Platten sammelt weiss, mit welchem Affentempo man Ramschkisten scannen kann und welche tief sitzenden Assoziationshöfe dabei getriggert werden. Dabei kann es natürlich vorkommen, dass man gar nichts kennt, was uns zur

zweiten falschen Annahme bringt: als wäre die leere Schnittmenge zwischen dem Angebot und dem eigenen Wissen keine Information. Aber eine leere Schnittmenge bedeutet, dass es sich um etwas handelt, mit dem das eigene Referenzsystem bis dato nichts zu tun gehabt hat, auf das man im übrigen auch nicht über etwaige webbasierte Empfehlungsmechanismen gestolpert wäre (sonst würde man zumindest den einen oder anderen Künstler kennen). Und das kann zwei Dinge bedeuten: es handelt sich um Produkte aus einem völlig inkompatiblen Geschmacksset, oder es handelt sich um ein Genre das man nicht kennt, das einem aber gefallen könnte. Was uns zur

dritten falschen Annahme bringt: er konzipiert verbilligte Musik als Totalschaden – wenn die Informationsbeschaffungskosten (der individuelle Zeitwert, den man für’s Herausfinden ob’s einem gefällt oder nicht aufwenden muss) höher sind als der Kaufpreis soll man sie nach Seth vermeiden und also auch vom Kauf absehen. Aber, wenn man so will:

Musik ist – weil sie so billig ist, also zwischen 0 und 15 Euro pro Album – immer schon ein Totalschaden. Die Informationsbeschaffungskosten für Tracks die einem wirklich gefallen sind immer viel höher als der Kaufpreis. Aber der persönliche Nutzen nimmt mit dem Grad des Gefallens, des Identifikationspotentials, der geschmacklichen Unwahrscheinlichkeit, … exponentiell zu – und Lieblingstracks sind sowieso unbezahlbar. Nur wird man natürlich bei der Suche nicht irgendwo beginnen und den long tail von hinten aufrollen, sondern dort, wo es wahrscheinlicher ist, dass man über was Spannendes stolpert.

Und dann macht er einen Sprung (wobei mir auch nicht so ganz klar ist, wie er das aus dem vorangegangenen ableitet):

Musicians, bloggers, writers – if you’re toiling in the long tail, getting stuck at zero is now a real possibility. Being just like the other guys but trying harder is less of an effective strategy than ever before.

vierte falsche Annahme: als wäre die Möglichkeit, unbekannt im long tail zu stecken, was neues (nur gibt es jetzt eben viel bessere Möglichkeiten in Subszenen, Microcommunities, in Japan … erfolgreich zu sein und eben nicht mehr völlig vor sich hin zu stecken)

fünfte falsche Annahme: als wäre das gleiche gleicher zu machen jemals (ausser für reflexive Strategien der Scheingleichheit usw.) eine effektive Strategie für irgendeinen (long tailischen) Künstler gewesen, da heisst es immer anders, schneller, weiter, weiter. Das einzige Feld, das nach dem Motto just like the other guys but trying harder operiert, ist das der Fliessbandproduktion für diverse Charts (für die stimmt, was er sagt, aber die hat er nicht gemeint.)

(abt. die welt wie sie ist)

Frage des Tages: Herr O’Reilly, was genau ist eigentlich das Web 2.0?

gestellt von Christina Bergmann für die Deutsche Welle (via), Antwort:

Beim Web 2.0 geht es darum, Anwendungen zu bauen, die das Netz als Plattform nutzen. Und die erste Regel dabei ist, dass die Anwendungen von ihren Nutzern lernen, also besser werden, je mehr Menschen sie benutzen. Beim Web 2.0 geht es um die Nutzung kollektiver Intelligenz.

Ok, das ist sicher das 50ste wortgleich beginnende und dann mehr oder weniger gleichartig verlaufende Interview mit Tim O’Reilly, das man in der dt. Presse in den letzten 12 Monaten lesen konnte, aber mir ist dabei etwas wahrscheinlich völlig Offensichtliches das erste Mal klargeworden:

man kann diese Definition auch nicht verstehen.

99% des dt. und 90% des int. Diskurses über Web 2.0 sind das unmittelbare Resultat des ganz einfachen – und völlig nachvollziehbaren, was soll man sich unter Anwendungen die das Netz als Plattform nützen schon vorstellen – Nichtverstehens der Ausgangsthese. Sämtliche dann in der Tat zunehmend wolkig und beliebig gewordenen Beschreibungsversuche über das Mitmachmitshinybuttonsviaajaxalsmashupdankwidgetsdurchaaluswweb sind nichts anderes als sich verselbständigt habende Serien von im Sog der ursprünglichen Beschreibungen aufgegriffenen, dabei aber isoliert und nicht mehr im Kontext verständlichen Elementen, wobei irgendwann die Wirkung mit der Ursache vertauscht wurde.

to be continued.

Wir sind produktiv Pt. IV

oops, hab da ein Stöckchen übersehen.

Was macht dich produktiv? Die besten Tipps unserer Leser

hmm, schwierig, der beste Tipp den ich geben kann ist wohl GTD zu lesen und dann auf die striktest mögliche Art zu befolgen und es dann nochmal zu lesen und auf’s Eindringlichste zu studieren und es dann noch strikter zu befolgen, aber das ist wohl kein konkret-genuger Tipp.

Eine meiner Lieblingsstrategien bzgl. von Dingen/Aufgaben, die man schon als zu Tuendes erkannt und benannt hat, für die man auch schon die tatsächlichen nächsten Schritte/die next actions definiert hat, die man dann aber aus welchen Gründen und inneren Blockaden auch immer einfach nicht und nicht tun will, die man von einer Todoliste in die nächste mitschleppt, aber es findet sich immer was besseres zu tun, ist die aleatorische next action

Voraussetzung dafür ist, dass man einen Haufen von next actions (GTD Lingo für Handlungen, die man ganz konkret einfach tun kann, über deren was und warum und wie man nicht mehr nachdenken muss, weil sie schon das Ergebnis eines vorausgegangenen Denkens ob des was und warums und wies sind) hat und dass ein paar davon diese Objekte des Widerstands sind.

Was man dann nach GTD-proper tun würde ist, diese nach Kontext (online, am pc, am telefon, ausser haus, …) aufzulisten und wenn man dann in einem jeweiligen Kontext ist, sie je nach vorhandener Zeit, dann nach vorhandener Energie, erst zuletzt nach Priorität gereiht abzuarbeiten. Nur eben: ein paar davon widersetzen sich und hier kommt die aleatorische next action ins Spiel:

anstatt die NAs nach Kontext zu ordnen, werden alle bunt miteinander vermischt. Dann wird eine zufällig ausgewählt (besonders lustig ist das, wenn man seine NAs in Papierform auf etwa Indexkarten hat und eine mit verschlossenen Augen aus dem Stapel zieht) – und die tut man dann, auch oder gerade wenn es überhaupt nicht zum Kontext oder ins aktuelle Konzept passt. Dann zieht man die nächste – und dann tut man die, usw. usf. Es gibt natürlich Grenzen der Sinnhaftigkeit, aber dabei entsteht mitunter ein eigenartiges Gefühl der Losgelöstheit von etwaigen Zwängen, es entwickelt sich ein unerwarteter Spass an der Zufälligkeit was als nächstes kommt und zu tun ist, und hin und wieder kann man sich so selbst überlisten etwas zu tun, das man sonst (natürlich mit den besten Gründen) immer vermieden hat.

Open Up

Dave Winer zum Unbundling von social networks :

… because what we really need is an architecture that allows anyone to add a tag to an arc, the same way we add tags to pictures on Flickr.

All these things point in one direction, esp Facebook. Closed systems are fine in the early stages of a new technology. They’re the training wheels for a new layer of users and uses. But, as we always see, the training wheels eventually come off, explosively, creating new systems that throw out the assumptions of the old. …

Eventually, soon I think, we’ll see an explosive unbundling of the services that make up social networks. What was centralized in the form of Facebook, Linked-in, even YouTube, is going to blow up and reconstitute itself.

(ich glaube er macht einen konzeptionellen fehler, weil er offenheit in erster linie technologisch denkt; die plattformen deren unbundling er voraussieht sind aber schon das gerebundelte – und funktional offen genuge – ergebnis von zuvor geunbundelten (bzw. ohnehin schon frei flottierenden) tatsächlichen bedürfnissen. vgl. etwa craigslist und edgeio.)

6:49 AM

Die SZ mit einem in seiner Doofheit nicht unwitzigen Artikel zu Blogs etc.

(nach wie vor (und nicht auf diesen artikel bezogen) aus systemtheoretischer sicht interessant: msm und blogs sind füreinander umwelten, die man irgendwie ins eigene system inkorporiert. während blogs durchaus auch die outputs der msm (und natürlich auch den von anderen blogs) ernst nehmen und innerhalb des eigenen systems weiterverarbeiten und also – zumindest asymptotisch – schlauer und differenzierter werden, nehmen die msm die blogs nur auf einer meta-ebene war. da ist was, was uns beobachtet und was über uns schreibt, und da ist was, was dann auch lustigerweise noch autoreflexiv über sich selbst schreibt, und da ist was, was vielleicht noch ganz allgemein irgendwie und über irgendwas herumschreibt. aber es wird nur das DASS wahrgenommen, aber nicht das WAS und schon gar nicht das vernetzte WIE und beim WARUM ist man schnell wieder beim solipsistischen tagebuchmotiv. insofern bleiben sie halt nur so schlau wie sie eben sind, bleiben aber auch auf den damit verbundenen opportunitätskosten, die das in einer vernetzten welt mit sich bringt, sitzen)

(update: auch 2012 gelesen eig. noch immer eine ‘stimmige’ analyse, deren effekte aber ausgeblieben sind; in der tat haben die msm eher dazugelernt während sich blogs eher strukturell verkrustet haben; die schuld sehe ich wie so oft beim konstrukt social media, das konnten ‘medienmacher’ mit den bewährten instrumentarien angehen und managen während sich die ‘subjekte’ selbst subordinierten)

WinWinWin

Ich hab am Nachmittag mal ein bisschen die Facebook Platform Developer Docs gescannt und mich mit ein paar Anwendungen herumgespielt, und das ist huge. Nicht super alles auf den Kopf stellend und die Industrie völlig verändernd huge, aber doch ziemlich huge.

Hat wohl jeder mitbekommen, aber falls nicht: seit gestern ermöglicht Facebook, dass beliebige andere Anwendungen direkt in Facebook integriert werden können. Und sie müssen kein monadisches (und oft nur parasitär geduldetes) Widget-dasein fristen, sondern sie werden Bürger erster Klasse, die gleichberechtigt neben den eingebauten Facebook Apps stehen, die diese sogar ersetzen können und die den gleichen Zugang zur DNA von Facebook – den Beziehungen der User untereinander, den Lifestreams der User in Form ihrer Timeline – bekommen.

Und da haben alle was davon:

- Die Anwendungsentwickler haben was davon, weil sie ihre bestehenden Anwendungen (in mehr oder weniger abgespeckten Versionen) der gesamten Userbasis von Facebook (24 Mio, jede Woche 100.000+) schmackhaft machen können. Und nicht nur schmackhaft. Werden sie einmal adaptiert, dann verbreiten sie sich im jeweiligen Netzwerk eines Users quasi von selbst (iLike etwa mit einem Verbreitungsgrad von 100 neuen Usern/Minute), weil die Freunde dessen Output der jeweiligen Aktivitäten in seiner timeline sehen. (sogar der Spiegel hat das (was den Bereich webtech angeht völlig überraschenderweise) gut kapiert und schön beschrieben )

Irgendwie löst Facebook u.a. auch das chicken or egg Problem vieler Seiten, die an-und-für-sich nützlich wären, wenn nur schon alle Bekannten und Verwandten mitmachen würden. Nur tun sie es nicht, also hat man keinen Anreiz das Tool zu verwenden, also entsteht nie eine Situation, in der es für die Bekannten und Verwandten interessant erscheint…

Gleichzeitig eröffnen sich natürlich auch für einen Schwarm von speziell für die Facebook Platform entwickelte Anwendungen tatsächlich ganz neue Möglichkeiten, einfach weil sie eben direkt an die bestehenden Netzwerke andocken können.

- Die User haben was davon, weil sie nach Lust und Laune das geliebte Facebook erweitern, Funktionalitäten per Klick hinzufügen können, ohne es jemals zu verlassen. Schon jetzt gibt es an die 100 Anwendungen, bald sind es tausend, bald werden diese immer besser für Facebook optimiert. Facebook wird für sie attraktiver.

- und Facebook hat davon am allermeisten, weil mit jeder Anwendung der Wert von Facebook steigt, sowohl weil eben mehr Funktionalität angeboten wird, als auch und besonders weil jede Anwendung weitere und andere Vernetzungs-, Interaktions-, und Aufmerksamkeitsdaten generiert, von denen Facebook letztlich lebt (und die in ihrer vernetzten Aggregiertheit / aggregierten Vernetztheit viel wertvoller sind als der Verzicht auf eine Gewinnbeteiligung). Dadurch wird Facebook nicht nur attraktiver als andere social networks, auch die Kosten für’s etwaige Switchen werden für den bestehenden User immer grösser, je mehr und auf je vielfältigere Weise er seine Zeit investiert und je leichter er die auch wieder immer vielfältigeren Ströme seiner Freunde rezipieren kann.

Geschickter Zug. Und wer in den nächsten 3 Monaten seine Anwendung nicht auf Facebook portiert hat (wär eigentlich witzig: StudiVZ in Facebook), ist selbst schuld. Bald wird es wesentlich schwieriger sein, eine Initialverbreitung anzustossen.

Dahingedümpel

der deutschen social networks, bzgl. einiger Metriken analysiert bei deutsche-startups (das sich irgendwie zum deutschen TechCrunch mausert). Mit Ausnahme der Studi- und Schüler VZs und der Lokalisten eher tote Hose, auch institutionell gebackupte Seiten wie unddu und bloomstreet haben Trafficzahlen von (trafficmässigen) Durchschnittsblogs.

(ein hauptproblem für alle deutschen web 2.0 seiten (nicht nur social networks) ist, dass üblicherweise die phase der early adopters fehlt. von denen kann ein dienst zwar nicht leben, aber sie legen die basis von content, best practices, hacks, etc. auf der dann andere sukzessive andocken können, auch wenn sie es dabei entgeeken und umfunktionalisieren, es gibt ein organisches wachstum, es behält einen gesunden kern. das hat natürlich auch damit zu tun, dass der funktionstyp innovator (natürlich gibt’s ausnahmen, etwa spreadshirt, openbc, plazes, …) oft seine innovative inspiration bei was schon seit 12 – 24 monate gegebenem findet, was also die neugierigen und experimentierfreudigen webophilen nicht wirklich anzieht.)

Liebe deinen Preis wie dich selbst

passt eigentlich gut zum vorigen Eintrag : you decide what feels right pricing bei SvN.

(Übergang von autoritären Preisen (buy or rip and burn) zu antiautoritären/postmodernen Preisen (wir wollen mit unserer Musik ja nur die Menschen erfreuen, natürlich müssen wir auch von was leben, aber wir wollen nicht von euch bezahlt werden, weil ihr müsst, wir wollen bezahlt werden, weil ihr bezahlen wollt, aber bezahlt nicht mehr als es euch wert ist – dem Durchschnitt ist es übrigens soundsoviel wert, aber macht euch darüber keinen Kopp))

(abt. wie man’s macht ist’s falsch)

Liebe deine Werbebotschaft wie dich selbst

The Break Up – nettes Video von Microsoft Digital Advertising Solutions das allerdings sämtliche Marketingplattitüden 2.0 (die Konsumenten sind die treibende Kraft, sie haben sich verändert, es geht ihnen nun um Dialog und Beziehung – nicht um zielgruppenoptimierte Einwegbestrahlung, blabla) aufgreift, um das gleiche alte dann in etwas granularerer Form zu verkaufen:

Reach and engage with your target audience across multiple digital touchpoints—and optimize your advertising impact through our world-class partnership services…

Davon abgesehen könnte man aber nach Slavoj Zizek sagen, dass sich der Übergang von der autoritären Erziehung (du besuchst deine Oma an ihrem Geburtstag, du gehst am Sonntag in die Kirche, und damit basta) zur antiautoritären (postmodernen) Erziehung (du weisst, wie sehr sich deine Oma / Gott über deinen Besuch freuen würde und dass sie / er unendlich traurig sein würde, wenn du nicht kommst, aber fühle dich bitte nicht genötigt, komm nur, wenn du wirklich aus eigenen Stücken kommen, wenn du sie / ihn wirklich sehen willst…) ((und die natürlich wesentlich perfider ist)) im Marketing / den Kundenbeziehungen wiederholt. Die Konsumenten sollen nicht mehr einfach nur kaufen, sie sollen jetzt auch noch reden bzw. eigentlich die Firmen und Produkte sogar lieben, und auch das Marketing soll nicht einfach branden und verkaufen, sondern eigentlich auch die Konsumenten lieben.

(abt. soweit kommen wir noch)

Richtig Klonen

A global community couple of servers answering one simple question: What’s your website doing? Receive answers on your phone, IM, or right here on the web!

(grundsätzlich spricht ja wirklich nichts gegen klone, die ganze kulturkreislehre etwa basiert auf der grundannahme, dass den menschen so oft nicht was neues einfällt, dass sie aber schlau genug sind, gute einfälle als solche zu erkennen und für sich zu adaptieren (übergang von handcraft zu clonecraft). andererseits ist es trotzdem irgendwie lustiger, wenn ideen ein bisschen um- oder weitergedacht und nicht nur als die eigenen verkauft werden)

The 6th Sense

Sind Zeitungen schon Gespenster, nur wissen sie es noch nicht?

media-ocean sagt ja, die blogrolle zitiert ein obskures paid-content bzw. paper only Rettungsmodell für Zeitungen eines WSJ-Opinionisten, aber ganz sind sie sich dort wohl auch nicht einig, in A Reality Check for Newspapers (via) beschreibt ein anderer WSJ-Kolumnist recht schlüssig die Situation für Content-Produzenten bzw. Rechteinhaber unter Internetbedingungen, Zitat:

Whether or not content creators like it, this is the age of fragmentation. In industry after industry, consumers are voting with their feet against old methods of packaging and distributing information. They want to pick and choose what’s of interest to them, without having to pay for or wade through what isn’t. That change, midwived by technology, has shaken or shattered content companies’ business models. It’s made everything they do more risky. And it’s stripped them of power they once enjoyed, forcing them to work with new companies and industries that somehow got to set the rules.

(eines der grundprobleme das zeitungen haben ist, dass sie sich im web nicht länger oligopolistisch einen kuchen aufteilen können, indem sie sich gegen die jeweils lokal vorhandenen anderen zeitungen positionieren (boulevard vs. bildungsbürgertum, rechts vs. links, alles eben noch gut genug), sondern dass sie sich gegen das gesamte weltweit vorhandene und frei zugängliche informationsangebot (nicht nur andere zeitungen) ausdifferenzieren müssen, und das ist nicht leicht, mit abgeschriebenen dpa/ap/reuters meldungen, faden kommentaren, fernsehprogramm und dem bild von einem busen ist das dann jedenfalls nicht mehr getan, andererseits kann ein tatsächlich erzeugter (informations/meinungs/kontextualisierungs/vollständigkeits/…-) wert ganz neue dynamiken und auch monetarisierungsmöglichkeiten (hier herrscht erstaunliche phantasielosigkeit, ads und classifieds) eröffnen. wert wird im internet ganz automatisch verstärkt, wenn es ihn gibt, wenn man es zulässt und wenn man sich mit den neuen katalysatoren (suchmaschinen, memetracker, aggregatoren, den lesern, den potentiell interessierten, …) arrangiert; gefahren gibt’s natürlich auch – u.a. powerlaw effekte, bei denen weniges überproportional verstärkt wird und der rest so dahindümpelt – aber wer die schoten dicht macht (paid content) ((dass das beim wsj funktioniert ist eher ein sonderfall, oft exklusiver und für geldentscheidungen relevanter content, eine zielgruppe die die abogebühr nicht kratzt)) oder den kopf in den sand steckt (es gibt kein problem nicht) schliesst sich selbst aus und muss auf die unfähigkeit der leserschaft hoffen, sich jemals webskills anzueignen.)

UGCV

Miniserie zu User Generated Company Value – (1) – (2) – (3) von Cem Basman.

die Diagnose: Internetunternehmen profitieren von der Leistung der User, sackeln nach der Vertafelsilberung Millionen/Milliarden ein, die User gehen leer aus!

die Idee: warum nicht User konkret mit Aktien, die nach einem Aktivitätspunkteschlüssel vergeben werden, angemessen beteiligen?

das Ergebnis: alle sind happy, die User besonders motiviert, die Unternehmen dadurch im Wettbewerbsvorteil.

So gut das klingt und so gerecht das vielleicht wäre, er löst damit das falsche Problem.

Funktionierende soziale Anwendungen basieren vereinfacht gesagt auf 3 Achsen entlang derer Wert erzeugt werden muss (höre Tom Coates’ (mp3) Vortrag beim Future of Web Apps Summit 06):

- individuelle Beiträge erzeugen Wert für den Beitragenden selbst (sonst würde er/sie es ganz einfach nicht tun, es muss ihm zumindest seine Zeit wert sein)

- jeder dieser Beiträge erzeugt auch Wert für andere

- die Organisation extrahiert daraus zwar wie auch immer gearteten Wert für sich selbst (sonst würden sie die Plattform nicht machen), verdichtet, organisiert, kondensiert, kanalisiert aber auch die individuellen Beiträge, Datenströme und Feedback-Loops zu einem Ding, bei dem das Leben für alle besser wird.

Nun gibt es unterschiedlichste Motive, warum die User was beitragen (hängt von der jeweiligen Anwendung ab), und unterschiedlichste Werte, die sie daraus ziehen (hängt auch wieder von der jeweiligen Anwendung ab), der systemisch dysfunktionalste ist dabei jedenfalls Geld.

Warum? Weil man mit Geld die falschen Verhaltensweisen belohnt und die falsche Art von Leuten (bzw. bots) anzieht. Bei social software ist Geld für Spam das was Licht für die Motten ist.

Man kann sich recht einfach für so ziemlich jede Anwendung ausmalen, was passiert, wenn mit Geld gewunken wird;

exemplarisch del.icio.us:

- ich bezahle für das Posten von Links; Effekt: Leute posten hunderte Links täglich, bots posten tausende, das System wird aufgebläht und gemolken, der Wert des Systems für alle anderen sinkt.

- oder ich bezahle für das erstmalige Hineinstellen von Links, wenn sie dann populär werden (aka Einfluss); Effekt: Leute posten täglich hunderte Links, von denen sie annehmen, dass sie populär werden (andere Aggregatoren werden gescannt, …), bots posten immer noch tausende, auch diese mit angepassten Quellen, fake accounts werden angelegt um die geposteten Links populär zu machen, das System wird homogenisiert und gemolken, der Wert des Systems sinkt.

- oder ich bezahle die Top 100 User; Effekt: Leute knacken den Algorithmus, der für die Berechnung der Top 100 herangezogen wird und spammen das System entsprechend zu, um auf diese Liste zu kommen, der Wert des Systems wird auch nicht grösser.

- usw.

Ay, so schönes Wetter, muss raus, noch schnell: anstatt sich also ein genossenschaftliches Modell zu überlegen, das Arbeit fair vergütet, sollte man eher an der Idee (ist die Welt mit ihr ein besserer Platz), am Modell (welche Verbindungen werden ermöglicht, welche Daten können wie fliessen, …) und an der Plattform arbeiten, dass der Nutzen und der Wert für alle Beteiligten maximiert wird. Wir leben im Zeitalter der Hypereffizienz und der Grenzwert der individuellen Leistung geht im System gegen Null. Es gibt sicher einige Möglichkeiten, wie man mit finanziellen Anreizen hier oder da ein paar Akzente setzen kann, aber wer sein Modell grundsätzlich auf Vergütung basiert, hat im social software Bereich schon verspielt.

(über gegenbeispiele wäre ich dankbar)

Timing II

ist wirklich von Vorteil (siehe Timing). Tumblelogs gibt’s ja eigentlich schon lange (anarchaia etwa seit 2 Jahren, happy birthday), wurden dann immer wieder auch von nicht unbekannten reflektiert, aber während der Launch von tumblr noch nicht für wirklich viel Aufsehen sorgte, bekommt es jetzt im Sog von Twitter so einiges an Hype ab (Lifehacker, Center Networks, Webware, Juxtaviews, … unisono: Tumblen ist das bessere Twittern) – und im Grunde keinen unverdienten, weil sich – glaub ich – durch Twitter tatsächlich unsere Wahrnehmungskompetenz von atomisierten Informationseinheiten verschoben hat.

(abt. dialektische spirale)

Update für das Internet

Schönes Feature von Thomas Reintjes im Deutschlandfunk: Web 2.0 – Update für das Internet (via) – im Gegensatz zu den Printmedien mal tatsächlich eine nicht ganz blöde Einführung ins Web 2.0, sogar das Ironisieren, Verniedlichen und die ganze Pseudokritik hält sich in Grenzen, insofern echt erfreulich.

Kleiner Wermutstropfen: die Beschreibung ist ziemlich vollständig, aber neben der Nennung der Standardfeatures wird bzgl. keiner Achse etwas tiefer geschürft, es werden halt die Nährstoffangaben von der Verpackung vorgelesen, aber es wird nicht darüber nachgedacht, warum die Mahlzeit dann auch schmeckt (oder nicht), wie’s überhaupt dazu kommen kann, etc, aber wer tut das schon.

(grund dafür ist – glaub ich – der hierzulande vorhandene solipsismus, der unter ausklammerung des gesamten internationalen diskurses das web 2.0 halt nochmal neu erfindet und den begriff dann in operativer geschlossenheit so lange kursieren lässt, bis man selbst an ihn glaubt)

(abt. hörtippderwoche)

Metahyping

Eigentlich erstaunlich:

es gibt (im deutschen Diskurs jetzt) keinen eigentlichen Hype über das Web 2.0, es gibt nur einen Hype um einen vermeintlichen Hype ums Web 2.0.

Es gibt auch keinen Hype um Twitter (dieser hypersozialen, mobilen Microtumbling Plattform), es gibt . nur . einen . Hype . um . den . Hype . um . Twitter

(abt. kulturkreislehre)

Rewire

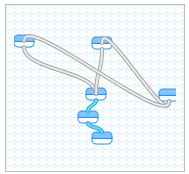

Wow, gleich zwei Meilensteine des Web innerhalb von zwei Tagen. Nachdem mit Useless Account [http://uselessaccount.com/] gewissermassen das konzeptionelle Nirvana des Web 2.0 markiert wurde (derzeit tun 6111 User begeistert nichts), legt Yahoo! nun mit pipes [http://pipes.yahoo.com/] nach und schenkt der Welt die erste als vollständig bezeichenbare Remixingplattform.

Pipes is a hosted service that lets you remix feeds and create new data mashups in a visual programming environment. The name of the service pays tribute to Unix pipes, which let programmers do astonishingly clever things by making it easy to chain simple utilities together on the command line.

Digger

Vor 2 Tagen hat digg-Gründer Kevin Rose verkündet, dass die Top Digger Liste nicht mehr angezeigt wird, seither tobt die Blogo- und Diggosphäre, die Liste ist an anderer Stelle wiederauferstanden, …

Rose hat das natürlich damit begründet, dass ein möglicher digg-für-die-eigenen-mediokren-Interessen-ausnützen-wollender Anker (die Top Digger dafür bezahlen, dass sie eine Seite auf die Frontpage diggen, derzeitige Gage dafür zwischen 100$ und 500$) ausgehoben werden soll, aber im Grunde sieht man dabei eines: wie eine früh getroffene Entscheidung im sozialen Design zurückkommen und einen in den eigenen Arsch beissen kann.

Ursprünglich ist digg ja aus der Idee heraus entstanden, eine Art demokratische Version von slashdot zu sein. Im Gegensatz zu slashdot konnte jeder Stories reinstellen, wie bei slashdot konnte jeder kommentieren, wie bei del.icio.us konnte jeder diggen was ihm gefällt, und die besten Stories eines Tages, die dann auch für den Gelegenheitsuser und Streuner attraktiv sind und die dann die Klickzahlen generieren, weil sie einer riesigen Leserschaft vorgesetzt werden, wurden so auf die Frontpage promoted. Geniales Prinzip und nicht umsonst wurde digg zu einer der paradigmatischen und erfolgreichsten Anwendungen des Web 2.0.

Nur wurde digg in den letzten paar Monaten ein Opfer der eigenen Popularität. Derzeit werden alle 3, 4 Minuten 15 neue Stories geposted. Die erscheinen zunächst in der upcoming Sektion auf der ersten Seite, nur bleiben sie dort nicht lange, sondern werden in den nächsten 10, 15 Min. von den nachrückenden Stories in die Unsichtbarkeit geschoben – selbst der leidenschaftlichste digger klickt sich nicht bis Seite 308 eines jeweiligen Tages durch. Die einzigen Stories, die es in die popular Sektion schaffen, sind die, die von populären Diggern gepostet oder gediggt werden (in etwa 60% der Frontpage Stories kommen von 100 Diggern, der Rest von den nächsten 400 – aus bald 1 Mio. Usern), nicht deshalb weil sie die besten Stories posten, sondern weil nur diese dann auch von deren (zahlreichen) Freunden gesehen und optional auch gediggt werden.

Es entbehrt nicht einer gewissen Ironie, dass dieser demokratische Ansatz unter den Bedingungen einer freien Informationswirtschaft die gleichen Kastenstrukturen herausgebildet hat, die eigentlich gestürzt werden sollten und dass ausgerechnet die soziale Komponente der Freundesnetzwerke Ursache dafür ist.

Der Planet der Affen

Robert Basic beklagt eine Innovations-Pause im US-Web – seit 2005 tue sich nichts mehr wegweisendes, 2006 nur Nachahmer, für 2007 sei nix in Sicht.

Naja.

Was man ev. sagen kann ist, dass die Zeit der neuen Megaseiten die dann auch bis zum Spiegel oder der Zeit durchdringen (myspace, youtube, craigslist, flickr, facebook, digg, delicious, lastfm) wohl für die nächste Zeit vorbei ist. Das liegt aber nicht an einer damals vorhandenen aber seit 2 Jahren stagnierenden Innovationsfähigkeit, sondern eher daran, dass diese Seiten quasi die Pilger / Kolonialisten der fundamentalen Datentypen (Text, Bild, Ton, Video, soziale Beziehungen, Waren, Bookmarks als webspezifischer Anker) unter readwriteweb-Bedingungen waren. Und nachdem die Pfründe bzgl. dieser fundamentalen Datentypen einmal gesichert waren und der Paradigmenwechsel vom (im allgemeinen jetzt) Empfänger zum (zumindest von der gegebenen Möglichkeit her) Sender einmal stattgefunden hat, haben sich die Gewinner bzgl. der jeweiligen Bereiche eben als supererfolgreiche Plattformen positioniert. Smash Hits waren sie aber nicht deshalb, weil sie besonders innovativ waren, sondern weil diese Bereiche mehr oder weniger jeden tangieren (Teenager gibt’s in den USA 50Mio -> myspace, Leute die ihre Haustiere verkuppeln wollen schon deutlich weniger -> matchmypet; digitale Photos hat jeder -> flickr, Bücher auch schon wieder weniger -> librarything, hmm, Amazon Reviews…, egal).

Ende 2004 waren die Rezepte mehr oder weniger bekannt (Usability: Gmail; alle für alle: del.icio.us; Allesschlucker: MySpace), O’Reilly fand dafür einen Namen, Breitband war bezahlbar, die Einstiegskosten für Startups waren mitunter aus der eigenen Tasche finanzierbar, 2005/2006 kam es zu einer tatsächlichen Explosion von realisierten Ideen, anders kann man die mehr als 10.000 (keine Hausnummer) neuen Tools die in den letzten 2 Jahren entwickelt wurden nicht beschreiben, nur stecken die Innovationen dann eher im Detail, in der Verfeinerung und Spezialisierung, in der Ausdifferenzierung der beteiligten Subsysteme (S3, Elastic Compute Cloud), in der Art und Weise wie diese sich wechselseitig durchdringen und verkoppeln und verkuppeln, im Graben von Kanälen wie Daten fliessen können (Mashups, Widgets), im Dekonstruieren und Reaggregieren (Memetracker, smart Aggregators), im Finden von anderen ökonomischen Modellen (Crowdsourcing, social Commerce Modelle), usw.

Natürlich gibt es Nachäffer, der 500ste digg-Klon ist mit pligg oder etwa auf crispynews schnell aufgesetzt und als innovativ lässt sich das dann schwer beschreiben, aber auch die machen mitunter Sinn, wenn sie sich lokalisieren (etwa yigg) oder thematisch spezialisieren (etwa pick!t) oder die Metapher etwas umdeuten (etwa reddit) oder sich mit einem bestehenden Angebot vermischen (etwa newsvine). Aber damit war es ja nicht getan, ganz im Gegenteil, man muss nur genauer hinschauen (wenn einen das interessiert, wenn einen das nicht interessiert verpasst man natürlich auch nichts). 2007 wird wunderbar.